多模态学习之论文阅读:《Systematic comparison of deep-learning based fusion strategies for multi-modal ultrasound in diagnosis of liver cancer》

《Systematic comparison of deep-learning based fusion strategies for multi-modal ultrasound in diagnosis of liver cancer》 -2024.10 NEUROCOMPUTING 影响因子7.9

(一)多模态数据构成

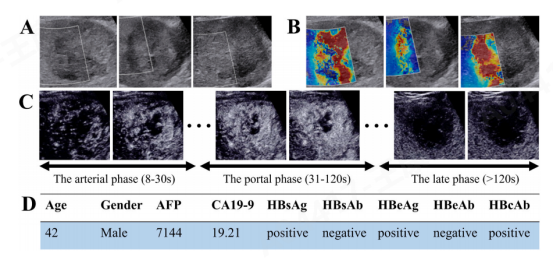

研究设计了“病变配对”方法来构建数据集,包括B模式超声、剪切波弹性成像(SWE)和对比增强超声(CEUS)数据,以及临床数据。研究中收集了自2021年9月至2022年12月期间接受超声检查的患者。共纳入86名患者,包括57名肝细胞癌(HCC)患者和29名肝内胆管癌(ICC)患者,数据包括B模式、SWE和CEUS图像,以及与超声检查日期最接近的血液检测生物标志物和每个患者的临床数据,包括肝炎指数和肿瘤生物标志物。

(二)数据可获取性

数据将在请求后提供(中山大学第一附属医院的超声数据库)。

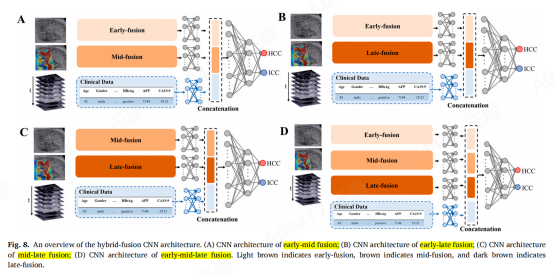

研究者设计了“病变配对”(Lesions Pairing)的方法来构建数据集,以解决多模态学习中样本量小的挑战。然后系统地比较了基于深度学习的多模态超声在肝癌诊断中的融合策略,并在比较了整合B超、SWE、CEUS超声数据和临床数据的多模态框架的结果基础上,提出了用于诊断肝细胞癌和肝内胆管癌的基于传统层级融合的混合融合策略。这些策略可以有效地提取模态内和模态间的信息。

(三)数据集规模

总样本量:共1147个样本,每个样本包括B超、剪切波超声、CEUS和临床文本模态。

训练集:包括852个多模态超声样本对(598个HCC配对样本和254个ICC配对样本)。

测试集:包括295个多模态超声样本对(201个HCC配对样本和94个ICC配对样本)。

(四)CEUS超声数据处理策略

动脉期采样

数据采集:从病变增强开始采集数据,以每秒3帧的速率连续采集10秒,共获得30帧。

时间范围:采集不一定延伸到动脉期的30秒标记。

门脉期采样

持续时间:门脉期从第30秒开始,持续到120秒。

数据采集:从30秒标记开始,继续以每秒1帧的速率采集15秒,共获得15帧,覆盖30至45秒的时间间隔。

延迟期采样

开始时间:延迟期从120秒后开始。

数据采集:以每秒1帧的速率采集15秒,获得15帧。

(五)实验步骤

特征提取:

l B超和SWE数据采用AlexNet、VGG16、ResNet-18、、ResNet-150、Inception-v3、DenseNet等网络提取特征

l CEUS序列数据采用3D-CNN、ConvLSTM网络提取特征

l 临床数据采用MLP多层感知机网络提取特征

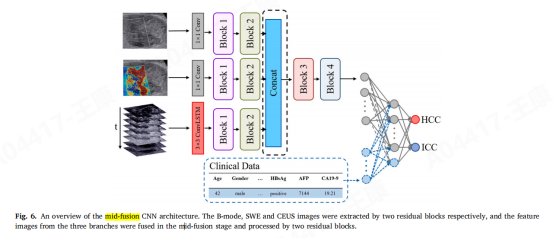

多模态融合网络设计

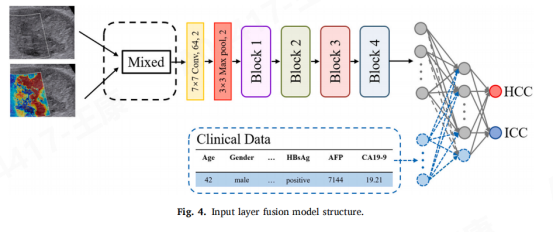

输入层融合

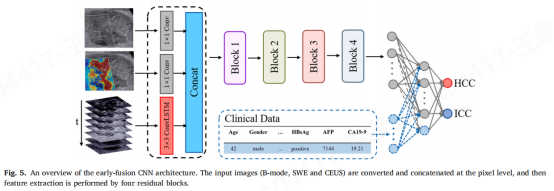

早期融合

中期融合

晚期融合

早中晚4种集成策略下的融合

(六)实验结果

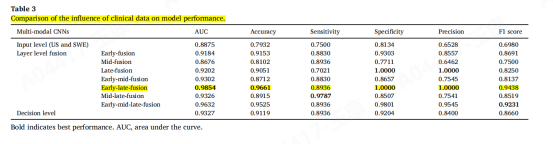

实验结果显示,混合融合策略在没有临床数据的情况下,早期-中期-晚期融合表现最佳;

而在有临床数据的情况下,早期-晚期融合表现最佳。关键数据显示,早期-晚期融合结合临床数据的AUC提高了13.8-25.88%,准确率提高了2.22%-9.79%。