信息熵的概念

注释:《机器学习实战》这本书说到香农熵,查了两个小时弄明白了。

信息熵有两种通俗解释:

1.代表信息的有用程度,越有用信息熵越大,负数是不可能的,我说句话不影响别人也可以影响我自己啊。

2.代表信息的压缩大小,一段话里面有重复的,把重复的去掉就等于压缩,这个压缩的极限就是信息熵。

看下面两个链接就明白了:

https://www.zhihu.com/question/22178202,知乎大神的回答,大概看看有个了解。

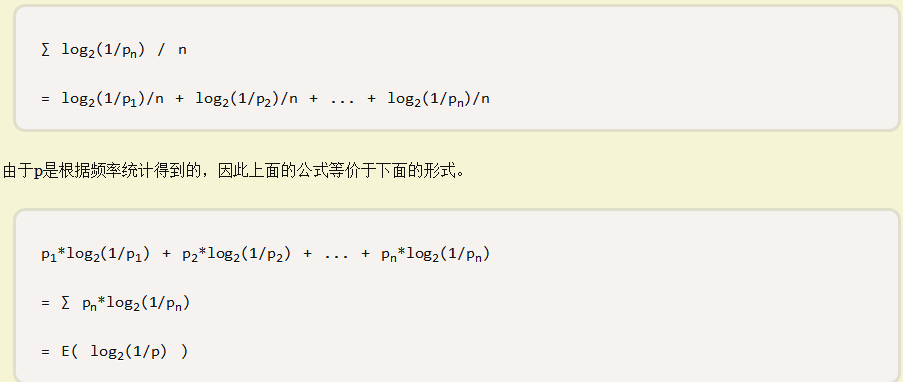

http://www.ruanyifeng.com/blog/2014/09/information-entropy.html,博客达人软大大的介绍,大概的推导都给出了。

这里说明其中的一点:

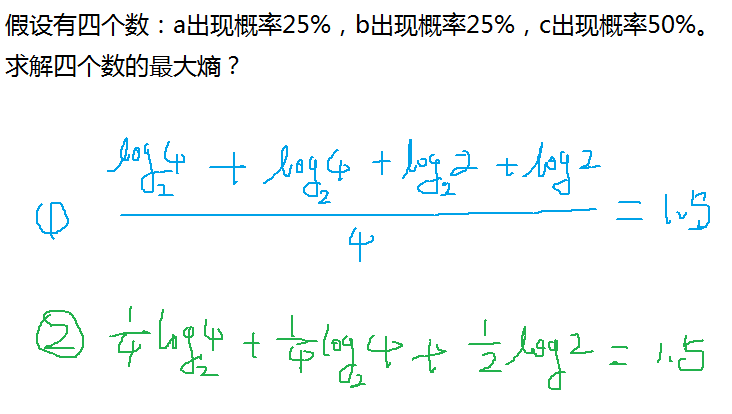

注意单个求解的时候,是求解每个特征出现的概率,其中包括重复的特征,a,b,c,c 是这样的四个数,c出现了两次,得计算两次才可以!

作者:影醉阏轩窗

-------------------------------------------

个性签名:衣带渐宽终不悔,为伊消得人憔悴!

如果觉得这篇文章对你有小小的帮助的话,记得关注再下的公众号,同时在右下角点个“推荐”哦,博主在此感谢!