TARGETDROP: A TARGETED REGULARIZATION METHOD FOR CONVOLUTIONAL NEURAL NETWORKS

TARGETDROP: A TARGETED REGULARIZATION METHOD FOR CONVOLUTIONAL NEURAL NETWORKS

Dense Object Detection

一. 论文简介

笔者感觉有点水的文章,想着既然看了就做个小记录吧

主要做的贡献如下(可能之前有人已提出):

- 提出一个目标正则化模块

二. 模块详解

2.1 论文详解

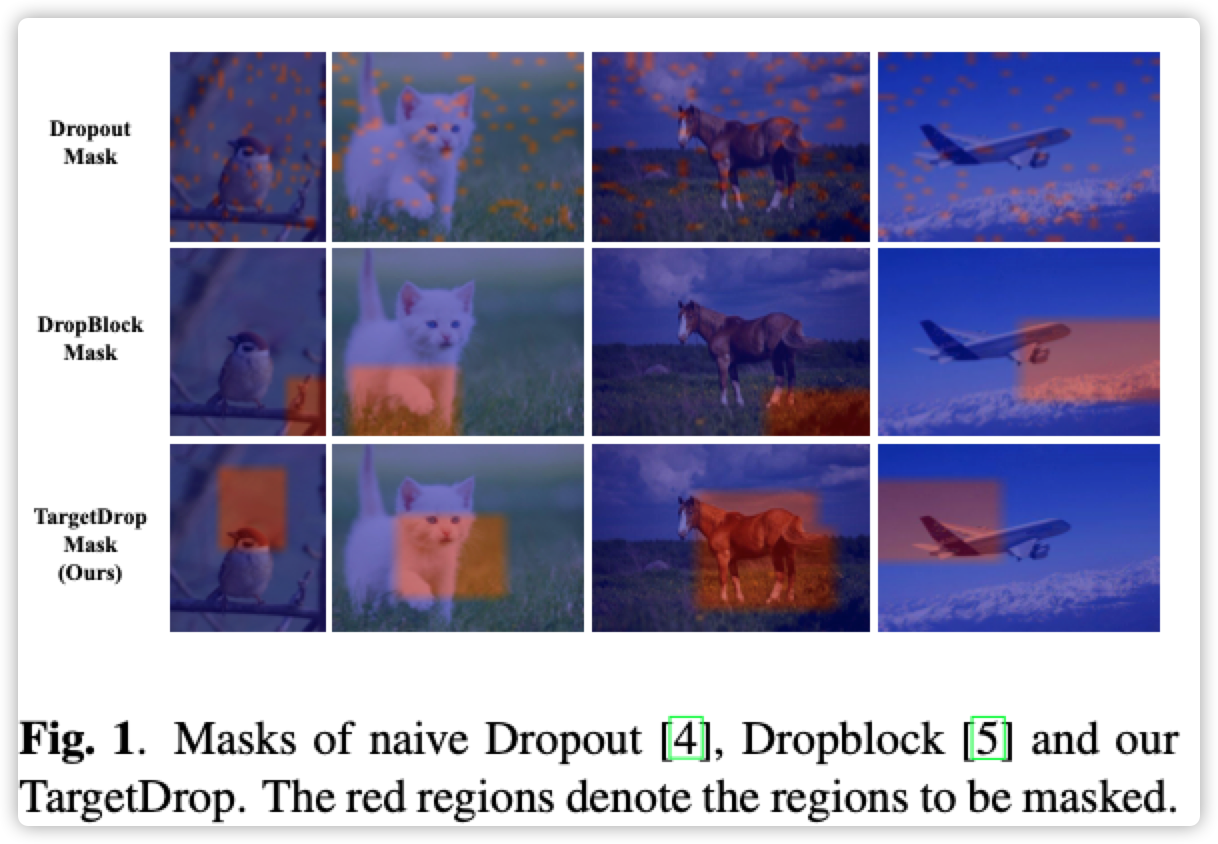

- 文章的出发点?下图展示了三种DropOut的实际表现,第三种带有目标性

- TargetDropout

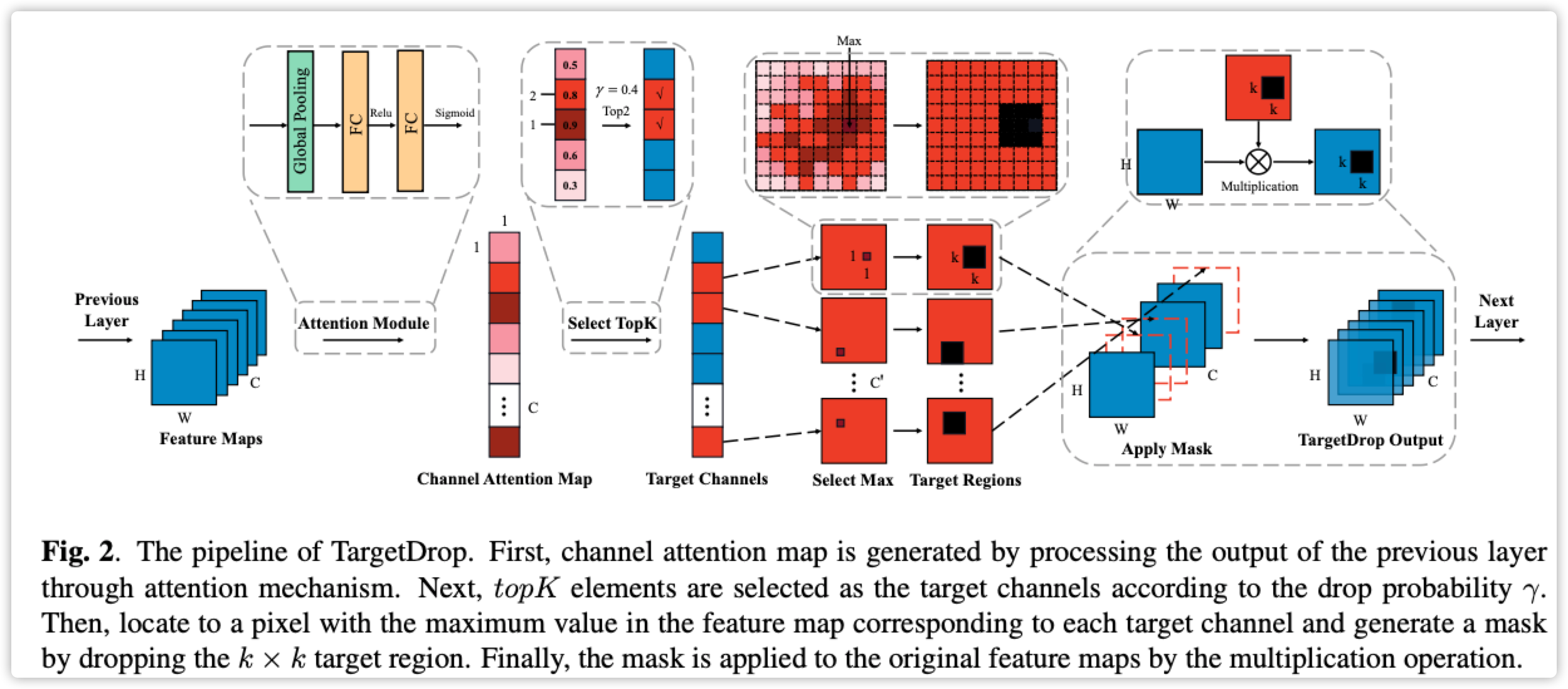

上面的图完全概括了这篇文章的核心,下面一步步说明:

- 假设 \(H\) 为当前 \(feature\ map\) , \(shape=[b,c,w,h]\)

- 对 \(w,h\) 轴进行均值操作,类似SE Attention模块的做法,参见论文公式(1),得到 \(v_c\)

- 再进行两个Full-Connect层操作,中间带两个激活函数-Relu+Sigmoid。得到 \(M\),参见论文公式(2)。这里的操作意义: 论文说是为了进一步获得通道之间的独立性。

- 先对 \(M\) 进行排序,然后选择 \(Top-K\) ,选择数量又一个参数 \(\gamma\) 进行控制,比如 \(channel=5,\gamma=0.4,top-k=2\). 再将 \(M\) 进行二值化,属于 \(top-k\) 为设置为1,不属于设置为0,论文公式(3)所示。

- Mask的位置 \([b,c]\) 已经确定(B是batch不用管,C按照\(top-k\)),\([w,h]\) 位置按照最大值即可。Mask的大小:按照公式(4)进行(就是一个Kernel,设置大小即可),掩膜操作直接相乘(Mask区域为0,其它区域为1),按照公式(5)。最后进行归一化接口,按照公式(6)。

- 很简单的一个模块,就是加了一个排序操作,训练阶段有点费时,推理阶段这个模块不起作用(这一点还是比较好的,相当于辅助训练)。

# 代码略

# 感觉作用不大,不去尝试了

三. 参考文献

- 原始论文

作者:影醉阏轩窗

-------------------------------------------

个性签名:衣带渐宽终不悔,为伊消得人憔悴!

如果觉得这篇文章对你有小小的帮助的话,记得关注再下的公众号,同时在右下角点个“推荐”哦,博主在此感谢!