《论文翻译》Xception

深度可分离网络-Xception

注释

- 本系列《论文翻译》仅代表个人观点

- 目的提高英文阅读能力

- 错误之处较多,欢迎读者修正,在此感谢

1. 摘要

我们提出了一种关于inception的解释,其介于正常卷积网络和深度可分离卷积之间(先进行分离卷积然后进行点卷积)。就此而论,深度可分离卷积可以被视为inception最大质量的跨越。这项工作受到Inception的启发,将会成为一个新网络架构的基准,同时Inception的卷积网络也将被替代。我们将此网络命名为Xception,在ImageNet数据集上略微强于Inception V3,当在大数据集上明显的超过Inception V3。当Xception和Inception V3具有相同的参数,表现能力不会提高,但是效率会提升。

翻译太烂,自己都没看懂

2. 介绍

今年来卷积神经网络作为计算机视觉的主要算法,同时开发设计他们的结构作为主要注意点。卷积神经网络的设计可以追溯到LeNet模型,进行简单的卷积堆叠提取特征和通过max-pooling对空间进行降采样。2012年,这种思想结构被提炼到AlexNet网络中,使用大量的max-pooling结构,对网络的每一层进行提取,获得大量的特征。由于ImageNet竞赛的驱动,随之而来的是网络越来越深的趋势。最著名的就是VGG网络等

此时出现一种Inception新的架构,在2014年被发明称之为GoogLeNet,之后陆续提升精确的升级到了V2、V3等版本。自从Inception架构的提出,其成为在ImageNet等数据集上最好的网络系列之一。

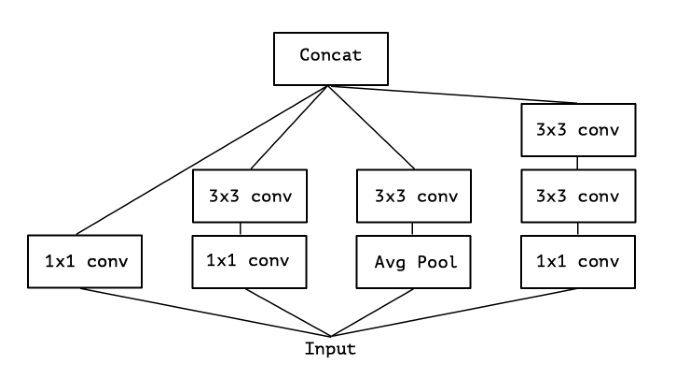

Inception系列是由Inception的基础模块构成,其中包括几个版本。如下图一所示为标准形式,同时也出现在Inception V3之中。这与早期的VGG网络有所不同,他是由渐渐的卷积网络堆叠而成。

然而Inception的结构和基本卷积类似(卷积特征提取结构),从经验上来看,此结构可以通过很少的参数获得大量的特征。他们如何工作,和传统卷积有何区别?

3. Inception假设

一个卷积层可以学习三维空间的滤波器权重,通过一个二维空间尺寸(长和宽)+一个通道空间。因此,一个单卷积核的任务可以同时映射跨通道的相关性和空间的相关性。

Inception模型的背后想法是使过程更简单、更高效的分解一系列独立的夸通道相关性和夸空间相关性操作。更精确的说,典型的Inception结构首先通过1×1的卷积研究夸通道的相关性,映射输入数据到3-4个相互独立的空间,和输入类似,之后通过规则的3×3或5×5卷积将所有相关性映射进3D空间之中。事实上,Inception模块的假设是跨通道的相关性和空间相关性相关分离,而不是倾向于将他们联合。

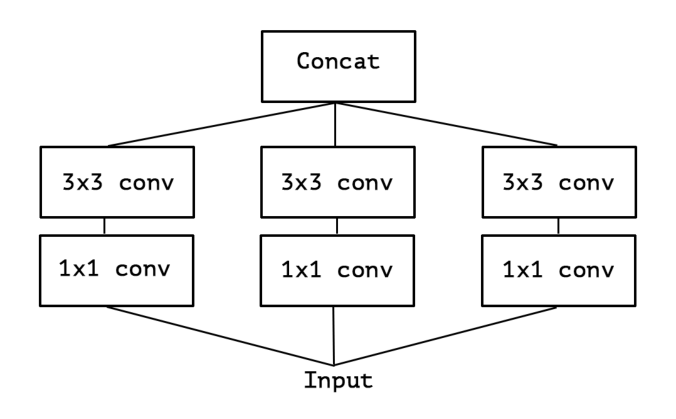

考虑一个简化版本的Inception模块,仅使用一种大小的卷积同时不包括pooling跳跃层。Inception模块可以被重新描述成一个大的1×1卷积+空间卷积,操作于输出通道没有重叠的段落。这个表达自然的出现以下几个问题:这个假设比之前的Inception的假设更合理吗?跨通道相关性和空间相关性可以完全分离吗?

4. 卷积和分离卷积之间的联系

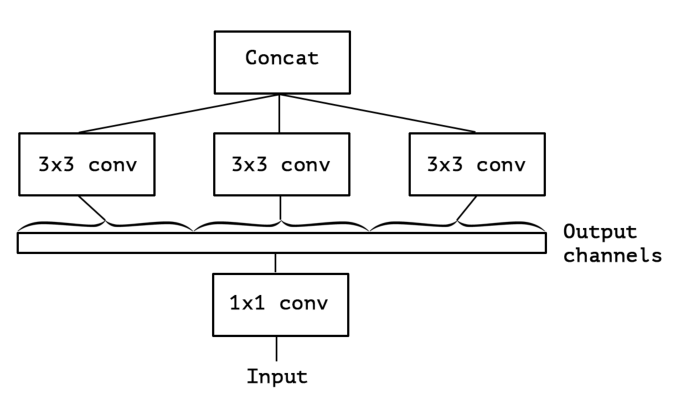

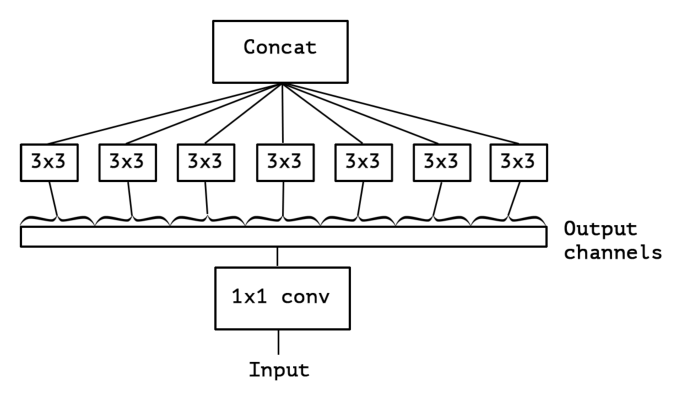

Inception模块是一个极其伟大的创作,其基于一个很强的假设,第一次使用1×1卷积去映射不同的通道,同时分离映射空间联系在每一个输出通道上。具体详见图4所示。我们注意到这个很强的模块和深度可分离卷积基本一致,模块被使用再2014年的网络中,自从被包含在TF框架之中就更受欢迎了。

一个深度可分离卷积,在深度学习框架中通常被称为可分离卷积,其实有深度卷积组成,空间卷积相互独立的执行,随后是点卷积操作,通过深度卷积将输出映射到一个新的通道空间。这也是和空间卷积相区别,所以在图像处理领域通常称为深度可分离卷积。

Inception模块和深度可分离卷积模块有两个很小的区别:

- 操作顺序不同:深度可分离卷积通常是先进行空间卷积之后再进行1×1卷积,而Inception则相反。

- 是否纯在非线性连接。在Inception中,两个操作之后都要进行非线性的RELU操作,然而Xception通常没有非线性连接。

我们认为第一个区别不是非常重要,尤其是因为这些操作被应用于一些堆叠操作。第二个区别非常重要,我们再实验部分进行了研究(详细见图10)

我们注意到一些Inception的中间概述,位于标准Inception模块和深度可分离卷积之间。事实上,在正常卷积和可分离卷积之间存在一个可分离的范围,一些独立通道的分割进行参数化,用于执行空间卷积。正常卷积(1×1卷积)在一个极端的范围,用于联系单个段落的情况。可分离卷积作用于其他极端情况,每个通道的段落。Inception模块位于之间,分割几百个通道到3-4个段落。这些中间的属性似乎还未被探索。

在进行这个讨论之后,我们建议使用深度可分离卷积替代Inception模块,通过堆叠可分离卷积模块的性能将在原始网络之上。通过TF中的可分离卷积工具进行实现。在下文中,我们提出一个基于以上探索的卷积网络架构,和Inception V3参数数量相等,同时在两个大型图像分类任务上进行对比表现。

4. 先验工作

当前的工作很大程度上依赖先前的努力:

就是一些之前的网络架构,VGG、Inception-V1-V2-V3、ResNet等

5. Xception 架构

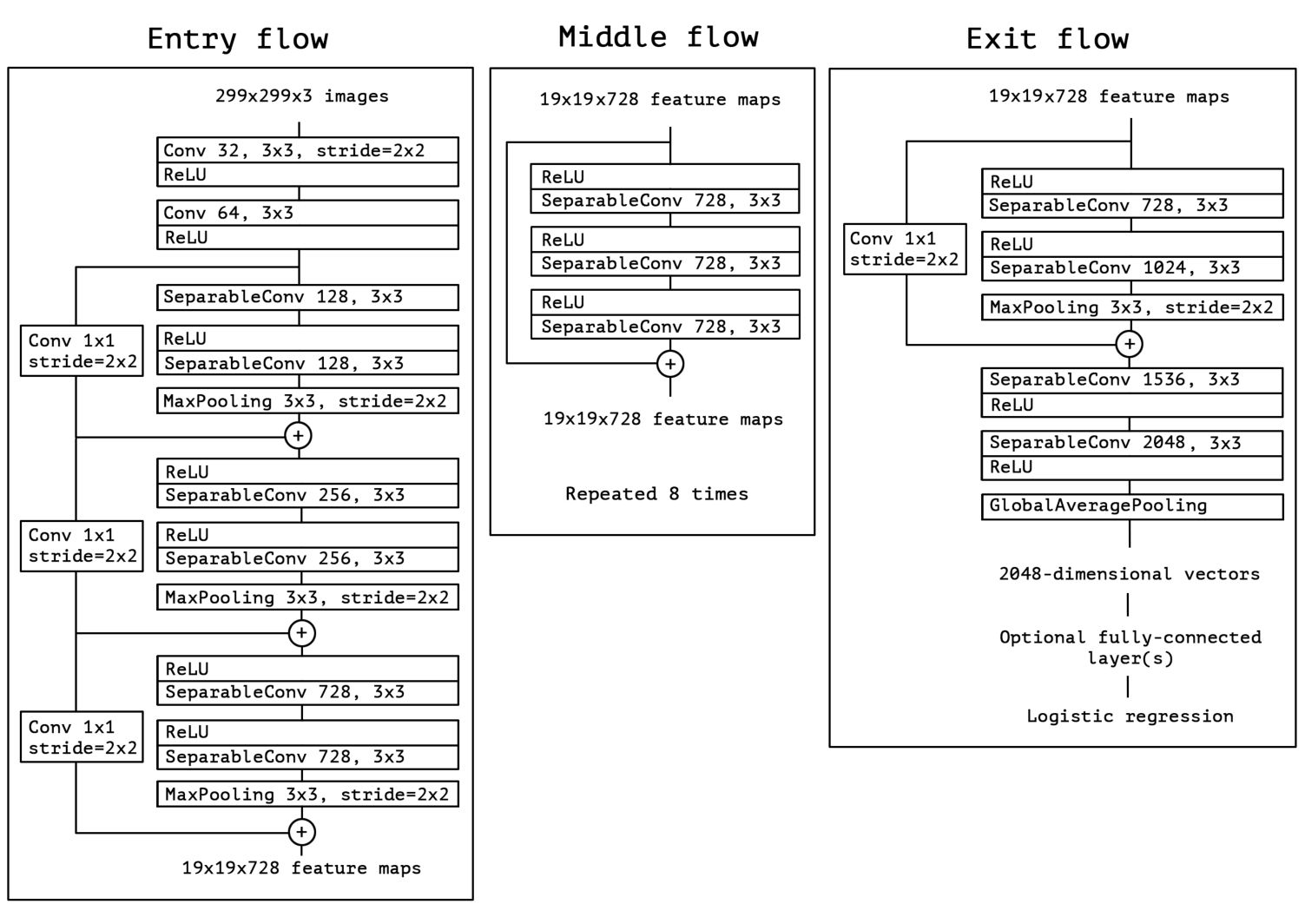

网络基础架构在图4所示,后面基本都是一些分析和前面说的一样。

作者所用网络如下图5所示,和Inception V3参数相同

6. 个人理解

本文其实就两个观点,第一个是为什么Inception有作用。第二个是我们更进一步放大第一个问题。以下根据个人理解说明这两个问题。

- 针对第一个问题为什么Inception有作用

| 说明 | 正常网络 | Inception |

|---|---|---|

| 输入 | 100×100×50 | 100×100×50 |

| 卷积 | 50×3×3×25 | (block1)+(block2)+(block3) |

| 参数 | nums | nums |

| 输出 | 100×100×25 | 100×100×25 |

正常卷积所使用的的卷积大小完全相同==>看到的特征大小(尺度)基本类似(相同)

Inception使用的卷积核不同==>看到的特征大小(尺度)基本有差异(不相同)

正常卷积全部通道都使用,不存在夸空间问题(卷积只是考虑空间联系,未跨空间)

Inception使用一张图三个/四个不同的卷积处理,最后进行叠加,已经进行了跨空间。

- 针对第二个问题优点继续放大

文中对两个优点进行讨论:

-

跨通道问题(文中已经说明这个优点对结果不明显,详细见原文1.2节)

-

在跨统计之后不接非线性RELU(文中说至关重要,详细见原文1.2节)

个人认为直接连接RELU破坏了跨空间之间的联系点,需要再进行卷积操作之后方可连接RELU。

第一个问题肯定是有作用的,只不过连接的太多可能作用不明显。

单词汇总

-

intermediate:中介 -

inspired by: 由。。。。启发(受到。。。鼓舞) -

outperform:超过 -

emerged:出现,暴露 -

sub-sampling:次采样(下采样==upSampling) -

what follow was:随之而来 -

At this point:此时 -

canonical:标准 -

This is a departure from:与。。。。不同 -

conceptually:概念(concept) -

come afte:紧随 -

This idea behind:背后的想法 -

decouple:解耦合(couple夫妇) -

reformulate:再叙述(formulate叙述) -

segment:分割、段落、分段 -

cornerstone:基石、基础 -

continuum:连接(continue) -

identical:统一 -

inclusion:包含(include) -

perform independently:独立执行 -

projecting:突出 -

minor:微小 -

implement:执行 -

whereas:然而 -

presence:存在(present) -

absence:缺陷、缺少(absent) -

investigate:调查、研究 -

spectrum:范围、光谱 -

in what follows:在下文 -

present:当前、提出

-------------------------------------------

个性签名:衣带渐宽终不悔,为伊消得人憔悴!

如果觉得这篇文章对你有小小的帮助的话,记得关注再下的公众号,同时在右下角点个“推荐”哦,博主在此感谢!