ES:ik 分词器

ik 分词器:可以将中文按照规则可以拆成多种粒度的词语。

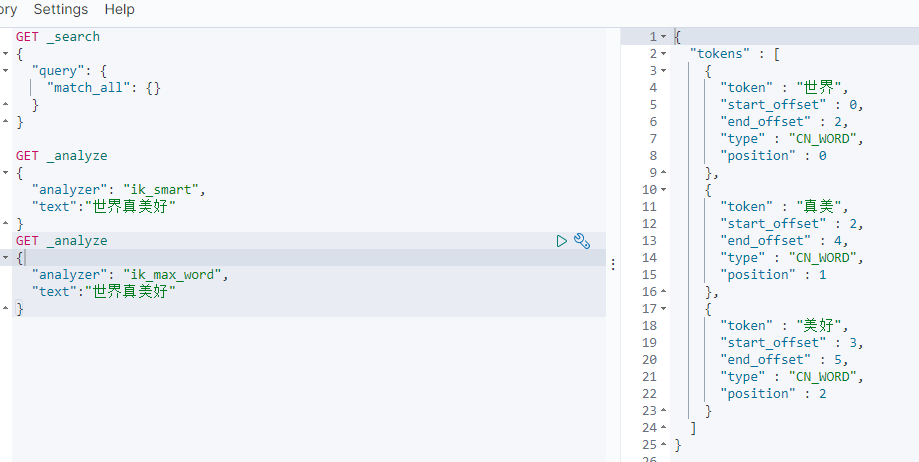

IK提供了两个分词算法:ik_smart (粗粒度切分) 和 ik_max_word(细粒度切分)。

下载地址:https://github.com/medcl/elasticsearch-analysis-ik/releases(请下载对应es版本)

安装:在usr/local/es/plugins 目录下新建文件夹ik ,将下载好的包解压到ik文件夹中,重启es即可。(注意,删除掉压缩包)

ik_smart算法:

ik_max_word算法:

如何增加自己的配置?

cd /usr/local/es/plugins/ik/config vi IKAnalyzer.cfg.xml

在配置文件里加上自己要定义的分词文档

然后在config里面新增my.dic

保存退出

重启es

再来测试