学习要点:

联合典型序列

信道编码定理

信源信道联合编码定理

经验主义设计

编码错误概率

典型信道编码

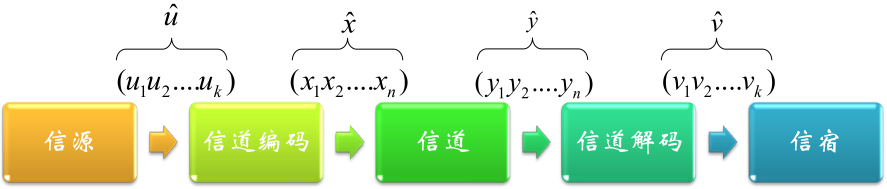

从通信角度看信道编码:

信道不可靠

W ^ \hat{W} W ^ W W W

研究目标:

信道构成 { X , q ( y ∣ x ) , Y } \{\mathcal{X},q(y|x),\mathcal{Y}\} { X , q ( y ∣ x ) , Y }

输入:符号集合 { 1 , 2 , . . . , M } \{1,2,...,M\} { 1 , 2 , . . . , M }

编码函数:X n : { 1 , 2 , . . . , M } → X n X^n:\{1,2,...,M\}\to\mathcal{X}^n X n : { 1 , 2 , . . . , M } → X n

译码函数:g : Y n → { 1 , 2 , . . . , M } g:\mathcal{Y}^n\to\{1,2,...,M\} g : Y n → { 1 , 2 , . . . , M }

信道编码 ( M , n ) (M,n) ( M , n )

信道编码:

原理:

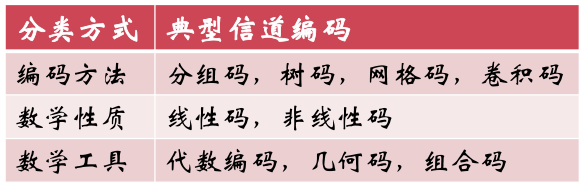

分类:

比如线性码(linear code)

编码函数为线性函数

任意个码字的线性组合仍然是码字

性能指标——错误概率:

λ i = P r { g ( Y n ) ≠ i ∣ X n = x n ( i ) } = ∑ y n q ( y n ∣ x n ( i ) ) I ( g ( y n ) ≠ i )

\begin{aligned}

\lambda_i&=\mathrm{Pr}\{g(Y^n)\not=i|X^n=x^n(i)\}\\

&=\sum_{y^n}q(y^n|x^n(i))I(g(y^n)\not=i)

\end{aligned}

λ i = P r { g ( Y n ) = i ∣ X n = x n ( i ) } = y n ∑ q ( y n ∣ x n ( i ) ) I ( g ( y n ) = i )

其中 I ( ⋅ ) I(\cdot) I ( ⋅ )

λ ( n ) = max i ∈ { 1 , . . . , M } λ i

\lambda^{(n)}=\max_{i\in\{1,...,M\}}\lambda_i

λ ( n ) = i ∈ { 1 , . . . , M } max λ i

P e ( n ) = 1 M ∑ i = 1 M λ i

P_e^{(n)}=\frac{1}{M}\sum_{i=1}^M\lambda_i

P e ( n ) = M 1 i = 1 ∑ M λ i

若输入等概,则算术平均错误概率等于译码错误概率

算术平均错误概率 ≤ \le ≤

性能指标——码率:

码率:R = log ∣ X ∣ M n R=\dfrac{\log_{|\mathcal{X}|}M}{n} R = n log ∣ X ∣ M

表示的是每个码字母所能携带的最大信息量,其中 log ∣ X ∣ M \log_{|\mathcal{X}|}M log ∣ X ∣ M n n n n n n R < 1 R<1 R < 1 n n n n n n

可达:

若存在(二元)序列 ( ⌈ 2 n R ⌉ , n ) (\lceil2^{nR}\rceil,n) ( ⌈ 2 n R ⌉ , n ) n → ∞ n\to\infty n → ∞ λ ( n ) → 0 \lambda^{(n)}\to 0 λ ( n ) → 0 R R R

2 n R ≤ ⌈ 2 n R ⌉ < 2 n R + 1 2^{nR}\le\lceil2^{nR}\rceil<2^{nR}+1 2 n R ≤ ⌈ 2 n R ⌉ < 2 n R + 1 ( ⌈ 2 n R ⌉ , n ) (\lceil 2^{nR}\rceil,n) ( ⌈ 2 n R ⌉ , n ) ( 2 n R , n ) (2^{nR},n) ( 2 n R , n )

信道容量的定义:

离散无记忆信道(DMC)的信道容量为所有可达码率的上确界(上确界指的是最小上界),C = sup R C=\sup{R} C = sup R

小于信道容量的码率可以获得任意小的差错概率

蕴含着渐进无差错和码的存在性,指导工程实践

信道容量定义:C = max I ( X ; Y ) C=\max I(X;Y) C = max I ( X ; Y )

香农第二定理说明了上述两种定义等价C = sup R ⟺ C = max I ( X ; Y )

C=\sup{R}\iff C=\max I(X;Y)

C = sup R ⟺ C = max I ( X ; Y )

信道传输中如何减少差错?

香农公式:C = W log ( 1 + P s N 0 W ) C=W\log{(1+\dfrac{P_s}{N_0W})} C = W log ( 1 + N 0 W P s )

提高抗干扰能力的方法:

增加功率(提高信噪比)

加大带宽(信号变化剧烈)

延长时间(降低速率)

最直观的设计:重复和增加冗余

重复码:

码率 R = k n R=\dfrac{k}{n} R = n k

误码率 P e = 1 k ∑ i = 1 k P e i , P e i = { v i ≠ u i } , i = 1 , . . . , k P_e=\frac{1}{k}\sum_{i=1}^kP_e^i,P_e^i=\{v_i\not=u_i\},i=1,...,k P e = k 1 ∑ i = 1 k P e i , P e i = { v i = u i } , i = 1 , . . . , k

码率 R R R P e P_e P e

R ≤ 1 − H ( p ) 1 − H ( P e )

R\le\frac{1-H(p)}{1-H(P_e)}

R ≤ 1 − H ( P e ) 1 − H ( p )

证明:

Fano 不等式(二进制)H ( X ∣ Y ) ≤ H ( P e ) + P e log ( K − 1 ) = H ( P e )

H(X|Y)\le H(P_e)+P_e\log(K-1)=H(P_e)

H ( X ∣ Y ) ≤ H ( P e ) + P e log ( K − 1 ) = H ( P e )

互信息I ( X ; Y ) ≥ I ( U , V ) ≥ ∑ i = 1 k I ( U i ; V i ) = ∑ i = 1 k ( H ( U i ) − H ( U i ∣ V i ) ) = k − ∑ i = 1 k H ( U i ∣ V i ) ≥ k − k H ( P e )

\begin{aligned}

I(X;Y)&\ge I(U,V)\ge\sum_{i=1}^kI(U_i;V_i)\\

&=\sum_{i=1}^k(H(U_i)-H(U_i|V_i))=k-\sum_{i=1}^kH(U_i|V_i)\\

&\ge k-kH(P_e)

\end{aligned}

I ( X ; Y ) ≥ I ( U , V ) ≥ i = 1 ∑ k I ( U i ; V i ) = i = 1 ∑ k ( H ( U i ) − H ( U i ∣ V i ) ) = k − i = 1 ∑ k H ( U i ∣ V i ) ≥ k − k H ( P e )

n C ≥ k ( 1 − H ( P e ) ) ⟹ k n ≤ 1 − H ( p ) 1 − H ( P e )

nC\ge k(1-H(P_e))\implies\frac{k}{n}\le\frac{1-H(p)}{1-H(P_e)}

n C ≥ k ( 1 − H ( P e ) ) ⟹ n k ≤ 1 − H ( P e ) 1 − H ( p )

传输速率与信道容量 R ≤ 1 − H ( p ) 1 − H ( P e ) = C 1 − H ( P e ) R\le\dfrac{1-H(p)}{1-H(P_e)}=\dfrac{C}{1-H(P_e)} R ≤ 1 − H ( P e ) 1 − H ( p ) = 1 − H ( P e ) C

误码率 P e ≥ H − 1 ( 1 − C R ) P_e\ge H^{-1}(1-\dfrac{C}{R}) P e ≥ H − 1 ( 1 − R C )

若 R > C R>C R > C P e > 0 P_e>0 P e > 0

若 R < C R<C R < C R = C R=C R = C P e P_e P e

好码的要求:

相同误码率下,码率越高越好

P e = 0 P_e=0 P e = 0 R R R

典型序列(Typical Sequence)

渐进均分性定理(AEP)

若 X 1 , . . . X n ∼ p ( x ) , i . i . d . , E X n = μ < ∞ X_1,...X_n\sim p(x),i.i.d.,EX_n=\mu<\infty X 1 , . . . X n ∼ p ( x ) , i . i . d . , E X n = μ < ∞ 1 n log p ( X 1 , . . . , X n ) ⟶ 依概率 H ( X )

\frac{1}{n}\log{p(X_1,...,X_n)}\overset{\text{依概率}}{\longrightarrow} H(X)

n 1 log p ( X 1 , . . . , X n ) ⟶ 依概率 H ( X )

典型序列及典型集(typical set)

序列 ( x 1 , . . . , x n ) ∈ X n (x_1,...,x_n)\in\mathcal{X}^n ( x 1 , . . . , x n ) ∈ X n 2 − n ( H ( X ) + ϵ ) ≤ p ( x 1 , . . . , x n ) ≤ 2 − n ( H ( X ) − ϵ ) 2^{-n(H(X)+\epsilon)}\le p(x_1,...,x_n)\le 2^{-n(H(X)-\epsilon)} 2 − n ( H ( X ) + ϵ ) ≤ p ( x 1 , . . . , x n ) ≤ 2 − n ( H ( X ) − ϵ ) A ϵ ( n ) A_\epsilon^{(n)} A ϵ ( n )

性质:

典型集的概率近似为 1

典型集中所有元素几乎是等概的

典型集的元素个数几乎等于 2 n H ( X ) 2^{nH(X)} 2 n H ( X )

联合典型序列(Jointly Typical Sequence, JTS)

联合典型序列

( X , Y ) ∼ p ( x , y ) (X,Y)\sim p(x,y) ( X , Y ) ∼ p ( x , y ) ( x n , y n ) ∈ X n × Y n (x^n,y^n)\in\mathcal{X}^n\times\mathcal{Y}^n ( x n , y n ) ∈ X n × Y n

∣ − 1 n log p ( x n ) − H ( X ) ∣ < ϵ |-\frac{1}{n}\log{p(x^n)}-H(X)|<\epsilon ∣ − n 1 log p ( x n ) − H ( X ) ∣ < ϵ ∣ − 1 n log p ( y n ) − H ( Y ) ∣ < ϵ |-\frac{1}{n}\log{p(y^n)}-H(Y)|<\epsilon ∣ − n 1 log p ( y n ) − H ( Y ) ∣ < ϵ ∣ − 1 n log p ( x n , y n ) − H ( X , Y ) ∣ < ϵ |-\frac{1}{n}\log{p(x^n,y^n)-H(X,Y)}|<\epsilon ∣ − n 1 log p ( x n , y n ) − H ( X , Y ) ∣ < ϵ 其中 p ( x n , y n ) = ∏ i = 1 n p ( x i , y i ) p(x^n,y^n)=\prod_{i=1}^np(x_i,y_i) p ( x n , y n ) = ∏ i = 1 n p ( x i , y i )

联合典型集

联合典型序列构成的集合记为 A ϵ ( n ) A_\epsilon^{(n)} A ϵ ( n )

联合渐进均分性(Joint AEP)

( X n , Y n ) ∼ p ( x n , y n ) = ∏ i = 1 n p ( x i , y i ) , i . i . d . (X^n,Y^n)\sim p(x^n,y^n)=\prod_{i=1}^np(x_i,y_i),i.i.d. ( X n , Y n ) ∼ p ( x n , y n ) = ∏ i = 1 n p ( x i , y i ) , i . i . d .

当 n → ∞ n\to\infty n → ∞ P r { ( X n , Y n ) ∈ A ϵ ( n ) } → 1 \mathrm{Pr}\{(X^n,Y^n)\in A_\epsilon^{(n)}\}\to 1 P r { ( X n , Y n ) ∈ A ϵ ( n ) } → 1

∣ A ϵ ( n ) ∣ ≤ 2 n ( H ( X , Y ) + ϵ ) , ∣ A ϵ ( n ) ∣ ≥ ( 1 − ϵ ) 2 n ( H ( X , Y ) − ϵ ) |A_\epsilon^{(n)}|\le 2^{n(H(X,Y)+\epsilon)},|A_\epsilon^{(n)}|\ge(1-\epsilon)2^{n(H(X,Y)-\epsilon)} ∣ A ϵ ( n ) ∣ ≤ 2 n ( H ( X , Y ) + ϵ ) , ∣ A ϵ ( n ) ∣ ≥ ( 1 − ϵ ) 2 n ( H ( X , Y ) − ϵ ) 如果 X ~ n \tilde{X}^n X ~ n Y ~ n \tilde{Y}^n Y ~ n ( X ~ n , Y ~ n ) ∼ p ( x n ) p ( y n ) (\tilde{X}^n,\tilde{Y}^n)\sim p(x^n)p(y^n) ( X ~ n , Y ~ n ) ∼ p ( x n ) p ( y n ) P r { ( X ~ n , Y ~ n ) ∈ A ϵ ( n ) } ≤ 2 − n ( I ( X ; Y ) − 3 ϵ ) \mathrm{Pr}\{(\tilde{X}^n,\tilde{Y}^n)\in A_\epsilon^{(n)}\}\le 2^{-n(I(X;Y)-3\epsilon)} P r { ( X ~ n , Y ~ n ) ∈ A ϵ ( n ) } ≤ 2 − n ( I ( X ; Y ) − 3 ϵ ) n n n P r { ( X ~ n , Y ~ n ) ∈ A ϵ ( n ) } ≥ ( 1 − ϵ ) 2 − n ( I ( X ; Y ) + 3 ϵ ) \mathrm{Pr}\{(\tilde{X}^n,\tilde{Y}^n)\in A_\epsilon^{(n)}\}\ge(1-\epsilon)2^{-n(I(X;Y)+3\epsilon)} P r { ( X ~ n , Y ~ n ) ∈ A ϵ ( n ) } ≥ ( 1 − ϵ ) 2 − n ( I ( X ; Y ) + 3 ϵ )

信息论最重要的结论

Shannon Theorem II (Noisy-channel coding theorem)

有噪信道可实现几乎无失真传输

该定理的结果与直观感觉正好相反

若信道有错误,如何能够完全纠正?

尤其是:纠正的过程本身也受错误的影响

基本思想:

允许任意小的非零错误概率存在

构造码列 C ( n ) , n → ∞ C^{(n)},n\to\infty C ( n ) , n → ∞

计算随机码的平均错误概率,随机码=所有码的平均=存在至少一个满足要求的码,即由于随机码

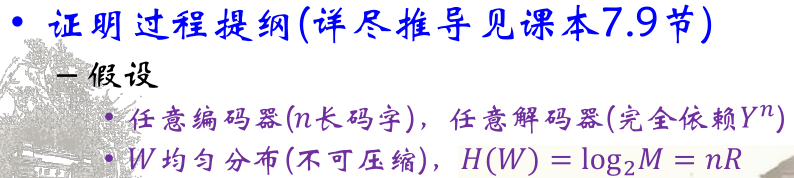

表述:

正定理:对于离散无记忆信道(DMC),小于其容量 C C C R < C R<C R < C ( 2 n R , n ) (2^{nR},n) ( 2 n R , n ) λ ( n ) → 0 \lambda^{(n)}\to0 λ ( n ) → 0

逆定理:对于任意编码方案 ( 2 n R , n ) (2^{nR},n) ( 2 n R , n ) λ ( n ) → 0 \lambda^{(n)}\to0 λ ( n ) → 0 R ≤ C R\le C R ≤ C

已知:DMC, X , Y , p ( y ∣ x ) , X ∼ p ( x ) \mathcal{X},\mathcal{Y},p(y|x),X\sim p(x) X , Y , p ( y ∣ x ) , X ∼ p ( x )

编码:

设 p ( x ) p(x) p ( x ) C C C I ( X ; Y ) = C I(X;Y)=C I ( X ; Y ) = C n n n p ( x ) p(x) p ( x ) ( 2 n R , n ) (2^{nR},n) ( 2 n R , n ) C ( n ) C^{(n)} C ( n )

∀ x n ∈ C ( n ) , p ( x n ) = ∏ i = 1 n p ( x i ) \forall x^n\in C^{(n)},p(x^n)=\prod_{i=1}^np(x_i) ∀ x n ∈ C ( n ) , p ( x n ) = ∏ i = 1 n p ( x i ) C ( n ) C^{(n)} C ( n ) 2 n R 2^{nR} 2 n R 设接收向量为 y n y^n y n p ( y n ∣ x n ) = ∏ i = 1 n p ( y i ∣ x i ) p(y^n|x^n)=\prod_{i=1}^np(y_i|x_i) p ( y n ∣ x n ) = ∏ i = 1 n p ( y i ∣ x i )

译码(前两种最优,第三种简单):

最大后验概率(MAP):选择 x ^ n ∈ C ( n ) \hat{x}^n\in C^{(n)} x ^ n ∈ C ( n ) p ( x ^ n ∣ y n ) p(\hat{x}^n|y^n) p ( x ^ n ∣ y n )

最大似然(ML):选择 x ^ n ∈ C ( n ) \hat{x}^n\in C^{(n)} x ^ n ∈ C ( n ) p ( y n ∣ x ^ n ) p(y^n|\hat{x}^n) p ( y n ∣ x ^ n )

典型集译码:选择 x ^ n ∈ C ( n ) \hat{x}^n\in C^{(n)} x ^ n ∈ C ( n ) x ^ n \hat{x}^n x ^ n y n y^n y n

若接收到的序列 y n y^n y n x ^ n \hat{x}^n x ^ n

否则,解码错误,记为事件 E \mathcal{E} E

目标:将证明若 R < C R<C R < C P r { E } → 0 \mathrm{Pr}\{\mathcal{E}\}\to0 P r { E } → 0

若平均错误概率 → 0 \to0 → 0 λ ( n ) → 0 \lambda^{(n)}\to0 λ ( n ) → 0 R R R

错误事件(两种情形):

存在 x ^ n \hat{x}^n x ^ n y n y^n y n x n x^n x n y n y^n y n x ^ n ≠ x n \hat{x}^n \neq x^n x ^ n = x n

x n x^n x n y n y^n y n

错误概率:

记 x n ( i ) x^n(i) x n ( i ) i i i i = 1 , . . . , M , M = 2 n R i=1,...,M,M=2^{nR} i = 1 , . . . , M , M = 2 n R x n ( 1 ) x^n(1) x n ( 1 )

令 E i ≜ { ( x n ( i ) , y n ) ∈ A ϵ ( n ) } E_i\triangleq\{(x^n(i),y^n)\in A_\epsilon^{(n)}\} E i ≜ { ( x n ( i ) , y n ) ∈ A ϵ ( n ) }

则λ 1 = P r { E ∣ x n ( 1 ) } = P r { E ˉ 1 ∪ E 2 ∪ . . . ∪ E M } ≤ P r { E ˉ 1 } + ∑ i = 2 M P r { E i } ≤ ϵ + ( M − 1 ) 2 − n [ I ( X ; Y ) − 3 ϵ ] ≤ ϵ + 2 3 n ϵ ⋅ 2 − n ( C − R ) ≤ 2 ϵ

\begin{aligned}

\lambda_1&=\mathrm{Pr}\{\mathcal{E}|x^n(1)\}=\mathrm{Pr}\{\bar{E}_1\cup E_2\cup...\cup E_M\}\\

&\le \mathrm{Pr}\{\bar{E}_1\}+\sum_{i=2}^M\mathrm{Pr}\{E_i\}\\

&\le\epsilon+(M-1)2^{-n[I(X;Y)-3\epsilon]}\\

&\le\epsilon+2^{3n\epsilon}\cdot 2^{-n(C-R)} \\

&\le 2\epsilon

\end{aligned}

λ 1 = P r { E ∣ x n ( 1 ) } = P r { E ˉ 1 ∪ E 2 ∪ . . . ∪ E M } ≤ P r { E ˉ 1 } + i = 2 ∑ M P r { E i } ≤ ϵ + ( M − 1 ) 2 − n [ I ( X ; Y ) − 3 ϵ ] ≤ ϵ + 2 3 n ϵ ⋅ 2 − n ( C − R ) ≤ 2 ϵ λ i = λ 1 ≤ 2 ϵ ⟹ P e ( n ) = P r { E } ≤ 2 ϵ \lambda_i=\lambda_1\le2\epsilon\implies P_e^{(n)}=\mathrm{Pr}\{\mathcal{E}\}\le2\epsilon λ i = λ 1 ≤ 2 ϵ ⟹ P e ( n ) = P r { E } ≤ 2 ϵ

码率的可达性

C ( n ) C^{(n)} C ( n ) p ( x ) p(x) p ( x ) ( M , n ) (M,n) ( M , n ) P e ( n ) P_e^{(n)} P e ( n ) C ( n ) C^{(n)} C ( n ) p ( x ) p(x) p ( x ) ( M , n ) (M,n) ( M , n )

∃ \exists ∃ ( M , n ) (M,n) ( M , n ) C ( n ) ∗ C^{(n)*} C ( n ) ∗ P r { C ( n ) 出 错 } ≤ 2 ϵ \mathrm{Pr}\{C^{(n)}出错\}\le2\epsilon P r { C ( n ) 出 错 } ≤ 2 ϵ 不妨设 λ 1 ∗ ≤ λ 2 ∗ ≤ . . . ≤ λ M ∗ \lambda_1^*\le\lambda_2^*\le...\le\lambda_M^* λ 1 ∗ ≤ λ 2 ∗ ≤ . . . ≤ λ M ∗ λ M / 2 ∗ ≤ 4 ϵ \lambda_{M/2}^*\le4\epsilon λ M / 2 ∗ ≤ 4 ϵ

构造新码 C ~ ( n ) ∗ = { C ( n ) ∗ 错 误 概 率 最 小 的 一 半 码 字 } \tilde{C}^{(n)*}=\{C^{(n)*}错误概率最小的一半码字\} C ~ ( n ) ∗ = { C ( n ) ∗ 错 误 概 率 最 小 的 一 半 码 字 }

最大错误概率 λ ~ ( n ) ∗ ≤ 4 ϵ \tilde{\lambda}^{(n)*}\le4\epsilon λ ~ ( n ) ∗ ≤ 4 ϵ

C ~ ( n ) ∗ \tilde{C}^{(n)*} C ~ ( n ) ∗ M 2 = 2 n R − 1 \frac{M}{2}=2^{nR-1} 2 M = 2 n R − 1 R ( 1 − 1 n ) R(1-\frac{1}{n}) R ( 1 − n 1 ) 当 n → ∞ n\to\infty n → ∞ C ~ ( n ) ∗ \tilde{C}^{(n)*} C ~ ( n ) ∗ R ( 1 − 1 n ) → R R(1-\frac{1}{n})\to R R ( 1 − n 1 ) → R λ ~ ( n ) ∗ → 0 \tilde{\lambda}^{(n)*}\to0 λ ~ ( n ) ∗ → 0

因此 R R R

需证明:

∀ \forall ∀ R R R R ≤ C R\le C R ≤ C ⟺ \iff ⟺ ∀ R > C \forall R>C ∀ R > C R R R P e ( n ) ↛ 0 P_e^{(n)}\not\to0 P e ( n ) → 0