应用信息论基础 第四章 信道与信道容量 笔记

学习要点:

- 信道特性

- 基本概念

- 信道模型及分类

- 信道容量特性

- 信道容量计算

- 离散信道容量

- 组合信道容量

- 连续及模拟信道容量

4.1 信道与信道容量

无记忆信道指的信道转移的这个特性在每一时刻彼此是独立的。

符号变为 个的话, bit

无噪声应该不等于无差错,因为假如两个不同的输入都以概率 映射到了同一个输出,那么也是产生了差错的。

这个例子很有意思。可以找到明确的译码方案来达到这个容量。

4.2 离散信道的信道容量

离散无记忆信道(DMC,discrete memoryless channel)

无记忆性:若某一时刻的输出仅和当时的输入有关,而与过去的输入和输出无关。

对于转移概率矩阵 ,它的每一行的和都是 ,但是列和不一定是

其中 是输出字符集的大小, 是输入字符集的大小。

额,这个证明我觉得可有可无,因为对称信道每一行是不同的排列,对于不同的输入字符,其输出的概率分布里的数值形成的集合是相同的,因此每一行的熵都相同,自然有 ,其中 为第 个输入字符。

然后 在输出分布为均匀分布时取得。

这个定理也很显然,对于对称信道,输出等概时,输入也是等概。我觉得这个证明写复杂了,对称信道每一行是不同的排列,每一列也是不同的排列,因此每一行的和是相同的,并且每一列的和也是相同的,也易知行和与列和都是 ,因此在输入等概时可以直接得出

其中 表示输入输出字符集大小,强对称信道中输入输出字符集的大小是一样的。

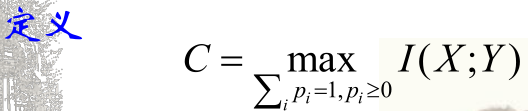

现在就是通过调整输入分布,来得到最大的 ,也就是 ,从而得到信道容量。其中 是输入分布, 是转移概率矩阵。

这个可以稍微算一下:

剩下的不算了,道理一样的。

这个定理的意思是,假如我们现在找到了一个能够达到信道容量的最佳分布 ,那么对于概率不为 的输入字符,其与输出字符的互信息必等于信道容量;假如该输入字符概率为 ,那么互信息必小于等于信道容量。

互信息的公式要记一下:

额,这个求偏导的地方步骤写的很简略…

重点就是分母上的 在求导的时候要展开。

妙啊。

单调递减这个也很显然,把分母写开之后发现 在分母这里,一层层推出去就发现这玩意是单减的。

二元对称信道怎么搞都行,可以直接

等号在输出字符之间独立时取到(因为信道是无记忆的,所以输出字符独立要求输入字符独立)

有记忆信道的结论和无记忆信道的结论中的不等号的方向是相反的。

4.3 信源与信道的匹配

为啥这么复杂。。要我来的话: 关于 上凸,因此极值点唯一。

4.4 组合的信道

这个和信道很有意思

4.5 连续信道的信道容量

4.6 模拟信道的信道容量