1.4 Multiplication and Inverse Matrices 阅读笔记

矩阵乘法(补充)和矩阵的逆

reference的内容为唯一教程,接下来的内容仅为本人的课后感悟,对他人或无法起到任何指导作用。

Reference

- Course website: Multiplication and Inverse Matrices | Unit I: Ax = b and the Four Subspaces | Linear Algebra | Mathematics | MIT OpenCourseWare

- Course video: 麻省理工公开课:线性代数-乘法和逆矩阵-网易公开课 (163.com)

- Course summary: Multiplication and Inverse Matrices (mit.edu)

- Extra reading: Section 2.4, 2.5 in Introduction to Linear Algebra, Fifth Edition by Gilbert Strang.

- Extra videos (3Blue1Brown):

上两讲直接起飞到了线性变换,但我发现提前开始了解这个概念之后对之后的intuition有帮助。这一讲回头补充一下1.1的[Matrix Multiplication](./1.1 The Geometry of Linear Equations.md#Matrix Multiplication),以及正式介绍耳熟能详的矩阵逆的求法:Gauss-Jordan Elimination,此外我对非方阵矩阵乘法的intuition有些疑惑因此补充了一点内容,整理1.5的时候直接把1.5的矩阵乘法逆也挪过来了,安排上有点乱。

Matrix Multiplication

目前我们学过的有:

Standard:

i行与j列的内积得到新矩阵i行j列的元素,因此前一个矩阵的列个数一定要等于后一个矩阵的行个数,而且m行n列乘n行p列会得到m行p列。

Column:

矩阵乘列向量相当于对矩阵的列向量进行线性组合。

但是还有些角度:

Row:

行向量乘矩阵相当于对矩阵的行向量线性组合。(之前一直把向量看作列向量,现在我开始分为行向量和列向量了)

Blocks:

矩阵可以分块乘法,懒得写了,因为我会。

Inverse

Definition

上一讲我们知道了如果再来一个线性变换让原来的方阵变成单位阵,那这个方阵就是方矩阵的逆。也就是说如果\({\mathbf{M}}'\mathbf{M}=\mathbf{I}\),则\({\mathbf{M}}'=\mathbf{M}^{-1}\),这个是左逆,还有右逆\(\mathbf{M}{\mathbf{M}}''=\mathbf{I}。有\)的运算左逆不等于右逆,但是矩阵乘法是等于的,也就是说\({\mathbf{M}}''=\mathbf{M}^{-1}={\mathbf{M}}'\):如果方阵可逆,那么左逆等于右逆。(这个是需要证明的,姑且当作已知条件~)

Linear Transformation

如果方阵可逆,相当于有一个抵消原有的线性变换的逆线性变换操作,把映射后的点再映射回去,因此线性变换前后的点是一对一的映射。多对一的映射(降维)无法产生逆线性变换(逆矩阵)。

Inverse of Matrix Multiplication

Judgment

怎么判断方阵可不可逆?这里给出了齐次线性方程组\(\mathbf{Ax}=\mathbf{0}\)的判断方法。

如果\(\mathbf{A}\)可逆,那方程两边就可以左乘\(\mathbf{A}^{-1}\),然后就得到\(\mathbf{x}=\mathbf{0}\)了。

如果\(\mathbf{A}\)不可逆,那说明列向量\(\mathbf{c}_i\)线性相关了,2向量至少共线/3向量至少共面/...,反正肯定有列向量浪费了,可以被其他的列向量线性组合出来,比如\(\mathbf{c}_3=x_1\mathbf{c}_1+x_2\mathbf{c}_2\),那么\(x_1\mathbf{c}_1+x_2\mathbf{c}_2-\mathbf{c}_3=\mathbf{0}\Rightarrow\begin{bmatrix}\mathbf{c}_1 & \mathbf{c}_2 & \mathbf{c}_3\end{bmatrix}\begin{bmatrix}x_1\\x_2\\x_3\end{bmatrix}=\mathbf{0}\)然后就得到\(\mathbf{x}\ne\mathbf{0}\)了。所以齐次线性方程组如果没有出现非零解,方阵就不可逆了。

Calculation

怎么求呢?其实就是解多个线性方程组:矩阵乘以矩阵的逆的第 \(j\) 列等于单位矩阵 \(\mathbf{I}\) 的第 \(j\) 列。

于是就可以用消元法了:列出\(\mathbf{A}\mathbf{A}^{-1}=\mathbf{I}\) → 写出增广矩阵\(\begin{bmatrix}\mathbf{A} & \vdots\mathbf{I}\end{bmatrix}\)

但是接下来不化成上三角了,初等行变换直接化为对角阵和\(\begin{bmatrix}\mathbf{I} & \vdots\mathbf{A}^{-1}\end{bmatrix}\) → 最右边的矩阵等于逆。也就是我们最熟悉的方法了。这方法叫Gauss-Jordan Elimination。

这方法能成的原因就是因为初等行变换相当于初等矩阵左乘~

Nonsquare Matrices as Transformations between Dimensions

前面都是在讨论方阵乘向量,方阵乘方阵的线性变换问题,那么非方阵的矩阵乘法怎么理解呢?

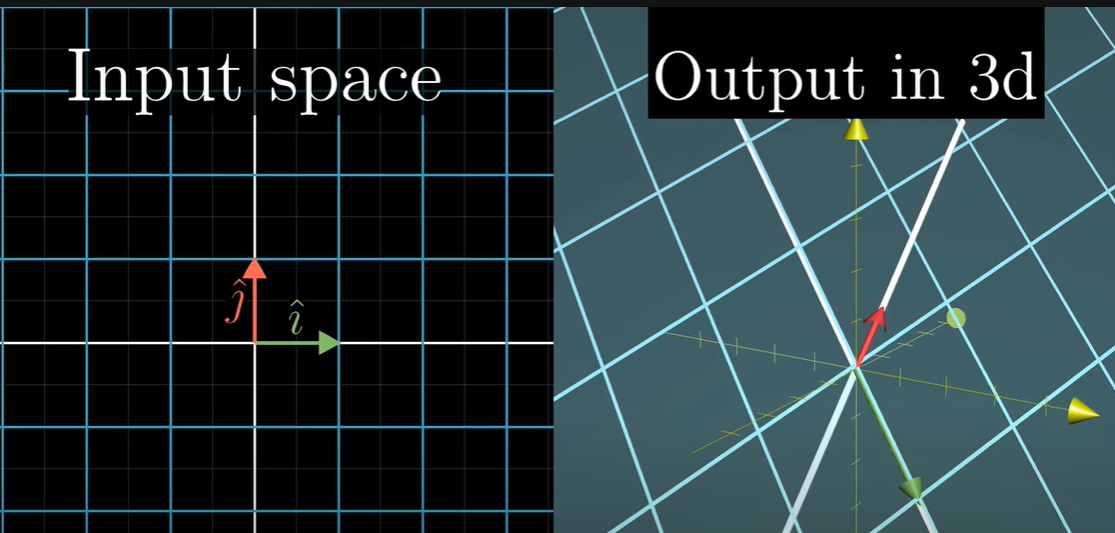

比如一个三行两列的矩阵\(\mathbf{A}=\begin{bmatrix}3 & 1\\4 & 1\\5 & 9\end{bmatrix}\),只能左乘到一个二维的向量上面,最上面提到了矩阵乘法的size规律,按照这个规律,会得到一个三维的向量,那么这个线性变换其实是把一个二维向量变成了三维的,基从单位向量\(\mathbf{i}=(1,0)\)和\(\mathbf{j}=(0,1)\)变成了两个三维的列向量。就像这样:

注意,维度的变换其实略微抽象,从二维空间变换到三维空间并不等同于从三维空间的一个平面变换到三维空间,空间的坐标轴/基的数量会变化。我们是将二维空间的\(\mathbf{i}=(1,0)\)和\(\mathbf{j}=(0,1)\)映射到了三维空间的矩阵的两个列向量,而不是将三维空间的\(\mathbf{i}=(1,0,0)\)和\(\mathbf{j}=(0,1,0)\)映射过去。

有升维就有降维,两行三列的矩阵会把一个三维的向量线性变换到一个二维向量,因此就降维了。

而矩阵乘法就可以看作线性变换的组合,只不过这次多了维度变换。

总结:非方阵的矩阵乘法是带有维度变换的线性变换。

reference的内容为唯一教程,接下来的内容仅为本人的课后感悟,对他人或无法起到任何指导作用。

reference的内容为唯一教程,接下来的内容仅为本人的课后感悟,对他人或无法起到任何指导作用。