Hadoop安装—Spark安装

Spark安装首先要先安装上Hadoop,然后才可以安装Spark。

Spark官网下载:http://spark.apache.org/downloads.html

需要注意的是:Spark对应的hadoop版本,然后上传至虚拟机

安装步骤:

1、加压文件,tar -zxvf spark-2.3.0-bin-hadoop2.7.tgz

配置环境变量,

2、拷贝配置文件,目录为./spark/config

cp spark-env.sh.template spark-env.sh

3、编辑文件,vi spark-env.sh,在最后增加如下内容:

export SPARK_DIST_CLASSPATH=$(/home/wdd/hadoop-2.9.0/bin/hadoop classpath)

指定spark和hadoop进行关联

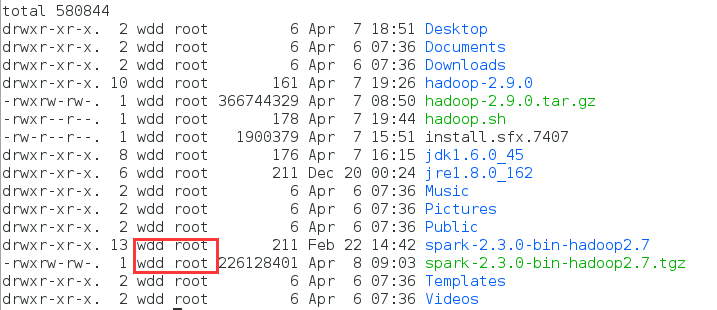

4、需要注意的是,所属组和所有者,如下图:

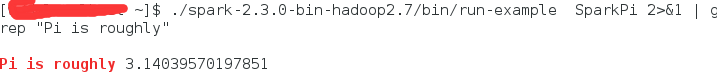

5、简单使用,计算pi的值

./spark-2.3.0-bin-hadoop2.7/bin/run-example SparkPi 2>&1 | grep "Pi is roughly"

有朝一日同风起,扶摇直上九万里

浙公网安备 33010602011771号

浙公网安备 33010602011771号