Tensorflow2.0笔记08——学习率策略

Tensorflow2.0笔记

本博客为Tensorflow2.0学习笔记,感谢北京大学微电子学院曹建老师

2. 学习率策略

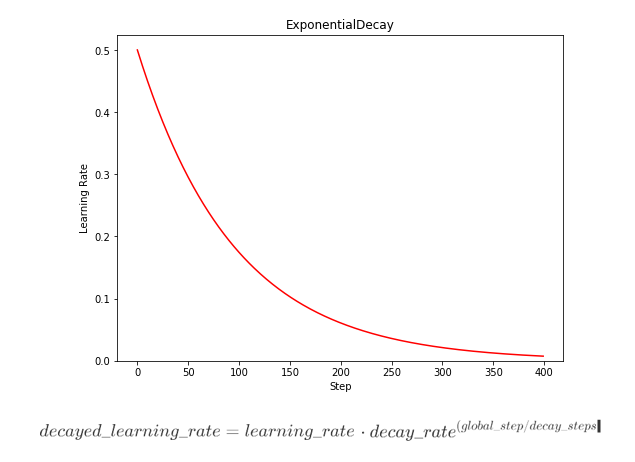

2.1 指数衰减

TensorFlow API: tf.keras.optimizers.schedules.ExponentialDecay

其中,learning_rate是初始学习率,decay_rate是衰减率,global_step表示从0到当前的训练次数,decay_steps用来控制衰减速度。

指数衰减学习率是先使用较大的学习率来快速得到一个较优的解,然后随着迭代的继续,逐步减小学习率,使得模型在训练后期 更加稳定。指数型学习率衰减法是最常用的衰减方法,在大量模型中都广泛使用。

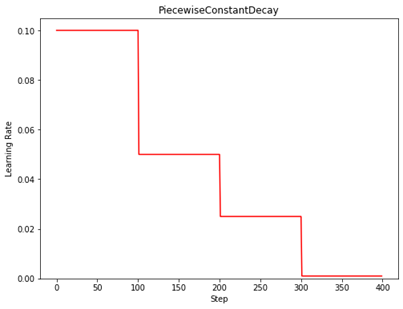

2.2 分段常数衰减

TensorFlow API: tf.optimizers.schedules.PiecewiseConstantDecay

分段常数衰减可以让调试人员针对不同任务设置不同的学习率,进行精细调参,在任意步长后下降 任意数值的learning rate,要求调试人员对模型和数据集有深刻认识。