神经网络与深度学习[邱锡鹏] 第五章习题解析

5-1

5-2

5-3

主要作用:

- 降维和升维:

每个1×1的卷积核都试图提取基于相同像素位置的特征的融合表达。可以实现特征升维和降维的目的。

比如,一张500 * 500且厚度depth为100 的图片在20个filter上做11的卷积,那么结果的大小为500500*20。 - 加入非线性:

1*1卷积核,可以在保持feature map尺度不变的(即不损失分辨率)的前提下大幅增加非线性特性(利用后接的非线性激活函数),把网络做的很deep。

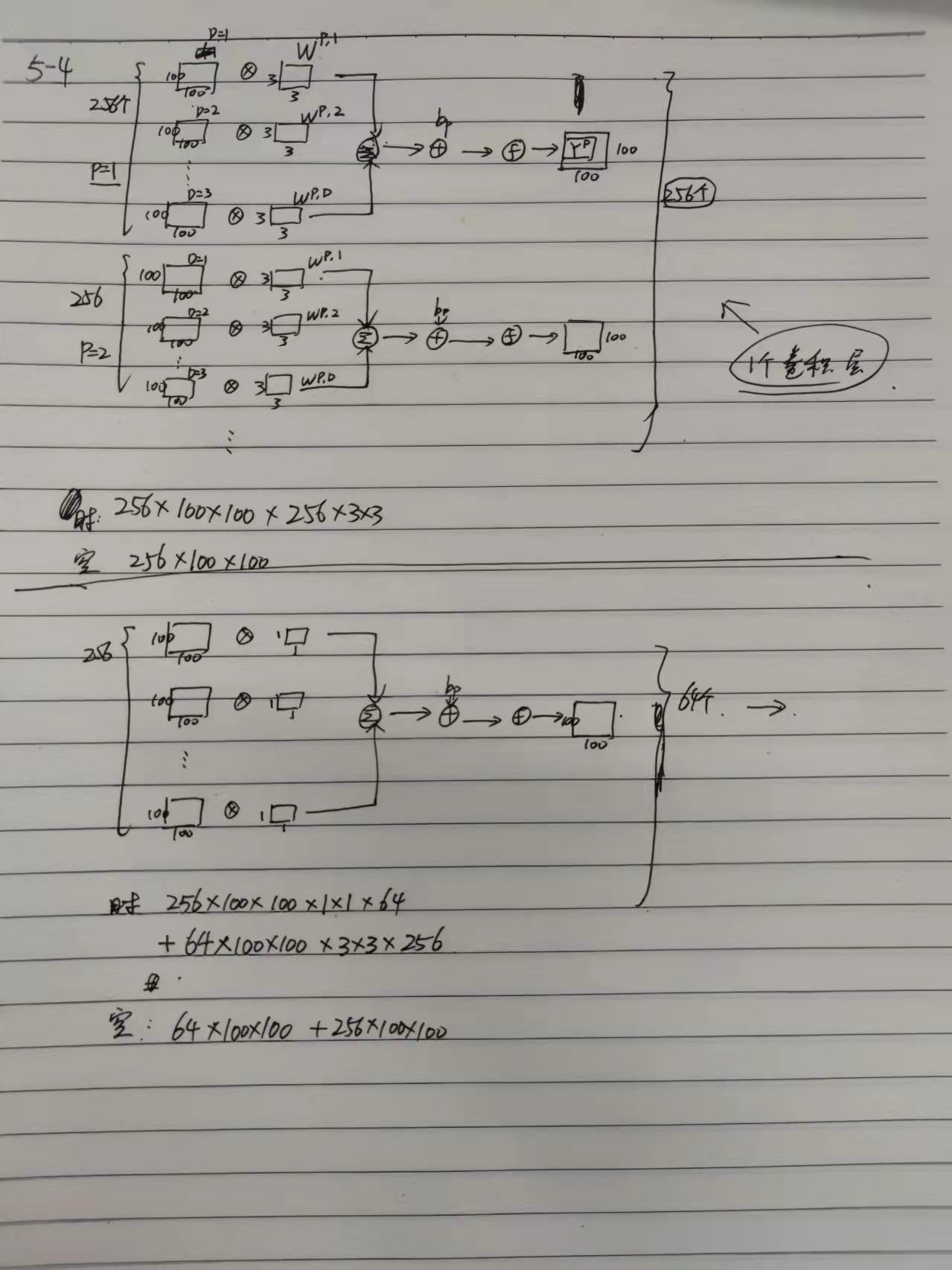

5-4

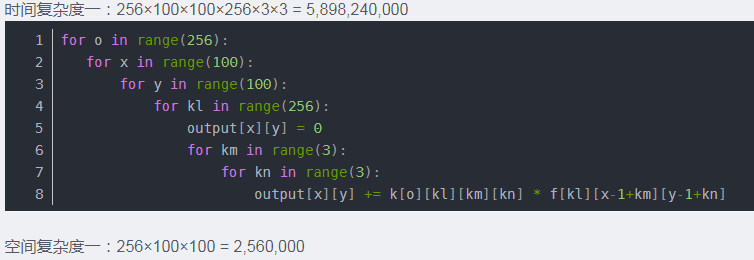

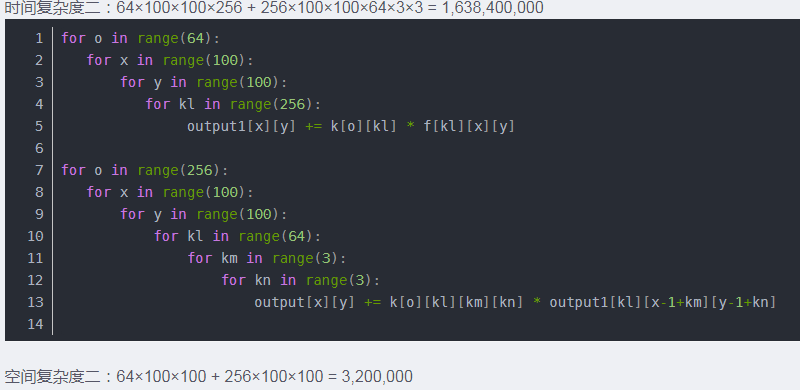

代码角度:

直观角度:

5-5

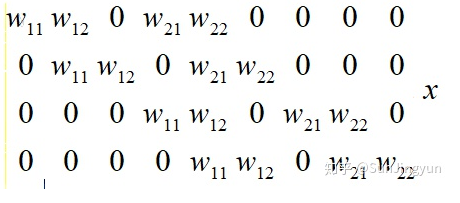

对于一个二维卷积,输入为3×3,卷积核大小为2×2,试将卷积操作重写为仿射变换的形式。

解析:将3×3输入展开成9维的。3×3的输入,卷积核大小为2×2,一共做四次卷积操作。在对应的位置上填写卷积核的值。

5-6

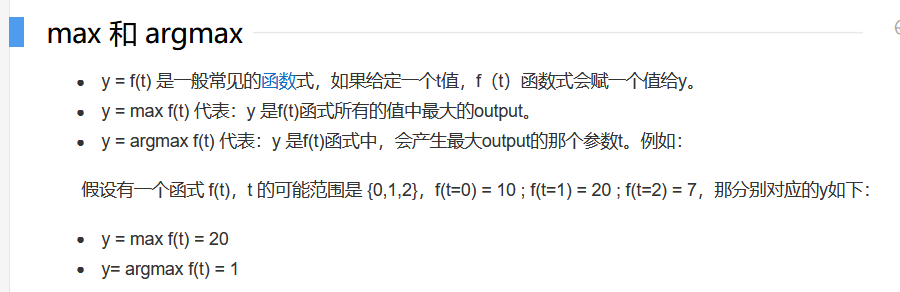

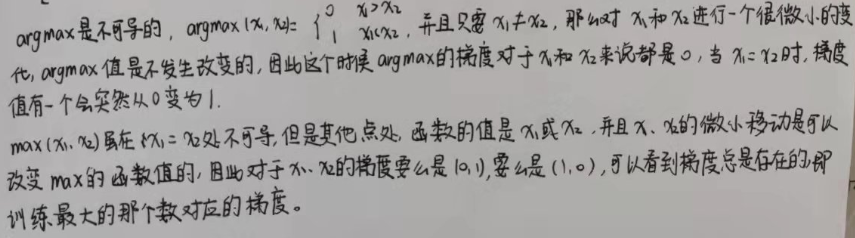

计算函数𝑦 = max(𝑥1, ⋯ , 𝑥𝐷)和函数𝑦 = arg max(𝑥1, ⋯ , 𝑥𝐷)的梯度。

这里的x1指的是f1(t),xd指的是fd(t)

5-7[佛啊]

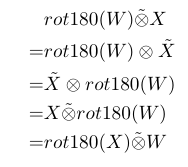

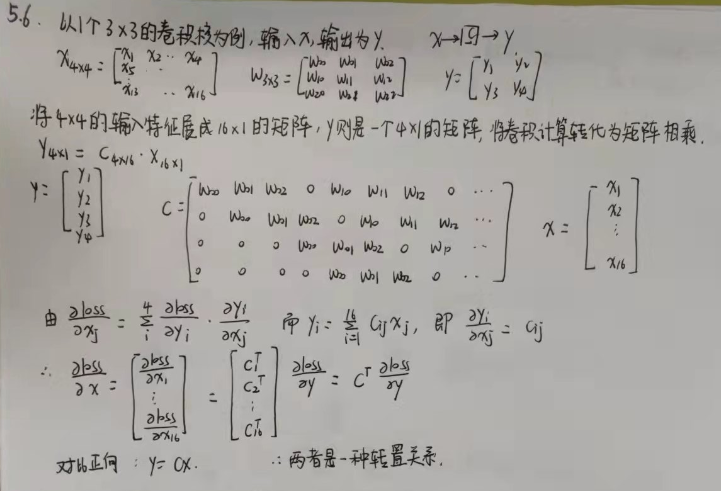

忽略激活函数,分析卷积网络中卷积层的前向计算和反向传播((公式5.39))是一种转置关系。

5-8

根据等宽卷积:

(M - K' + 2P)/S + 1 = M,其中S= 1,

K' = K + (K-1)(D-1),

求得 :

P = (K-1)D/2