math-2023-07-19

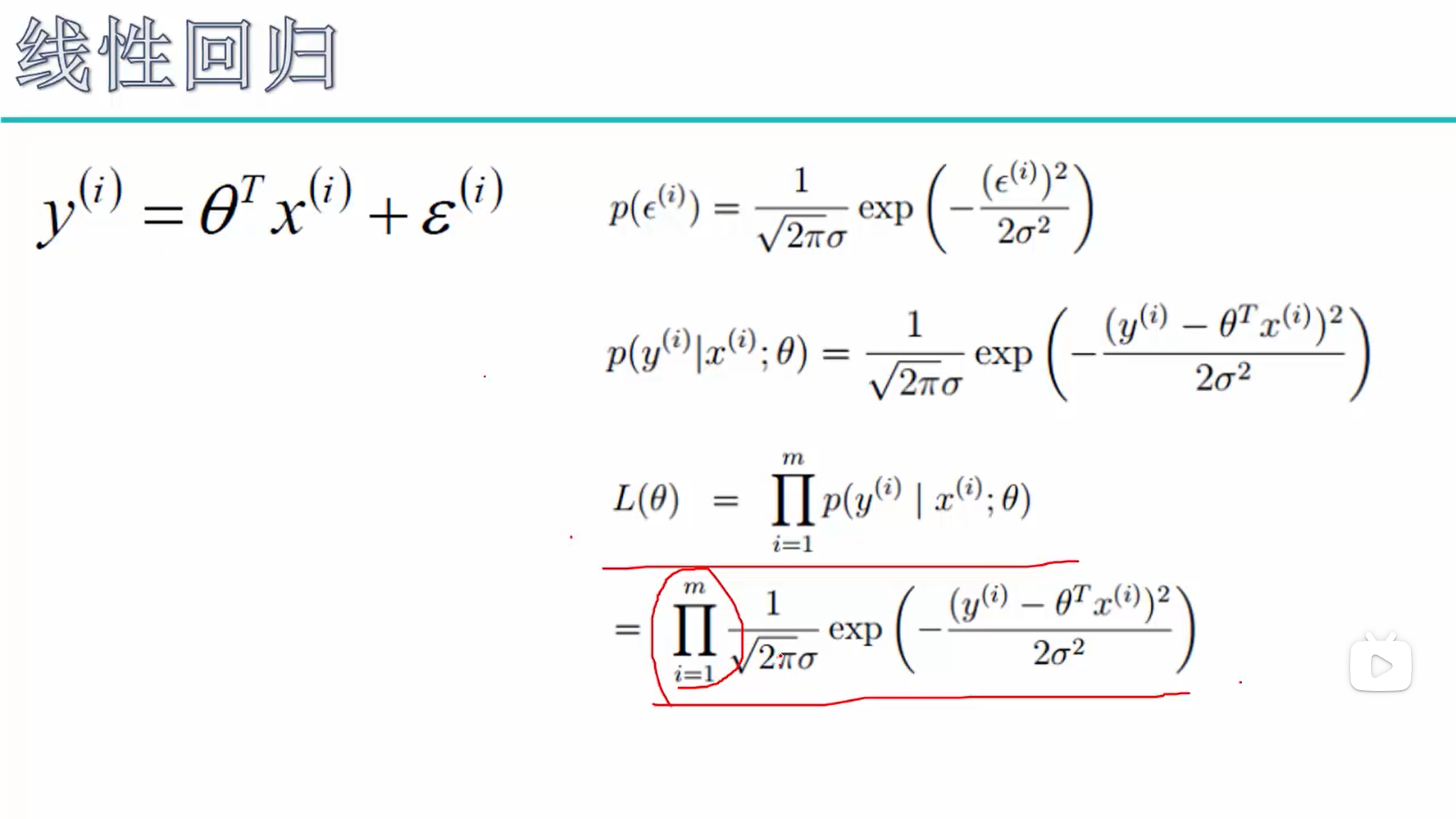

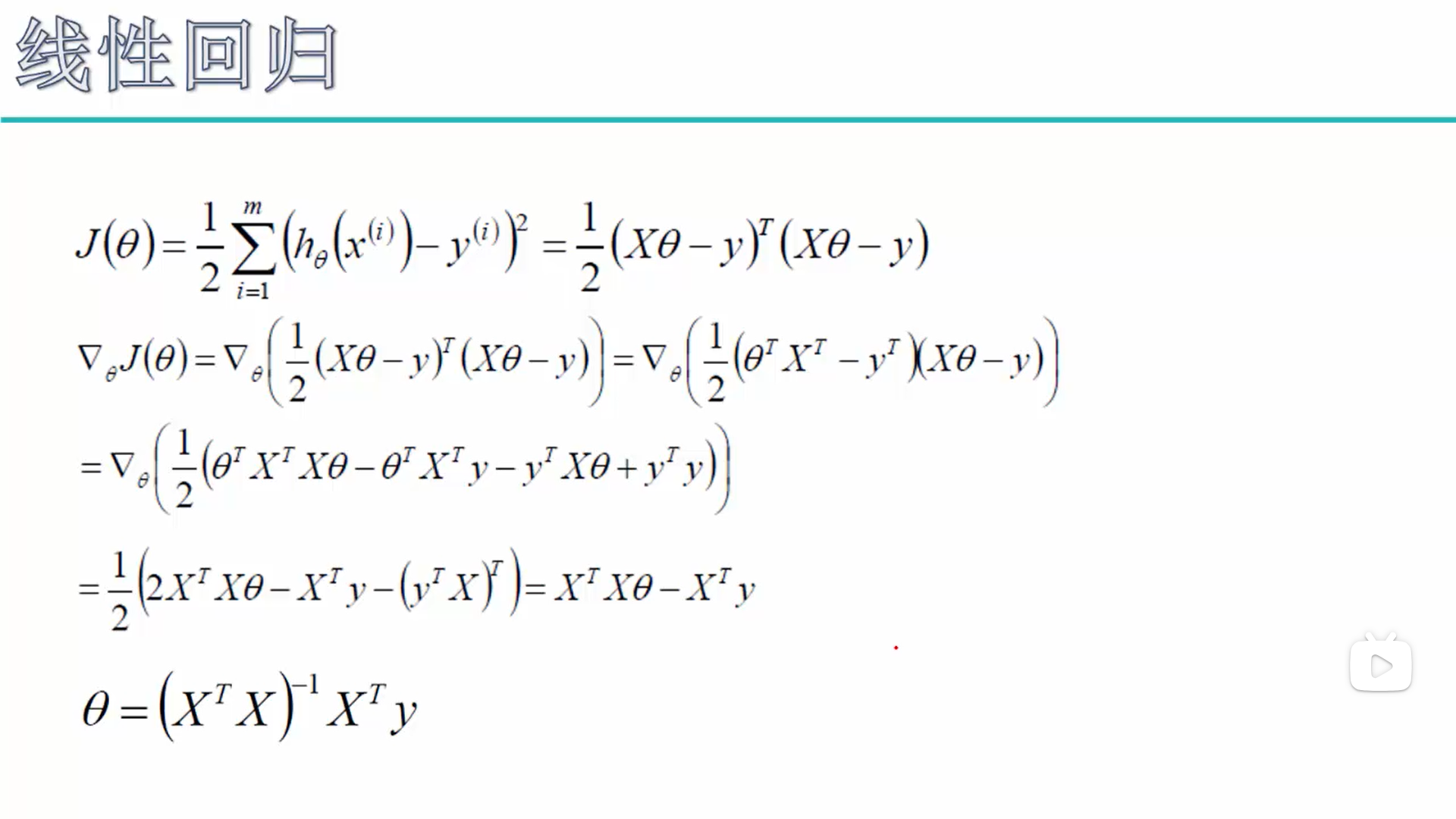

1、图片截取自《机器学习第二阶段:机器学习经典算法(1)-回归算法》视频的《4.目标函数求解》中00:32,第一个问题是误差项ε(i)为什么能代入正态分布公式(如果没有这一步,接下来的所有的公式变换都不复存在了,所以要解决这个问题)?其实主是因为满足正态分布(更准确来说是满足中心极限定理);第二个问题是为什么需要所有项的概率乘积L(θ)越大越好而不是越小越好?主要涉及最大似然估计,通俗理解可参考:(1)https://www.cnblogs.com/xiaoxia722/p/12820802.html,(2)https://zhuanlan.zhihu.com/p/26614750;第三个需要解决的是矩阵相关运算和求导:(1)https://blog.csdn.net/liankui6027/article/details/114984648,(2)https://blog.csdn.net/shyjhyp11/article/details/126814717。

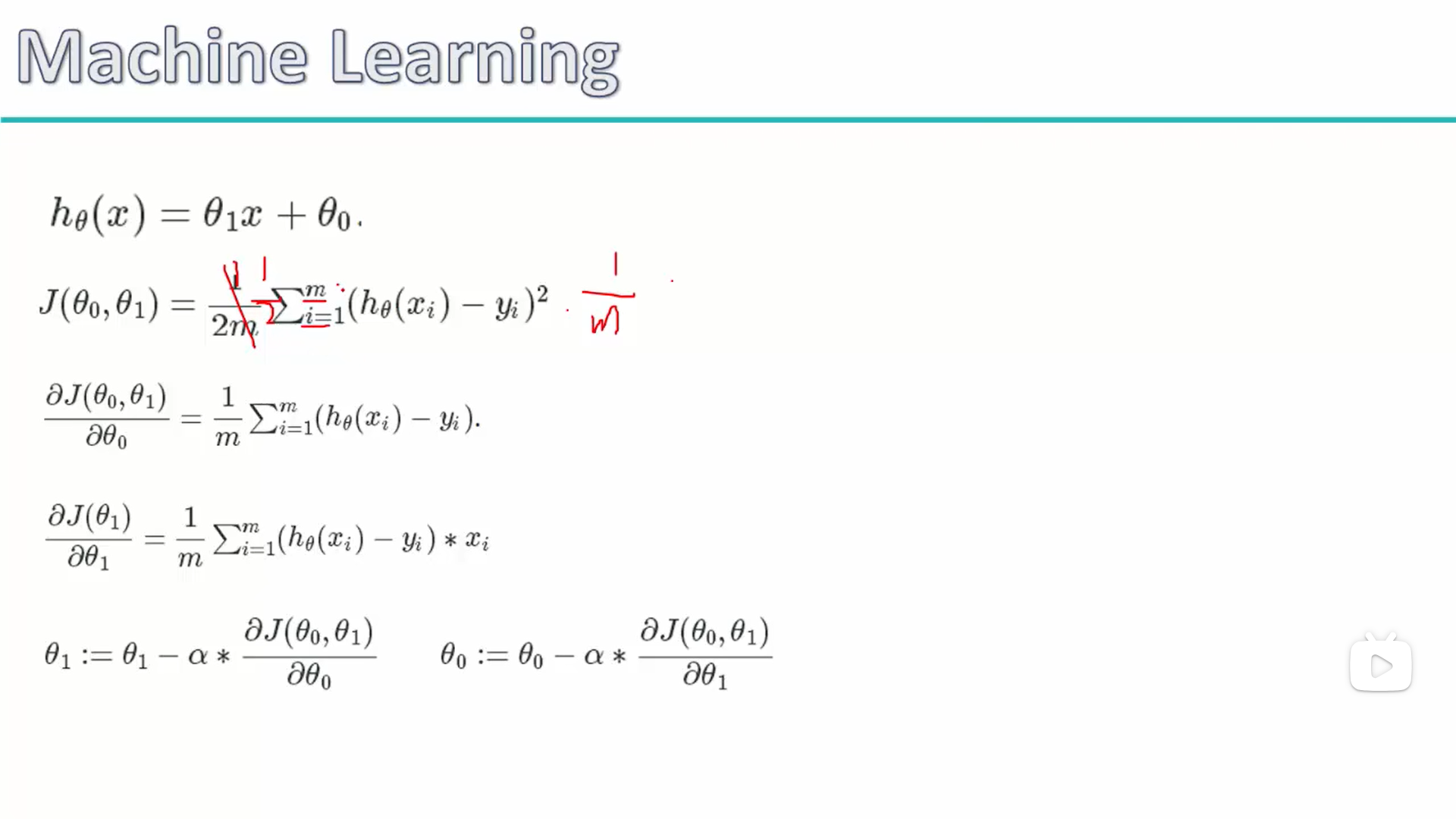

2、图片截取自《机器学习第二阶段:机器学习经典算法(1)-回归算法》视频的《6.梯度下降实例》中02:13,一般解释是:损失函数前面的1/m这个参数,主要是因为除以样本个数之后可以使得损失函数大小与样本数量的大小无关,深入了解的话会发现与均方误差有关:(1)https://blog.csdn.net/xuechanba/article/details/124364680。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律