机器学习第七堂课20210415

无监督降维

无监督有三类:降维、聚类、概率建模。

本节课主要讲降维和聚类。PCA(主成分分析)

降维的主要应用:一、数据可视化(Scatter plot)直接去掉某个维度会丢失大量数据信息。

降维具有如下一些优点:

- 1) 使得数据集更易使用。

- 2) 降低算法的计算开销。

- 3) 去除噪声。

- 4) 使得结果容易理解。

数据可视化(Scatter plot matrix散点图矩阵)适用于维度不是很大的数据。

背景知识

协方差矩阵:

数据集两个维度之间的协方差

降维的目的:图像处理、基因学。

高维特征的问题:存在大量冗余的特征,降低了机器学习的性能;数据分布可视化问题;维度灾难。

维度灾难:数据分布不符合直觉;不利于统计分析;影响机器学习性能。

内在维度(intrinsic dimensionality)

内在维度:表征数据变化的自由变量的个数。

a)1维线性子空间(直线)

b)1维非线性子空间(圆)

c)1维非线性子空间--流形(抛物线)

降维的算法有很多,比如奇异值分解(SDV)、主成分分析(PCA)、因子分析(FA)、独立成分分析(ICA)。

PCA是线性降维的方法。

MDA是非线性降维的方法。

LDA算法是监督的降维。

无监督的降维:数据没有类别标签。

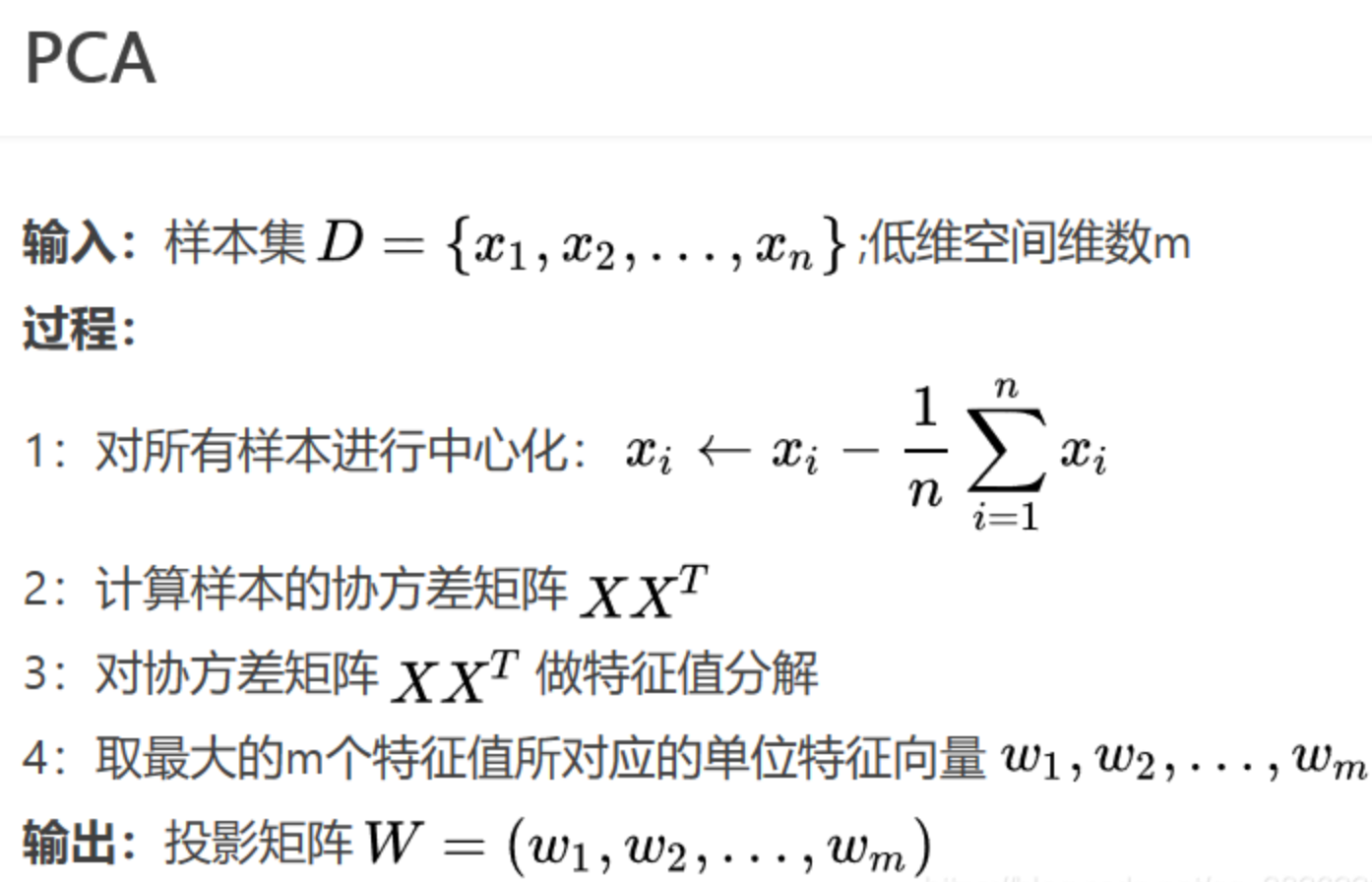

PCA的过程:

线性降维:将d维的原始数据X = (x1,x2,x3,,,,,,xm)属于Rd*m

线性投影到d' 维子空间Z = W的转置X

投影矩阵:W属于R(d*d')降维后数据:Z属于R(d'*m)

通常 d' <<d

最佳的子空间(主成分):

一、最小重构误差:数据样本到投影点的距离最近。

二、方差最大化。数据样本的投影点之间尽可能分散。

tr:矩阵的迹。方差最大,则tr需要max。

最小重构误差和方差最大化的目标函数是等价的。

PCA的优化算法:最小化式子,带有等式约束。

对 等式约束 的目标函数使用拉格朗日乘子法 可以得到:

协方差矩阵的意义:

1、 特征值就是方差,需要最大化

2、特征向量需要最小化,是最小重构误差。

PCA的应用:

1、数值计算

2、特征脸:经过PCA得到脸部图像特征值,当主成分个数m>=100,重构图像很接近原始图像。

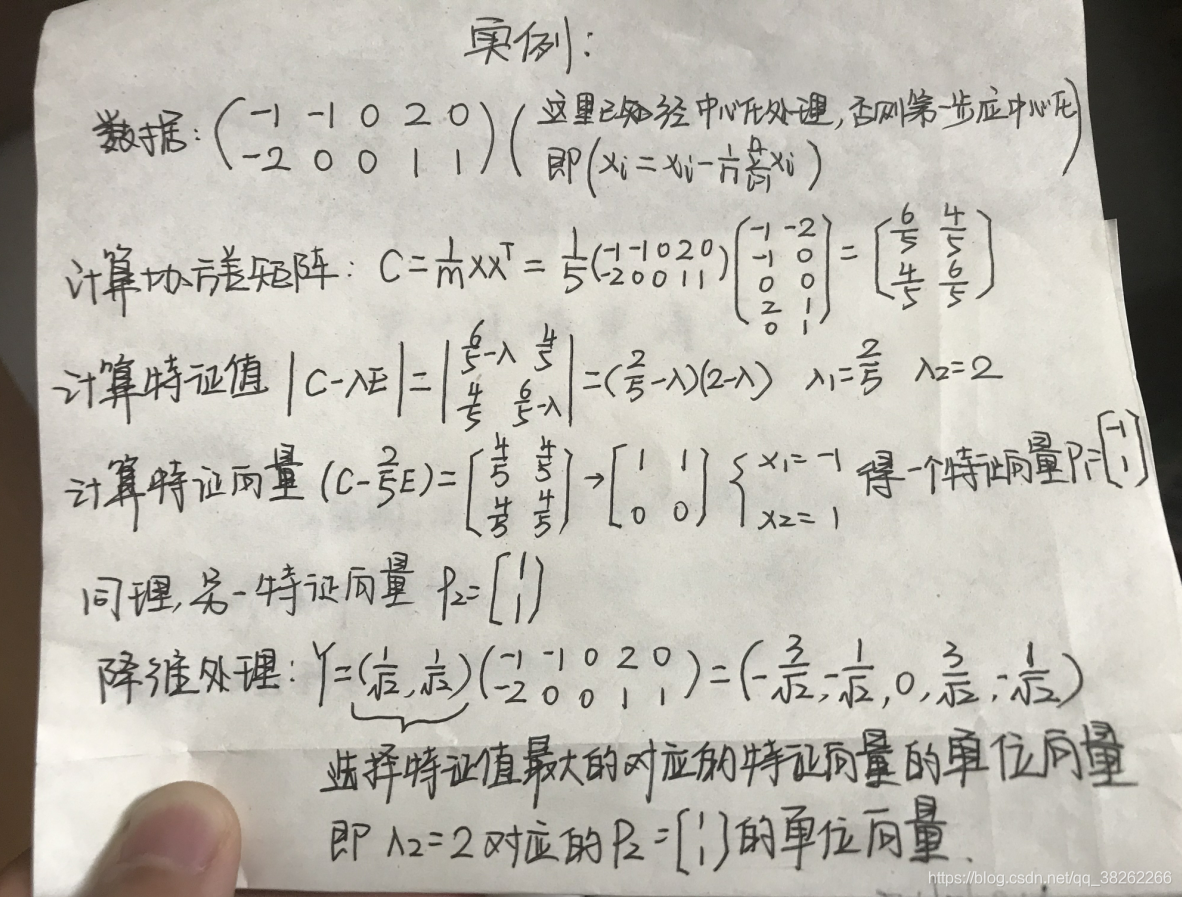

参考链接:https://blog.csdn.net/program_developer/article/details/80632779

https://blog.csdn.net/qq_38262266/article/details/100592330