多网卡绑定bond和team

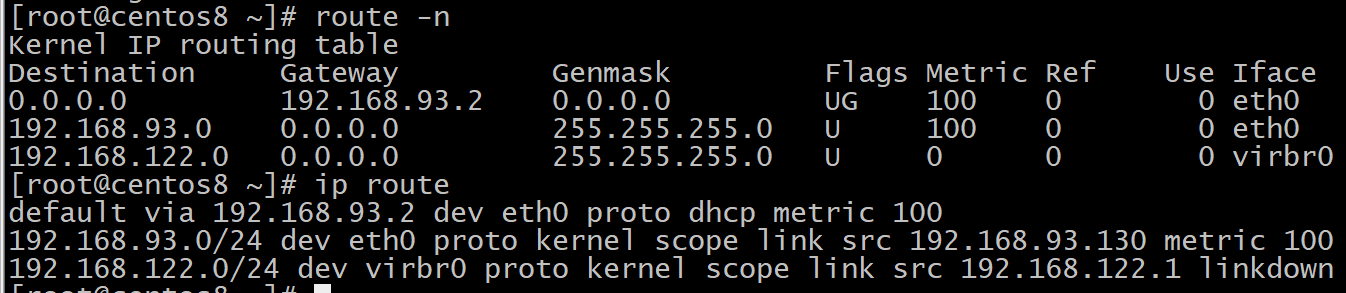

1.我们知道route -n可以显示路由表信息,其实还有一个命令可以

ip route

结果和route -n是一样的。

2.如果我们现在想要删除路由表的记录,就可以使用ip route

比如删除上图的第二个路由记录,只用把ip route中的那条记录复制下来在ip route后加上del即可:

ip route del 192.168.93.0/24 dev eth0 proto kernel scope link src 192.168.93.130 metric 100

想要还原,将del换成add即可:

ip route add 192.168.93.0/24 dev eth0 proto kernel scope link src 192.168.93.130 metric 100

所以ip route这个命令的好处就是:它的显示结果可以直接加到命令去用,比较方便。

3.多网卡绑定Bonding:

在生产中为了服务器的稳定,经常会将多个网卡绑成一起,让其绑定同一IP对外提服务,物理网卡空用同一MAC地址。

优点:加强容错率

Bonding工作模式(7种):

Mode 0:负载均衡—所有链路处于负载均衡状态,轮询方式往每条链路发送报文这模式的特点增加了带宽, 同时支持容错能力,当有链路出问题,会把流量切换到正常的链路上。 性能问题—一个连接或者会话的数据包如果从不同的接口发出的话,中途再经过不同的链路,在客 户端很有可能会出现数据包无序到达的问题,而无序到达的数据包需要重新要求被发送,这样网络 的吞吐量就会下降。Bond0在大压力的网络传输下,性能增长的并不是很理想。

Mode 1:容错能力—只有一个slave是激活的(active)。也就是说同一时刻只有一个网卡处于工作状态,其他 的slave都处于备份状态,只有在当前激活的slave故障后才有可能会变为激活的(active)。 无负载均衡—此算法的优点是可以提供高网络连接的可用性,但是它的资源利用率较低,只有一个 接口处于工作状态,在有 N 个网络接口的情况下,资源利用率为1/N。

Mode 2:即:(balance-xor) XOR policy(平衡策略)聚合口数据报文按源目MAC、源目IP、源目 端口进行异或HASH运算得到一个值,根据该值查找接口转发数据报文 负载均衡—基于指定的传输HASH策略传输数据包。 容错能力—这模式的特点增加了带宽,同时支持容错能力,当有链路出问题,会把流量切换到正常 的链路上。 性能问题—该模式将限定流量,以保证到达特定对端的流量总是从同一个接口上发出。既然目的地 是通过MAC地址来决定的,因此该模式在“本地”网络配置下可以工作得很好。如果所有流量是通过 单个路由器,由于只有一个网关,源和目标mac都固定了,那么这个算法算出的线路就一直是同一 条,那么这种模式就没有多少意义了。

Mode 3:即:broadcast(广播策略)这种模式的特点是一个报文会复制两份往bond下的两个接 口分别发送出去, 当有对端交换机失效,感觉不到任何downtime,但此法过于浪费资源;不过这种模式有很好的容 错机制。此模式适用于金融行业,因为他们需要高可靠性的网络,不允许出现任何问题。

Mode 4:即:(802.3ad) IEEE 802.3ad Dynamic link aggregation(IEEE 802.3ad 动态链接聚 合) 在动态聚合模式下,聚合组内的成员端口上均启用LACP(链路汇聚控制协议)协议,其端口状态 通过该协议自动进行维护。 负载均衡—基于指定的传输HASH策略传输数据包。默认算法与blance-xor一样。 容错能力—这模式的特点增加了带宽,同时支持容错能力,当有链路出问题,会把流量切换到正常 的链路上。对比blance-xor,这种模式定期发送LACPDU报文维护链路聚合状态,保证链路质量。

Mode 5:即:(balance-tlb) Adaptive transmit load balancing(适配器传输负载均衡) 在每个物理接口上根据当前的负载(根据速度计算)分配外出流量。如果正在接收数据的物理接口 口出故障了,另一个物理接口接管该故障物理口的MAC地址。 需要ethtool支持获取每个slave的速率

mod=6:即:(balance-alb) Adaptive load balancing(适配器适应性负载均衡) 该模式包含了balance-tlb模式,同时加上针对IPV4流量的接收负载均衡,而且不需要任何 switch(交换机)的支持。接收负载均衡是通过ARP协商实现的。bonding驱动截获本机发送的ARP 应答,并把源硬件地址改写为bond中某个物理接口的唯一硬件地址,从而使得不同的对端使用不 同的硬件地址进行通信。 mod=6与mod=0的区别:mod=6,先把eth0流量占满,再占eth1,….ethX;而mod=0的话,会 发现2个口的流量都很稳定,基本一样的带宽。而mod=6,会发现第一个口流量很高,第2个口只 占了小部分流量。

4.配置Bonding,可以直接改配置文件也可以使用命令。

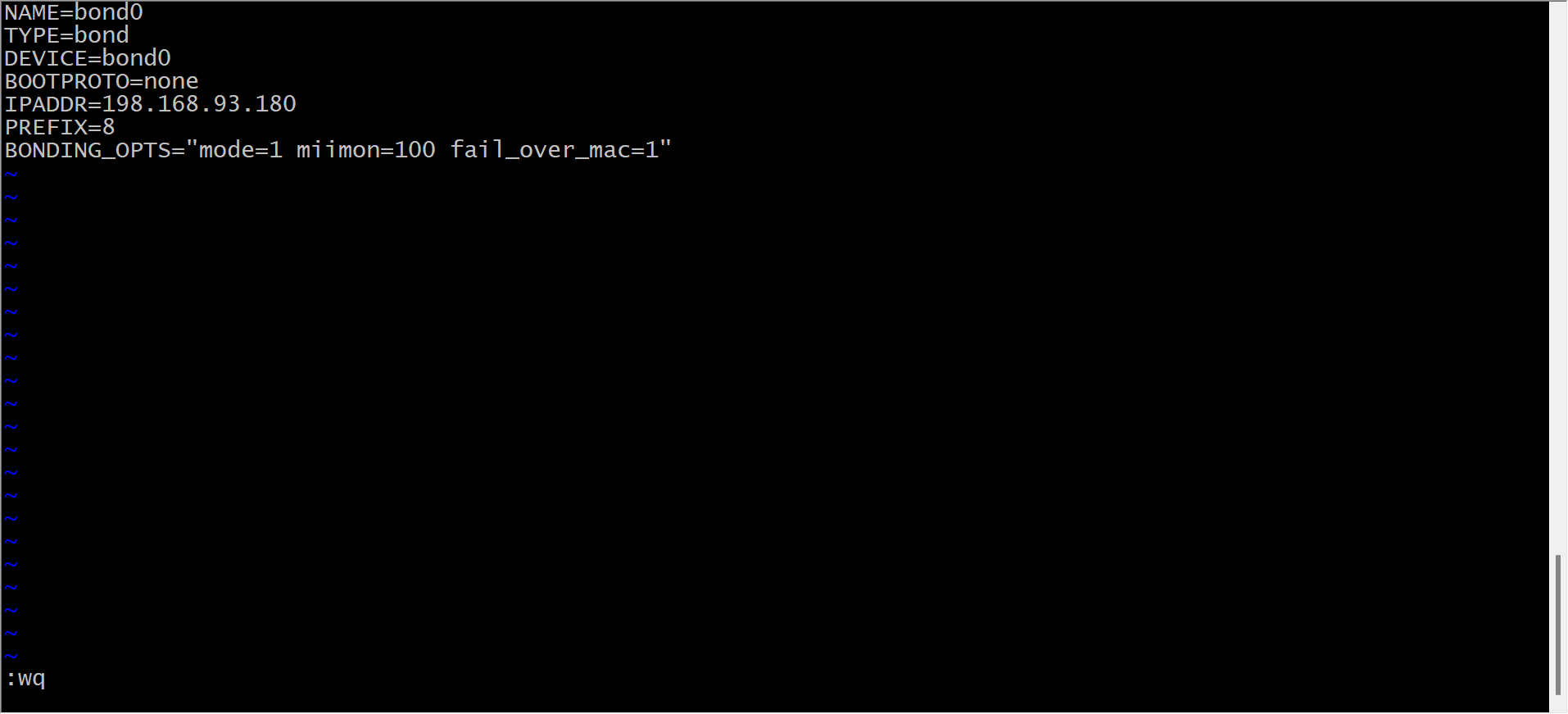

我们先用改配置文件的方法配置:

第一步:在/etc/sysconfig/network-scripts/目录下创建一个名为ifcfg-bond0的文件并增加配置,配置内容如下。

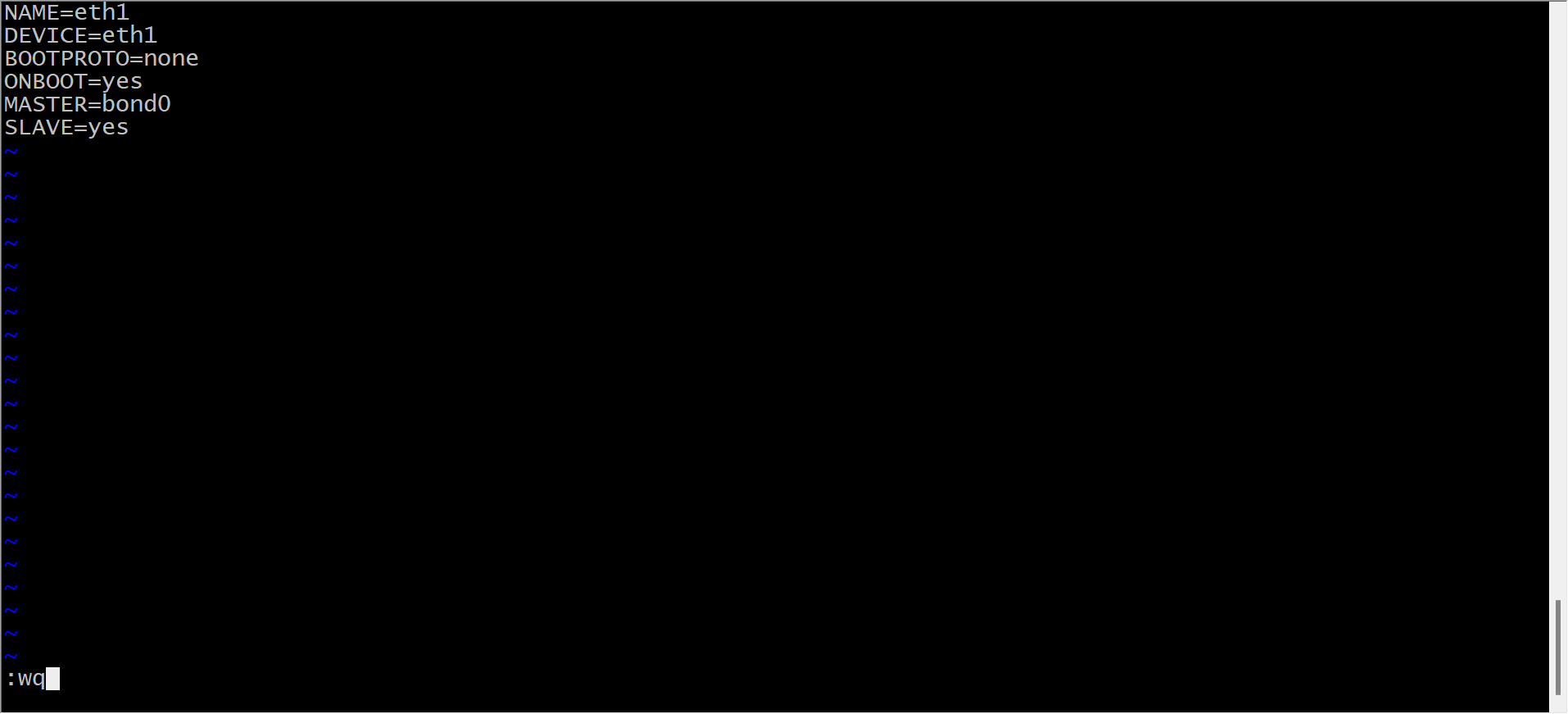

第二步,配置网卡文件

第三步,重启网络服务

service network restart

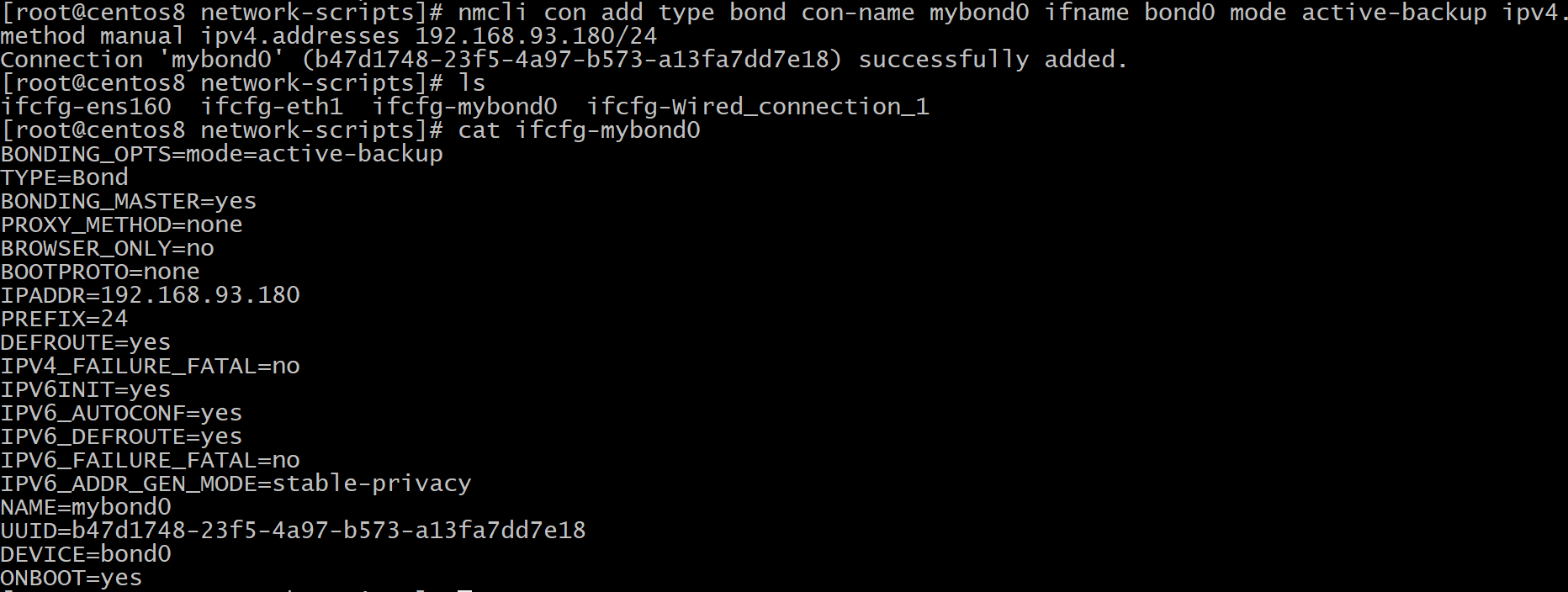

再用命令创建Bonding

第一步,添加Bonding接口

nmcli con add type bond con-name mybond0 ifname bond0 mode active-backup ipv4.method manual ipv4.addresses 192.168.93.180/24

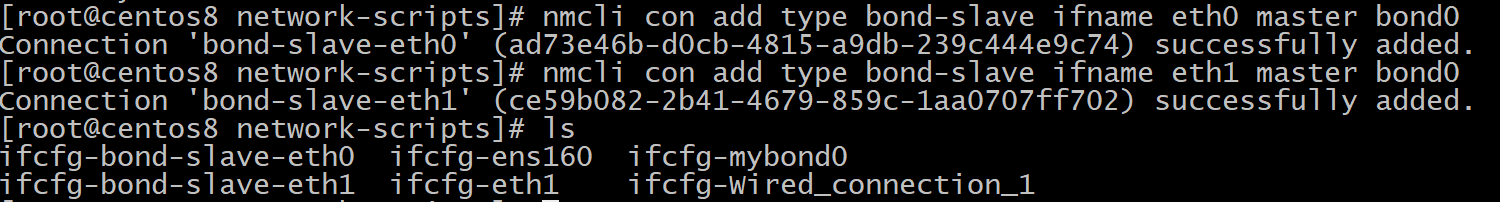

第二步,添加从属接口

nmcli con add type bond-slave ifname eth0 master bond0

nmcli con add type bond-slave ifname eth1 master bond0

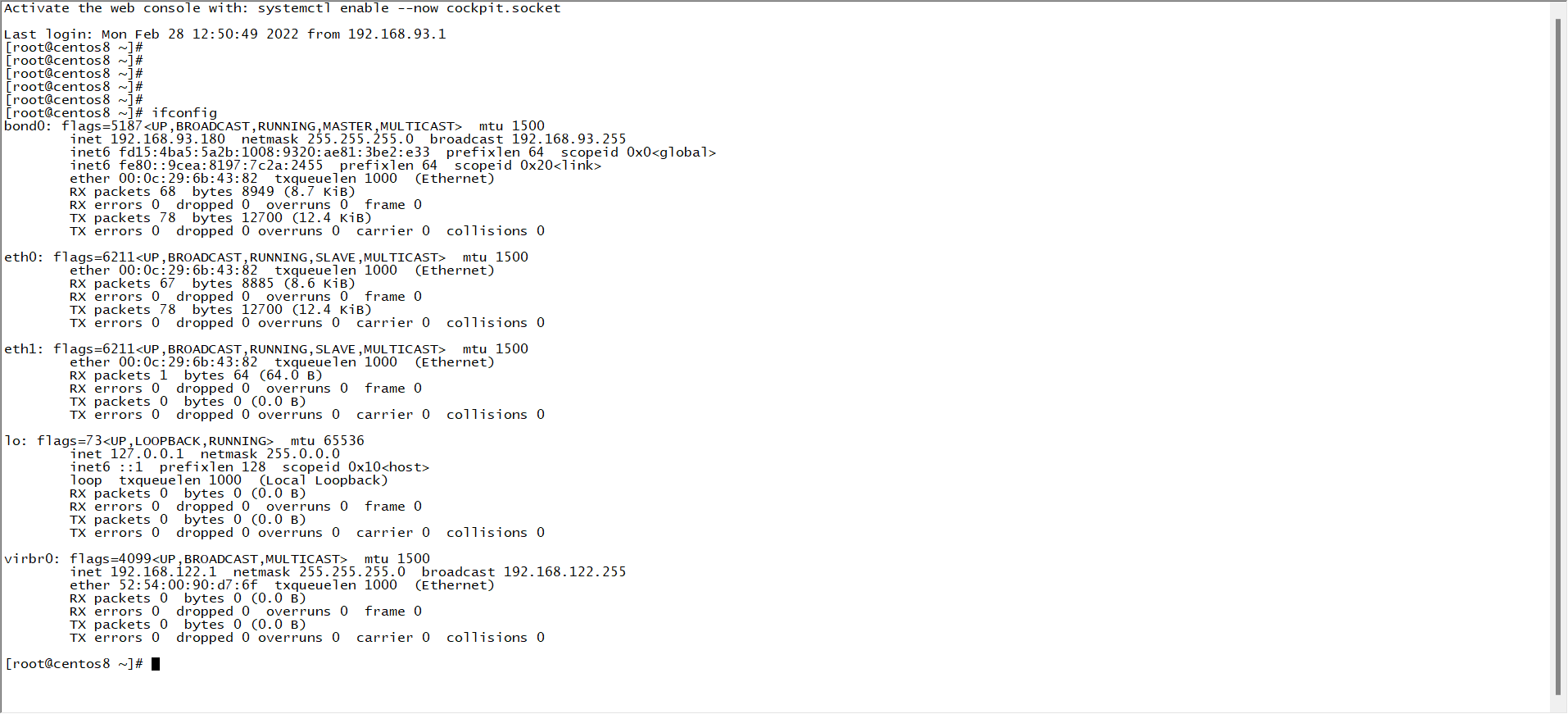

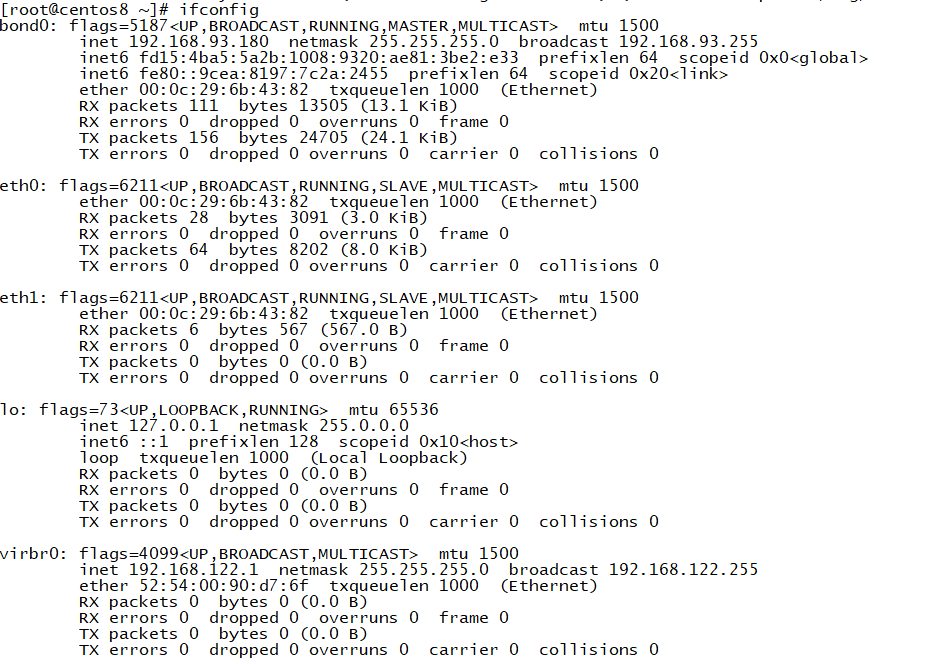

第三步,启动从属接口从而启动绑定

nmcli con up bond-slave-eth0

nmcli con up bond-slave-eth1

最后一步,启用绑定

nmcli con up mybond0

5.配置Team

网络组:是将多个网卡聚合在一起方法,从而实现冗错和提高吞吐量。和Bonding相似。

1、创建一个网络组接口

nmcli connection add type team con-name team0 ifname team0 config '{"runner":{"name":"activebackup"}}'

2、配置team0

[root@centos7 ~]# nmcli connection modify team0 ipv4.addresses 172.20.108.244/16 ipv4.method manual ipv4.gateway 172.20.0.1

3、创建port接口

nmcli connection add con-name team0-eth1 type team-slave ifname eth1 master team0

nmcli connection add con-name team0-eth2 type team-slave ifname eth2 master team0

4、启动team0及从属接口

nmcli connection up team0 nmcli connection up team0-eth1 nmcli connection up team0-eth2

5、查看工作状态

teamdctl team0 state

6、配置文件示例:

[root@centos7 network-scripts]# cat ifcfg-team0 DEVICE=team0 TEAM_CONFIG="{\"runner\":{\"name\":\"activebackup\"}}" PROXY_METHOD=none BROWSER_ONLY=no BOOTPROTO=dhcp DEFROUTE=yes IPV4_FAILURE_FATAL=no IPV6INIT=yes IPV6_AUTOCONF=yes IPV6_DEFROUTE=yes IPV6_FAILURE_FATAL=no IPV6_ADDR_GEN_MODE=stable-privacy NAME=team0 UUID=6c68702b-2ec5-4ca3-b7a2-0b609316c75c ONBOOT=yes DEVICETYPE=Team #IPADDR=172.20.108.244 #PREFIX=16 #GATEWAY=172.20.0.1 [root@centos7 network-scripts]# cat ifcfg-team0-eth1 NAME=team0-eth1 UUID=9be1b6bf-3f40-4d93-b686-aff1b6c32ec8 DEVICE=eth1 ONBOOT=yes TEAM_MASTER=team0 DEVICETYPE=TeamPort [root@centos7 network-scripts]# cat ifcfg-team0-eth2 NAME=team0-eth2 UUID=5f26b005-4f7d-4c13-af42-2fe98f7ec545 DEVICE=eth2 ONBOOT=yes TEAM_MASTER=team0 DEVICETYPE=TeamPort

7、删除team0

nmcli connection down team0 nmcli connectioni delete team0-eth0 nmcli connectioni delete team0-eth1

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· 25岁的心里话