NLP复习之神经网络

NLP复习之神经网络

前言

tips:

- 设计神经网络时,输入层与输出层节点数往往固定,中间层可以自由指定;

- 神经网络中的拓扑与箭头代表预测过程数据流向,与训练的数据流有一定区别;

- 我们不妨重点关注连接线,因为它们是权重,是要训练得到的

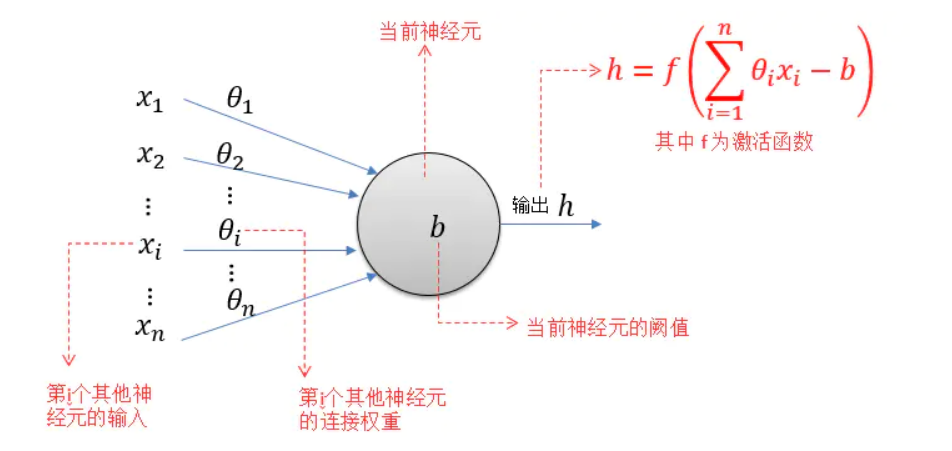

神经元

神经元模型是一个包含输入、输出、计算功能的模型,注意中间的箭头线,称之为“连接”,上面有“权值”

一个神经网络的训练算法就是让权重的值调整到最佳,以使得整个网络的预测效果最好。

MP神经元模型接收来自n个其他神经元传递过来的输入信号(x1~xn),这些输入信号通过带权重(θ或ω来表示权重,上图采用θ)的连接(Connection)进行传递,然后神经元(图示阈值为b)收到的总输入(所有输入和权重的乘积的和)与神经元的阈值b比较,并经由激活函数(Activation Function,又称响应函数)处理之后产生神经元的输出。

理想情况下,激活函数的形式应为阶跃函数(也就是修正线性单元ReLU),通常选择Sigmoid函数:

其值域为

神经元可以看做一个计算与存储单元,计算是神经元对其的输入进行计算,存储是神经元会暂存计算结果,传递到下一层。

多层神经网络

单层神经网络(感知机)在此处暂时忽略不写,期末要挂科了

上图展现了基本两层神经网络,其中

为了求最后的输出值

反向传播(BP算法)

给出一个示例,是我们的作业题目

(1)在该例子中什么是输入层,隐藏层,输出层,并对不同的层和层之间的权重矩阵进行维度标记。

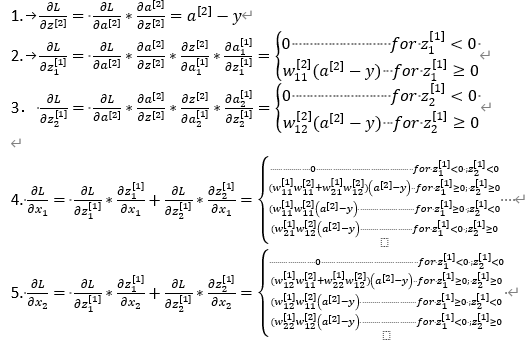

(2)使用链式法则,在损失函数L上,分别对

解

(1)

输入层:

输入层与隐藏层之间的权重矩阵:

经过加权求和与偏置后,得到:

经过ReLU激活函数后得到隐藏层:

隐藏层与输出层之间的权重矩阵:

经过加权求和与偏置后,得到:

经过sigmoid激活函数后得到输出层:

(2)

损失函数:

所有表达式:

阶段求导:

链式求导:

本文作者:诩言Wan

本文链接:https://www.cnblogs.com/wanyy-home/p/17973810

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY