搭建hadoop遇到的Q&A

-

运行jps命令没有namenode节点?

先停掉hadoop,删除tmp,重新建立tmp,赋予权限,再重新启动,就可以了

$sudo mkdir -p /app/hadoop/tmp $sudo chown hduser:hadoop /app/hadoop/tmp

-

打开secondarynamenode的网页什么都没有?

https://blog.csdn.net/newhandnew413/article/details/107311016

-

在浏览器输入50070,无法访问?

在阿里云实例那边,打开相应的端口

-

linux系统永久更改主机名?

[root@wanpi]$hostnamectl set-hostname master #master为想要更改的主机名 [root@master]$reboot #重启 [root@master]$

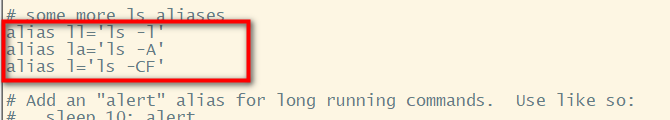

5.ll command not found 当ll 无法识别时解决办法

操作如下:(符号都是英文状态下的)

sudo vim ~/.bashrc #编辑文件

加入 alias ll='ls -l'

然后:esc

再按:“:wq !”

立即生效: source ~/.bashrc(这步一定不能要做!!!)

6.hadoop yarn 配好怎么不能访问 19888端口,8088端口可以

解决办法:

jhistoryserver 服务没有启动,

通过命令启动 mr-jobhistory-daemon.sh start historyserver

7.运行wordcount后无法在浏览器端下载part-r-00000

8.hadoop-mapreduce-examples-2.7.7.jar作用

在 MapReduce 组件里,官方给我们提供了一些样例程序,其中非常有名的就是 wordcount 和 pi 程序。这些 MapReduce 程序的代码都在 hadoop-mapreduce-examples-2.7.5.jar 包里

详细讲解:Hadoop2.6.0子项目hadoop-mapreduce-examples的简单介绍 - 泰山不老生 - 博客园 (cnblogs.com)(原文链接)

9.删除HDFS文件系统中的文件

hadoop@master:/usr/local/hadoop/bin$ hdfs dfs -rm -r /out02

hadoop@master:/usr/local/hadoop/bin$ hdfs dfs -rm -r /qqout3

10.修改map和reduce个数

mapper数量的修改: hdfs-site.xml 添加(64m,128m,256m)

<property>

<name>dfs.block.size</name>

<value>256m</alue>

</property>

<property>

<name>dfs.namenode.fs-limits.min-block-size</name>

<value>256m</alue>

</property>

reducer数量的修改:

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.9.2.jar wordcount -D mapred.reducer.tasks=2 /data/input/yelp* /data/out/yelp_data_count

11.运行wordcount时出现内存不够

在yarn-site.xml中加入

<property> <name>yarn.nodemanager.resource.memory-mb</name> <value>2048</value> </property>

浙公网安备 33010602011771号

浙公网安备 33010602011771号