CS231n 2016 通关 第六章 Training NN Part2

本章节讲解 参数更新 dropout

=========================================================================================

上节内容回顾与总结:

模型过程:

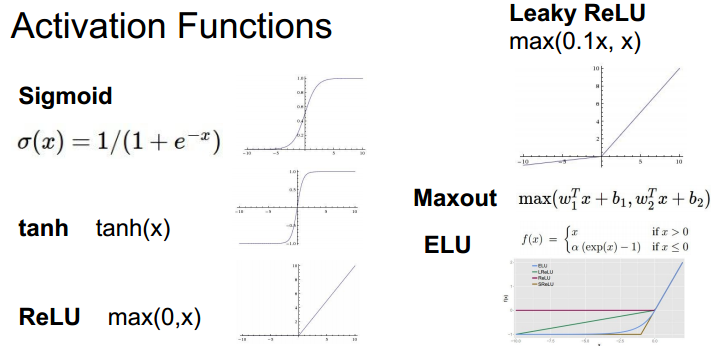

激活函数:注意理解各个函数的优缺点

数据预处理:

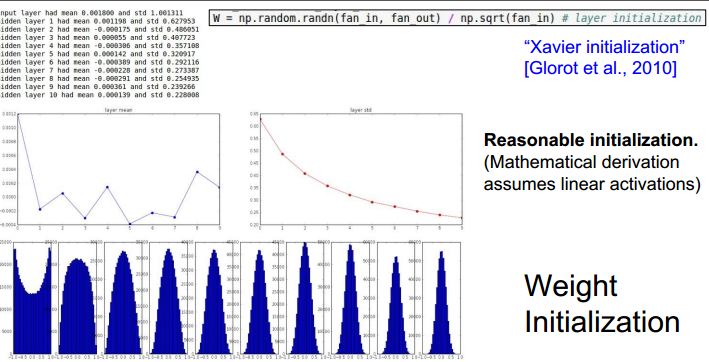

权重参数初始化:Xavier方法,使用较多。

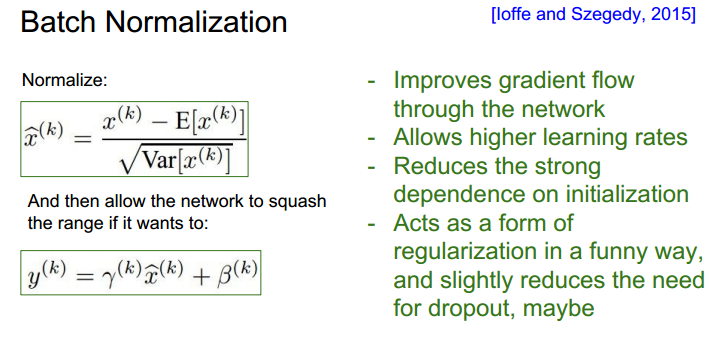

batch normalization :

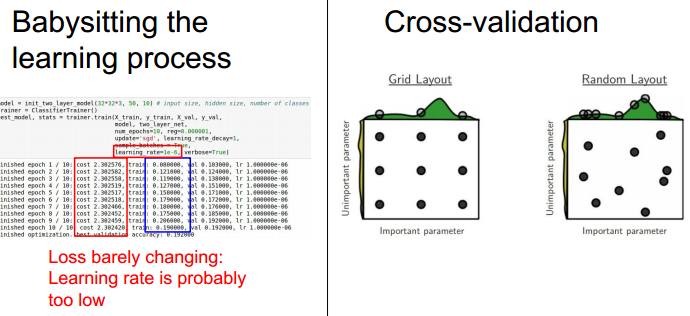

cross validation :比较loss 结果,选择合适学习率

=========================================================================================

本章知识点:

=========================================================================================

Parameter Update :

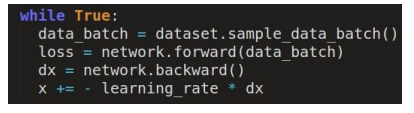

训练NN的代码结构:

最后一行即为参数更新。

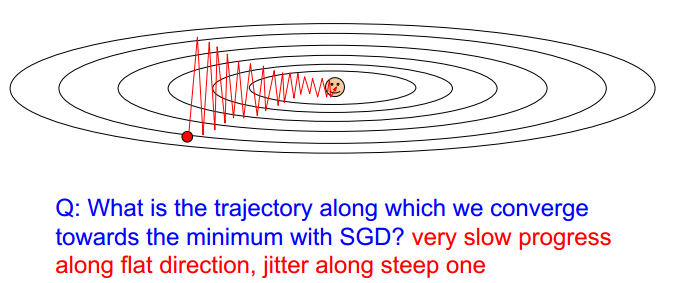

sgd的轨迹:

因为minibatch的原因,在波动中收敛。

Momentum update

加入了动量,加速收敛。

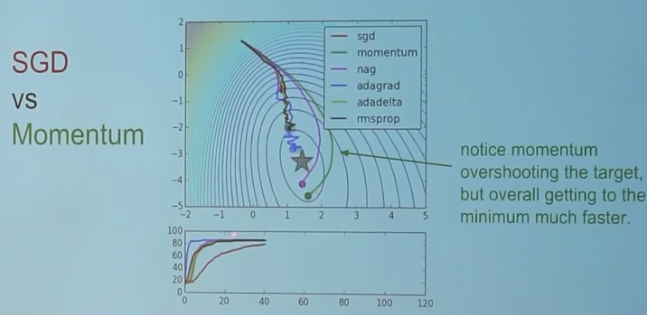

SGD vs Momentum

Momentum 直观解释:

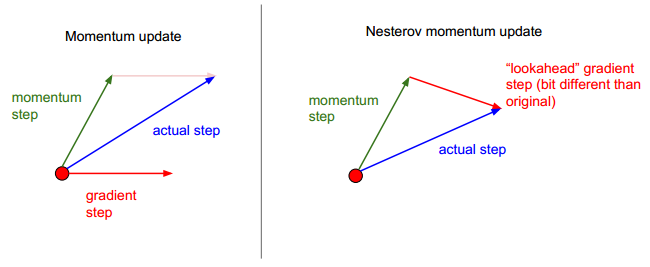

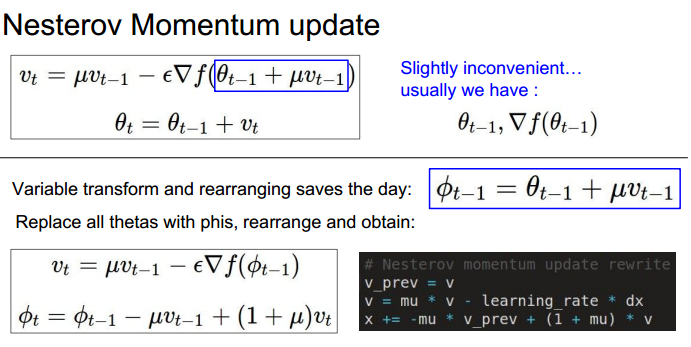

Nesterov Momentum :

更新公式比较:

AdaGrad update : 前两种是在更新方式上的算法,接着总结学习率更新的算法

自适应梯度,根据误差项来调整学习率。

显然,在误差较大时学习率低,当误差减小时,学习率升高。

RMSProp update :

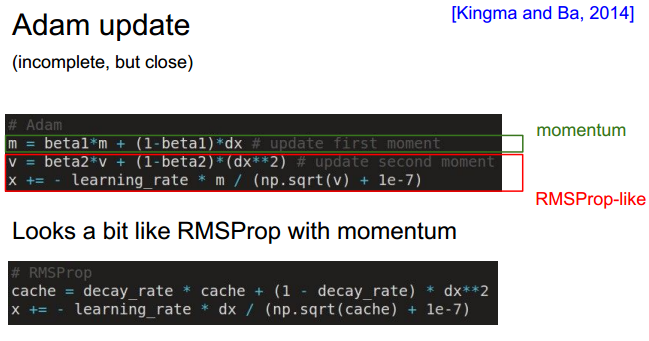

Adam update :

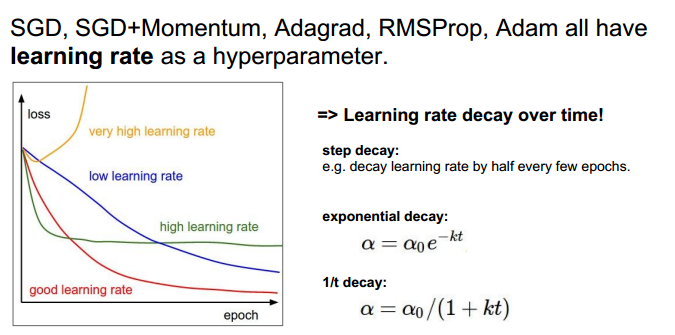

Learning rate :

可以使用开始时较大的学习率,之后逐步衰减的方法。

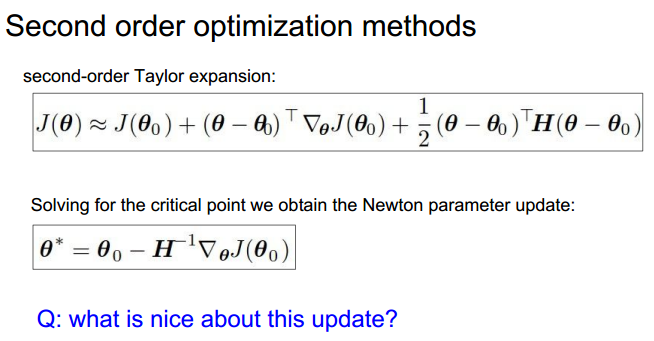

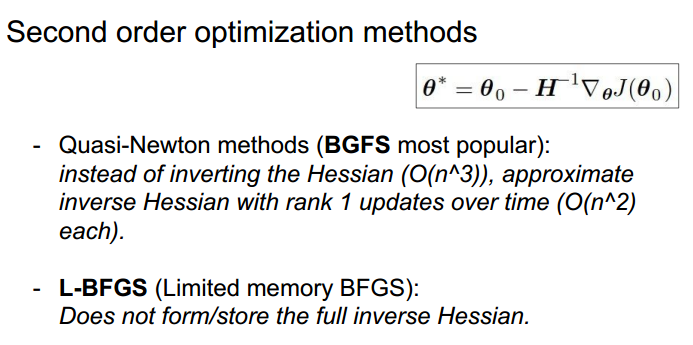

第二种优化方法:

损失函数泰勒展开:

这种方法,不需要超参数,学习率等。但是不实用,因为需要计算H-1,即海森矩阵。其比较庞大。

拟牛顿法:

实际应用:

=========================================================================================

model ensemble :在测试的时候,使用多个模型,对结果做平均值。

一些技巧:

=========================================================================================

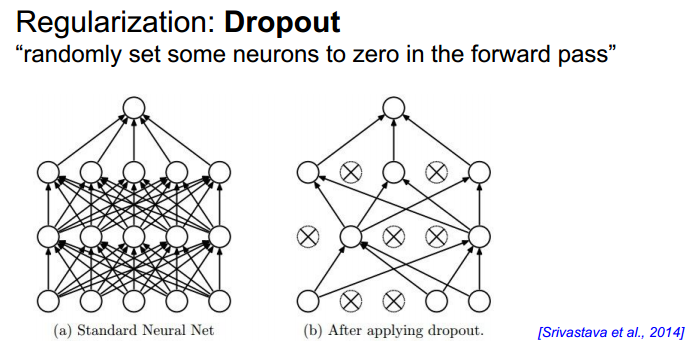

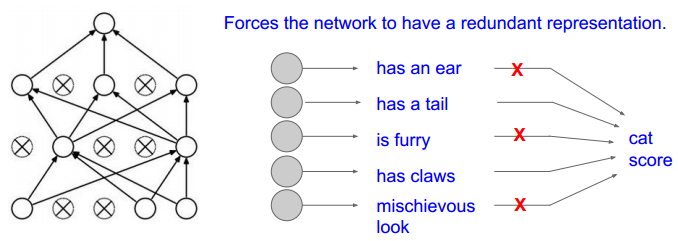

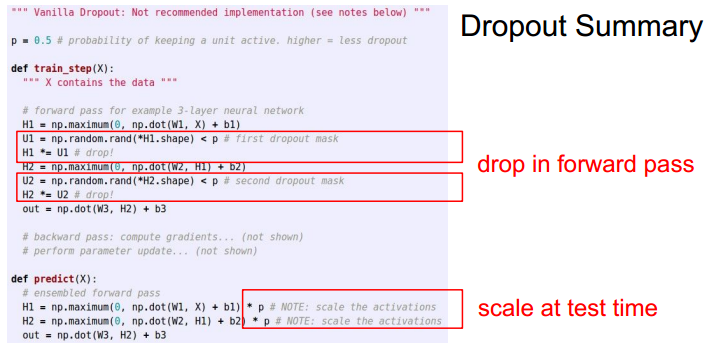

Dropout :

示意图:

代码结构:

模型实例:

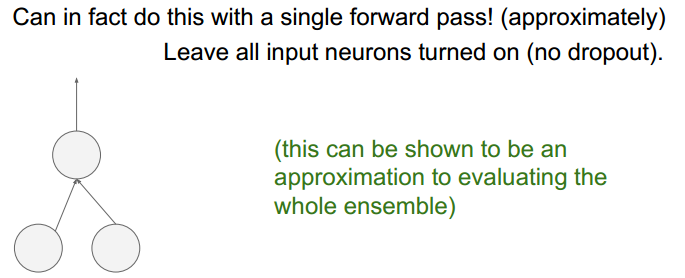

测试阶段:没有dropout

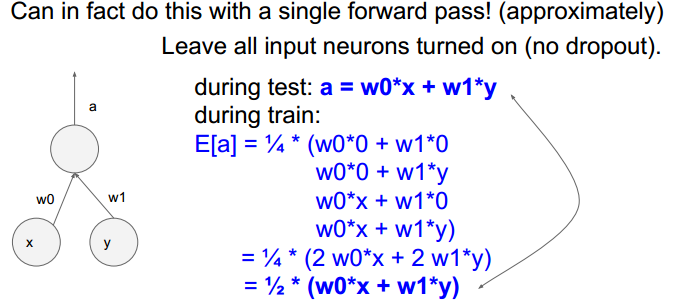

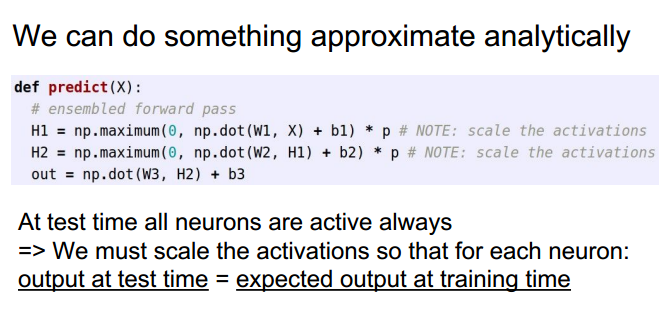

在training 阶段做出一些调整:

修改后:

两种方式:

=========================================================================================

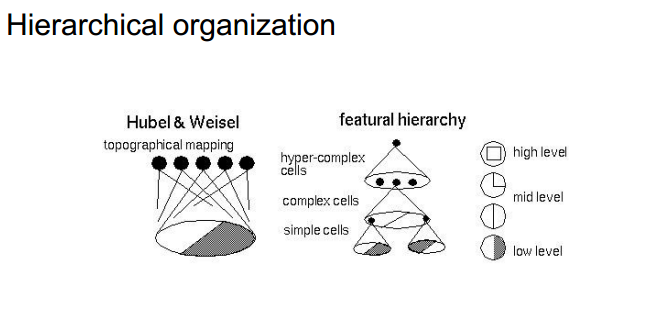

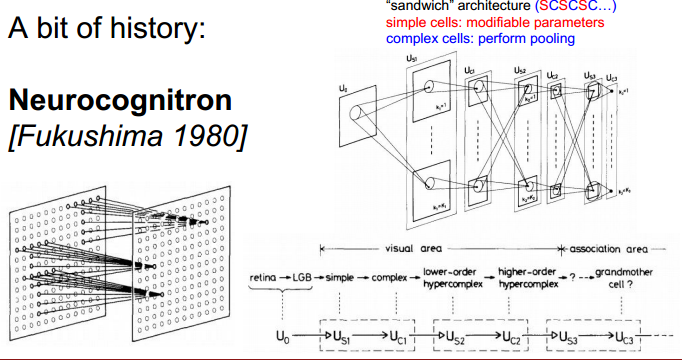

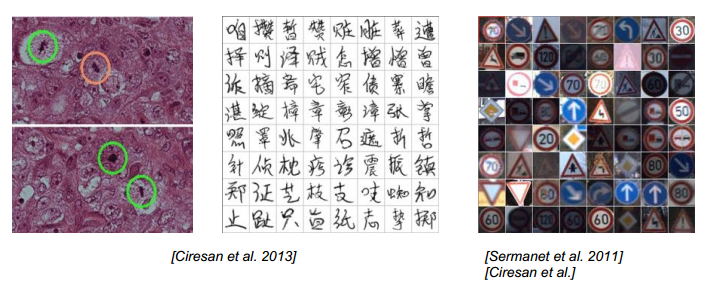

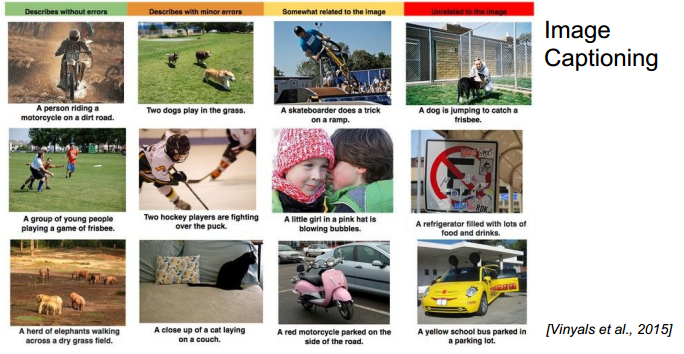

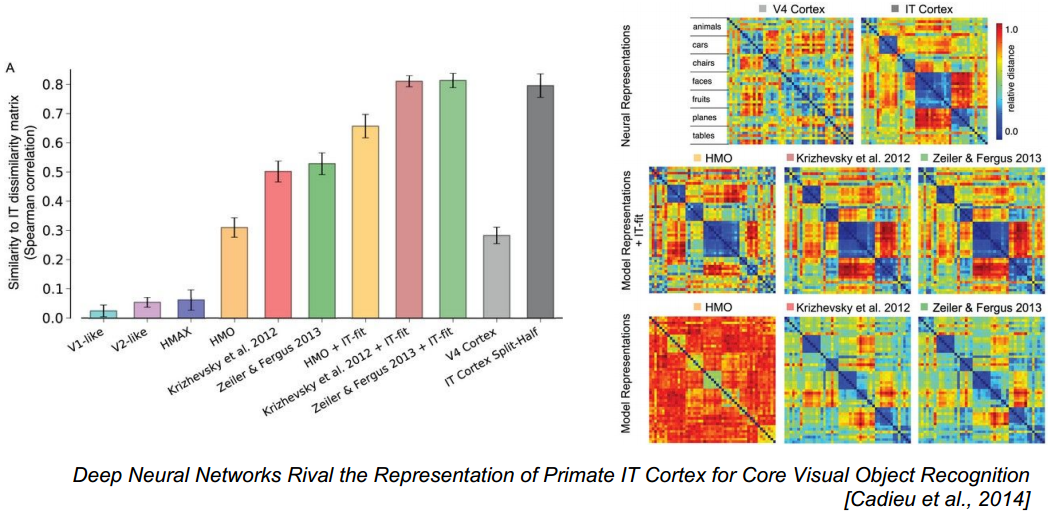

CNN 发展过程

视觉系统是由简单结构到复杂结构,信号的抽象过程。

拟生视觉网络。

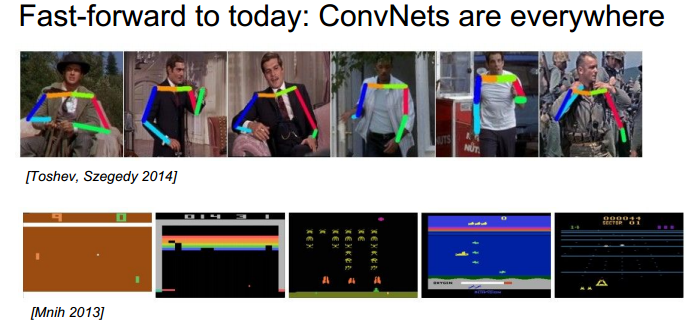

现阶段:分类、复原、识别应用广。

附:通关CS231n企鹅群:578975100 validation:DL-CS231n

浙公网安备 33010602011771号

浙公网安备 33010602011771号