Align before Fuse: Vision and Language Representation Learning with Momentum Distillation

Align before Fuse: Vision and Language Representation Learning with Momentum Distillation

2022-03-18 10:04:06

Paper: https://proceedings.neurips.cc/paper/2021/file/505259756244493872b7709a8a01b536-Paper.pdf

Code: https://github.com/salesforce/ALBEF

1. Background and Motivation:

大部分现有的 VLP 方法依赖于预训练的物体检测器,进行 region based 图像特征提取,采用多模态编码器将 image feature 和 word tokens 进行融合。多模态编码器被训练用于理解图像和文本,例如 masked language modeling, image-text matching。虽然这种方式很有效,但是作者仍然总结了如下几个不足:

(1)图像特征和文本符号映射仍然停留在他们自己的空间,使得多模态编码器很难学习建模他们之间的交互;

(2)物体检测器 --- 标注费钱,使用费算力 --- 在预训练阶段需要标注矩形框,在推理阶段高分辨率图像,如 600*1000,速度较慢;

(3)广泛使用的 image-text 数据集均是从网上搜集的带有严重噪声的数据,现有的预训练目标,如 MLM 可能过拟合到文本数据,降低了模型的泛化性能。

因此,作者提出了 ALBEF 以尝试解决上述问题。作者首先用一个 detector-free 的方式分别对 image 和 text 进行编码。然后,利用一个多模态编码器来融合图像特征。引入了一个中间的 image-text contrastive (ITC) 损失,该损失函数可以达到如下三个效果:

1). 其将 image 和 text 特征进行了对齐,使其更加易于多模态编码器进行跨模态学习;

2). 其改善了单个编码器以更好地理解图像和文本的语义意义;

3). 学习了一个公共的低纬度空间以映射 image 和 text,使得 image-text matching objective 可以通过对比困难负样本挖掘找到更多有信息的样本。

为了改善在噪声环境下的学习问题,本文引入了 Momentum Distillation (MoD),一个简单的方法就可以使得模型引入较大的网络数据集。在训练过程中,作者模型的一个动量版本,然后利用这个动量模型来产生 pseudo-targets 作为额外的监督。有了 MoD, 该模型就不会因为产生了其他合理的输出,且该输出不同于 web annotations 而受到惩罚。实验表明,MoD 不仅改善了 pre-training,也对下游任务有较好的提升。

2. ALBEF Pre-training:

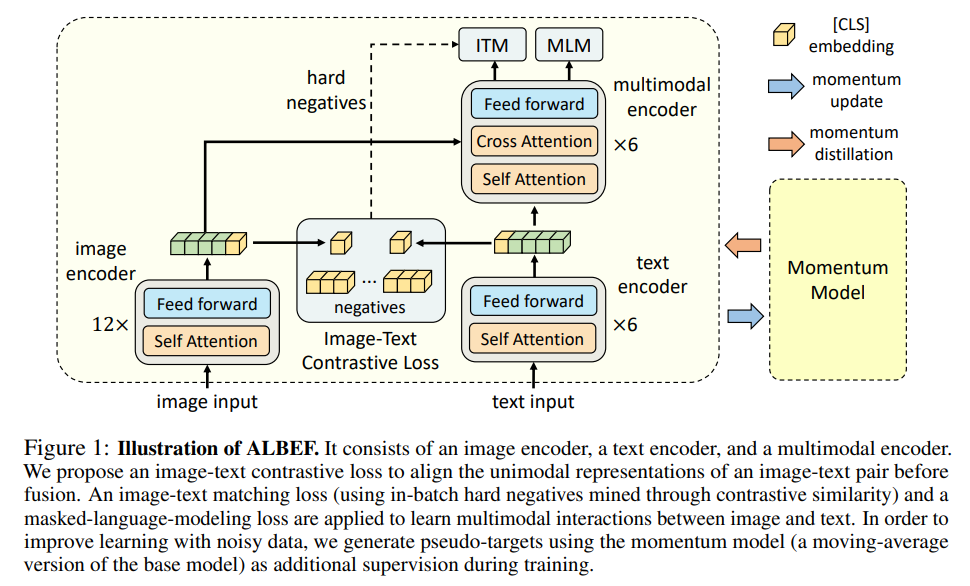

如图 1 所示,ALBEF 的视觉编码器是 ViT-B/16,作者也加载了 ImageNet 上预训练的权重作为初始化值。BERT-based 模型被选择作为 text encoder,也是利用预训练权重进行初始化。网络结构上大致就是这样。

关于预训练目标,作者这里用到了三个:

1. image-text contrastive learning;

2. Masked language modelling;

3. Image-text matching。

完整的预训练目标就是这三者损失的加和。

本文的另外一个贡献是 Momentum Distillation:

对于 ITC learning,一张图像的 negative text 可能也会匹配上图像的内容;

对于 MLM,可能存在其他的单词不同于 annotation,但是依然很好地描述了图像中的内容。然而,ITC 和 MLM 的 one-hot labels 惩罚了所有的 negative prediction,却没有考虑到其正确性。

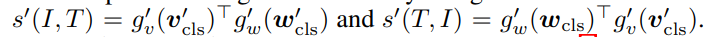

为了解决上述问题,作者提出使用动量模型的方法,从伪真值上进行学习。动量模型时一种连续进化的教师,包含了 单模态和多模态编码器的指数级移动平均版本。特别的,对于 ITC 来说,作者首先利用动量单模态编码器来计算 image-text 的相似性;

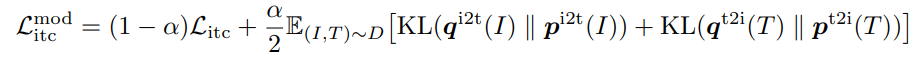

然后通过替换操作,计算 soft pseudo-targets 。ITC-MoD loss 可以定义如下:

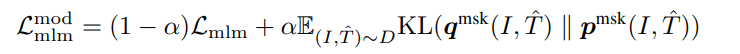

类似的,对 MLM loss 也可以加上这个约束:

==

浙公网安备 33010602011771号

浙公网安备 33010602011771号