Time Lens: Event-based Video Frame Interpolation

Time Lens: Event-based Video Frame Interpolation

2021-06-21 19:40:23

Project: http://rpg.ifi.uzh.ch/TimeLens.html

Code: https://github.com/uzh-rpg/rpg_timelens

1. Background and Motivation:

视频帧的插值有众多应用场景,主要是针对一般帧率的视频(30-50 FPS 左右),将其帧率可以提升到任意的 FPS,比如 500 FPS, 1K FPS 等。作者对基于视频的插帧方法进行了回顾:

1. Warping-based approach 利用光流估计和图像扭曲来生成两个关键帧之间的视频帧。并且有一个假设:运动是线性的,连续帧之间亮度保持一致。

2. Kernel-based approaches 将视频插帧看做是一个 local convolution 的过程,其卷积核来源于 key frames。

3. Phase-based approaches 将VFI 看做是一个 phase shift estimation problem,其中神经网络解码器直接预测中间帧的阶段分解。

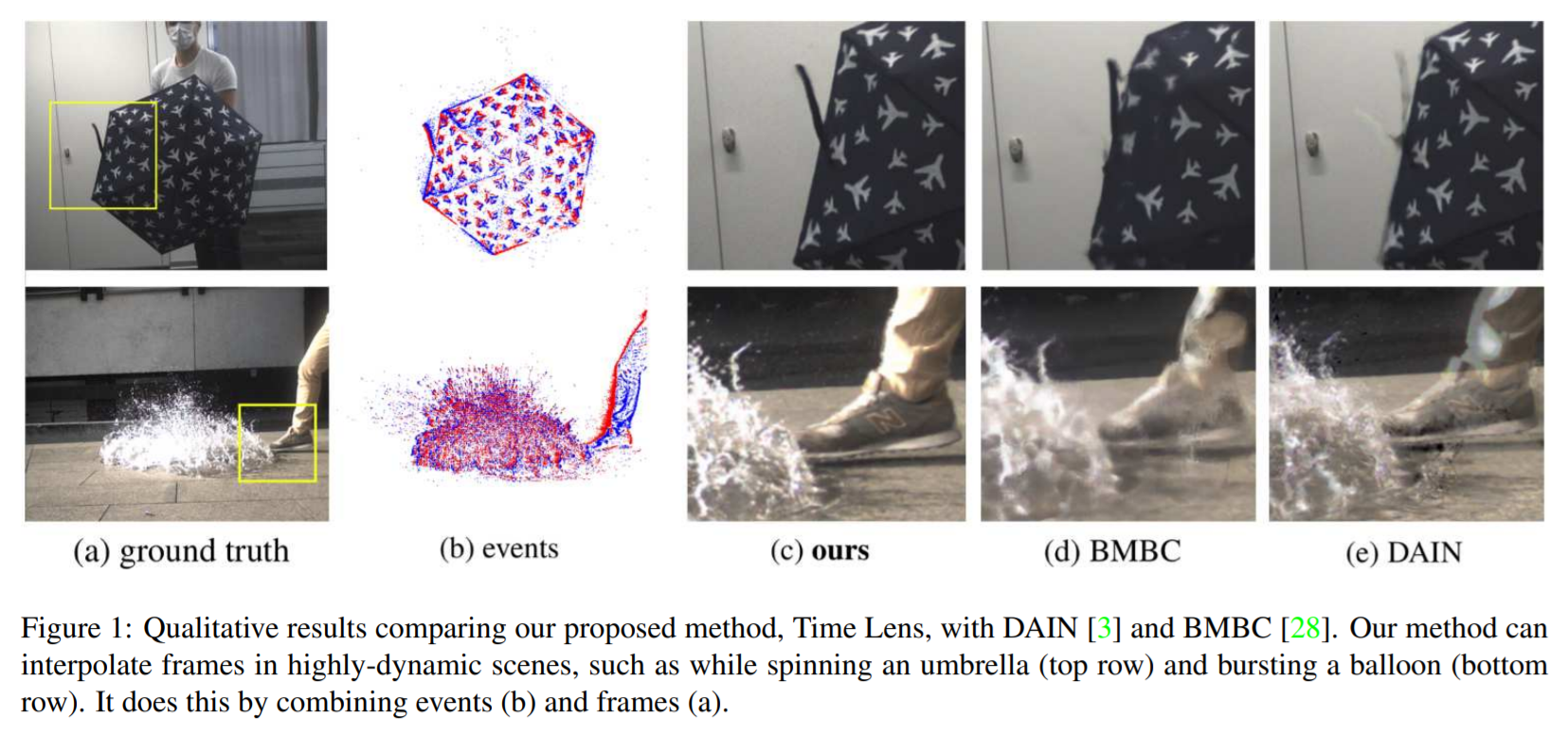

总体来说,所有基于 video frame 的方法均假设了简化的运动模型,即,线性运动。因为视频帧之间的时间,并没有可用的视觉信息。这就是基于 frame 方法的核心缺陷,此外,这种假设还基于亮度和改变保持一致的前提下,这样就极大的限制了其他高动态场景下的应用:

1. non-linear motions between the input keyframes,

2. changes in illuminations or motion blur;

3. non-rigid motions and new objects appearing in the scene between keyframes.

Multi-Camera Approaches:

Event-based Approaches:

2. 本文方法:

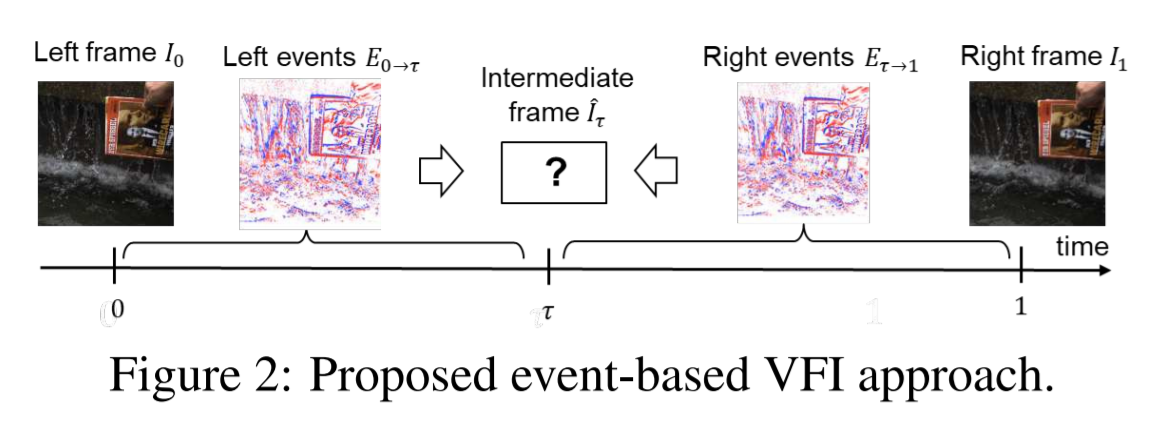

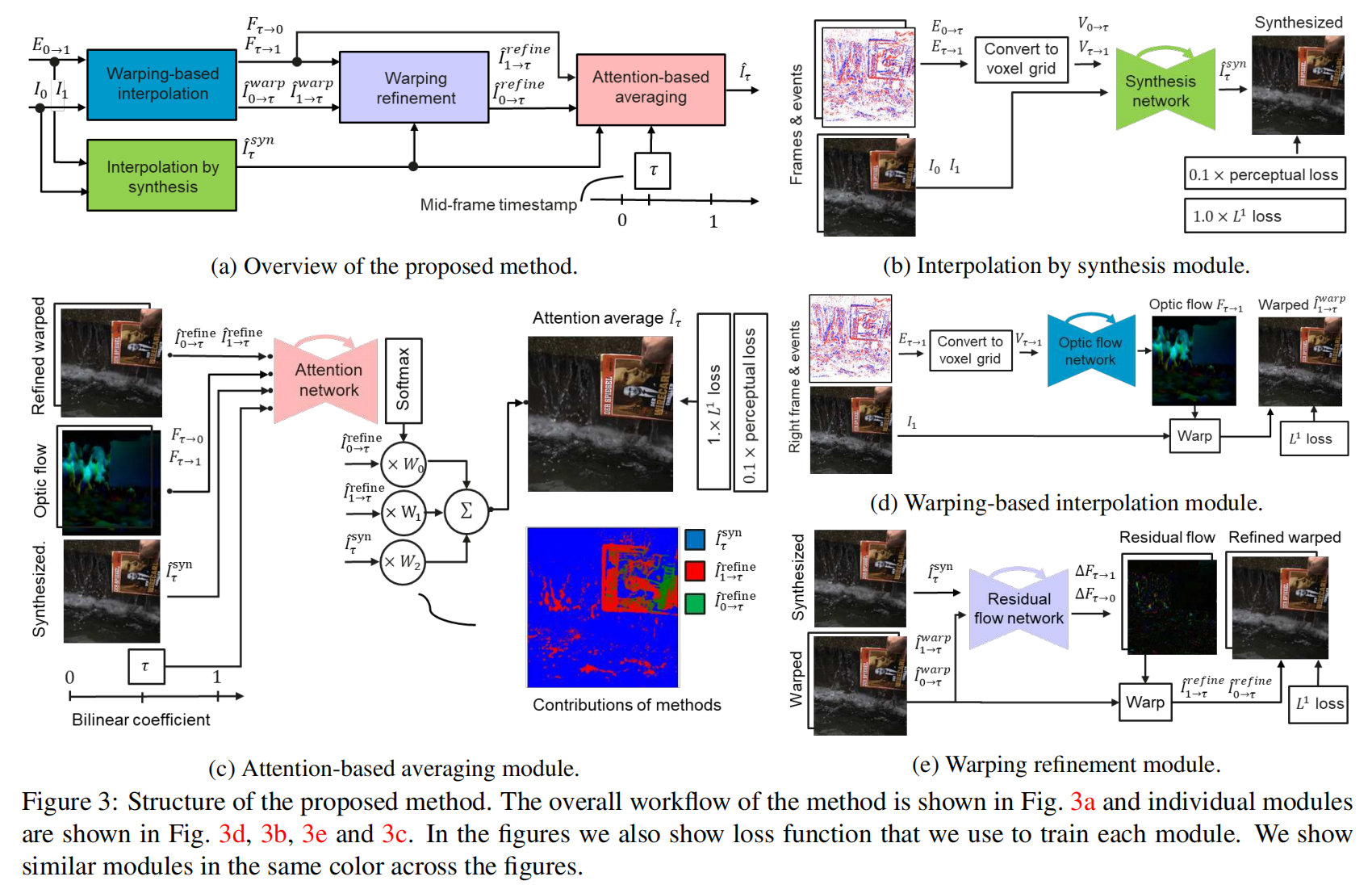

如上图所示,本文所提出的任务设定,尝试在两帧之间,使用两组 event flow,来预测中间的 frame。本文提出一种 warping-based 和 synthesis-based interpolation 相结合的思路,具体的:

1. the warping-based interpolation module 预测一个新的视频帧,通过利用event flow 预测得到的光流,进行 RGB keyframe 的边界扭曲;

2. the warping refinement module 目的是改善该预测;

3. 通过仿真模块得到的插值,预测一组新的视频帧,直接融合边界 keyframe 和 event sequences 的输入信息;

4. 基于 attention 的平均化模块,有好的组合 warping-based 以及 synthesis-based results。

这样的话,经过上述步骤就可以充分挖掘 warping- 和 synthesis-based 插帧方法的优势。算法的大致流程如下图所示:

3. 所提的数据集:

上图是本文数据集所用的摄像头组合,RGB 相机和 Event 相机,均为高分辨率的相机。

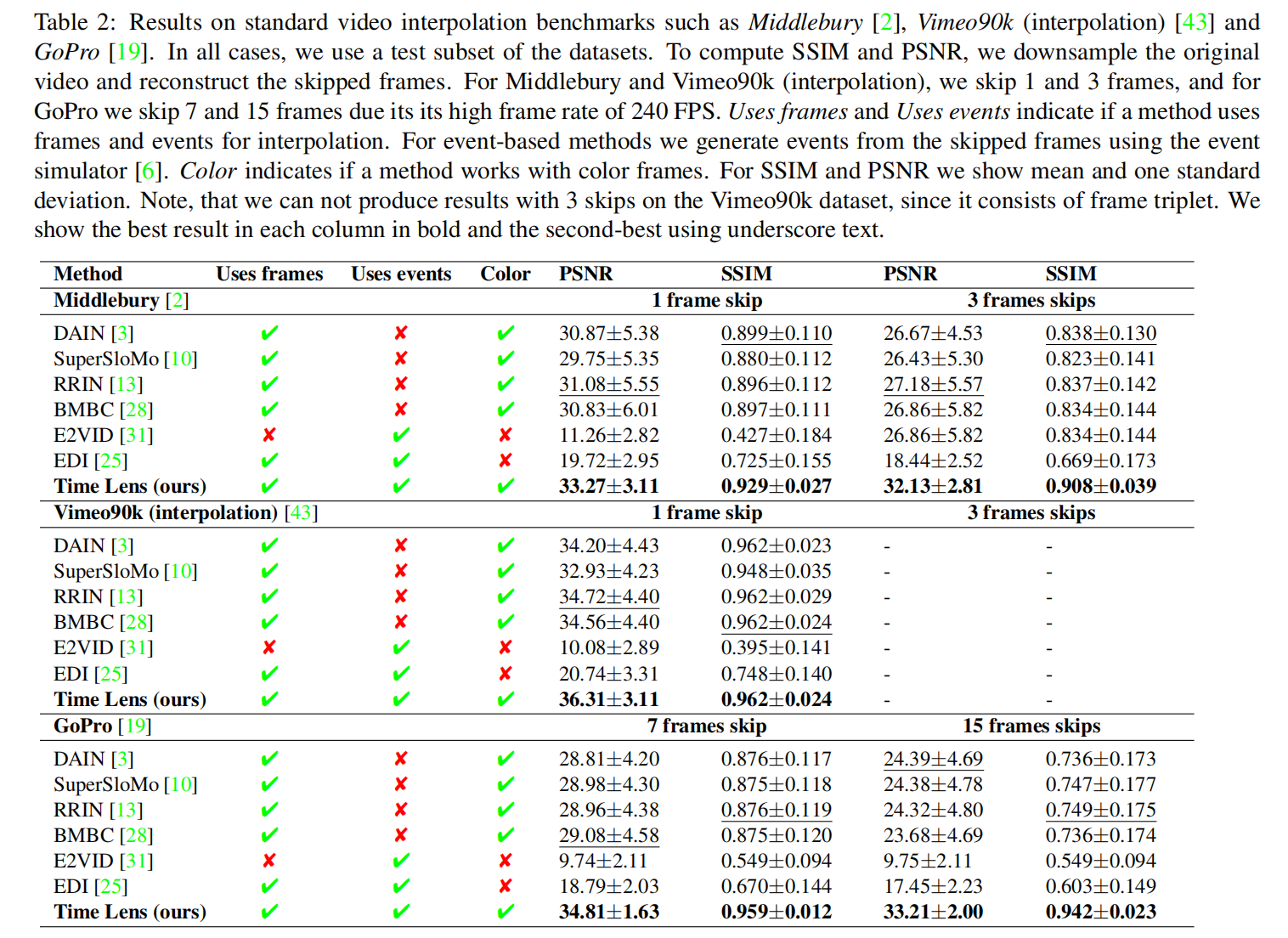

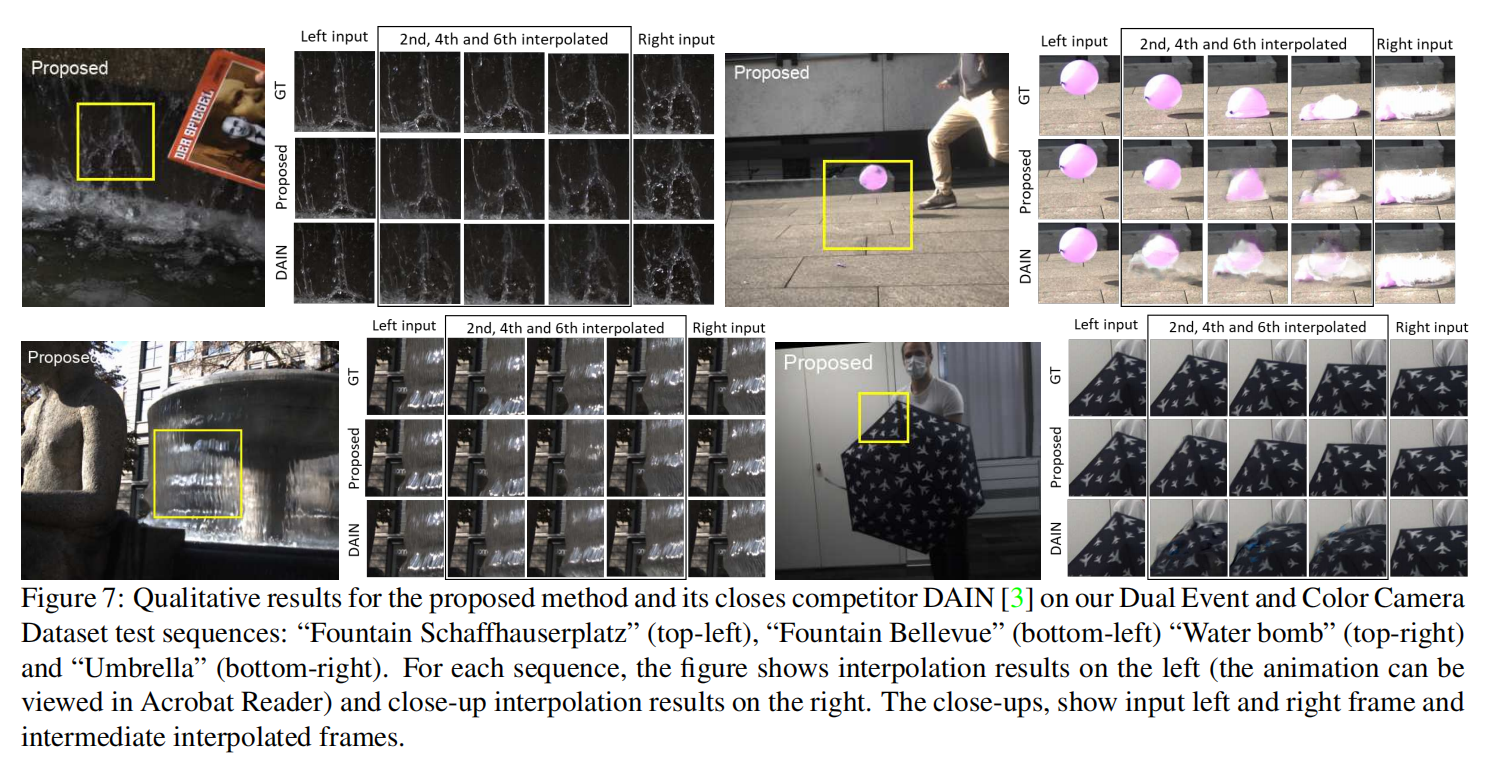

4. Experiments:

浙公网安备 33010602011771号

浙公网安备 33010602011771号