再谈spark部署搭建和企业级项目接轨的入门经验(博主推荐)

进入我这篇博客的博友们,相信你们具备有一定的spark学习基础和实践了。

先给大家来梳理下。spark的运行模式和常用的standalone、yarn部署。这里不多赘述,自行点击去扩展。

2、Spark standalone模式的安装(spark-1.6.1-bin-hadoop2.6.tgz)(master、slave1和slave2)

3、Spark standalone简介与运行wordcount(master、slave1和slave2)

4、Spark on YARN模式的安装(spark-1.6.1-bin-hadoop2.6.tgz + hadoop-2.6.0.tar.gz)(master、slave1和slave2)(博主推荐)

5、Spark on YARN简介与运行wordcount(master、slave1和slave2)(博主推荐)

正文开始

想说的是,对于spark的配置文件,即spark-env.sh。压根可以不做任何修改和配置。(当然我指的是常用和固定的那些参数)

#!/bin/sh

home=$(cd `dirname $0`; cd ..; pwd)

bin_home=$home/bin

conf_home=$home/conf

logs_home=$home/logs

data_home=$home/data

lib_home=$home/lib

#服务器配置文件

configFile=${conf_home}/my1.properties

spark_submit=/home/hadoop/spark/bin/spark-submit

#!/bin/sh

deleteCheckpoint=$1

home=$(cd `dirname $0`; cd ..; pwd)

. ${home}/bin/common.sh

hdfs dfs -rm -r /spark-streaming/behavior/stop

if [ "$deleteCheckpoint" == "delck" ]; then

hdfs dfs -rm -r /spark-streaming/checkpoint/behavior

fi

${spark_submit} \

--master yarn \

--deploy-mode cluster \

--name behavior \

--driver-memory 512M \

--executor-memory 512M \

--class com.djt.spark.streaming.UserBehaviorStreaming \

${lib_home}/behavior-stream-jar-with-dependencies.jar ${configFile} \

>> ${logs_home}/behavior.log 2>&1 &

echo $! > ${logs_home}/behavior_stream.pid

#!/bin/sh

home=$(cd `dirname $0`; cd ..; pwd)

. ${home}/bin/common.sh

hdfs dfs -mkdir -p /spark-streaming/behavior/stop

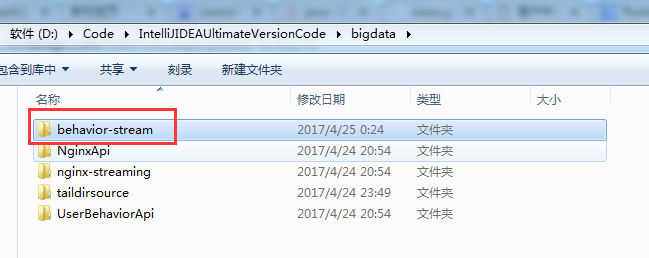

然后,直接将这个本地写好的目录,上传到集群

后续很简单,不多说。

藏经阁技术资料分享群二维码

分类:

spark

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律