逻辑回归算法

逻辑回归算法

逻辑回归算法原理

逻辑回归做的是分类的任务。应用非常广。原理上简单,实践上方便。

支持向量机(SVM),神经网络,都可以做分类任务,但逻辑回归依然经典🐮×。

机器学习中不是算法越复杂越好,简单暴力高效才是王道。

当我们面对一个项目时,通常先做一个basemodel。就是先用逻辑回归这样的简单算法,看看效果,再改进算法或换其他算法能不能效果更好。如果差不多,那么直接用逻辑回归就好了。

因此,机器学习中的分类算法,首选就是逻辑回归。这就是为什么它厉害的原因。

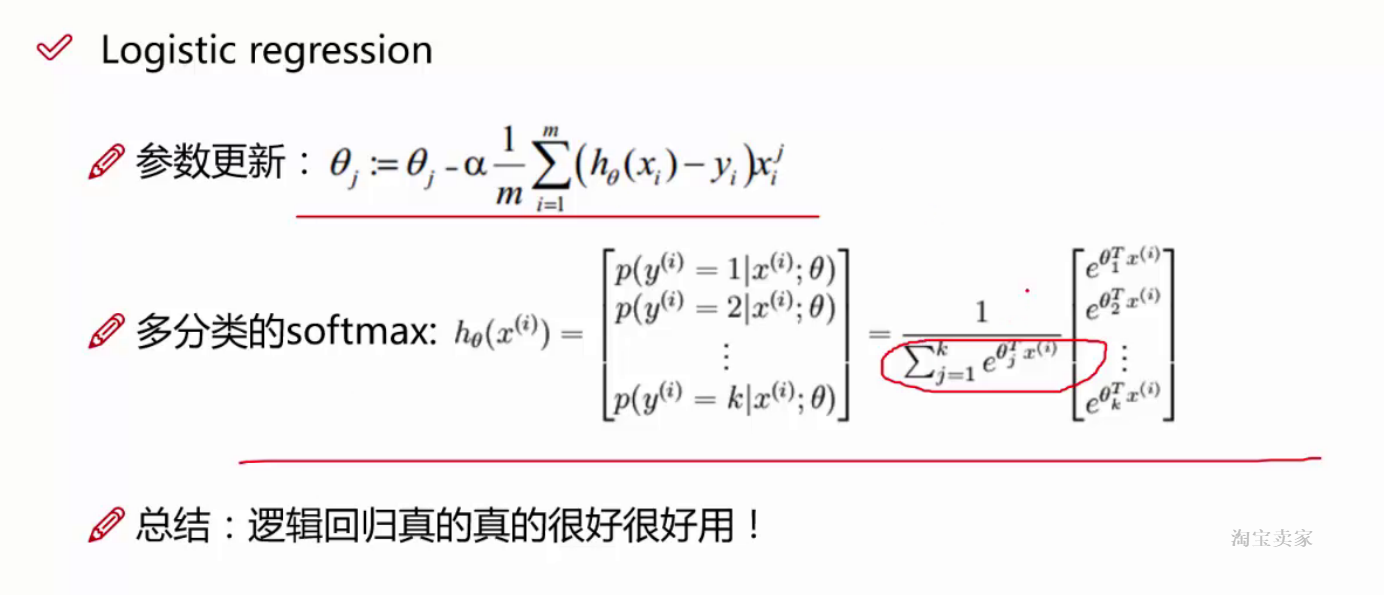

虽说它是经典二分类算法,但是也是可以解决多分类问题的。这时要叫softmax分类器。原理是一样的。

越简单的算法,越好解释最终得出的参数,越好进行可视化展示。

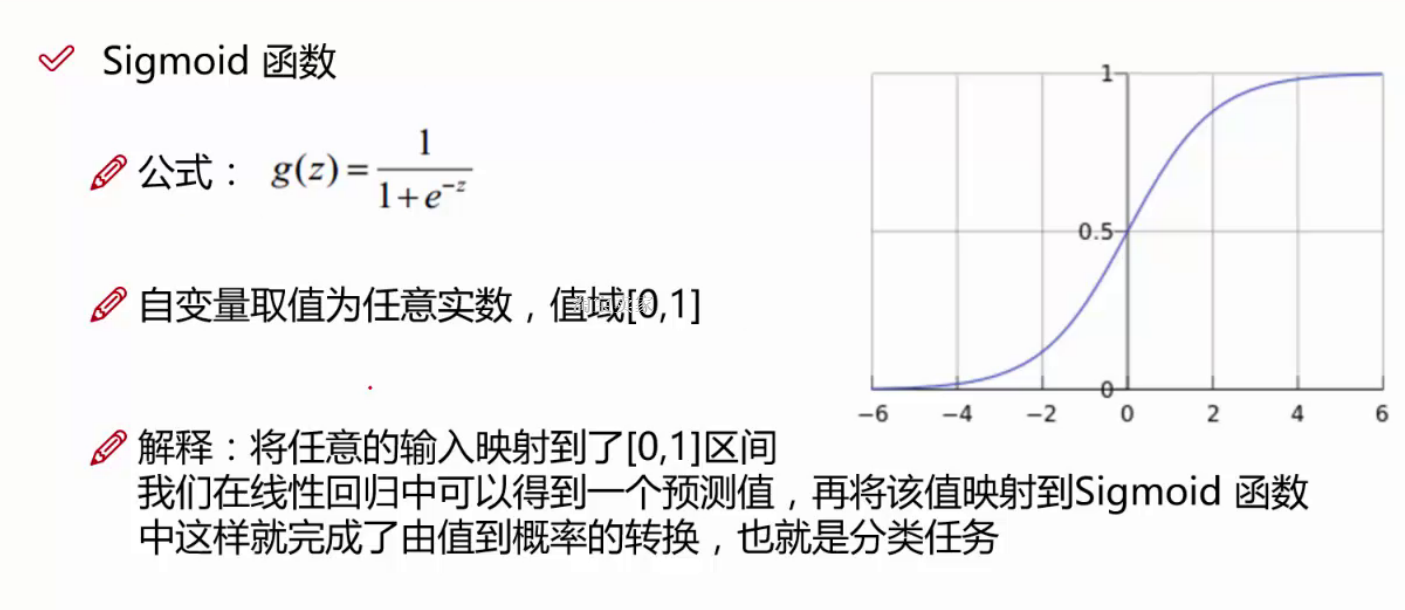

上图就是sigmoid函数。

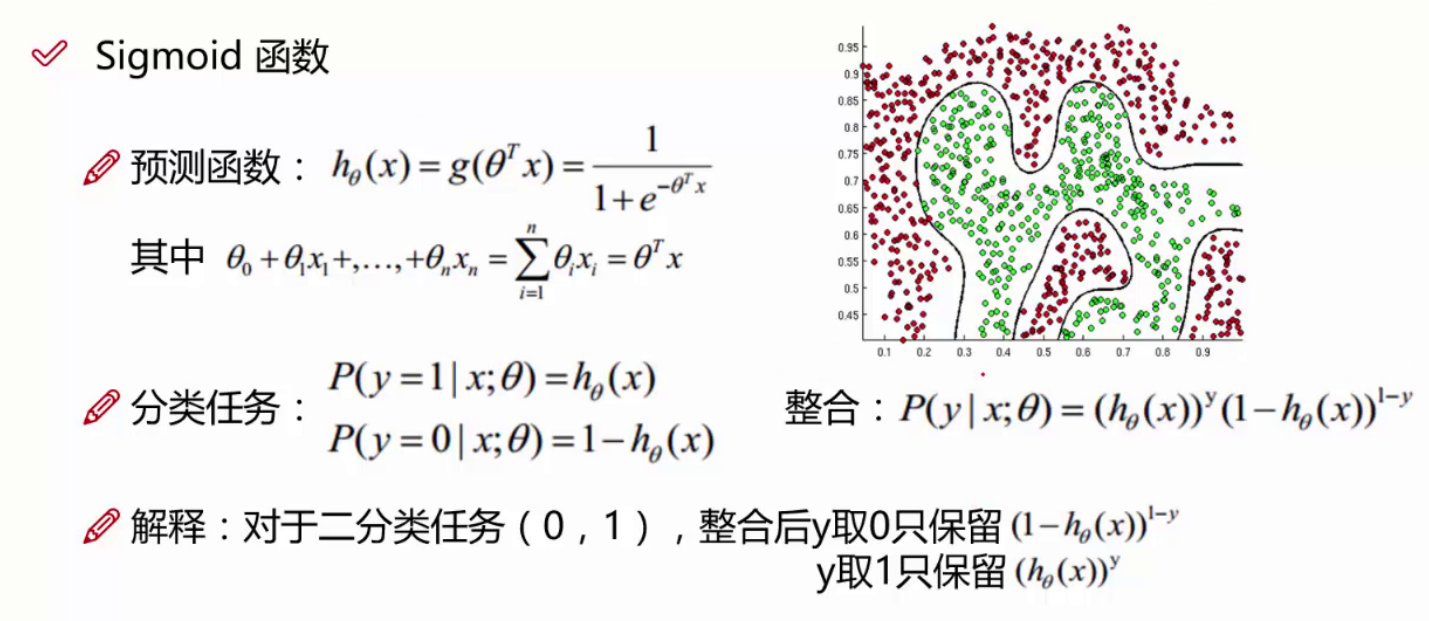

z表示线性回归的输入,sitar*X的结果,带入sigmoid后实现分值转概率。

逻辑回归求解

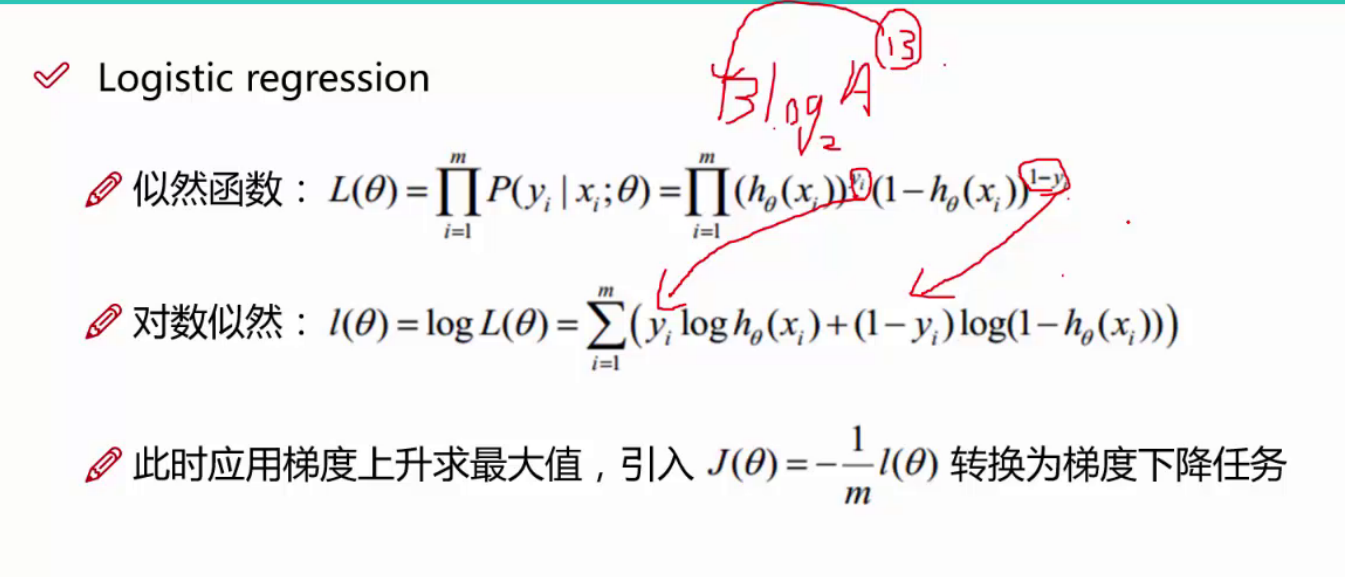

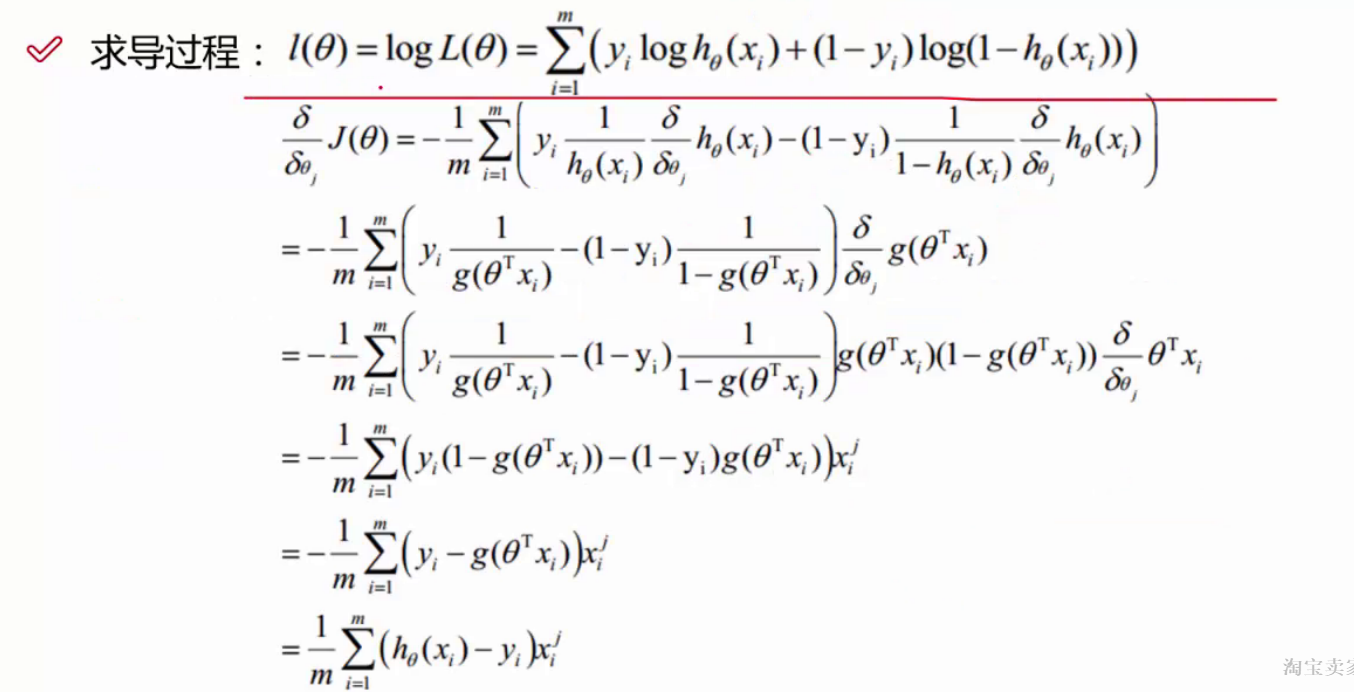

一般要把梯度上升问题转换为梯度下降问题。

一般有几个sitar就要对几个sitar求偏导。

xji 表示:第i个样本,在j特征方向的导数。

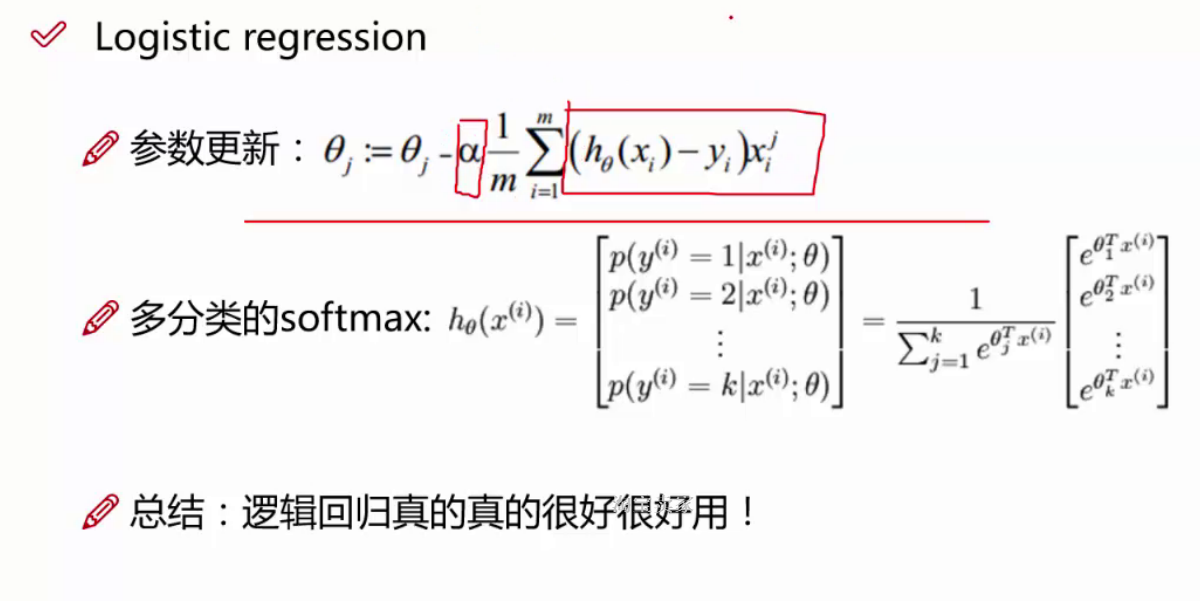

上图两个红框左侧是更新步长(学习率,更新率),右侧是更新方向。

红框中间表示,用minibatch来做。

红框前面的减号是因为用梯度下降来做的。

用于多分类,红框表示做归一化。

算法原理很简单。但是特别实用。

和线性回归比,就是把结果带入了sigmoid函数中,得到概率值。是线性回归的升级版。