梯度下降算法

梯度下降算法

梯度下降原理

在线性回归算法求解中提到,sitar不一定可以求解。现在来尝试另外一种解法:梯度下降!

核心在于如何优化。

通常需要 优化迭代 1万次,10万次。

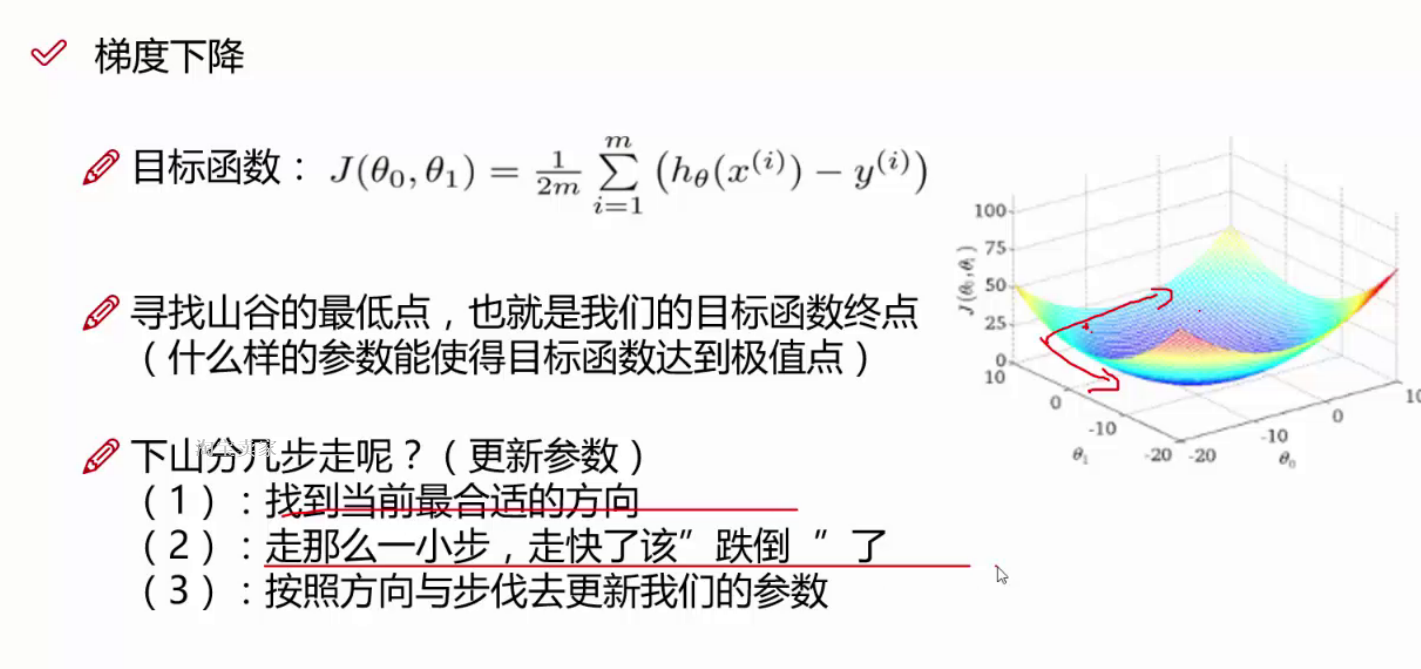

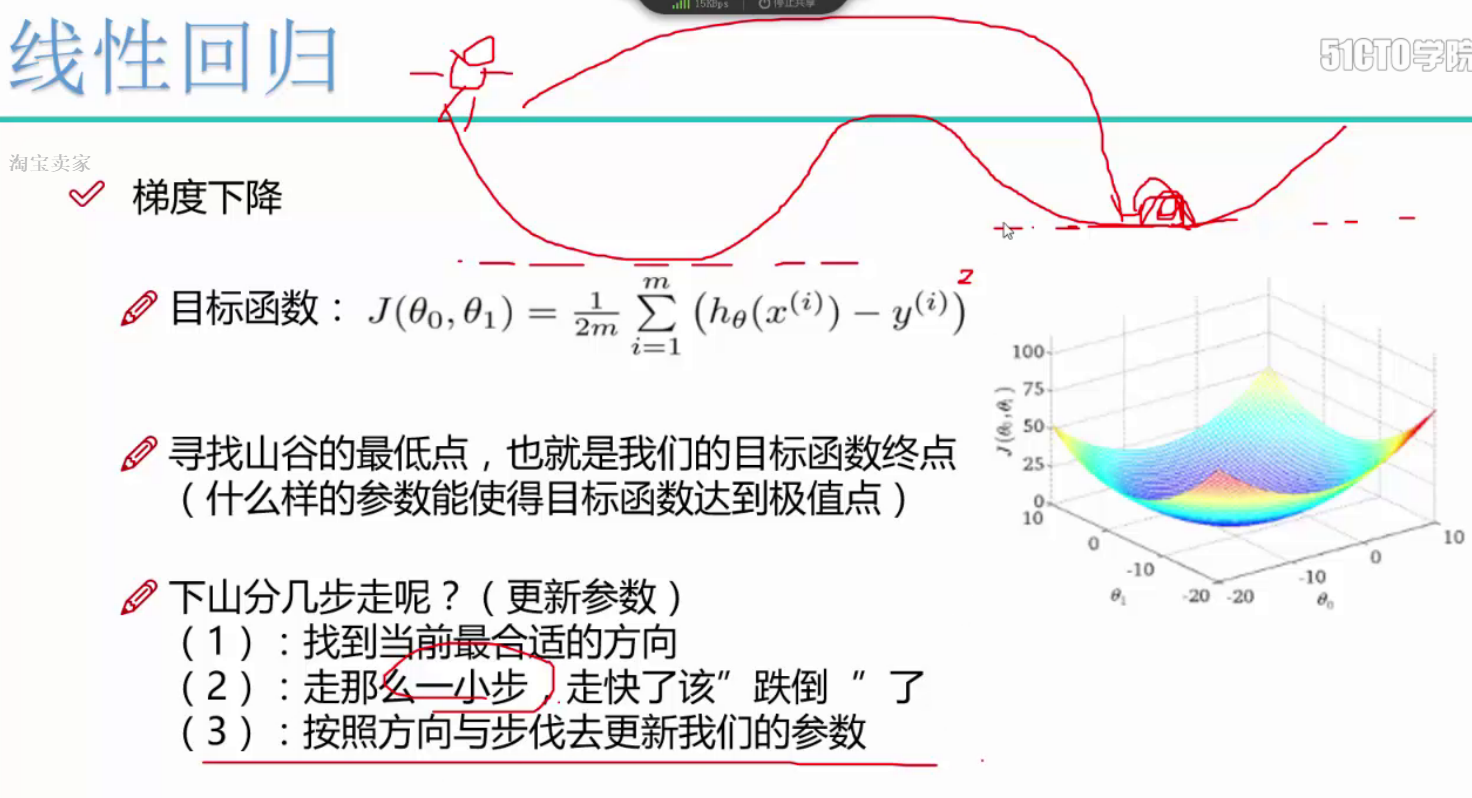

优化时要在不同方向进行。这就需要在各自方向求偏导,各自更新。

一句话:沿着目标函数下降的方向去走。

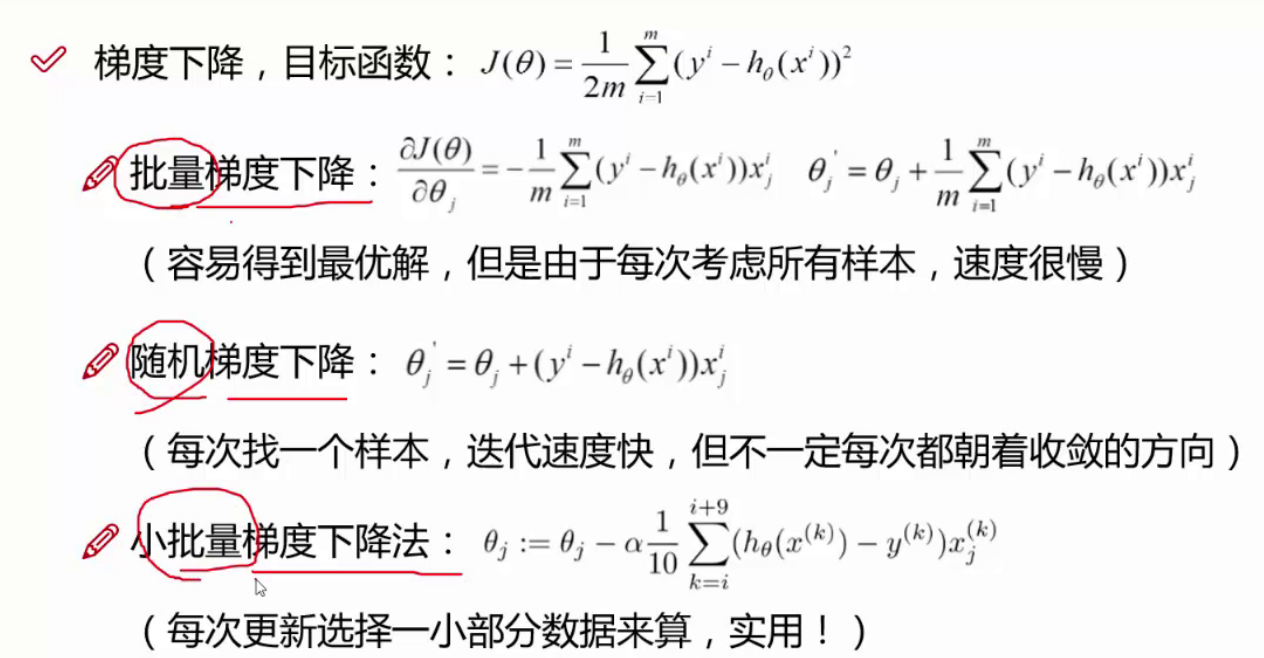

梯度下降方法对比

批量梯度下降精度高,速度慢。

随机梯度下降迭代速度快,但会受不纯净数据的干扰(噪音点,离群点,异常点)。

小批量梯度下降,最实用。

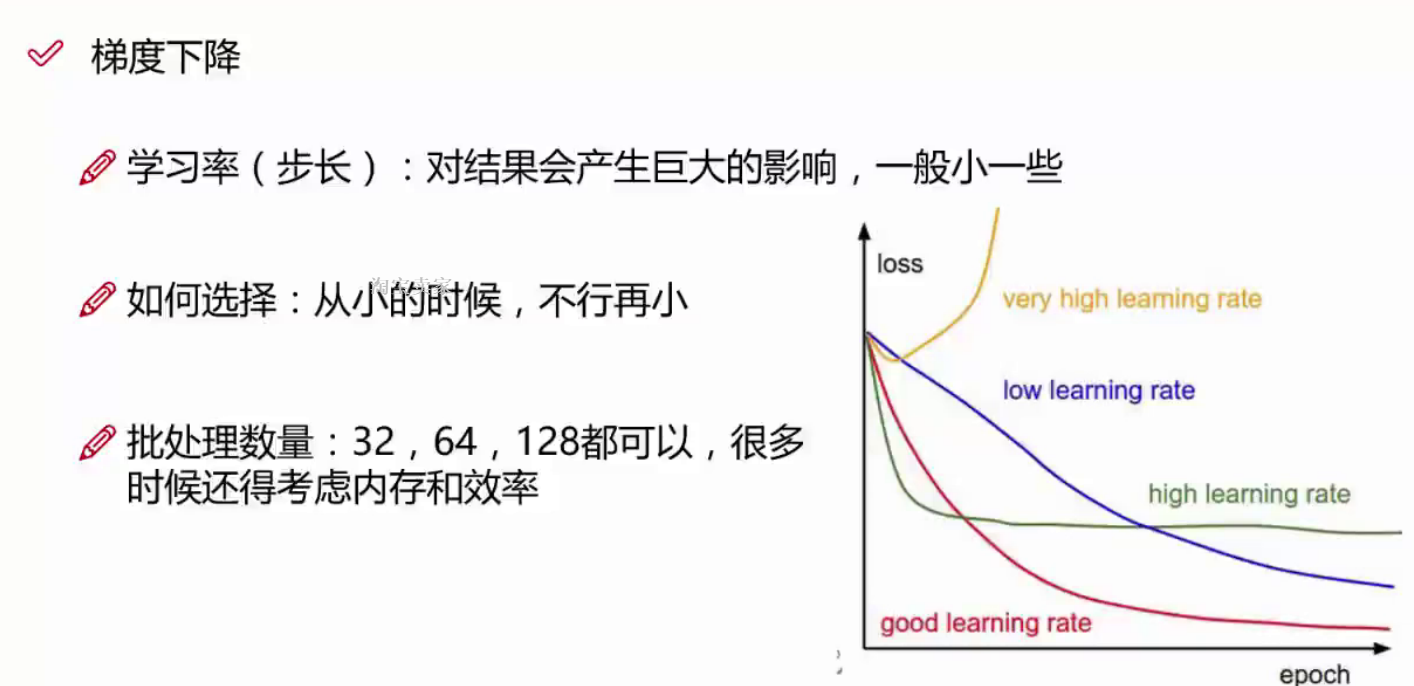

学习率对结果的影响

梯度下降:

1.方向

2.更新

大的学习率会使迭代过程不平稳。越过最低点,达到局部极小值点。

一般用小的学习率,大的迭代次数,进行迭代。

实际开发中,小的学习率如果不能使结果收敛,那么就再次减小学习率。

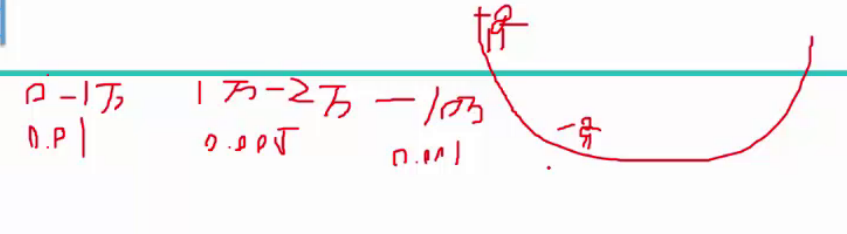

一开始采用较大的学习率(一般用0.01),逐渐减下学习率(如0.001)。

批量一般选64作为minbatch。通常batch越大,最终结果稳定性越高。