摘要:

本文地址:https://wanger-sjtu.github.io/fp16-err/ 最近在项目中需要实现fp16的数据类型做FFN的计算,算子实现的同学反馈误差与x86上得到的golden数据有比较大误差。开始以为是x86侧做数值模拟仿真的问题。后面也实现了对比了一下,发现误差累计确实挺大。 阅读全文

posted @ 2024-09-22 14:59

青铜时代的猪

阅读(376)

评论(2)

推荐(0)

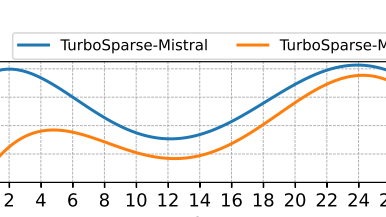

本文地址:https://wanger-sjtu.github.io/TurboSparse/ 关于llama稀疏性的观察 llama原始模型的FFN计算过程为: \[f(x) = \text{silu}(xW_{Gate}) \odot xW_{UP} \times W_{Down} \]clas 阅读全文

本文地址:https://wanger-sjtu.github.io/TurboSparse/ 关于llama稀疏性的观察 llama原始模型的FFN计算过程为: \[f(x) = \text{silu}(xW_{Gate}) \odot xW_{UP} \times W_{Down} \]clas 阅读全文

本文地址:https://www.cnblogs.com/wanger-sjtu/p/SVE_learn_0.html SVE对比NEON有几个新增的地方。 1. 变长的向量 2. 支持Gather-load && Scatter-store ![](https://img2023.cnblogs. 阅读全文

本文地址:https://www.cnblogs.com/wanger-sjtu/p/SVE_learn_0.html SVE对比NEON有几个新增的地方。 1. 变长的向量 2. 支持Gather-load && Scatter-store ![](https://img2023.cnblogs. 阅读全文