网络爬虫

第一部分

请分析作业页面,爬取已提交作业信息,并生成已提交作业名单,保存为英文逗号分隔的csv文件。文件名为:hwlist.csv 。

文件内容范例如下形式:

学号,姓名,作业标题,作业提交时间,作业URL

20194010101,张三,羊车门作业,2018-11-13 23:47:36.8,http://www.cnblogs.com/sninius/p/12345678.html

20194010102,李四,羊车门,2018-11-14 9:38:27.03,http://www.cnblogs.com/sninius/p/87654321.html

*注1:如制作定期爬去作业爬虫,请注意爬取频次不易太过密集;

*注2:本部分作业用到部分库如下所示:

(1)requests —— 第3方库

(2)json —— 内置库

答:

本次作业是在参考一些已经完成作业大佬的思路基础上,自己查阅网上有关网络爬虫的资料后,尝试的结果。

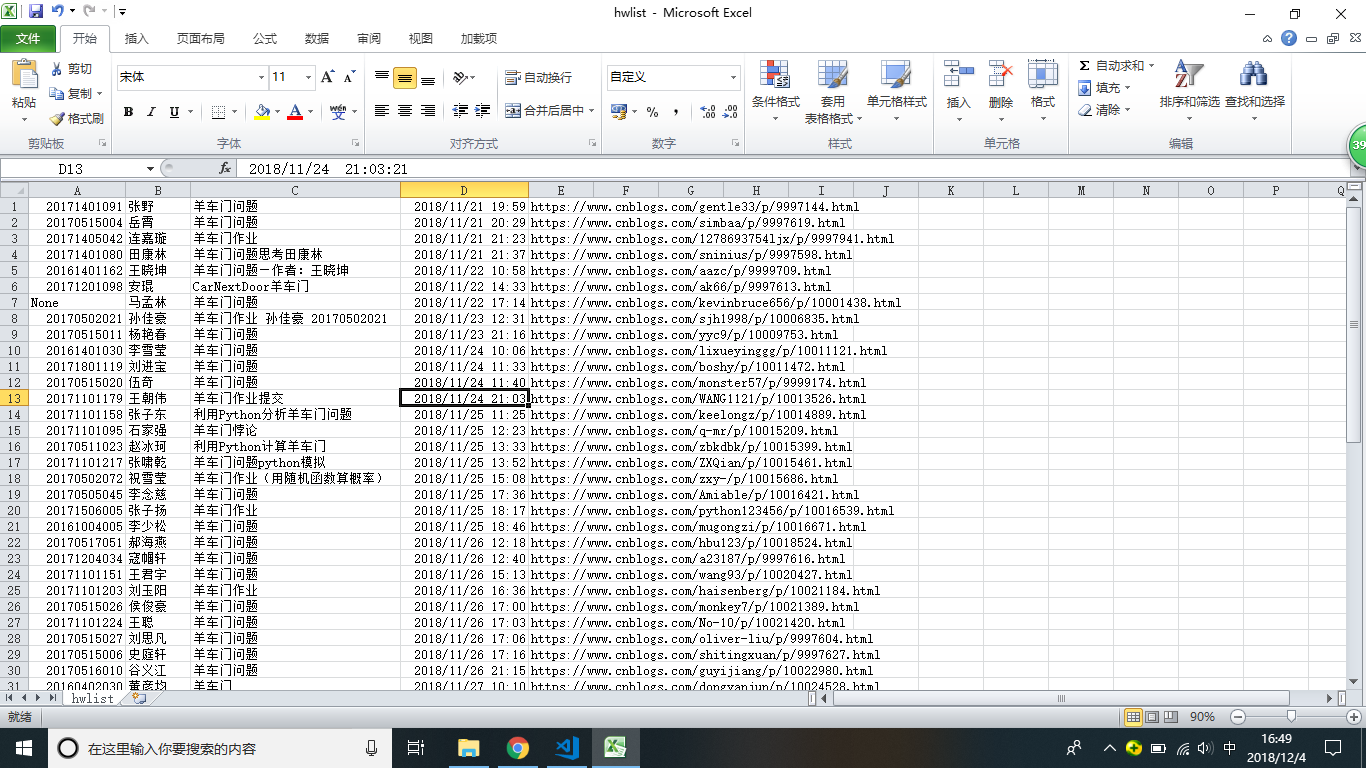

代码运行效果如下(对excell中单元格格式做出微小更改):

1 import requests 2 import json 3 4 url = 'https://edu.cnblogs.com/Homework/GetAnswers?homeworkId=2420&_=1543844945149' 5 r = requests.get(url,timeout=3.7) 6 datas = json.loads(r.text) 7 data = datas['data'] 8 everyone = '' 9 for i in data : 10 everyone = everyone + str(i.get('StudentNo'))+','+str(i.get('RealName'))+','+str(i.get('Title'))+','+str(i.get('DateAdded').replace('T',' '))+','+str(i.get('Url')) +'\n' 11 12 with open('hwlist.csv','w') as A : 13 A.write(everyone)