hadoop-3.1.2分布式搭建

一、准备工作

三台虚拟机:

master、node1、node2

时间同步

关闭防火墙:

systemctl stop firewalld

查看防火墙状态:

systemctl status firewalld

取消防火墙自启:

systemctl disable firewalld

修改主机名

三台分别执行 vim /etc/hostname 并将内容指定为对应的主机

名

静态IP配置

vim /etc/sysconfig/network-scripts/ifcfg-ens33

关闭NetworkManager,并取消开机自启

systemctl stop NetworkManager

systemctl disable NetworkManager

systemctl status NetworkManager

免密登录

1、生成密钥

ssh-keygen -t rsa

2、配置免密登录

ssh-copy-id master

ssh-copy-id node1

ssh-copy-id node2

3、测试免密登录

ssh node1

配置好映射文件:

vim /etc/hosts

192.168.6.101 master

192.168.6.102 node1

192.168.6.103 node2

配置jdk

java -version

二、hadoop-3.1.1分布式搭建

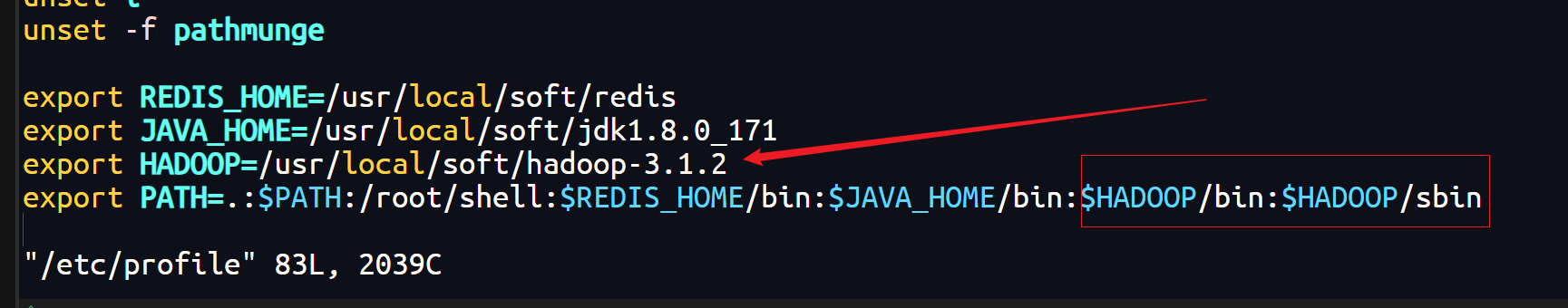

1、上传解压配置环境变量

- 解压

tar -zxvf hadoop-3.1.2.tar.gz

- 配置环境变量

vim /etc/profile

- 使环境变量生效

source /etc/profile

2、修改配置文件

- 1、进入hadoop配置文件所在位置,修改hadoop配置文件

cd /usr/local/soft/hadoop-3.1.2/etc/hadoop

- 2、修改core-site.xml配置文件,在configuration中间增加配置

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/soft/hadoop-3.1.2/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

</configuration>

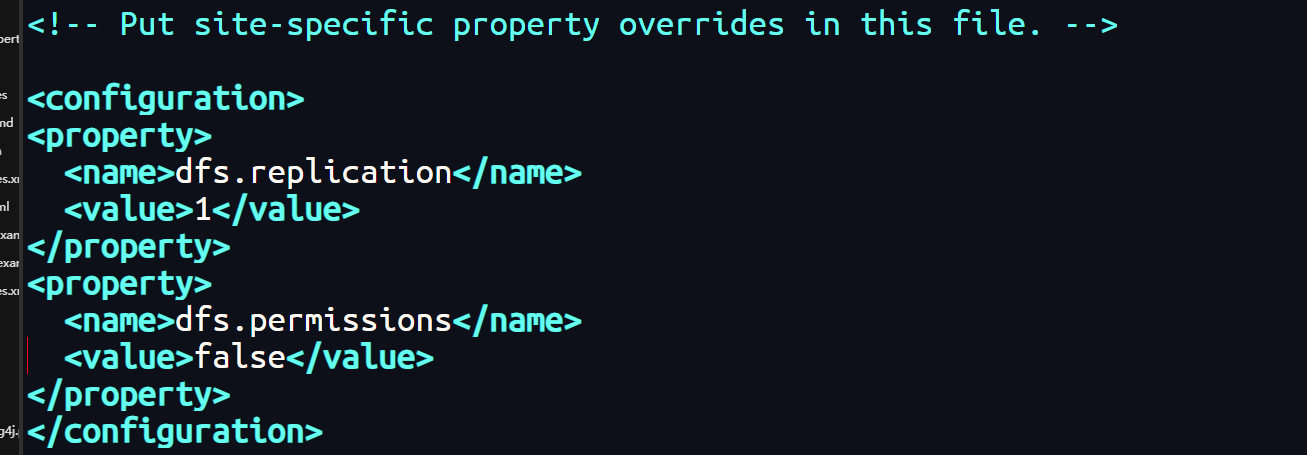

- 3、修改hdfs-site.xml配置文件,在configuration中间增加配置

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

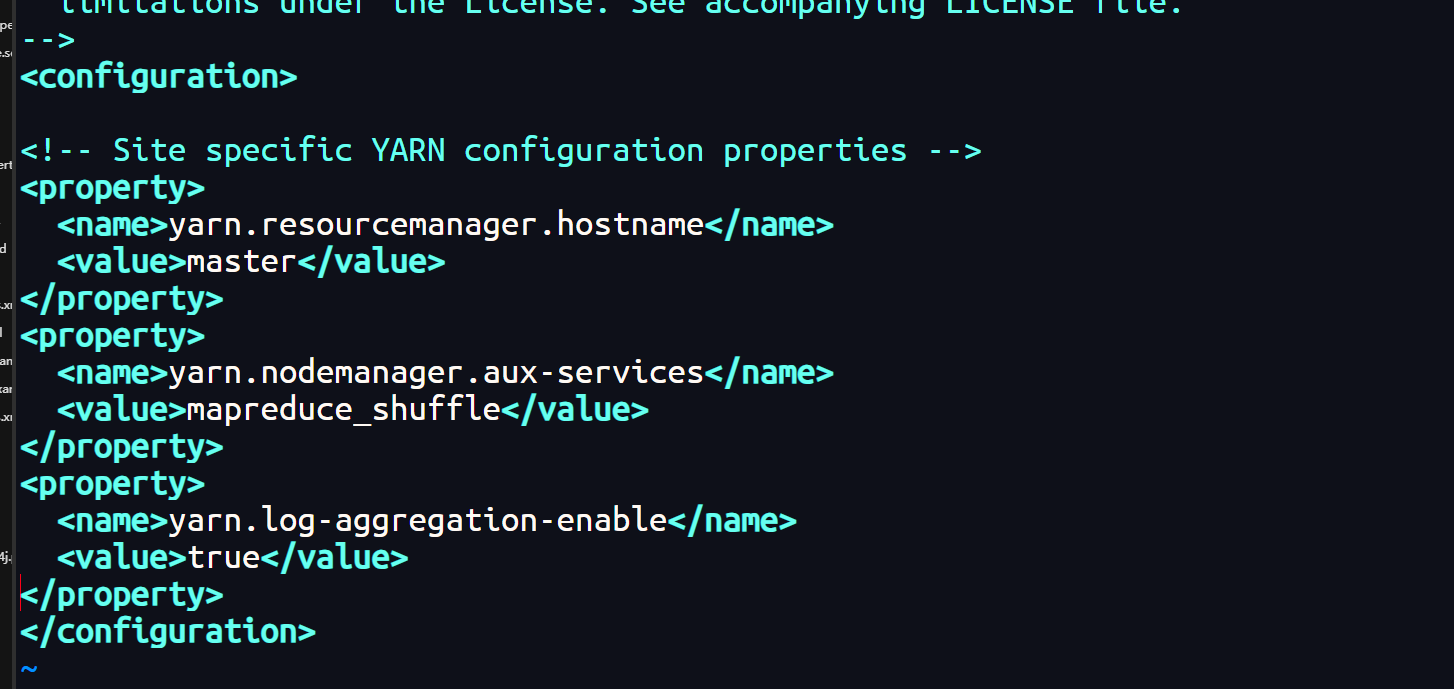

- 4、修改yarn-site.xml配置文件,在configuration中间增加配置

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

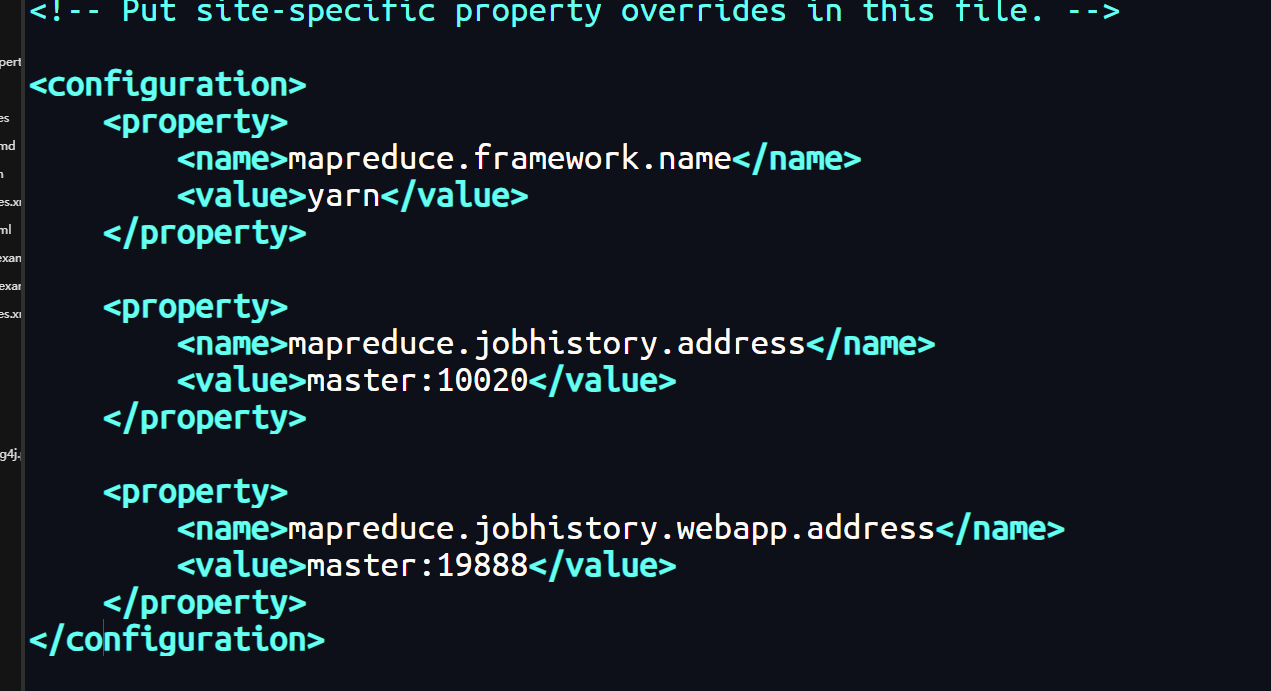

- 5、修改mapred-site.xml配置文件,在configuration中间增加配置

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

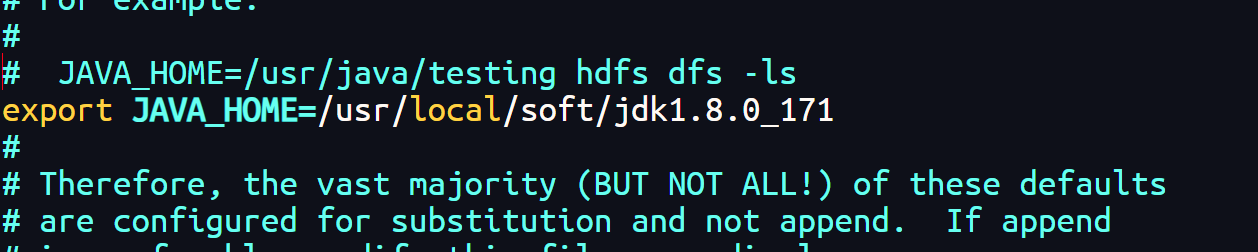

- 6、修改hadoop-env.sh配置文件

export JAVA_HOME=/usr/local/soft/jdk1.8.0_171

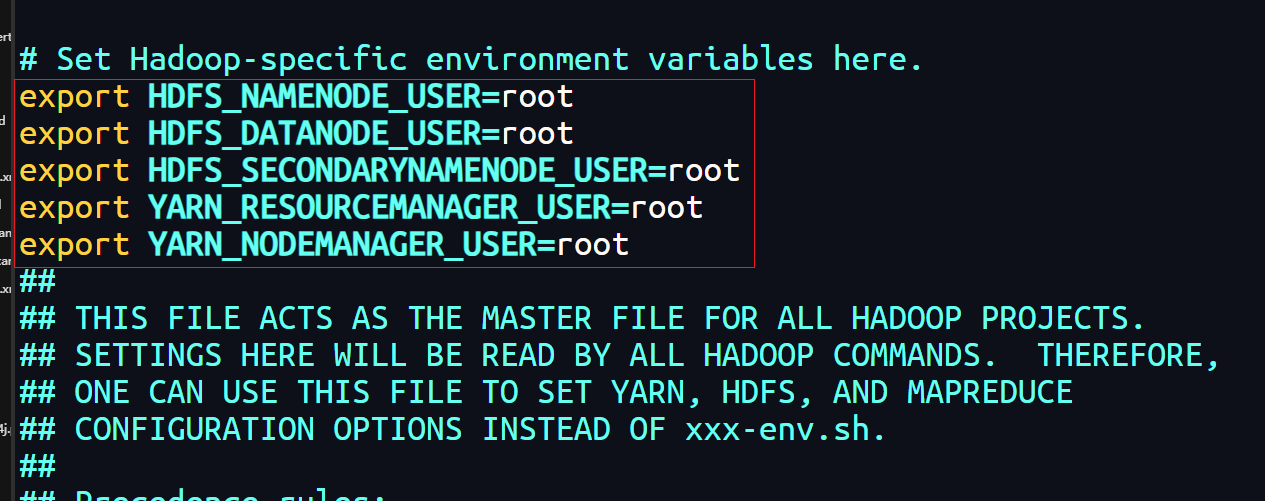

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

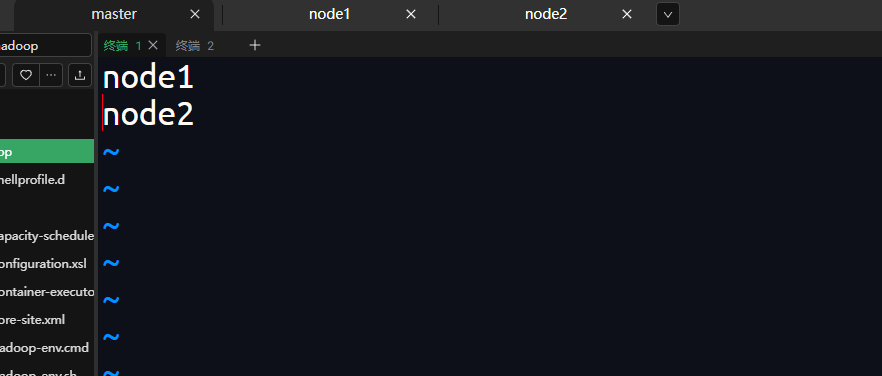

- 7、修改 workers 配置文件

node1

node2

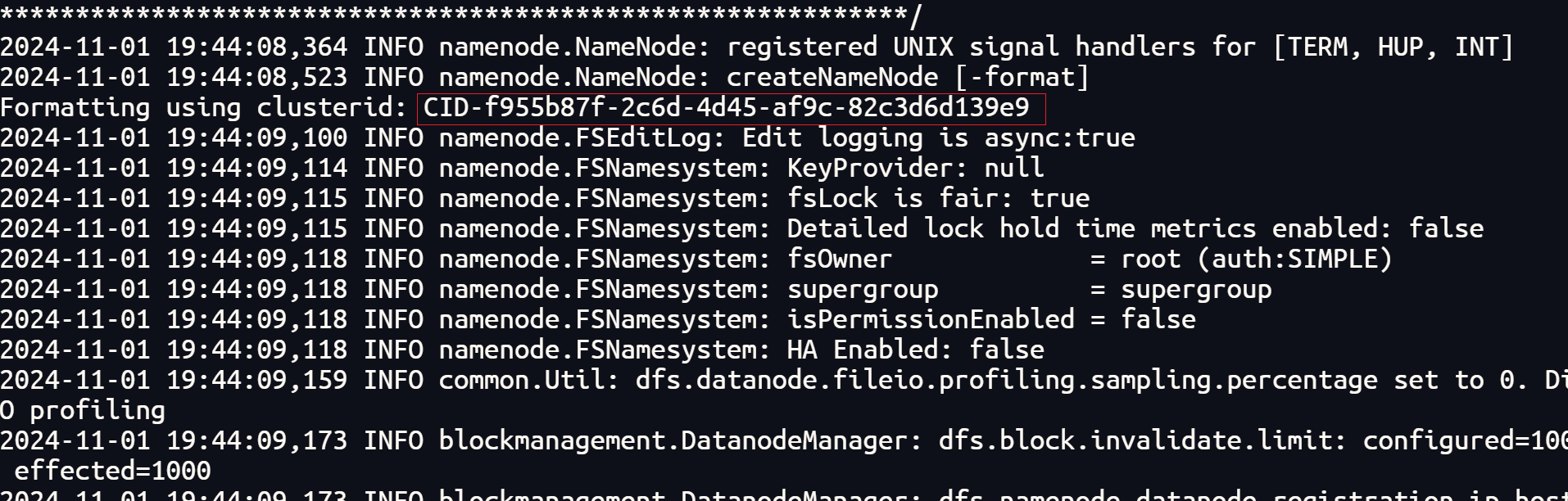

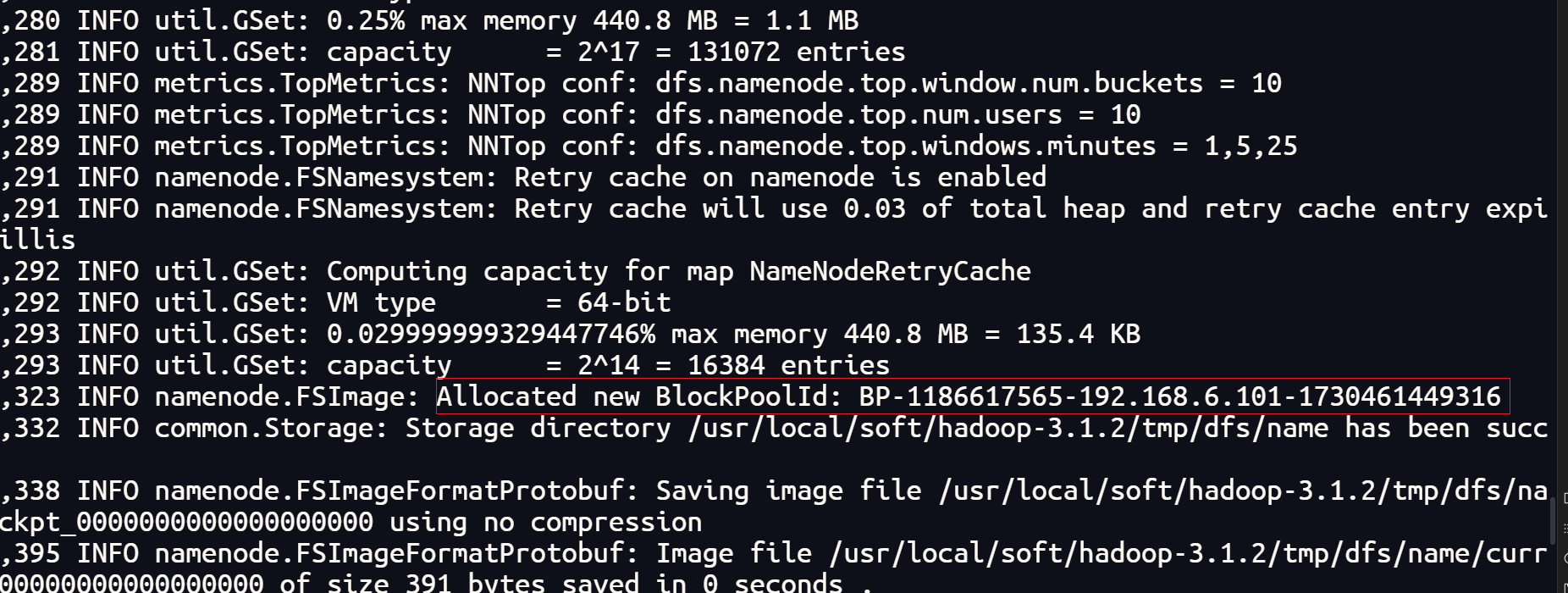

- 8、初始化hdfs

hdfs namenode -format

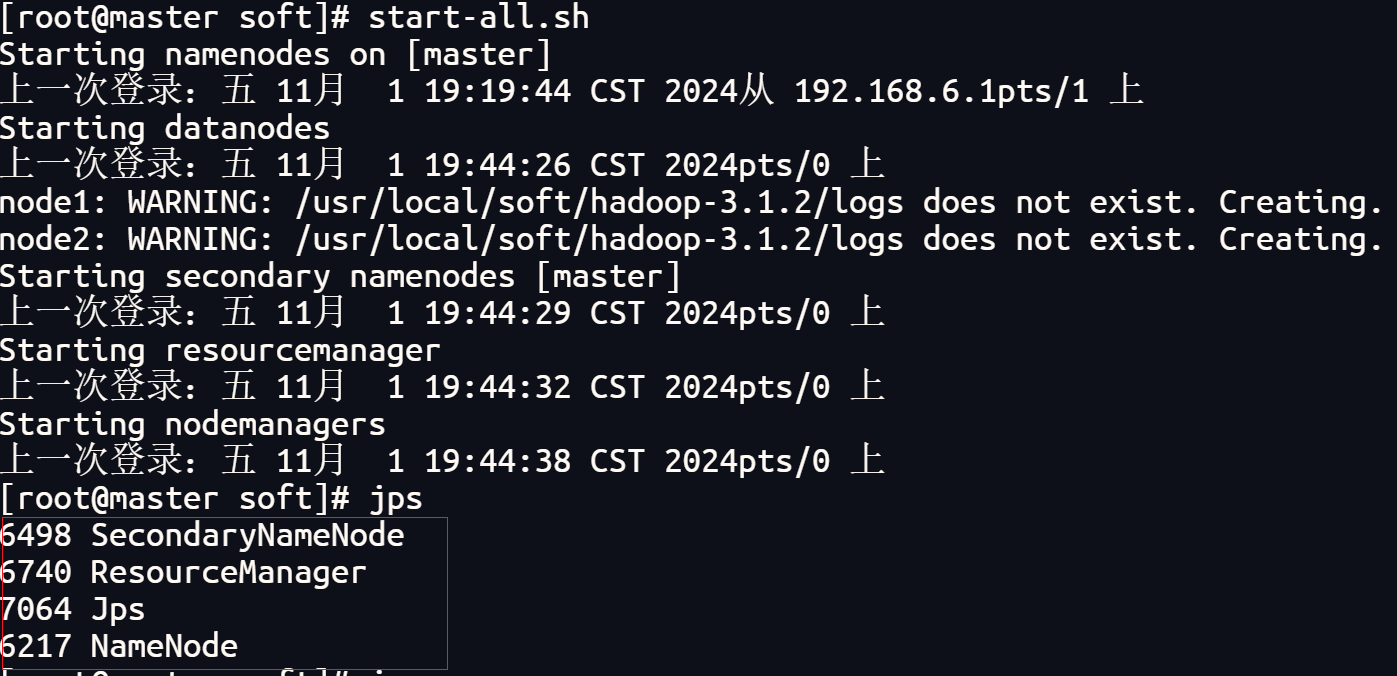

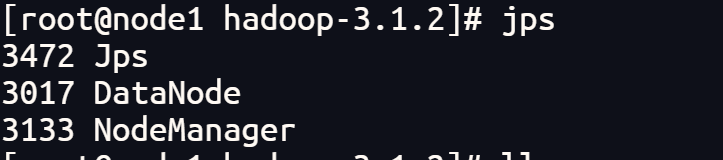

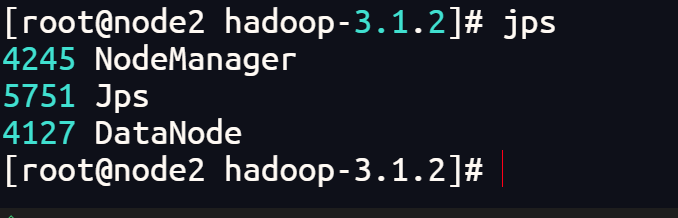

- 9、启动hadoop

start-all.sh

master

node1

node2

- 10、停止hadoop

stop-all.sh

三、格式化集群

- 1、关闭集群

stop-all.sh

- 2、删除每个节点的hadoop根目录下的tmp目录

rm -rf tmp/

- 3、重新格式化 在hadoop的bin目录下执行

hdfs namenode -format

- 4、重新启动

start-all.sh