2024-08-04 - 大模型技术及交叉应用- 第四章- 基础理论 - 清华大学 - 刘知远

摘要

2024-08-04 周日 杭州 狂风大作

小记: 之前买了 2 个茶饮,单独喝怎么都不好喝,然后我混在一起,居然美味极了。

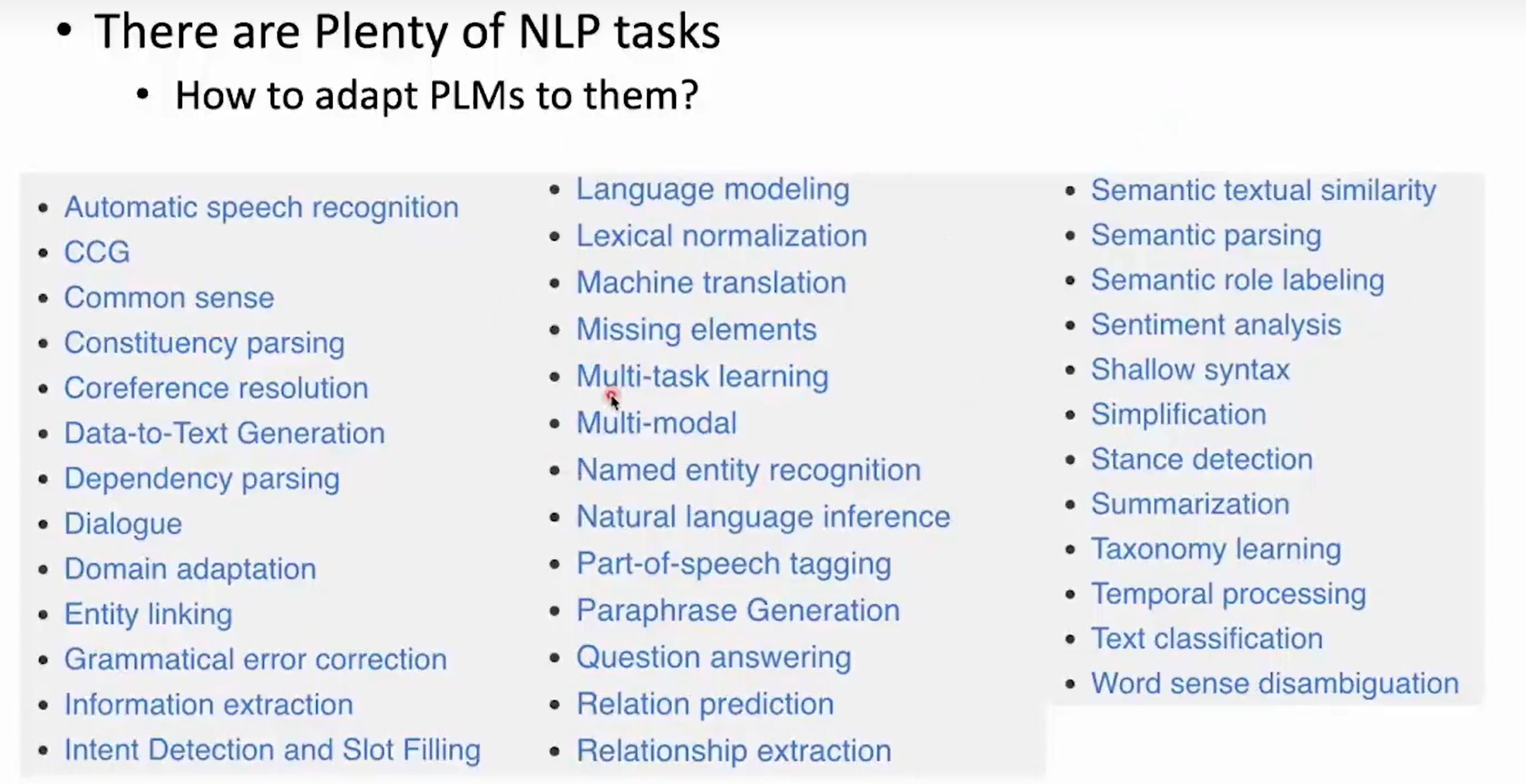

课程内容

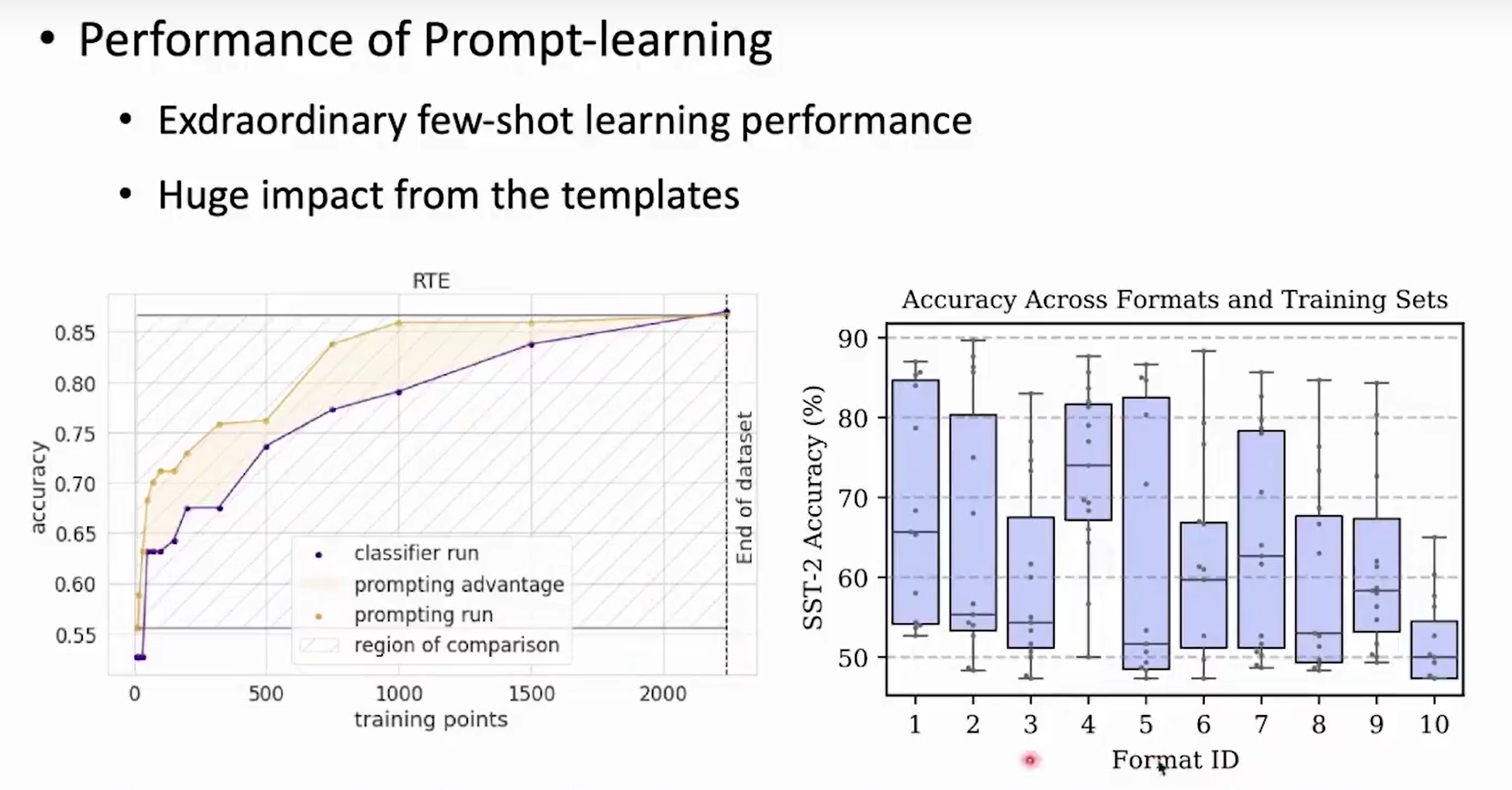

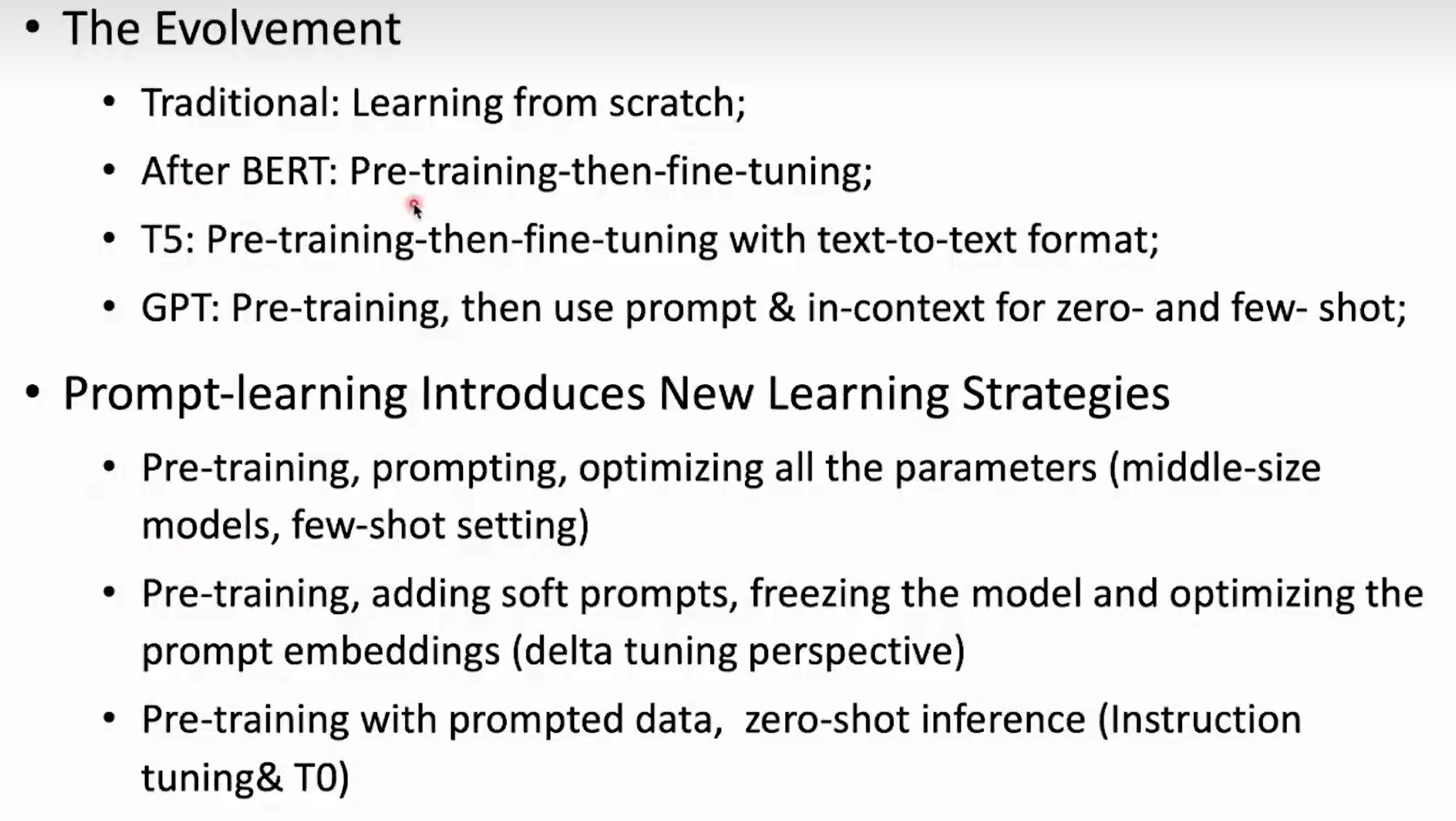

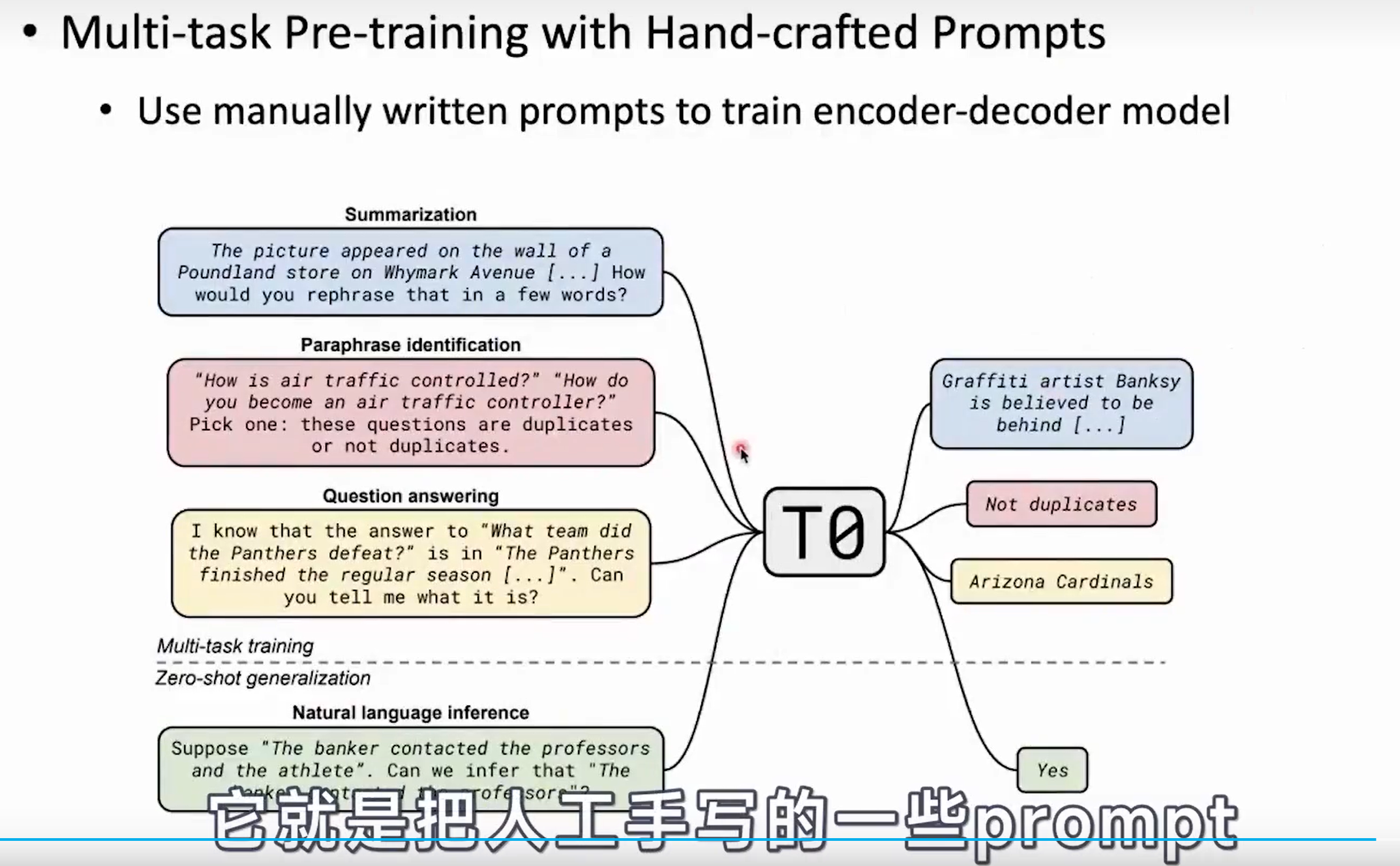

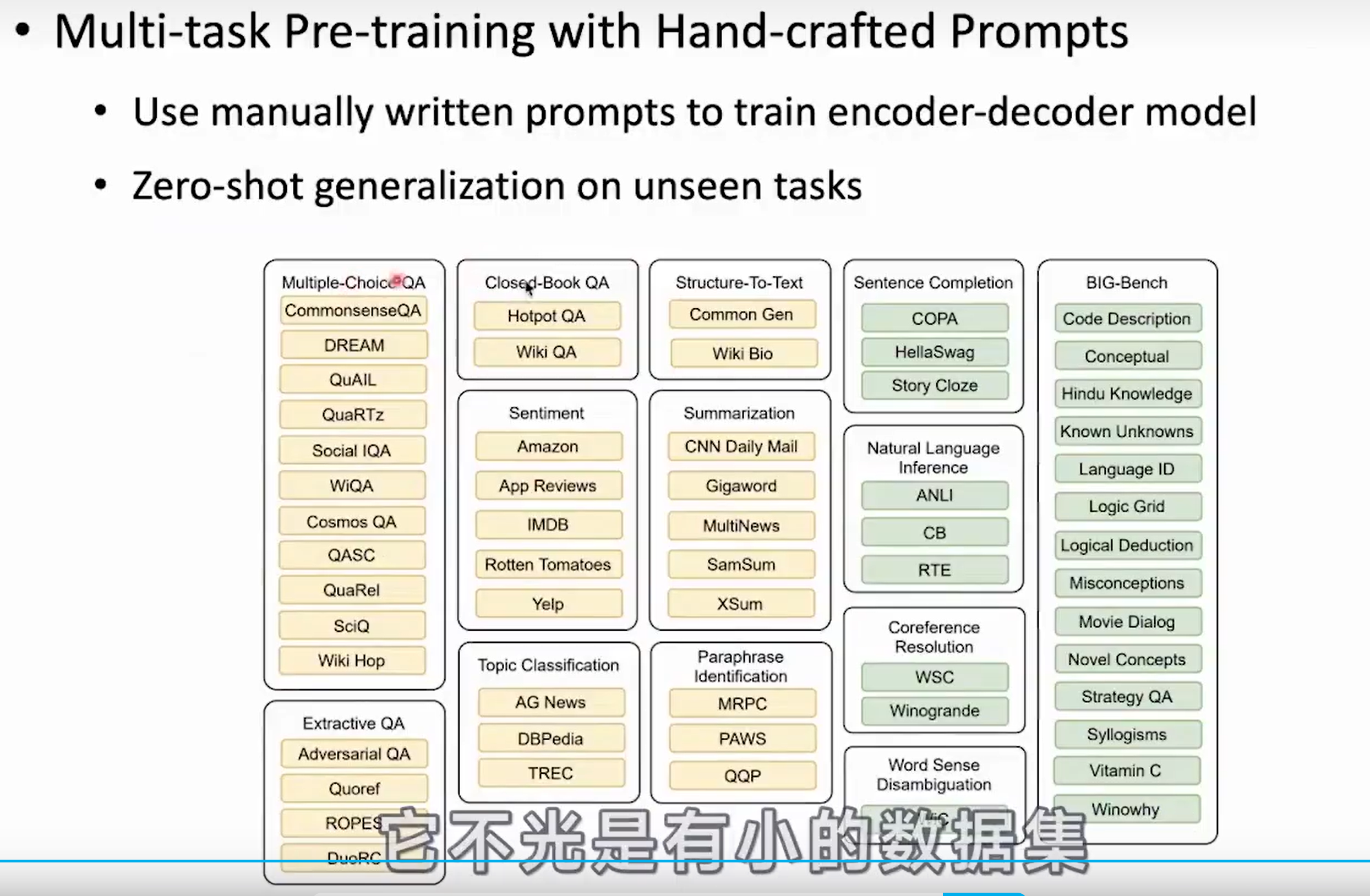

1. Prompt-Learning 系统课程

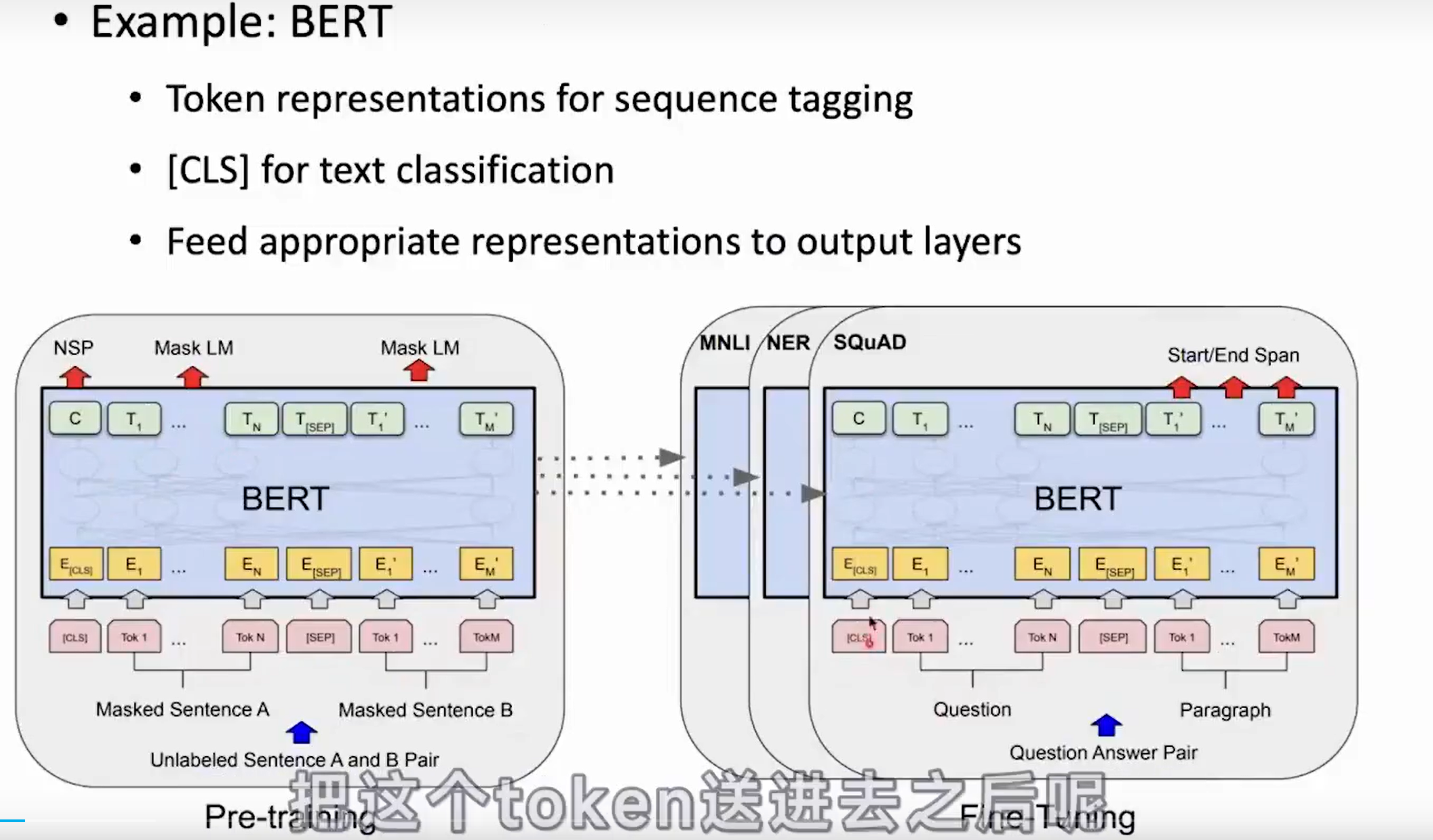

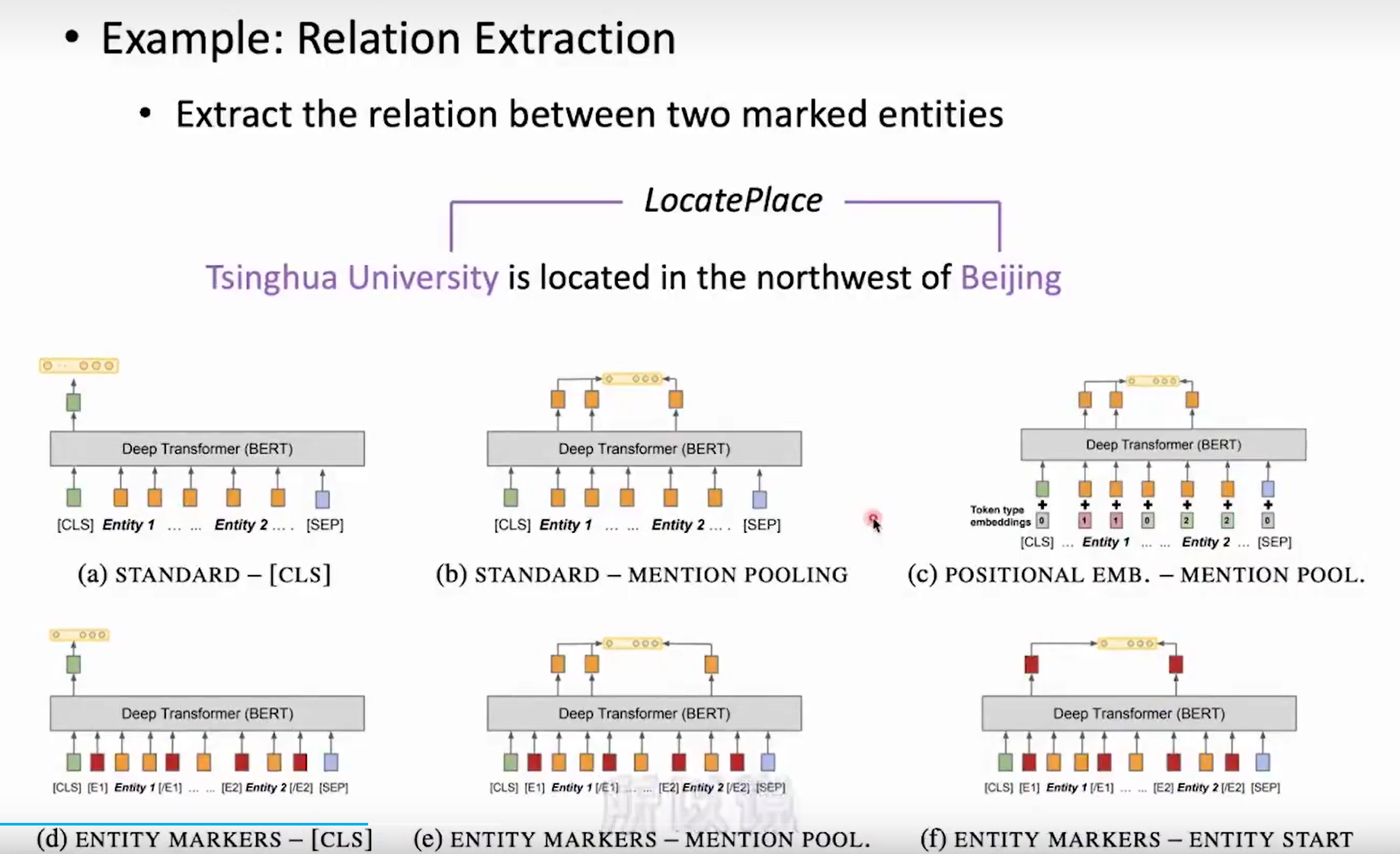

- BERT 微调策略

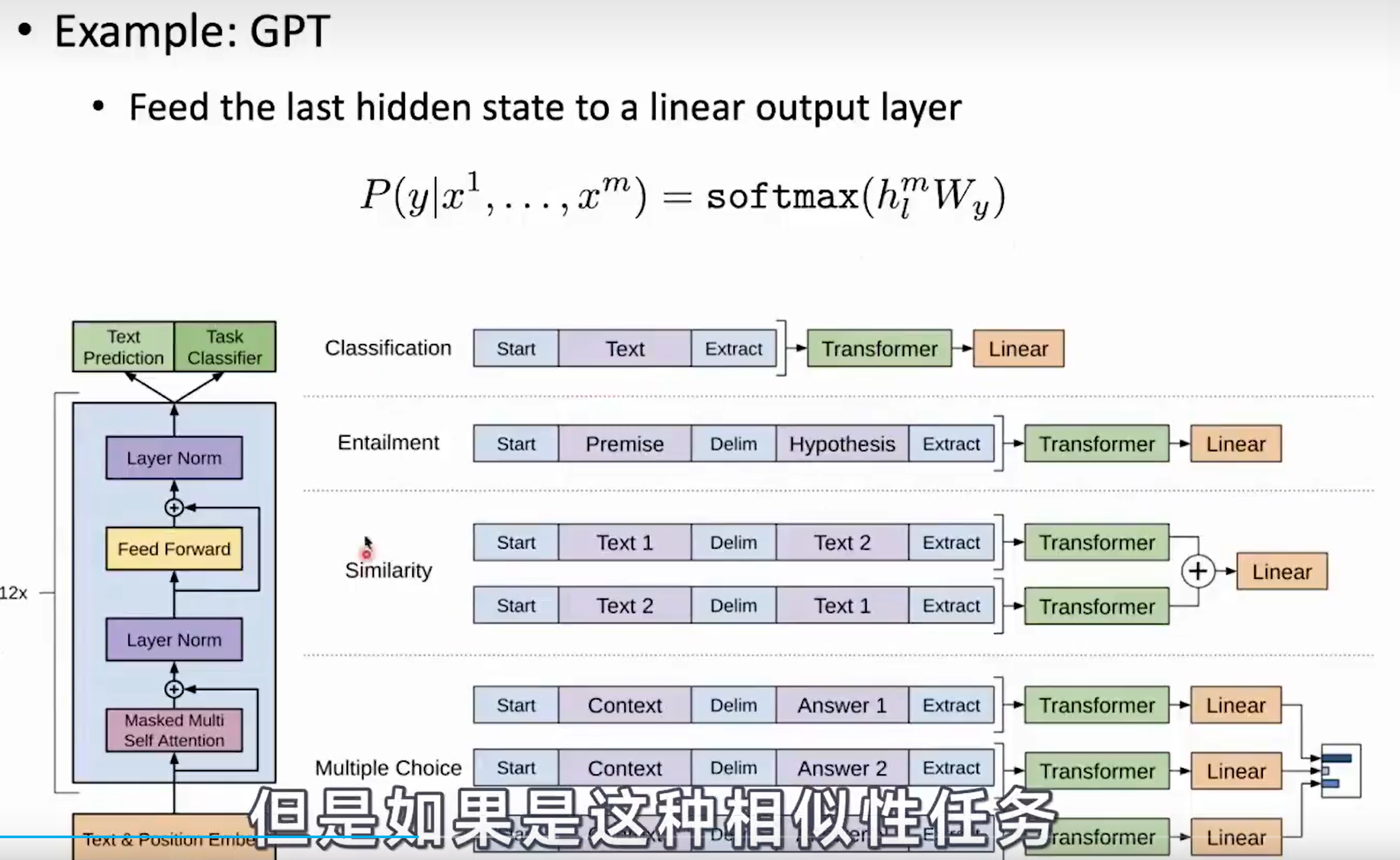

- GPT 微调策略

-

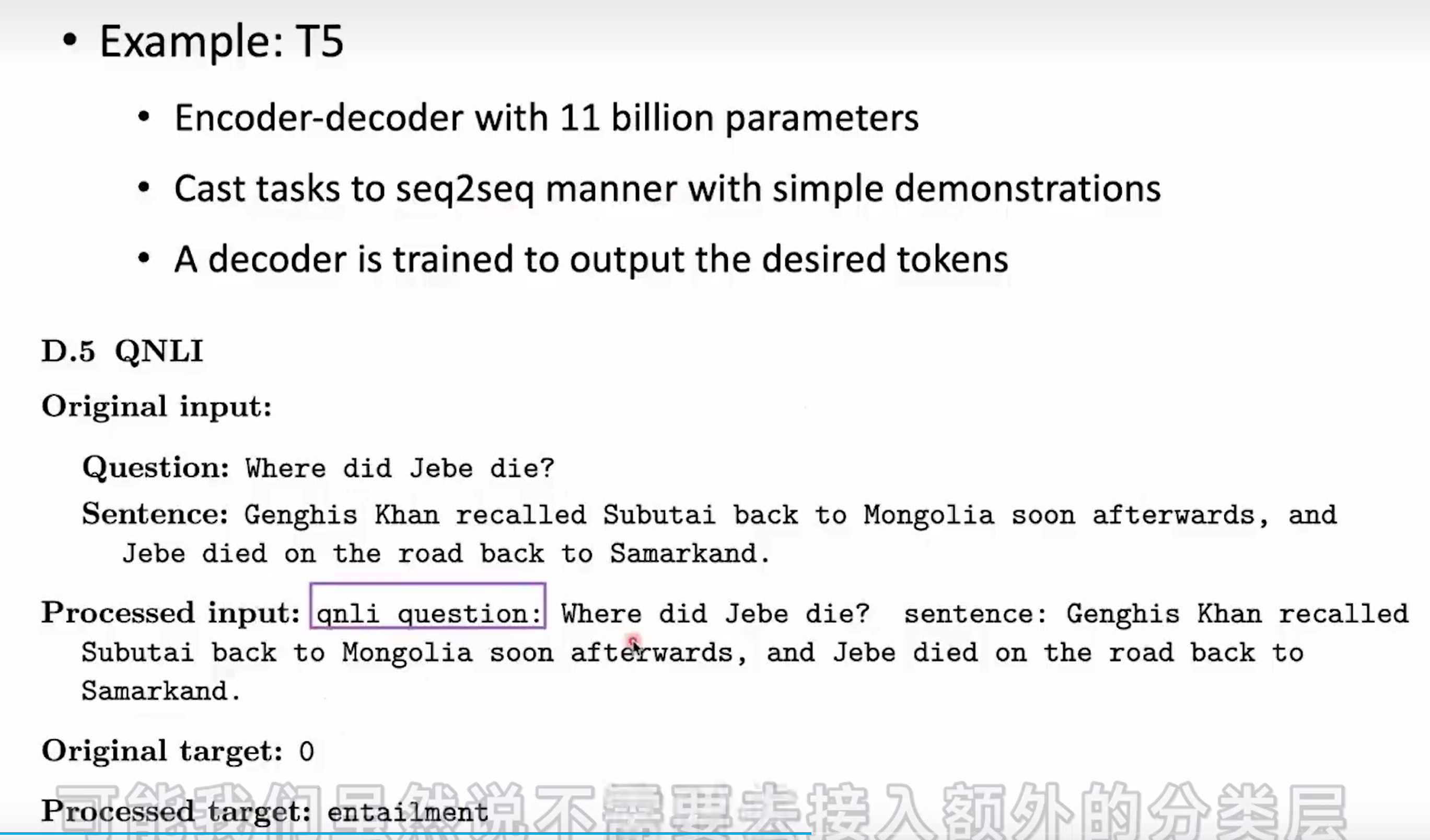

T5 策略(110亿大模型)

-

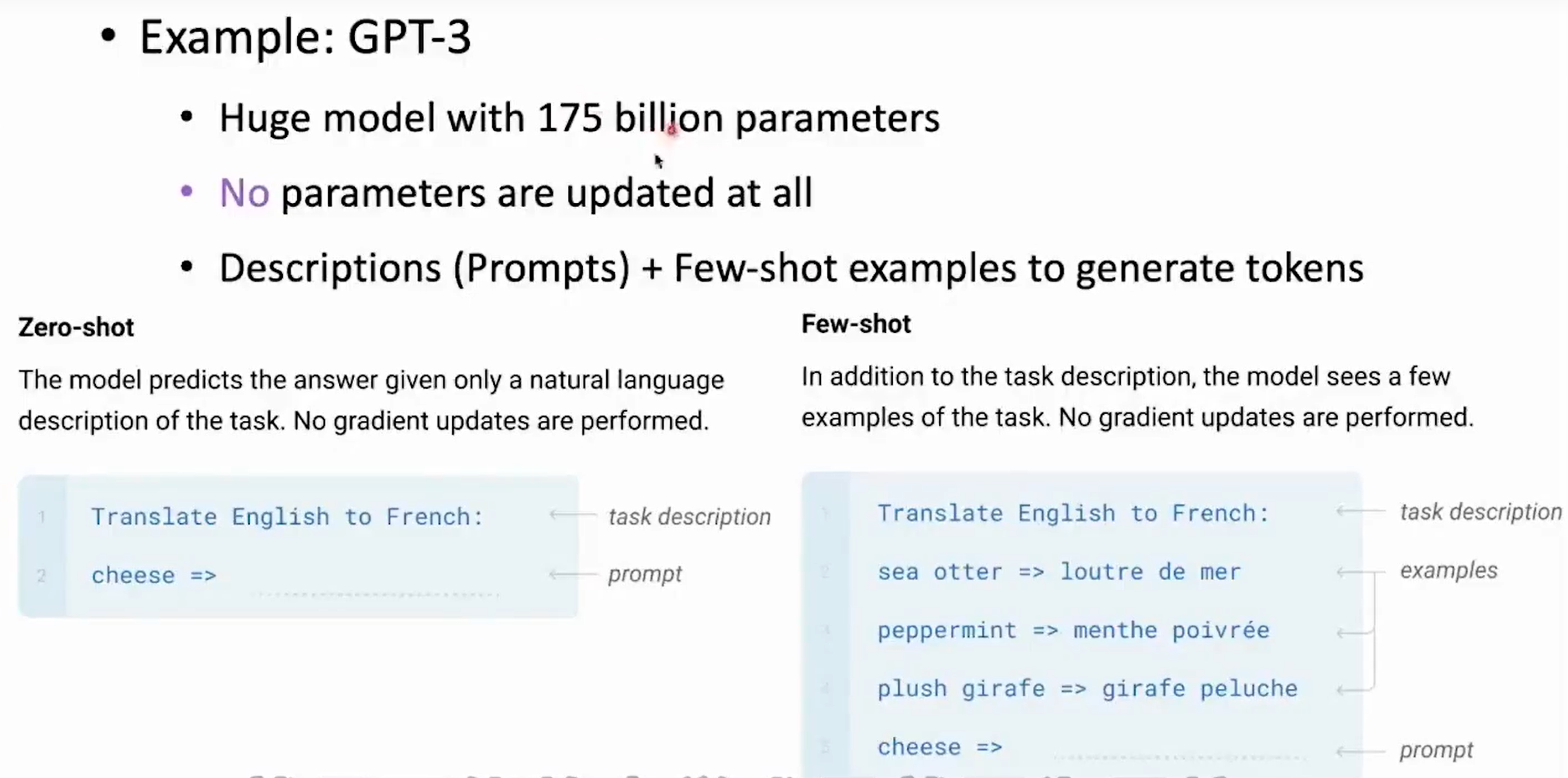

GPT-3(千亿大模型)

-

大模型为什么越大越好

-

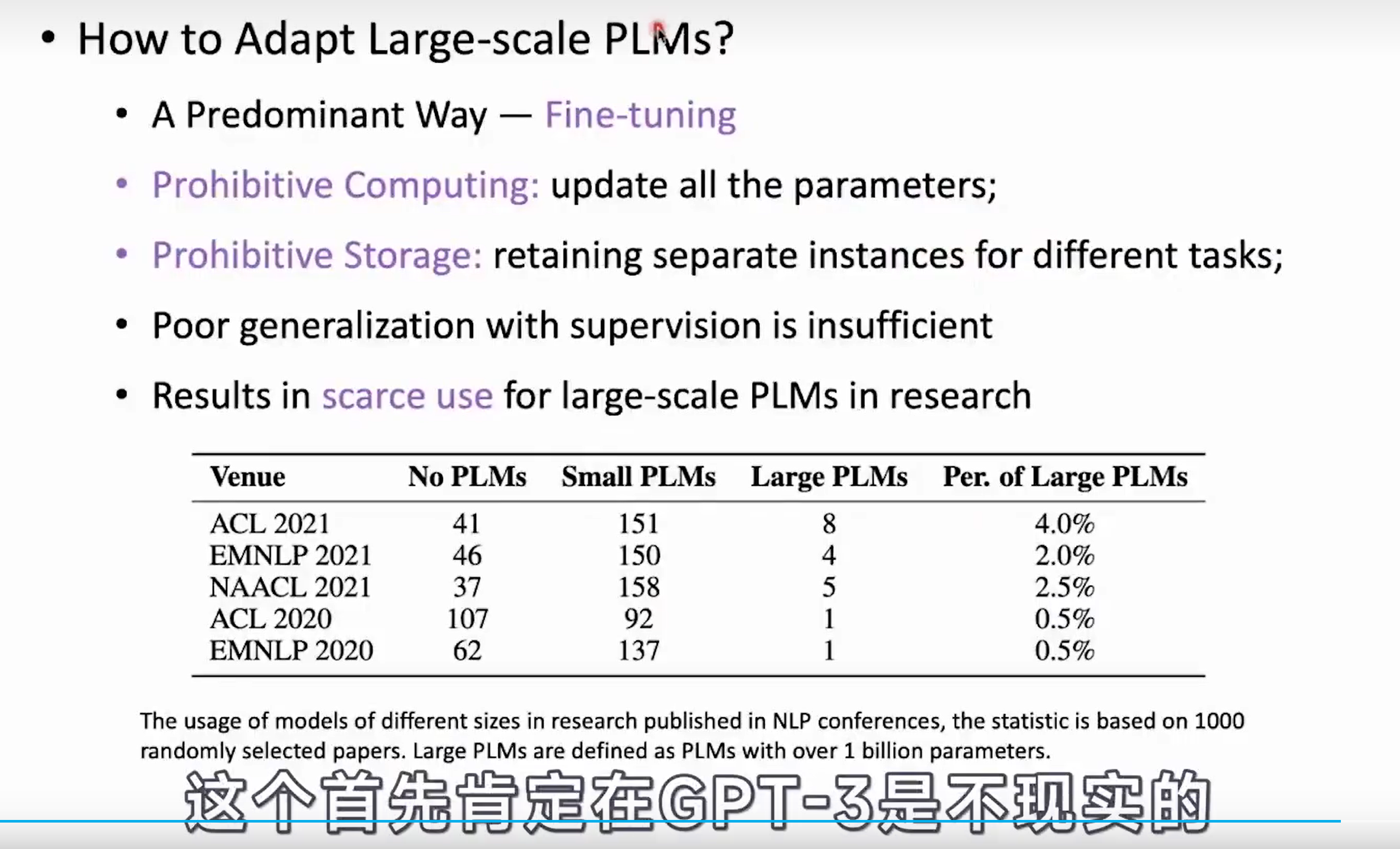

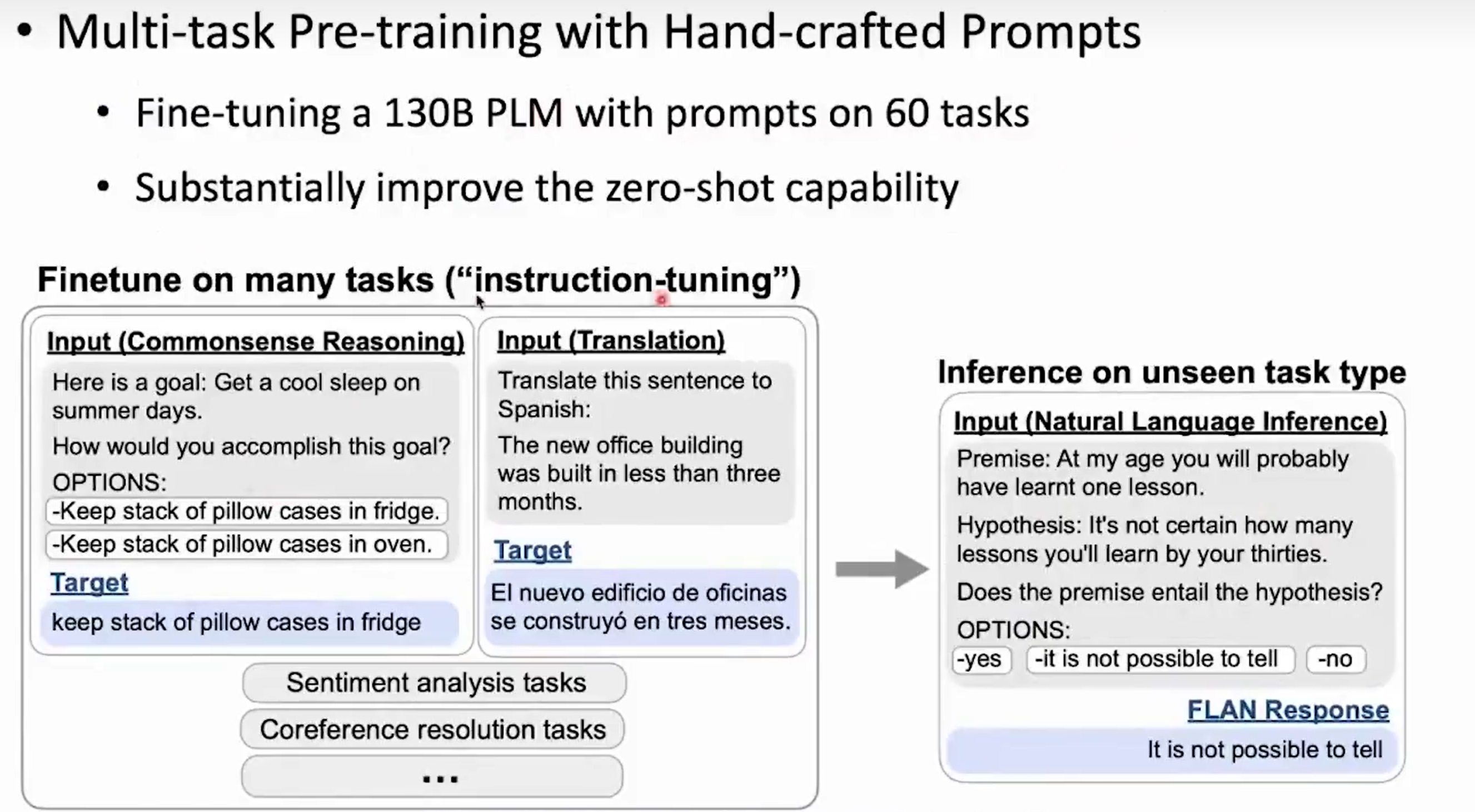

如何微调大模型

-

如何高效微调大模型

-

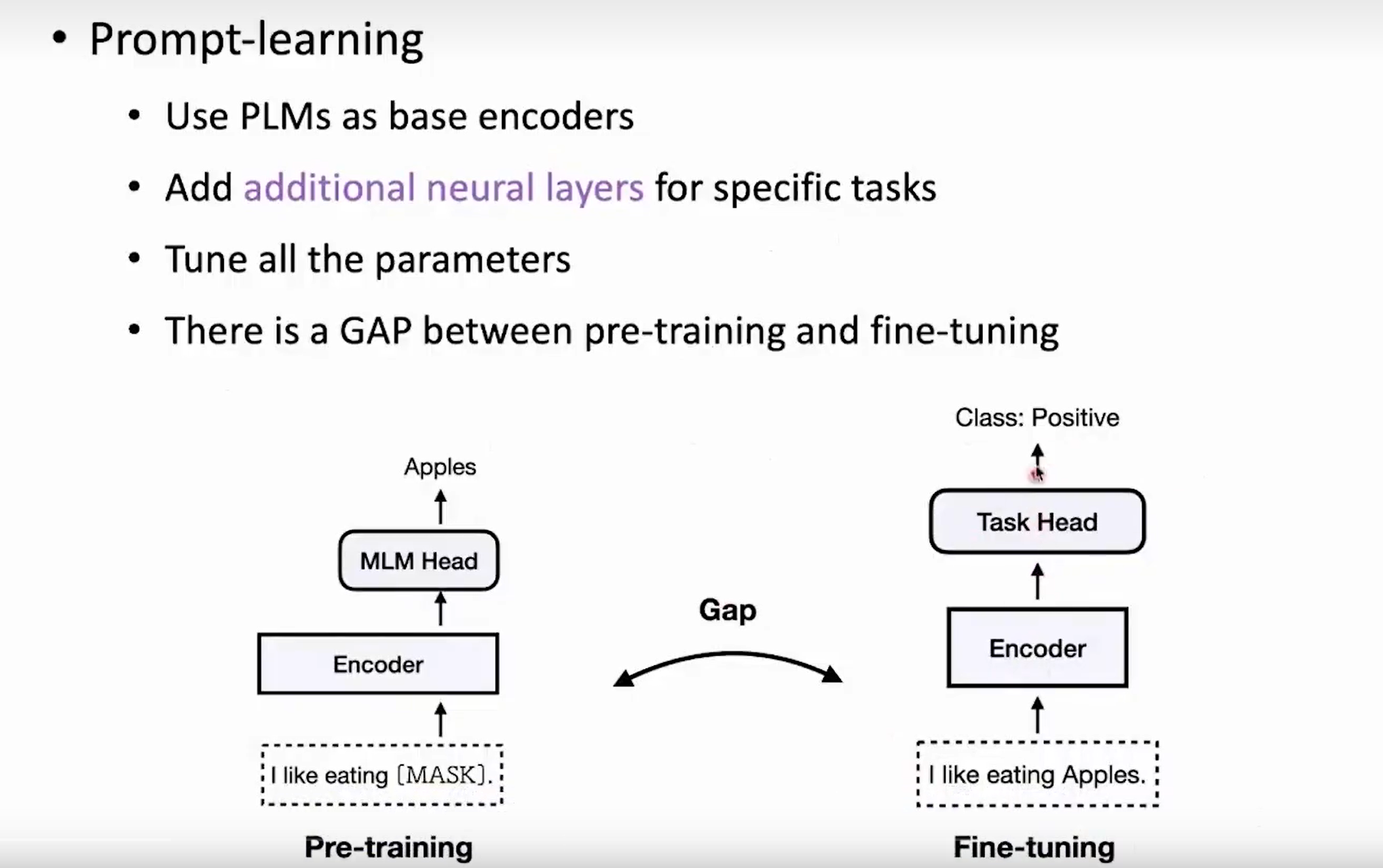

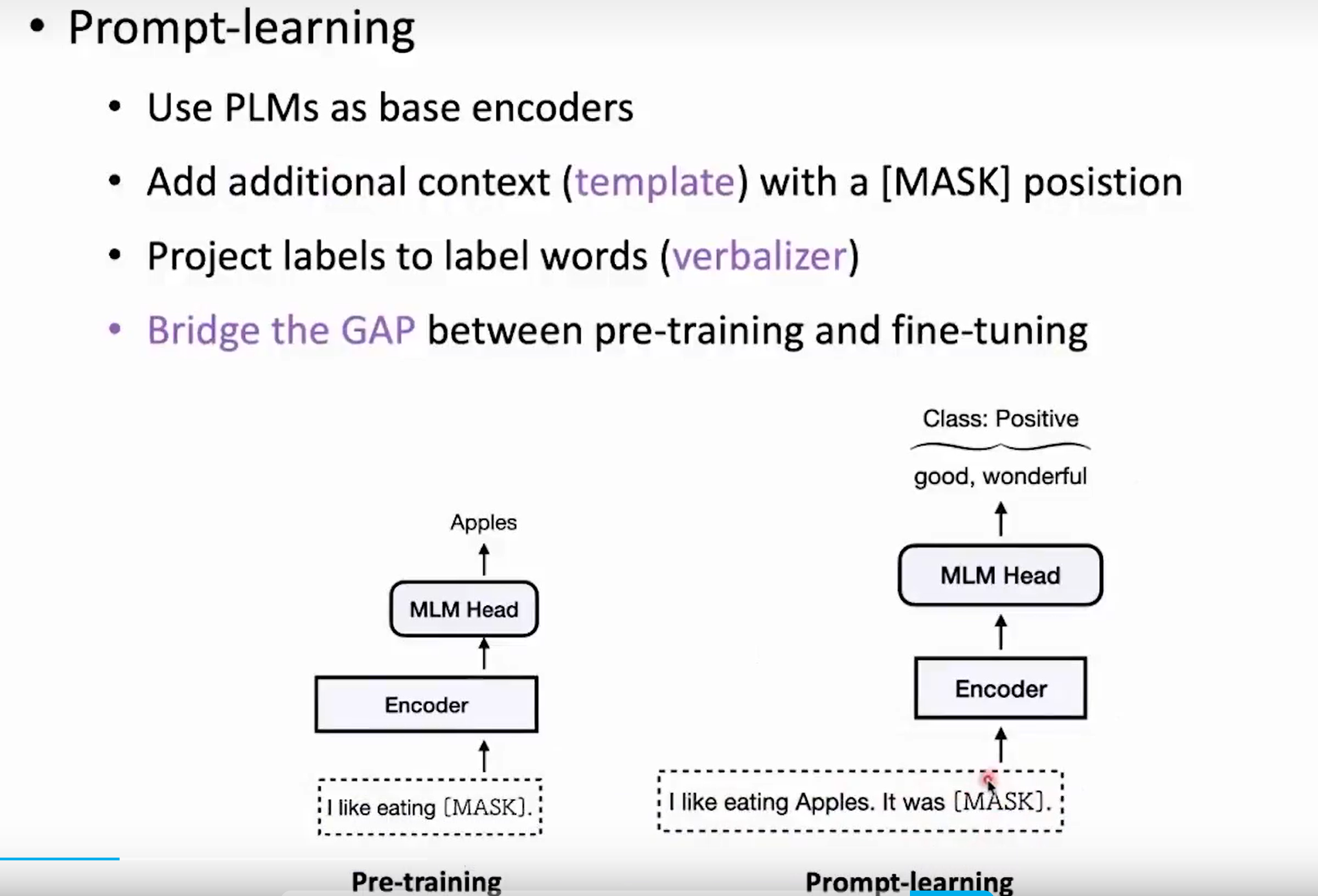

Pre-Training 与 Fine-Tuning 的区别

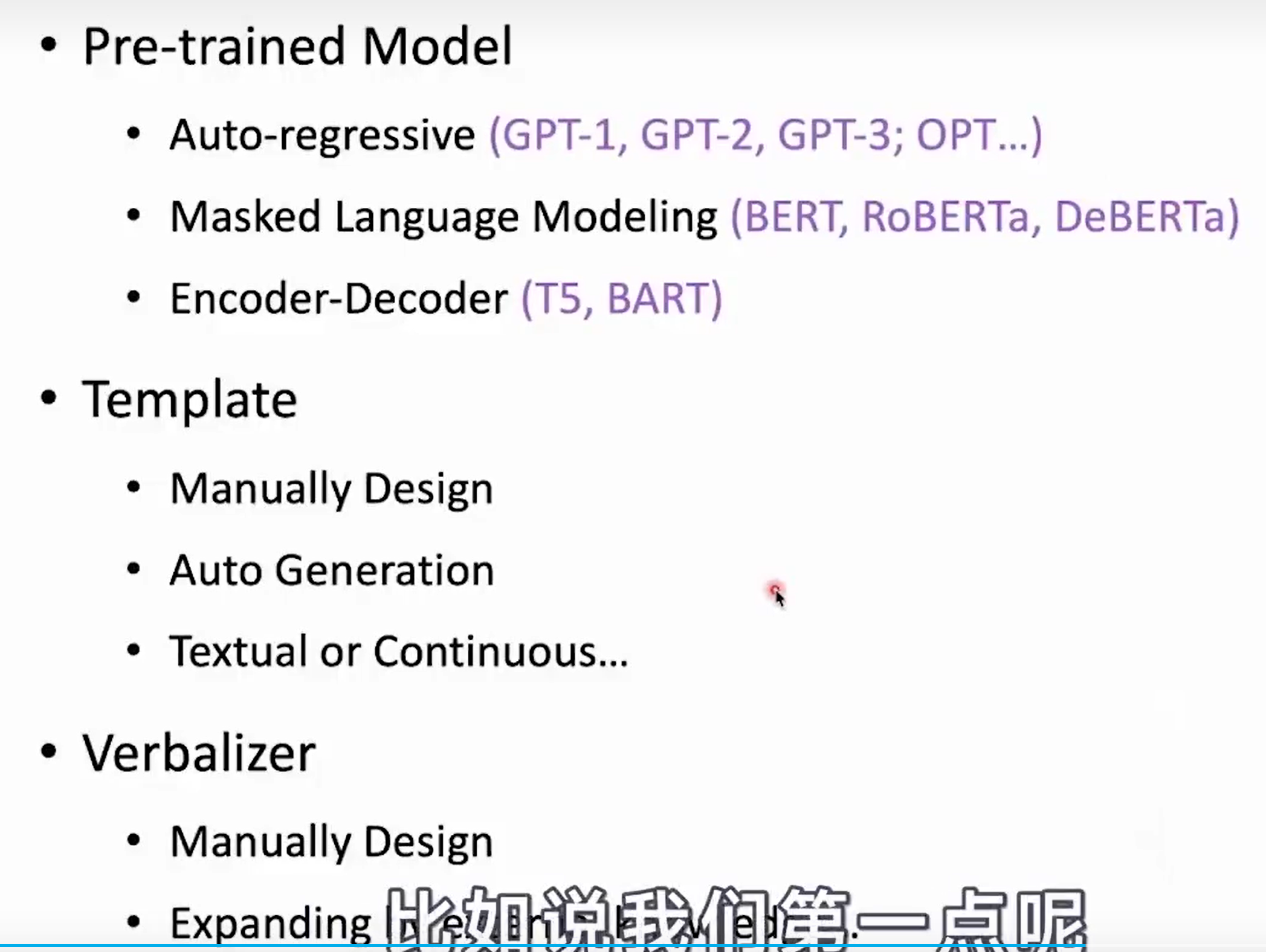

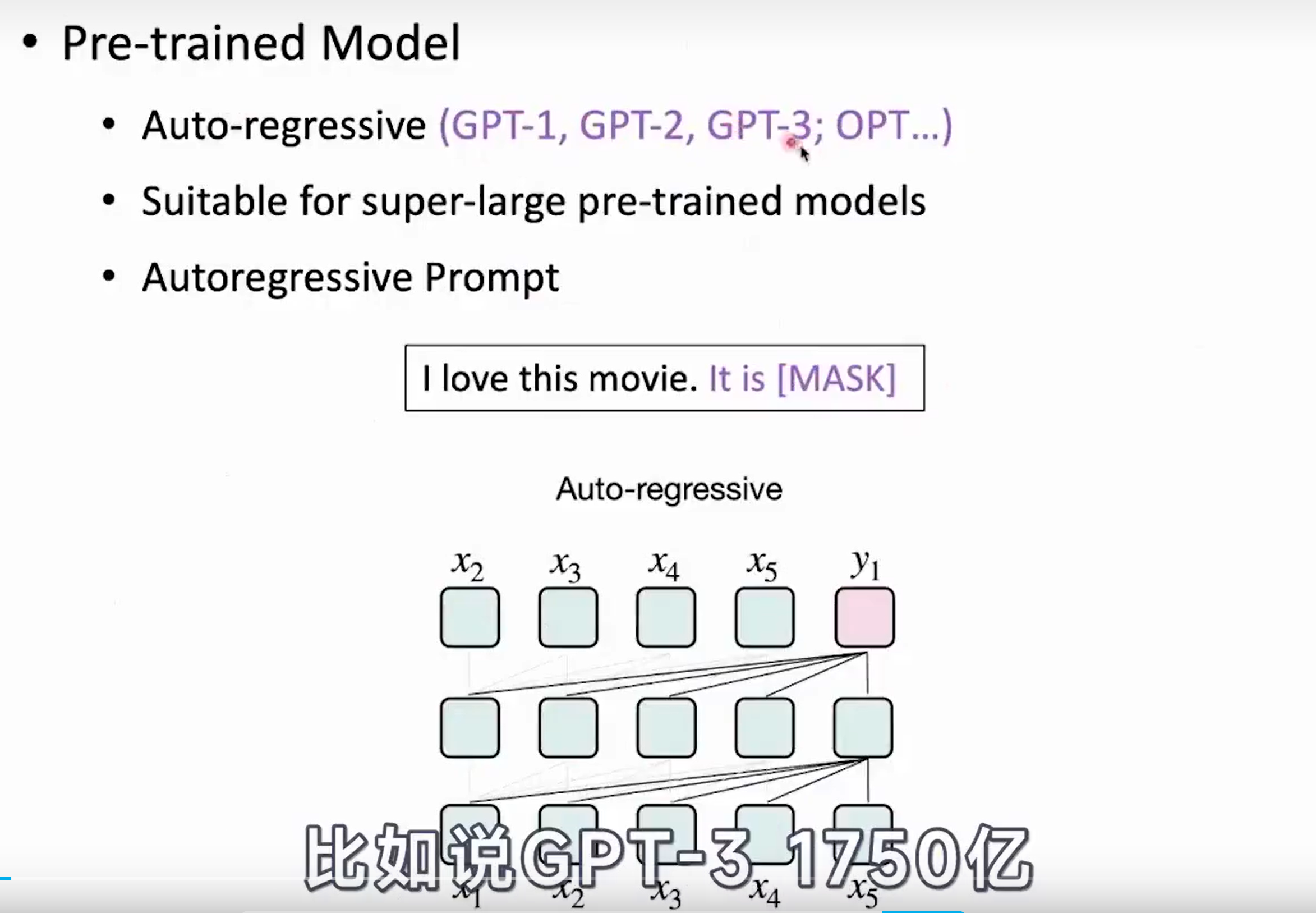

- Auto-regressive

代表: GPT-1; GPT-2; GPT-3;...

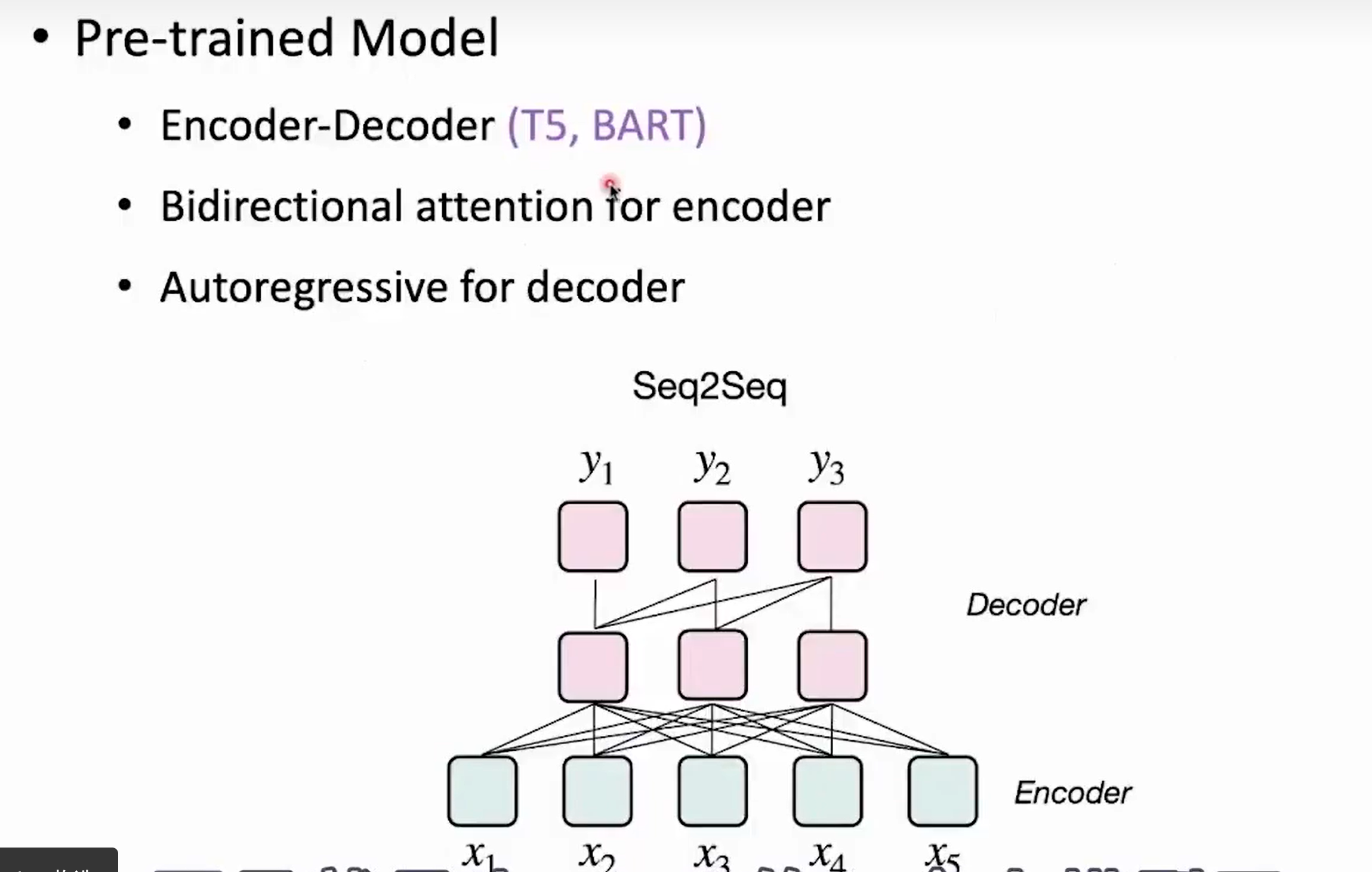

- Encoder-Decoder(T5; BART)

小结: T5 比较通用一些,并且 T5 属于目前开源的大模型,GPT 不开源,BART 也不开源,毕竟真正有价值的东西,人们总喜欢藏起来,一贫如洗的时候都会无私奉献,一旦拥有又会极力占有。

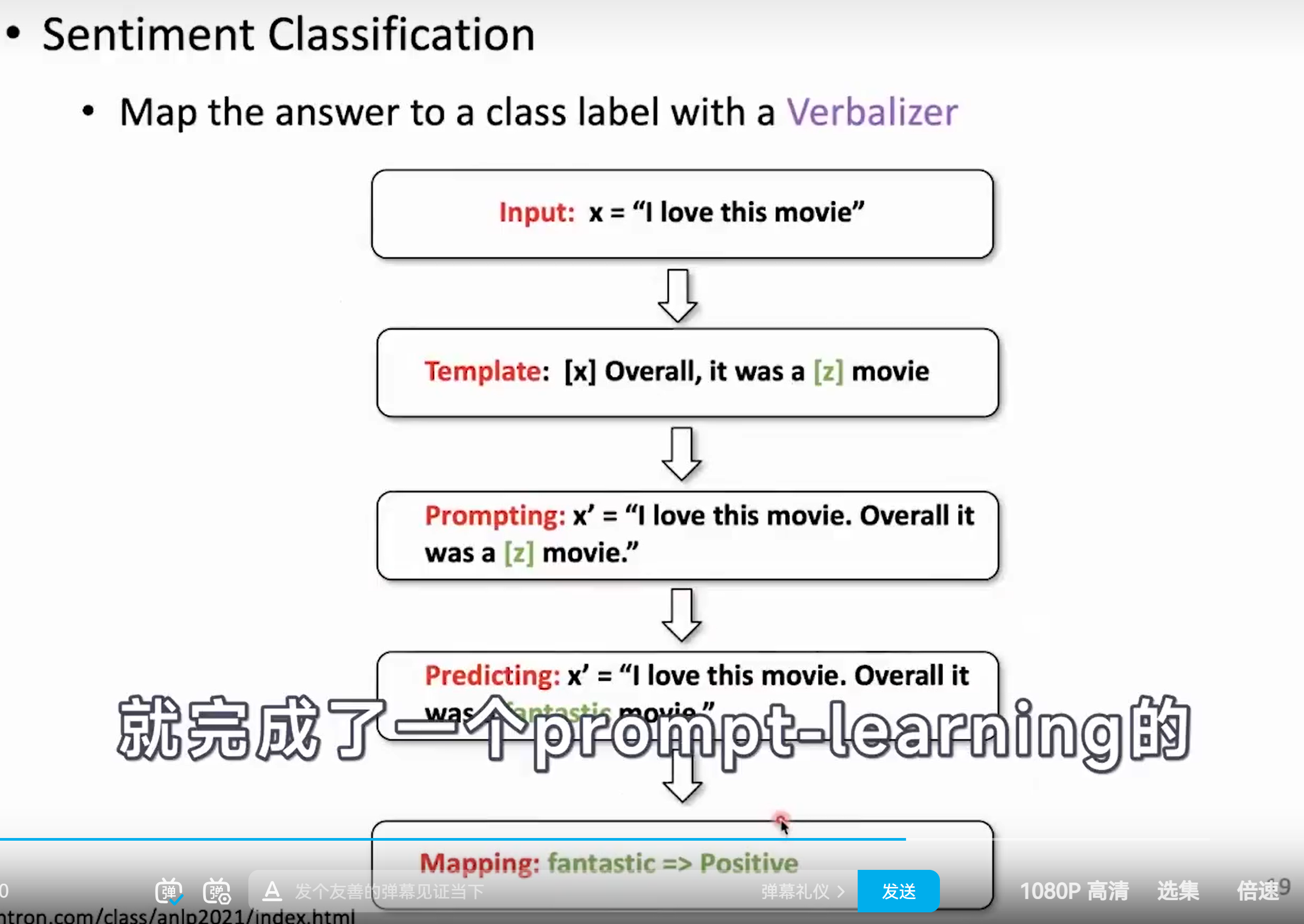

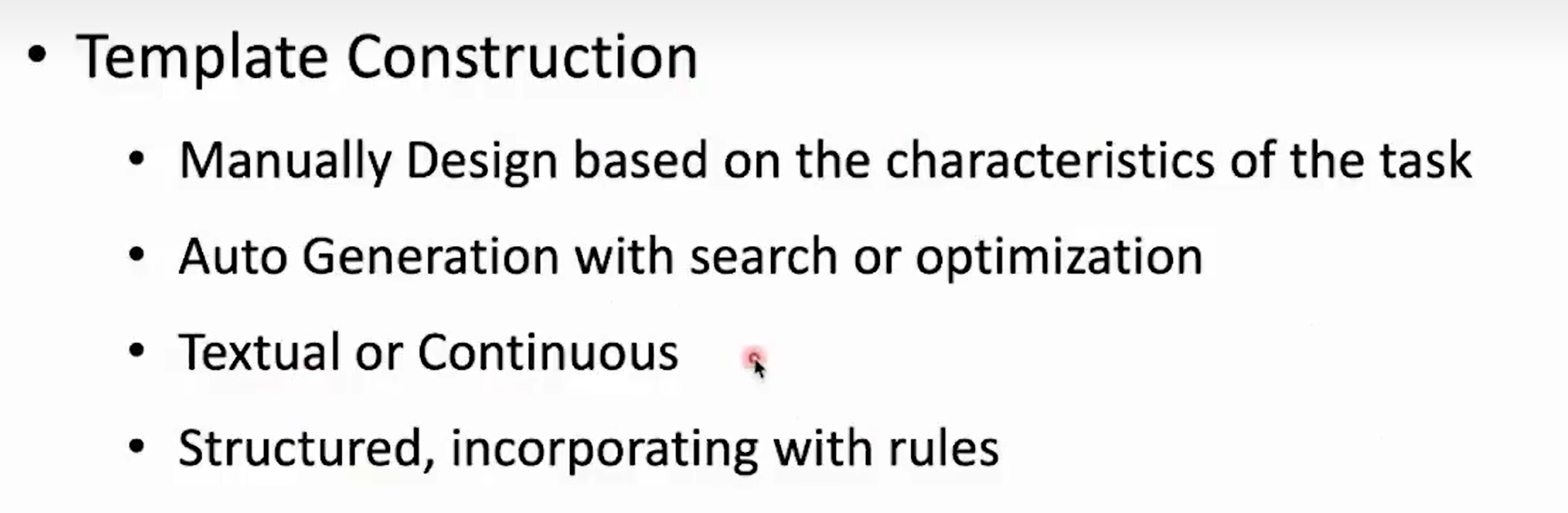

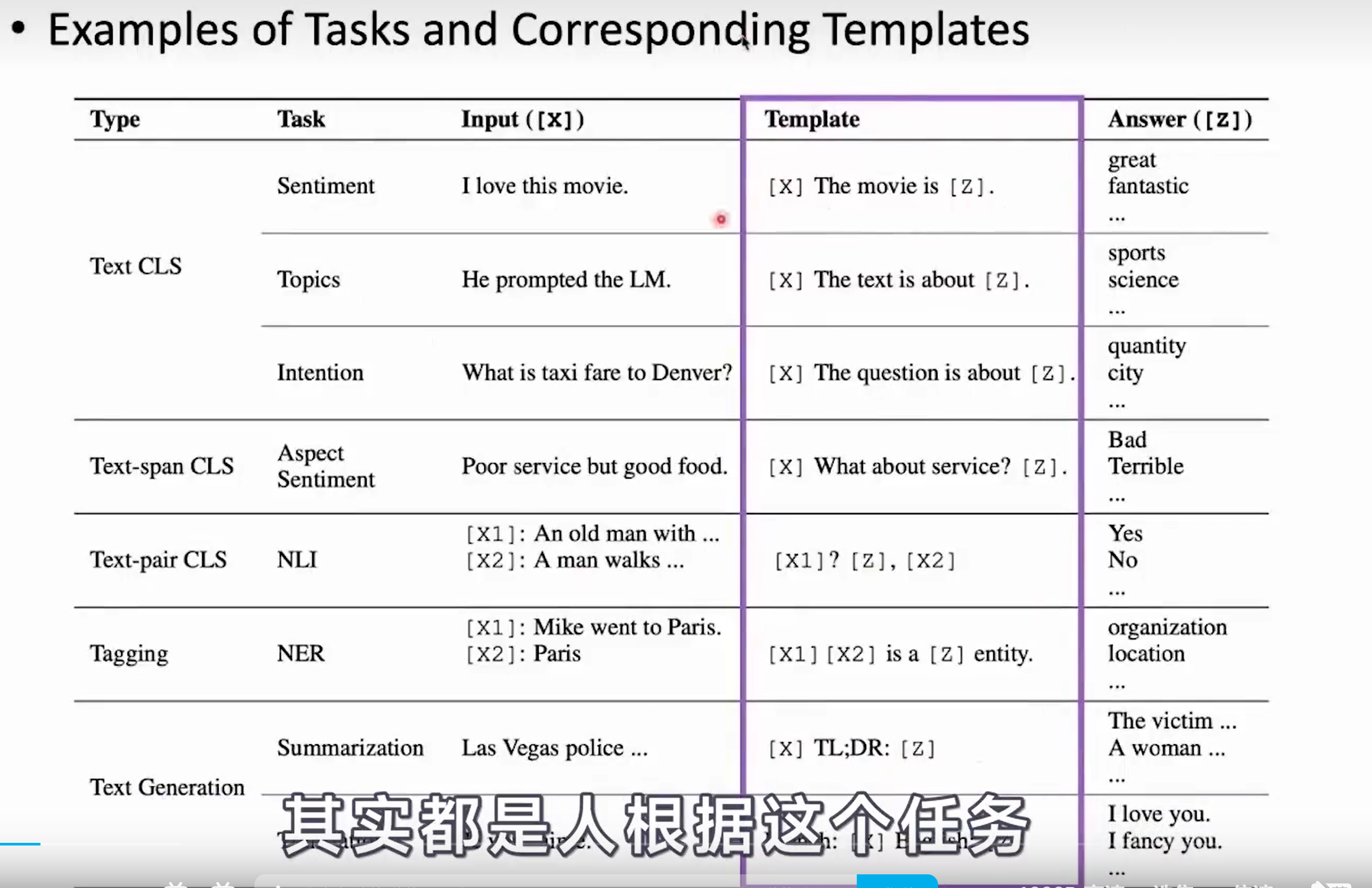

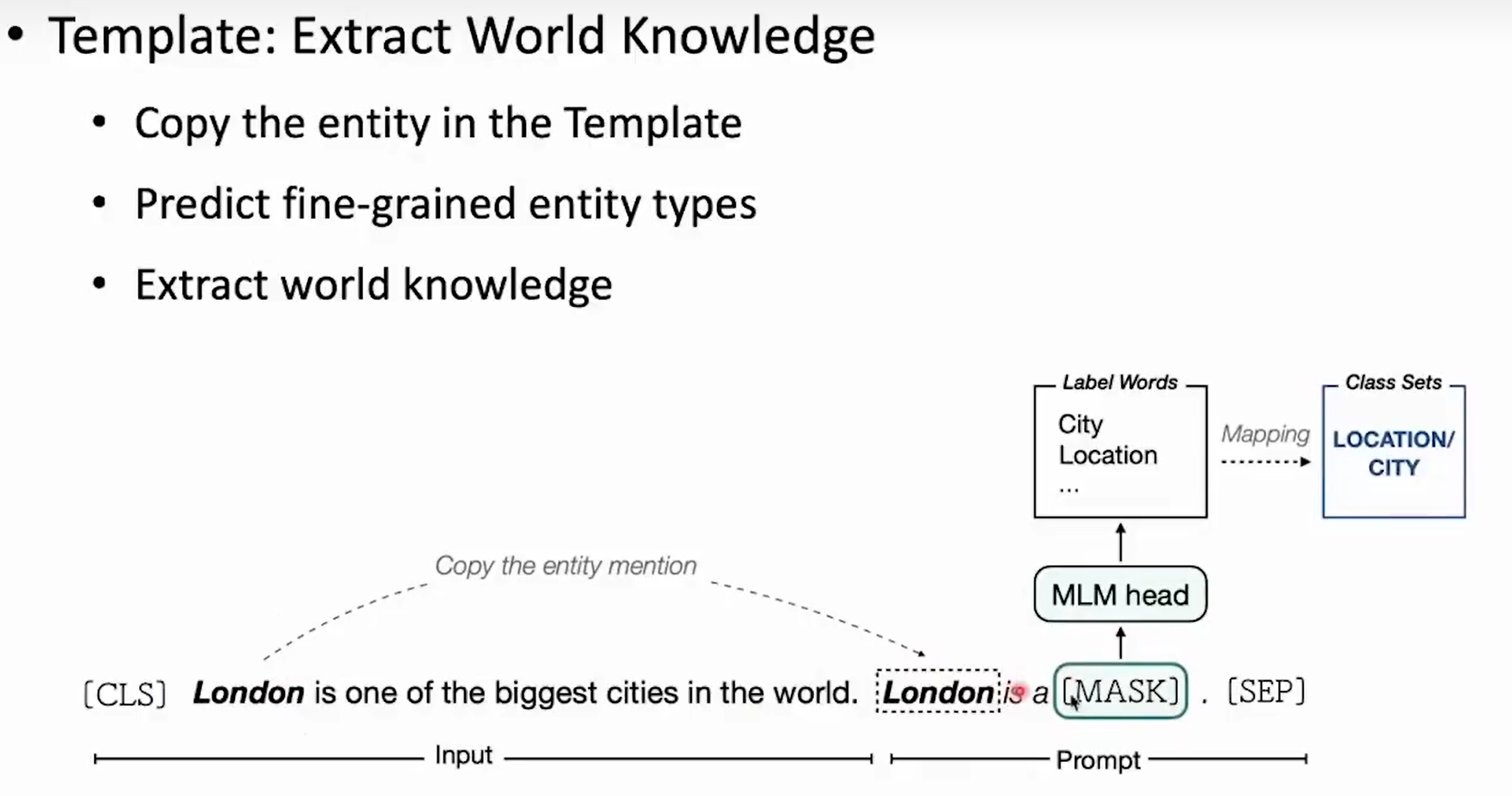

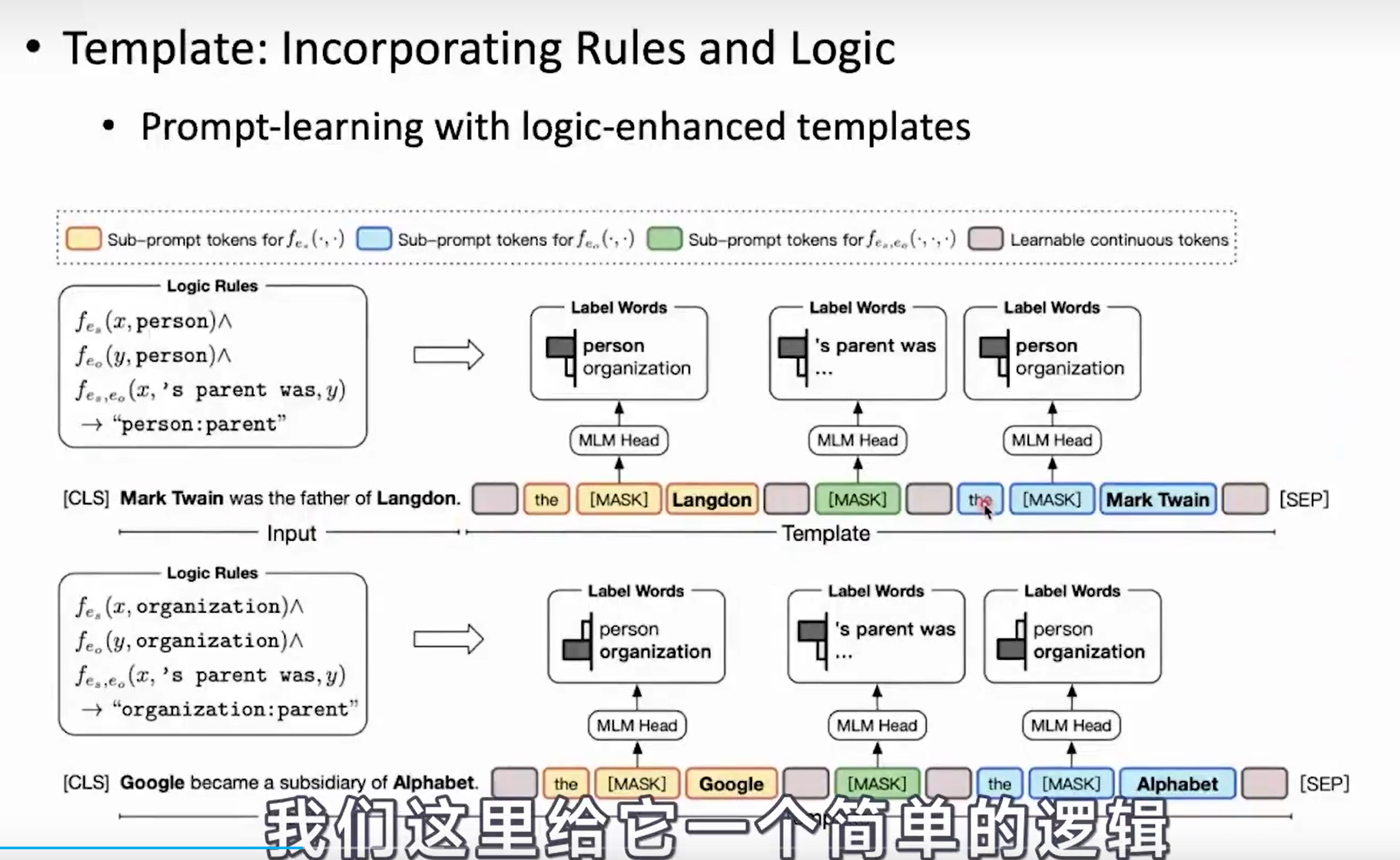

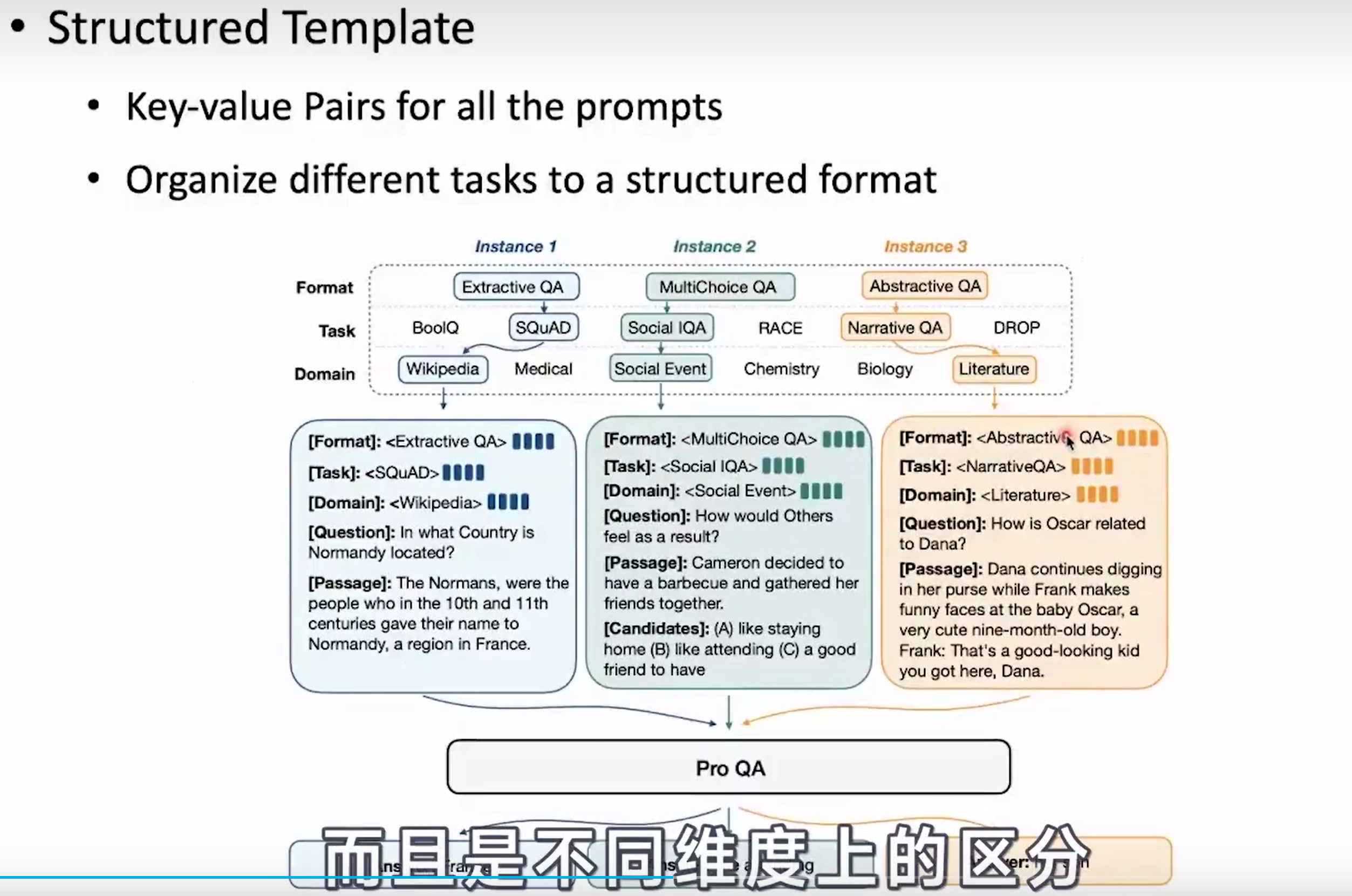

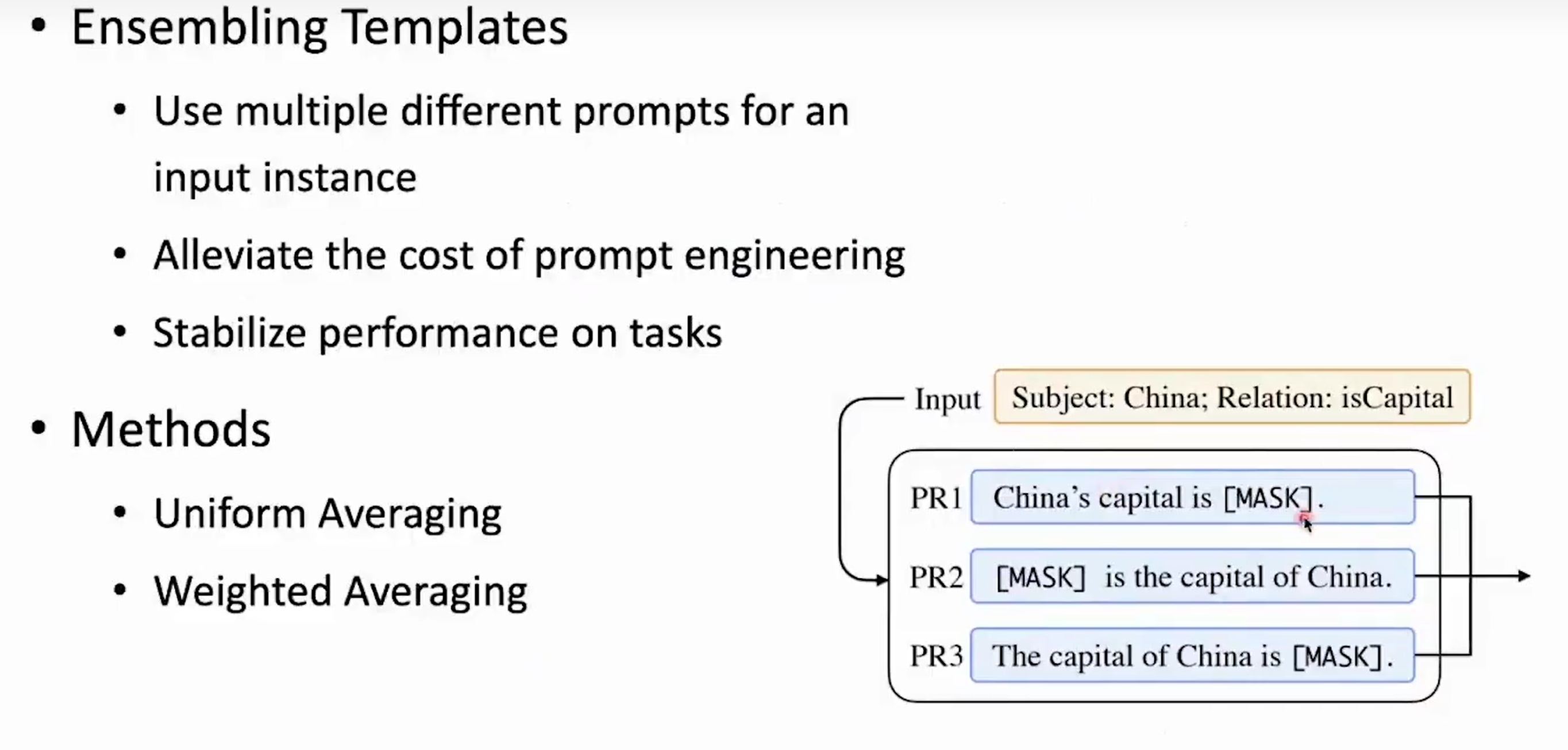

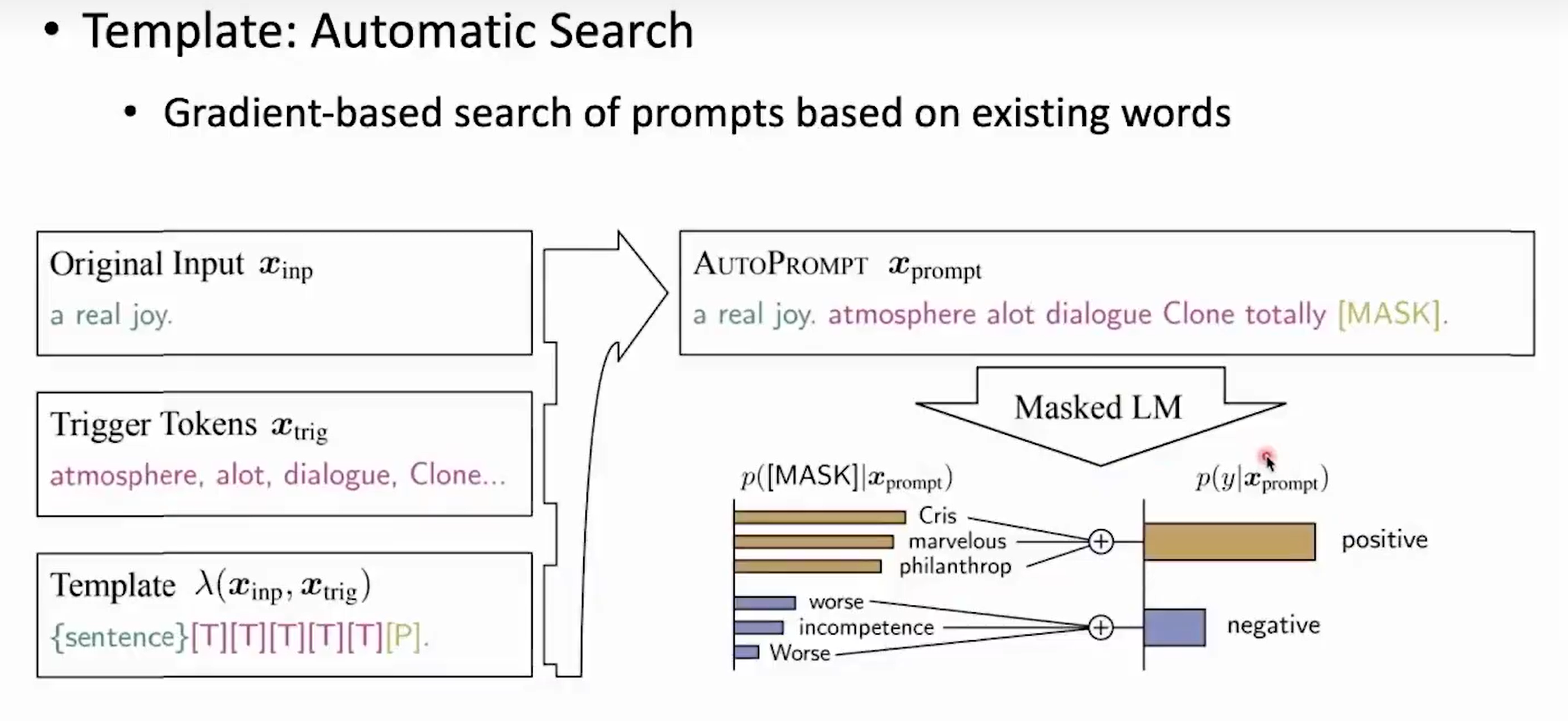

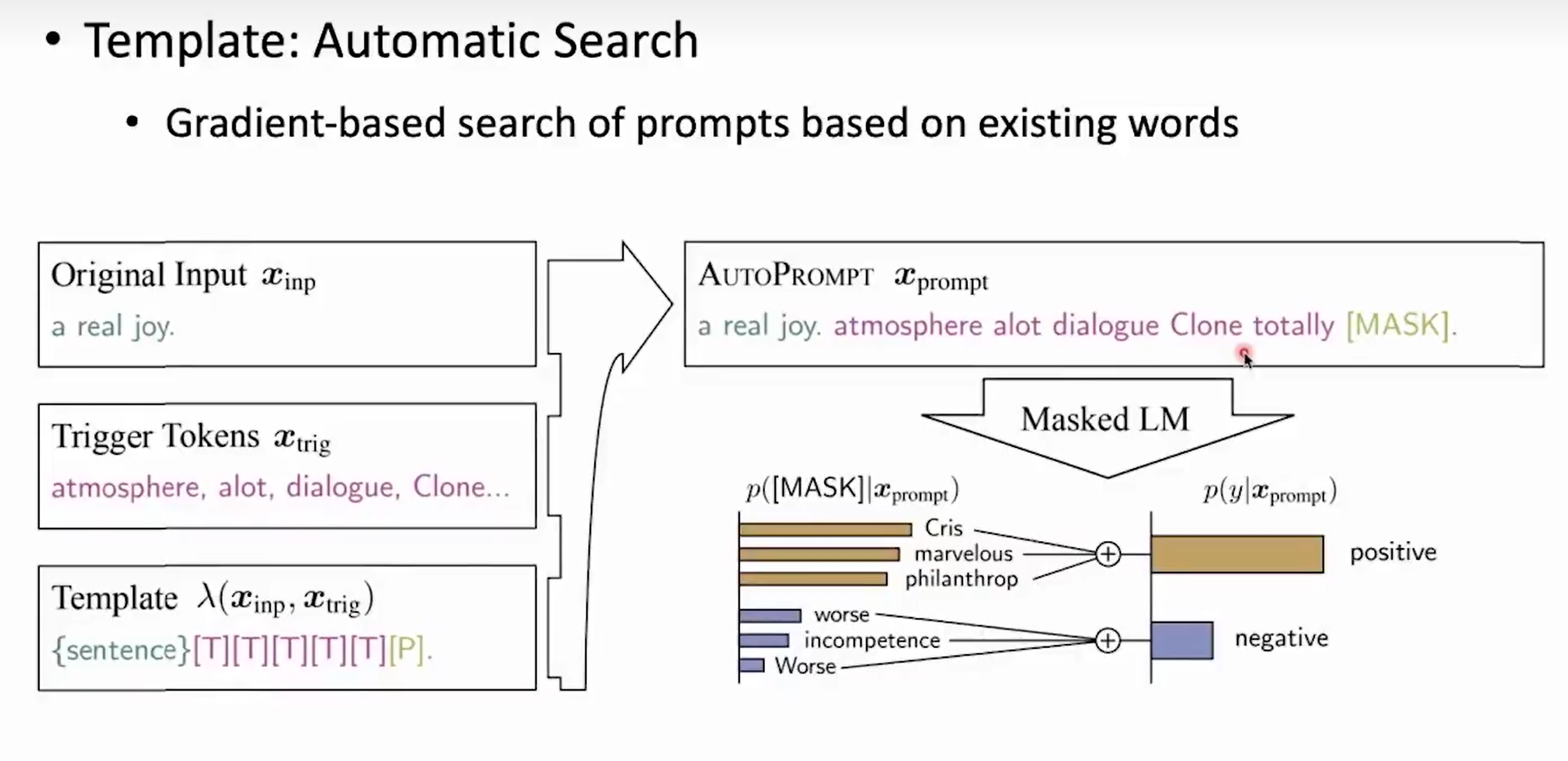

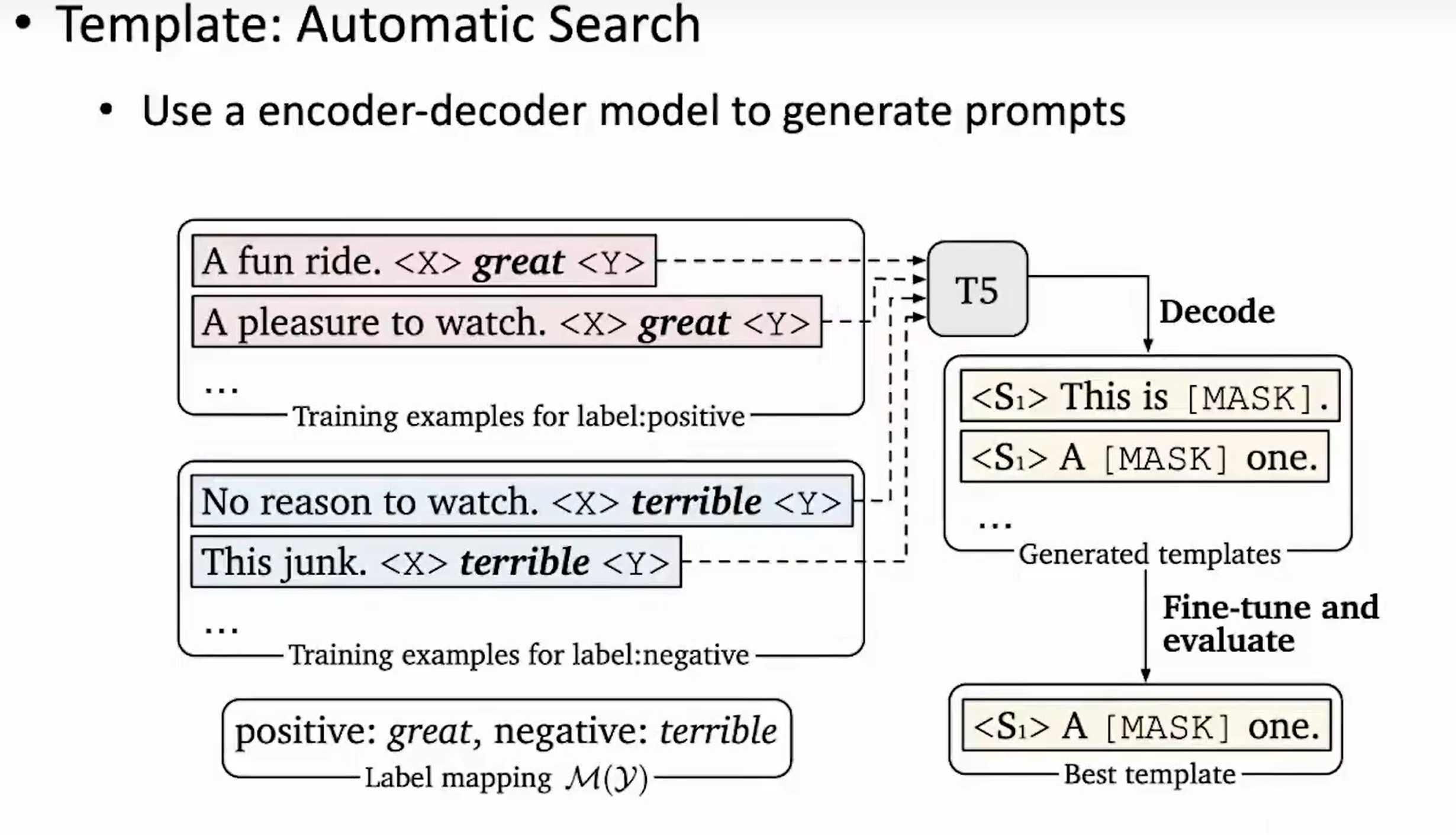

- Template (模板)

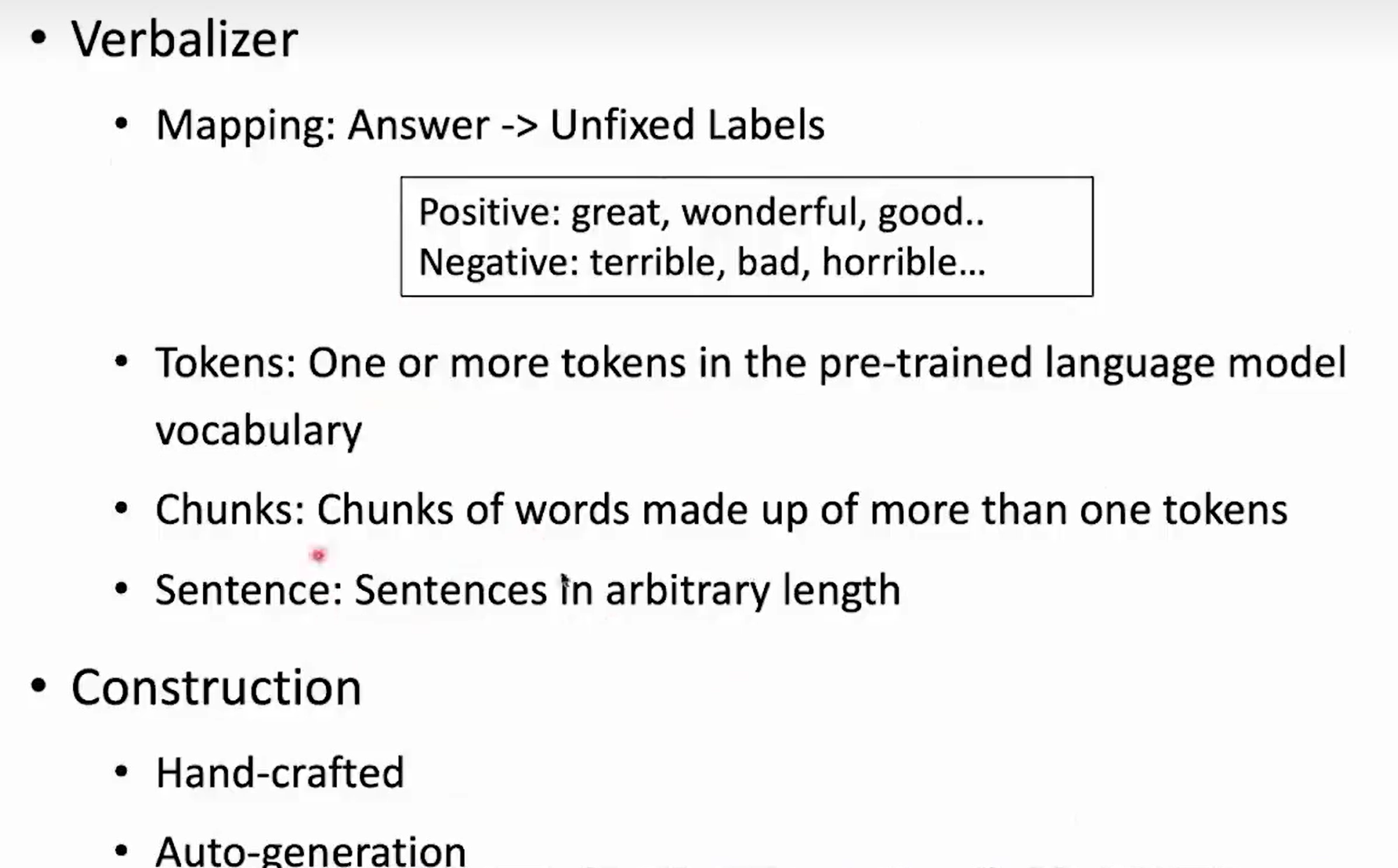

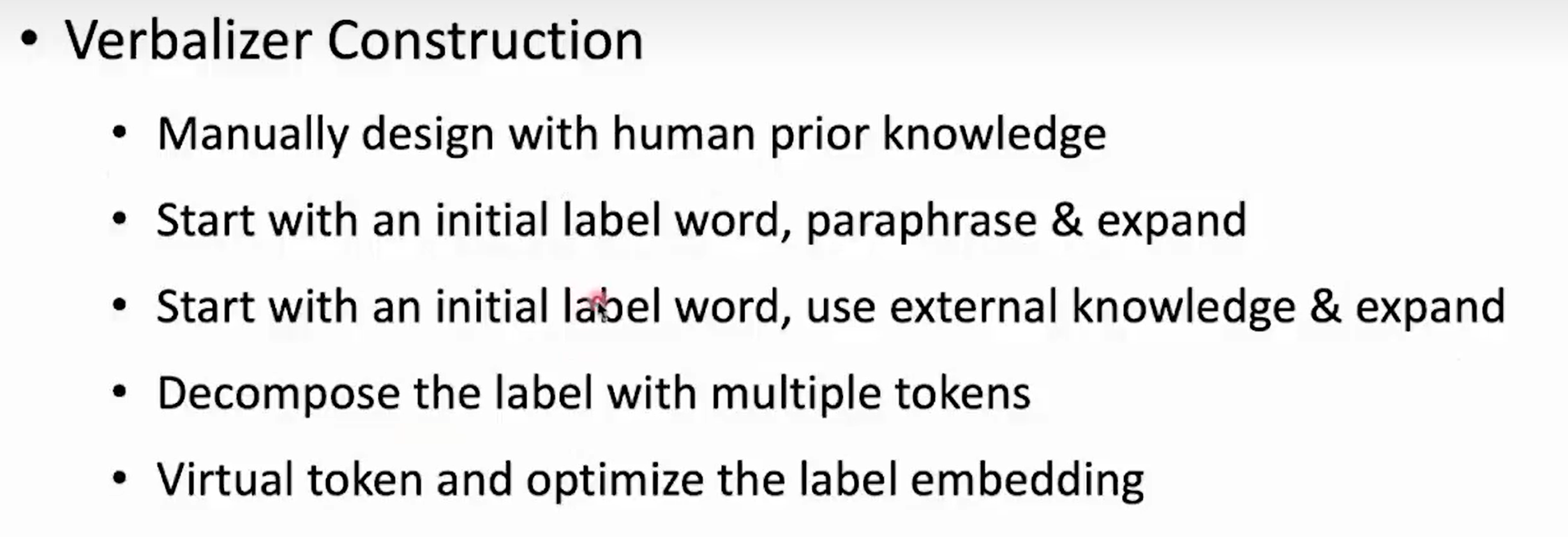

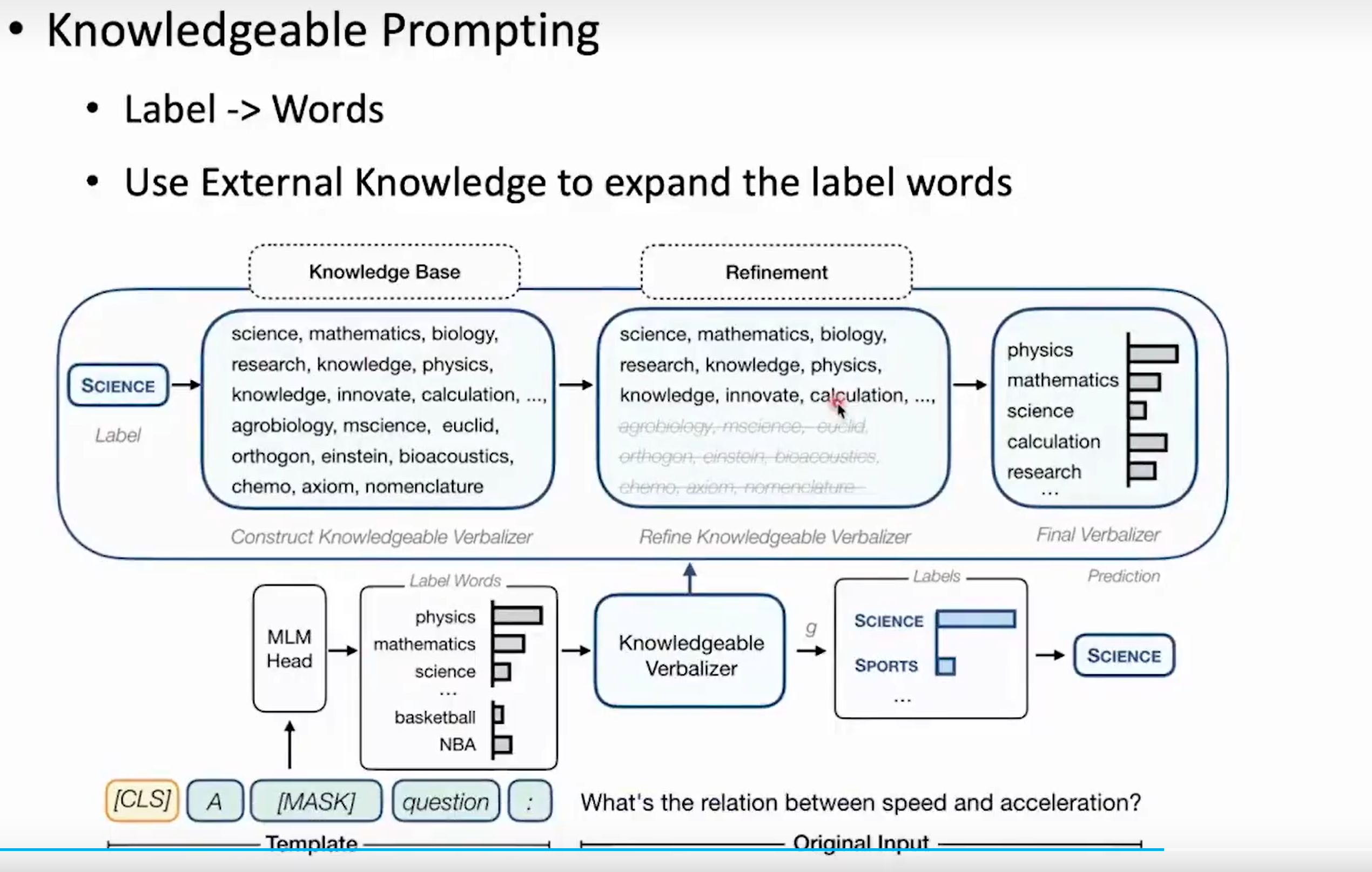

- Verbalizer

- 学习策略

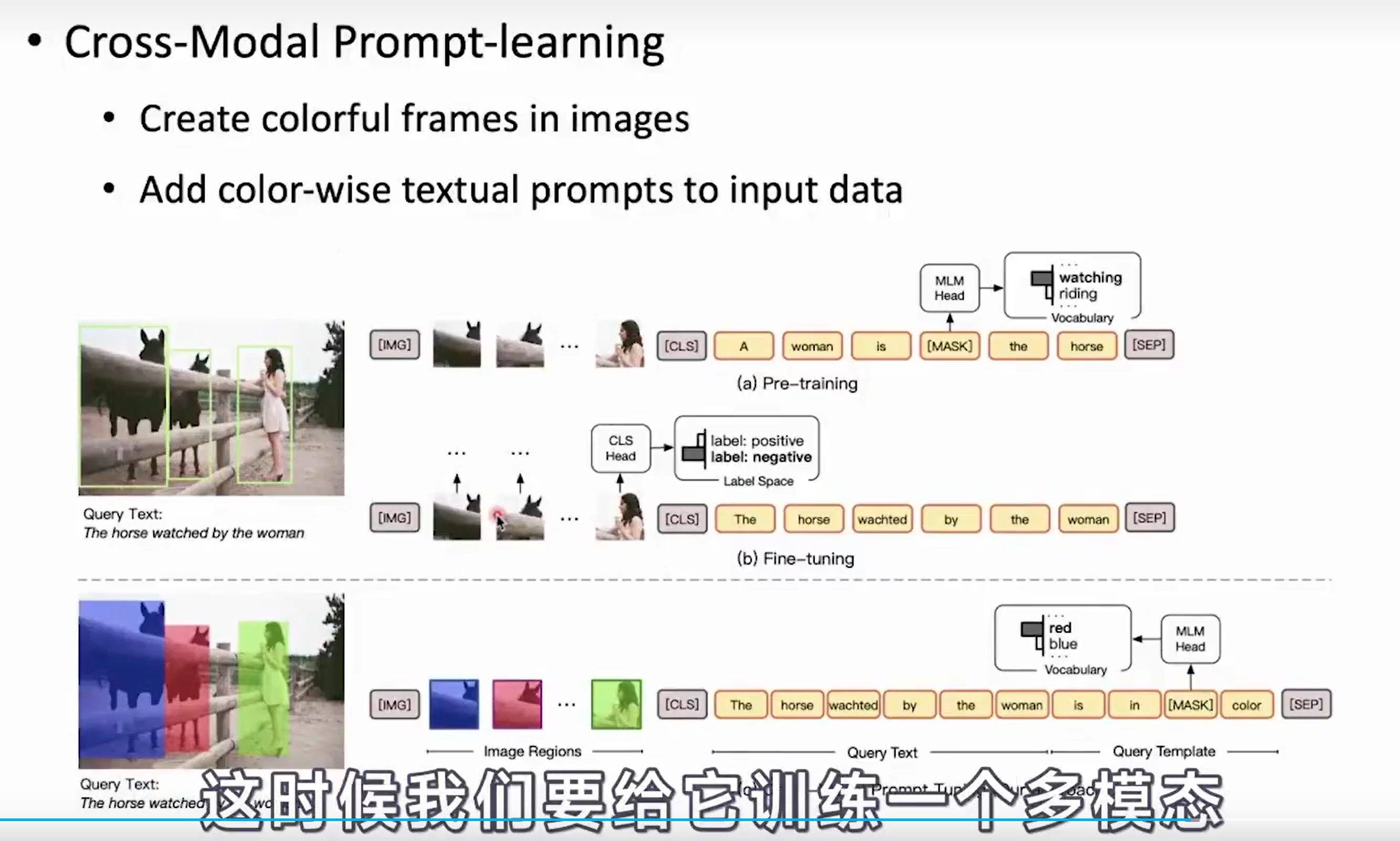

- 应用

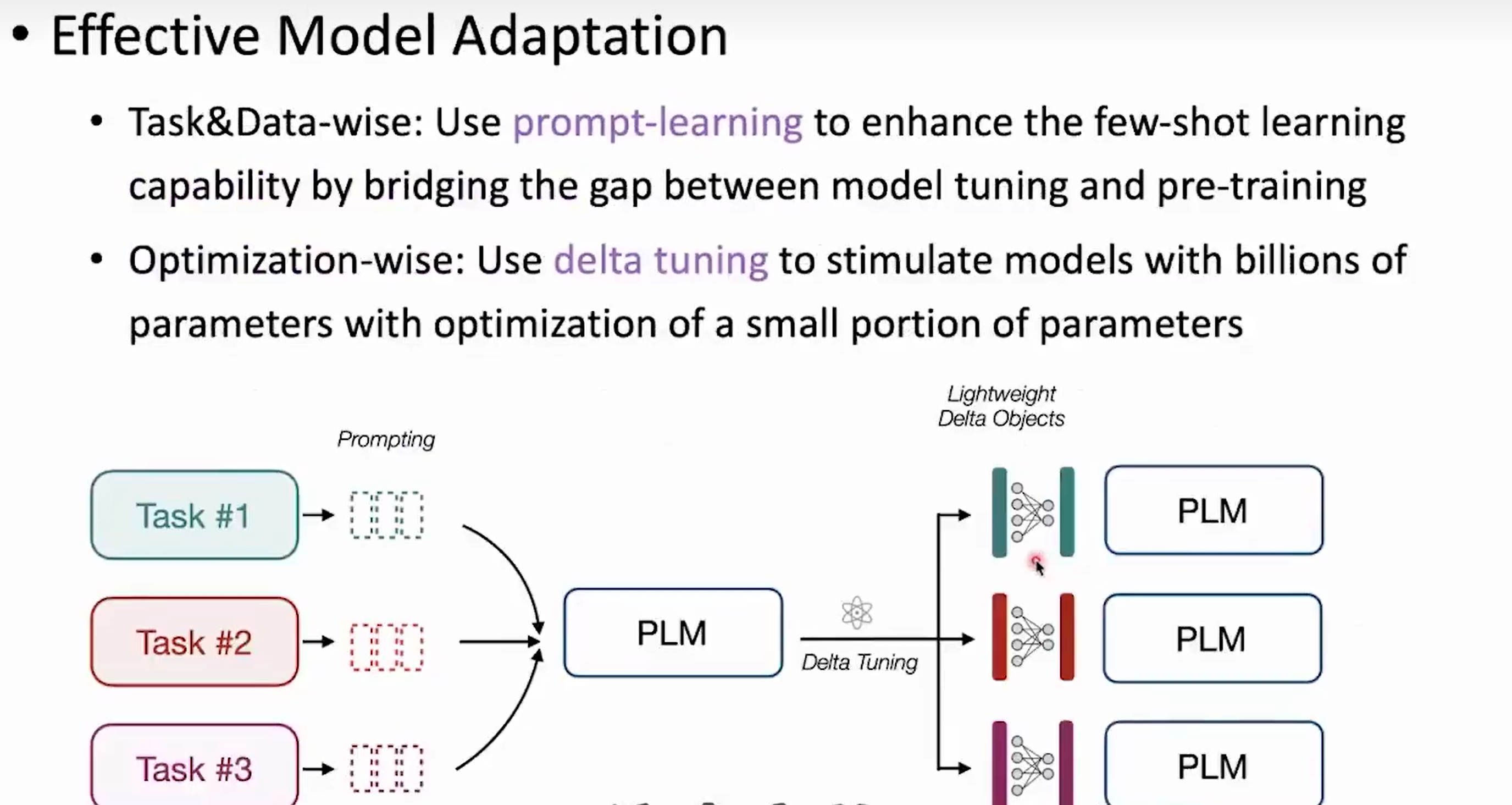

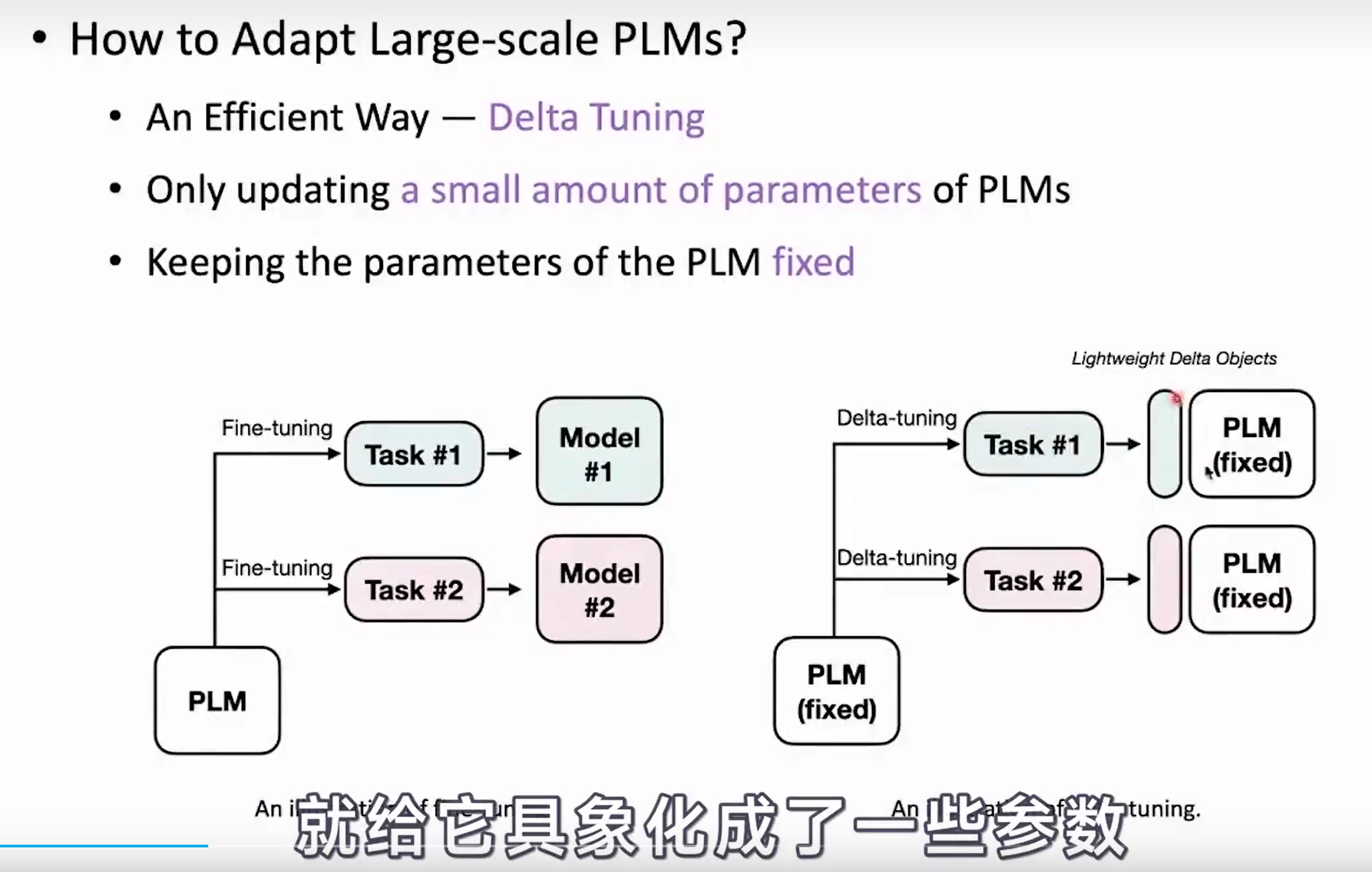

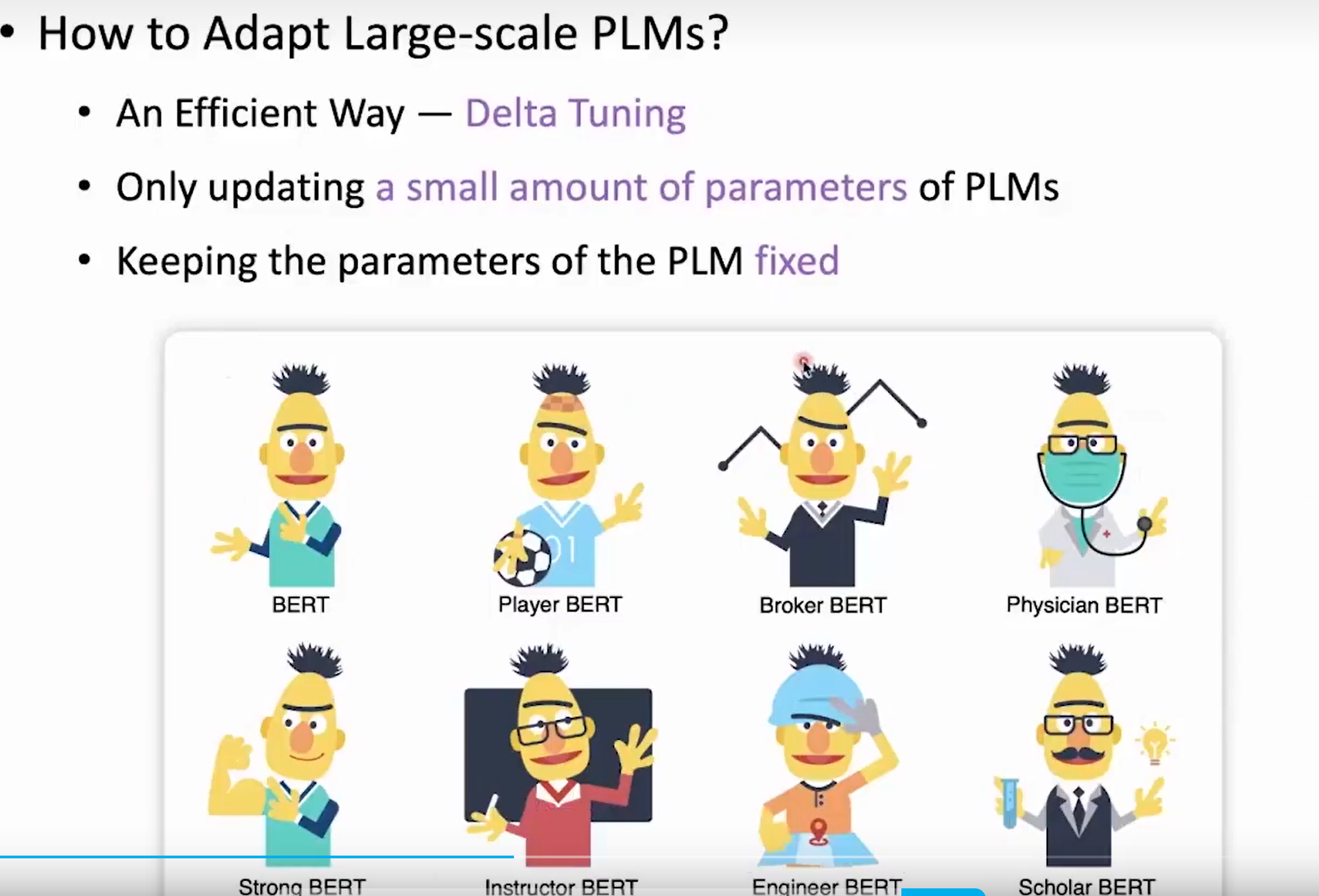

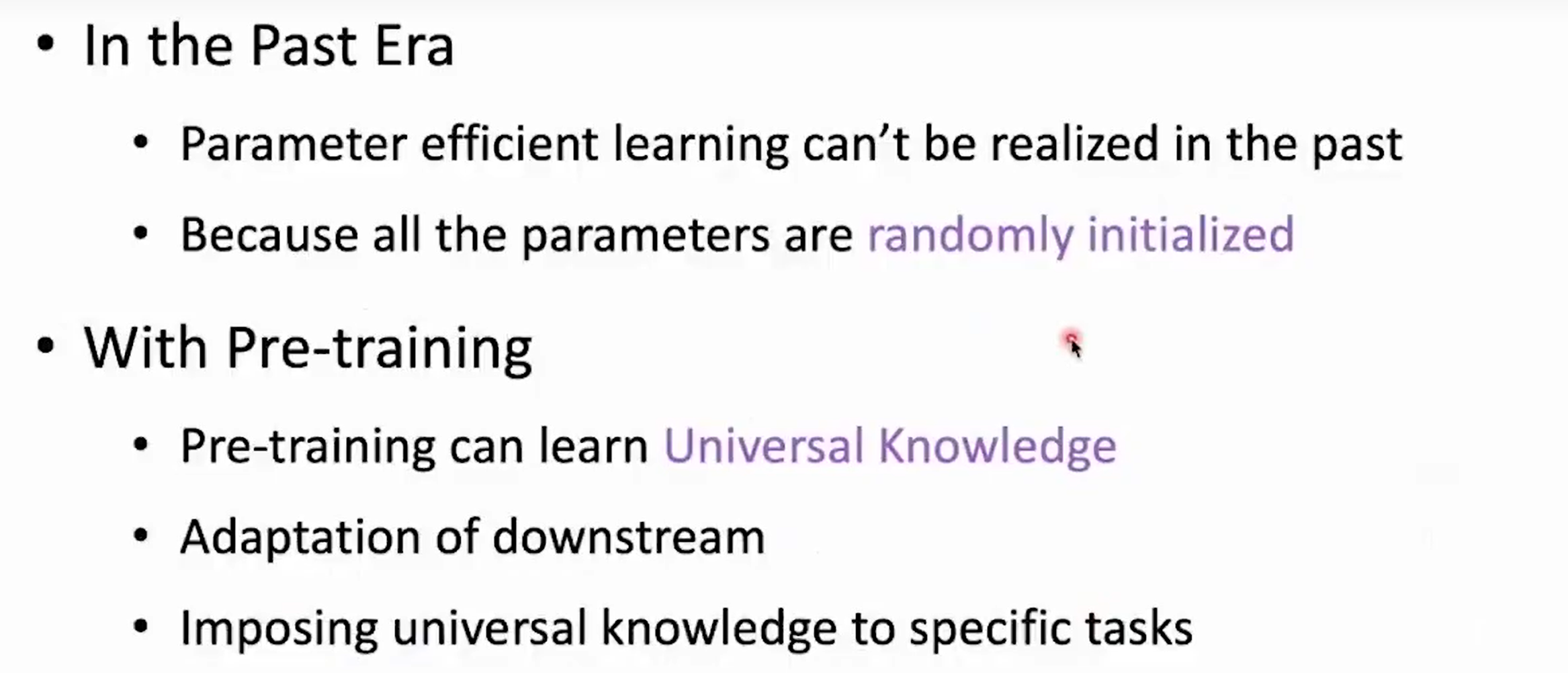

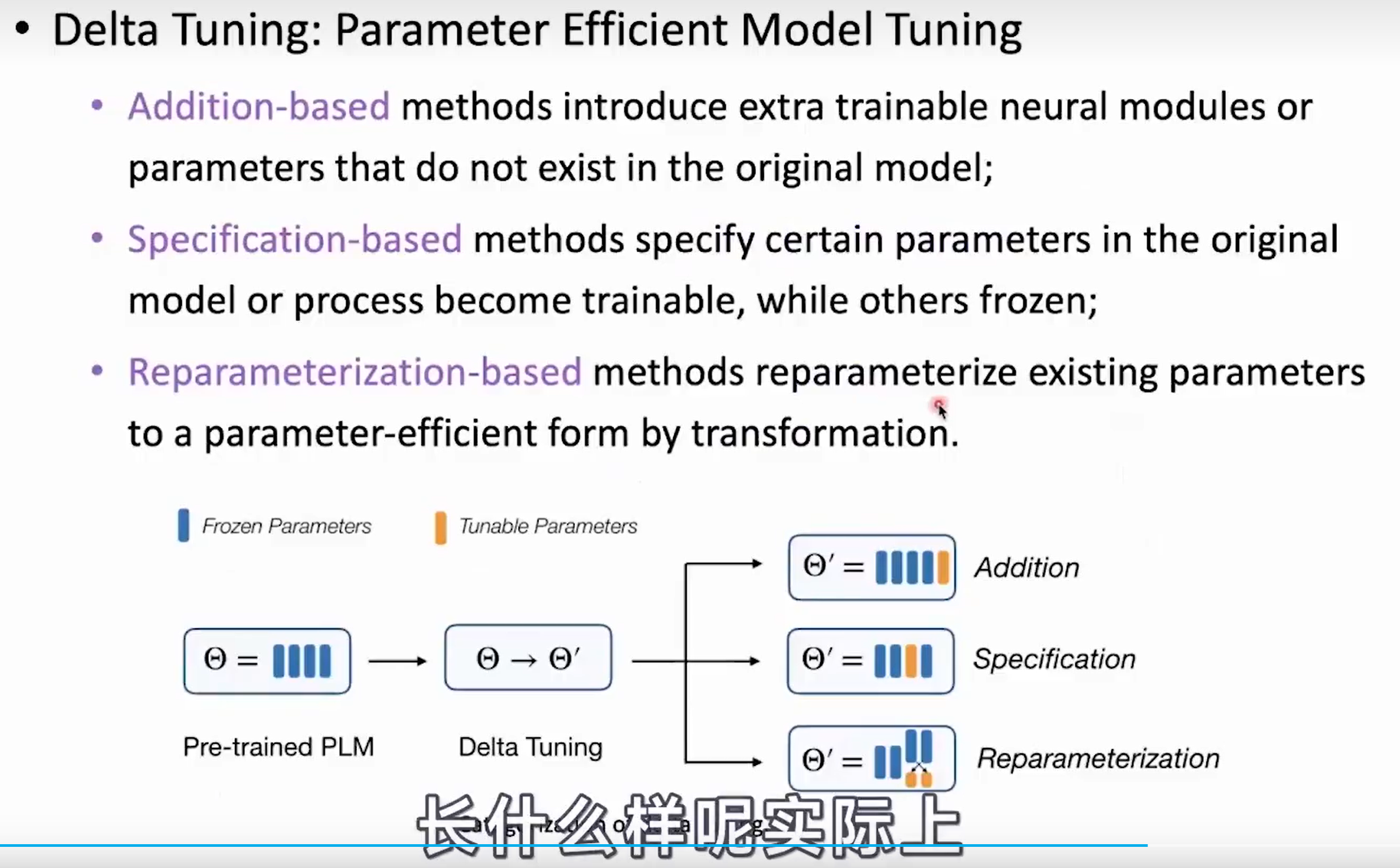

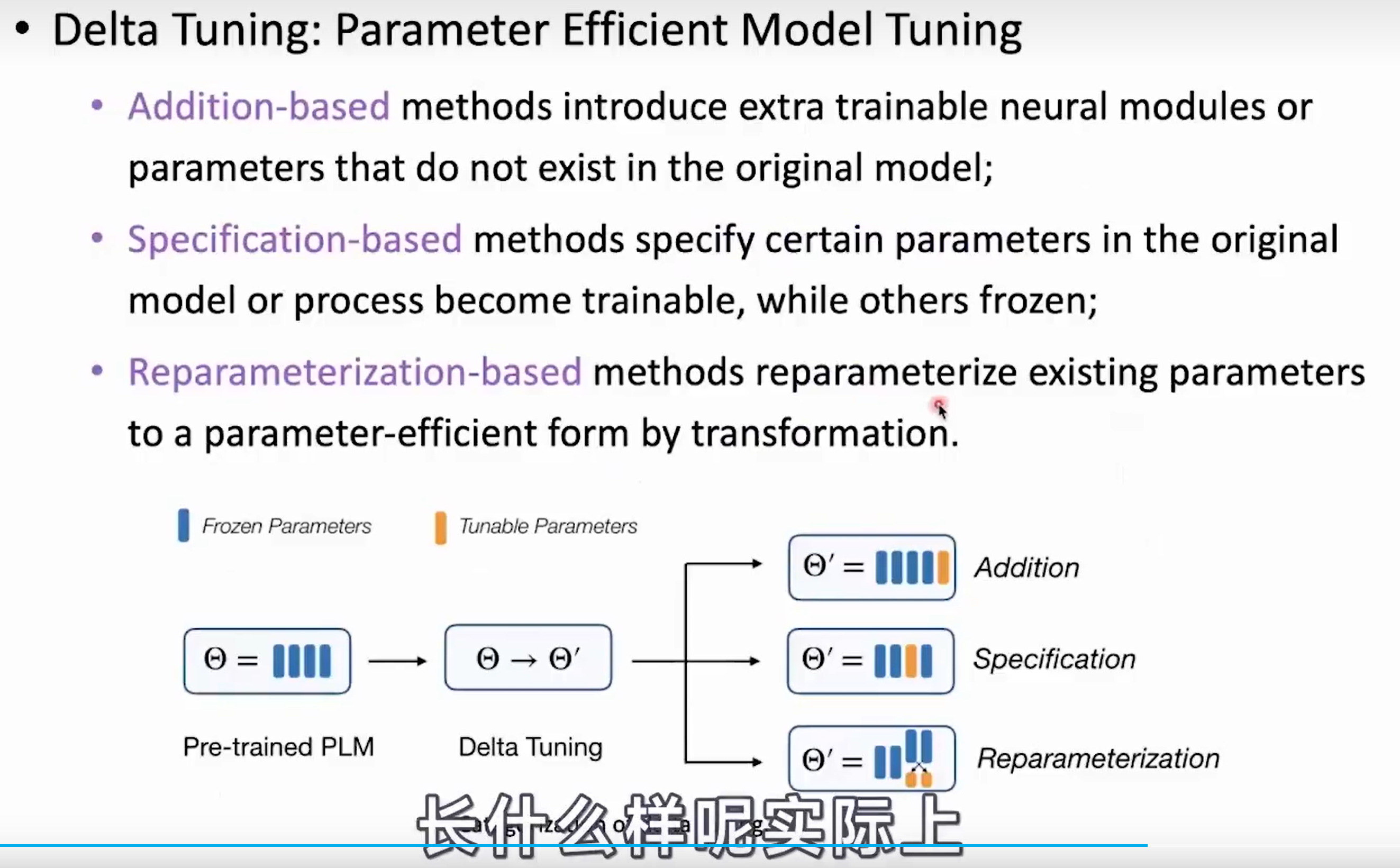

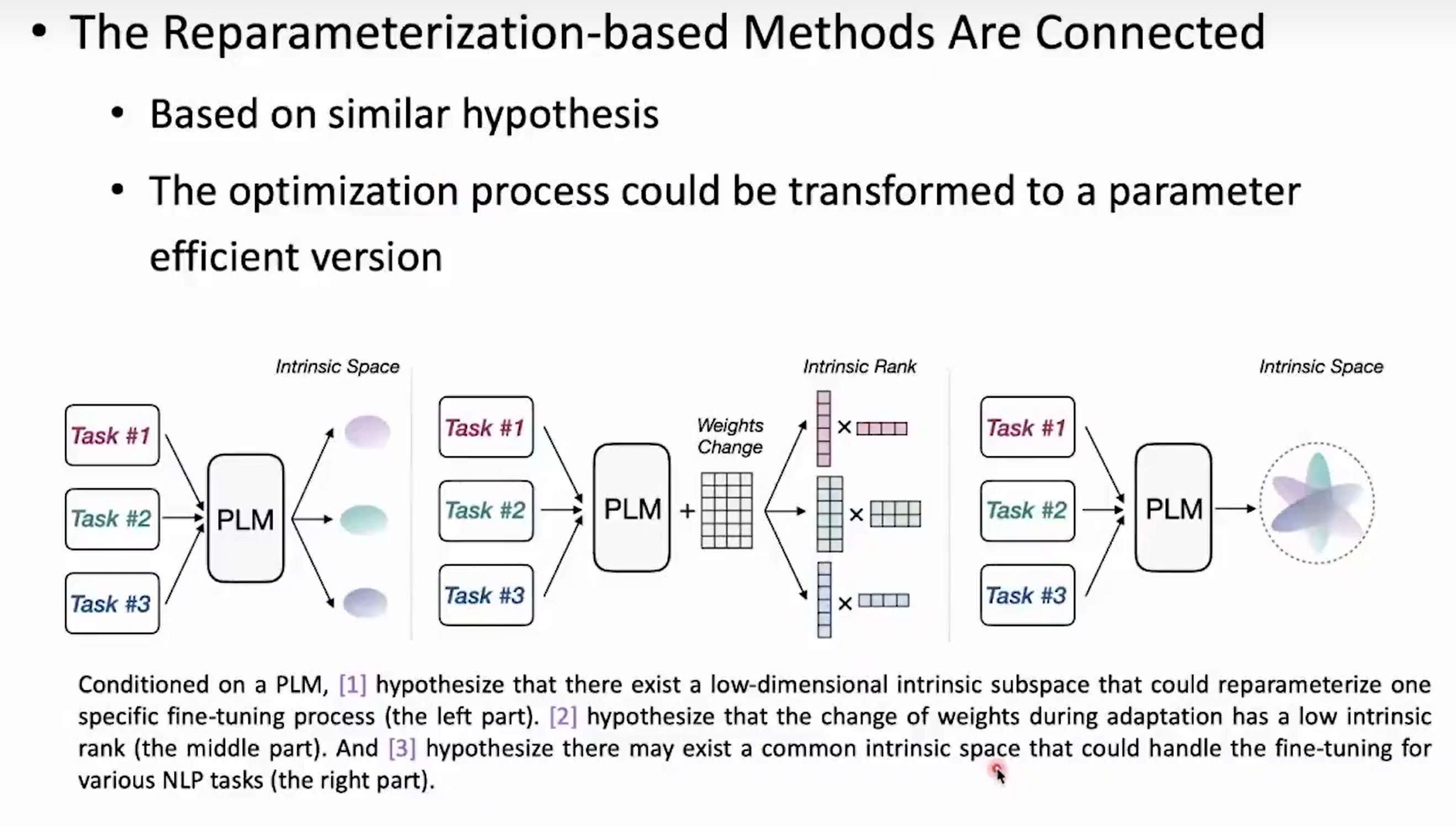

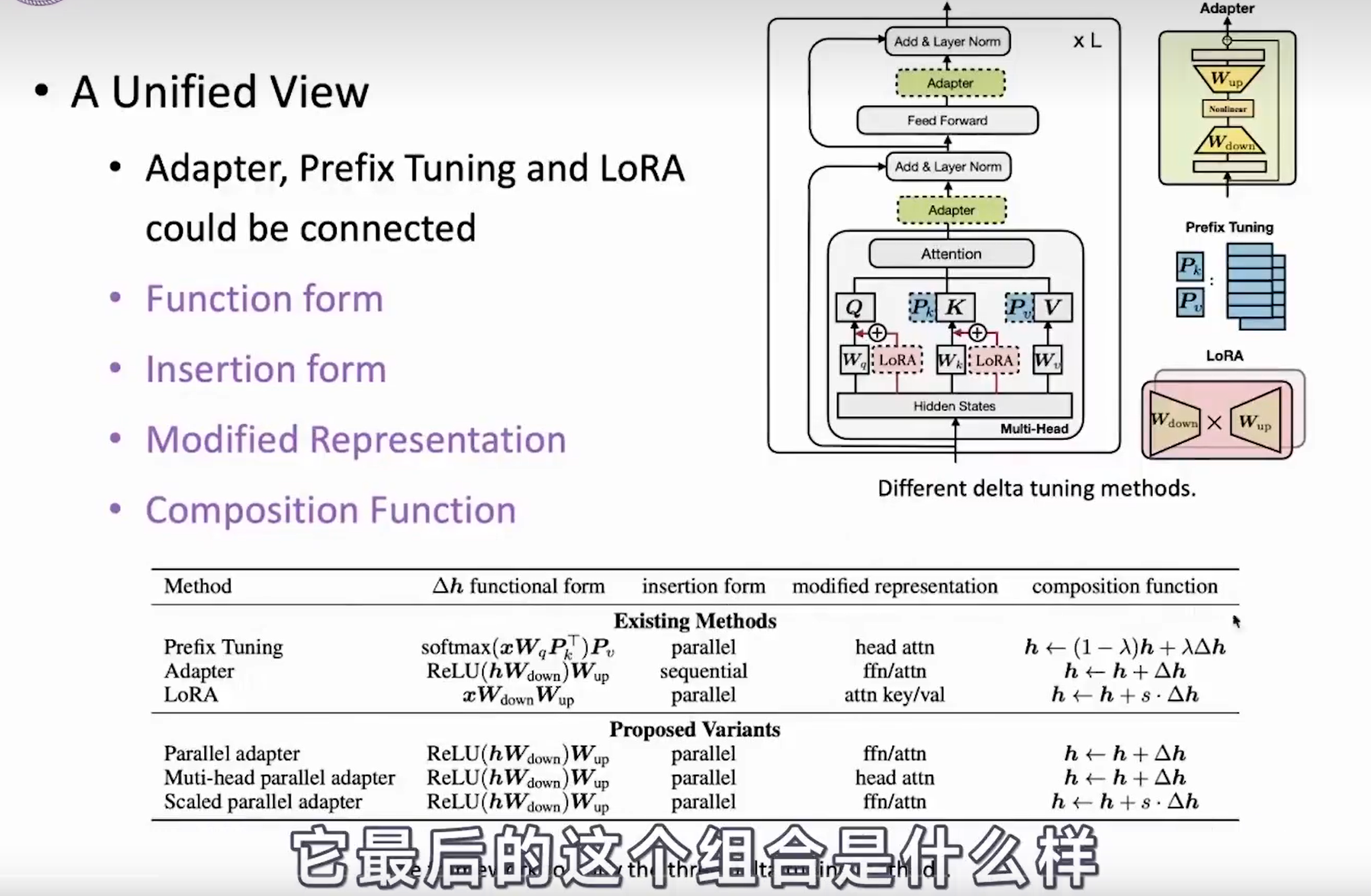

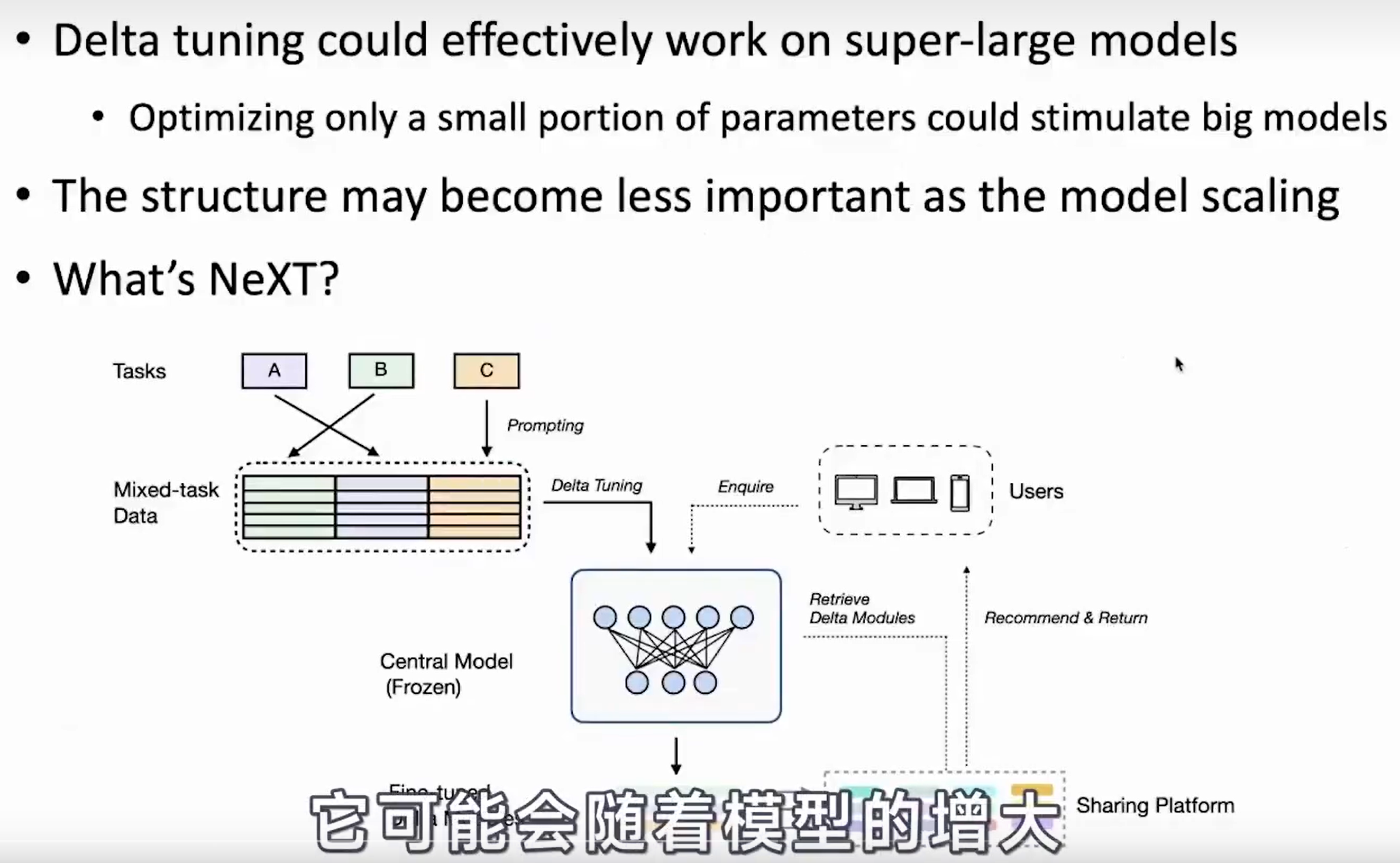

- Delta Tuning

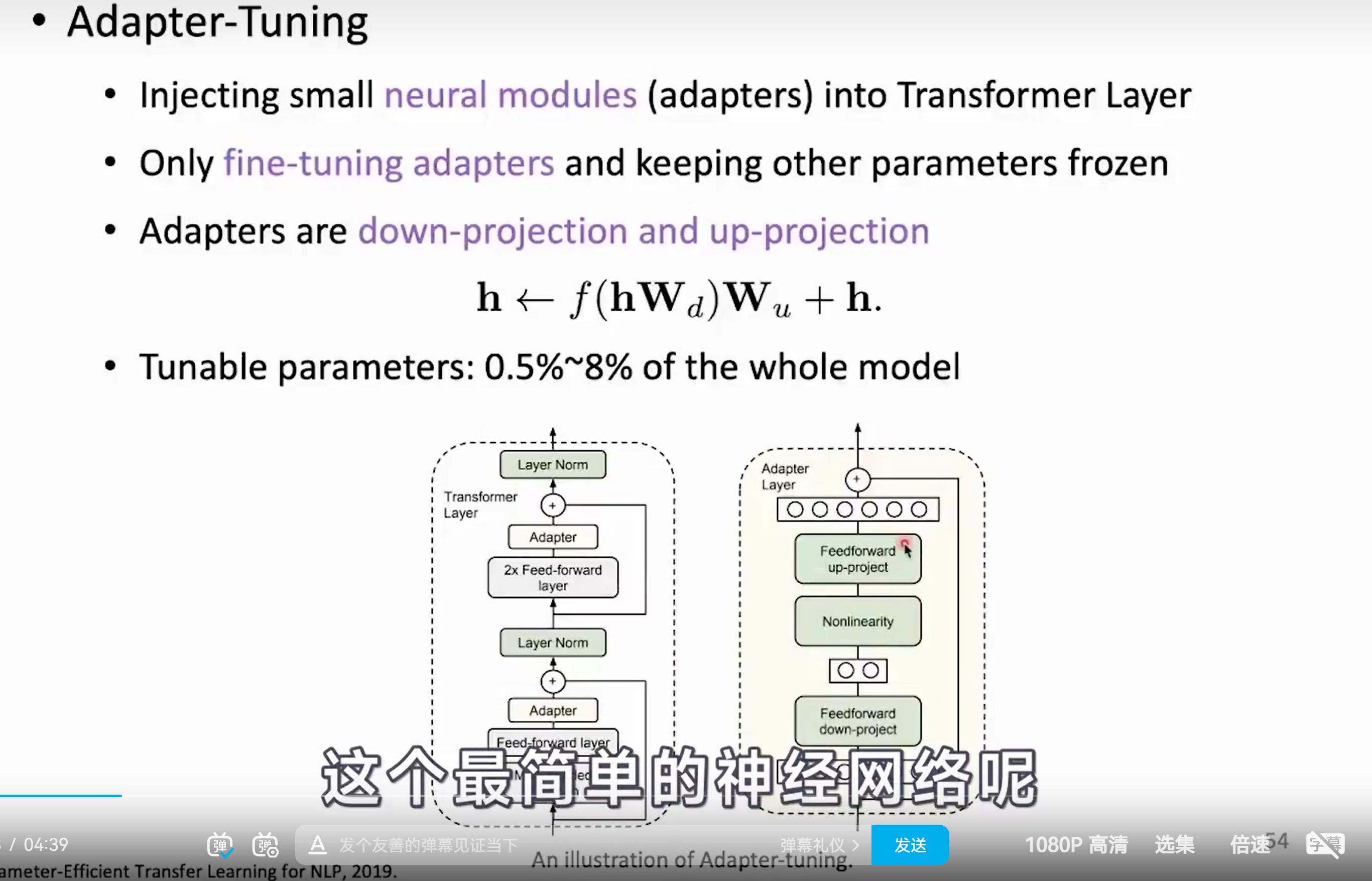

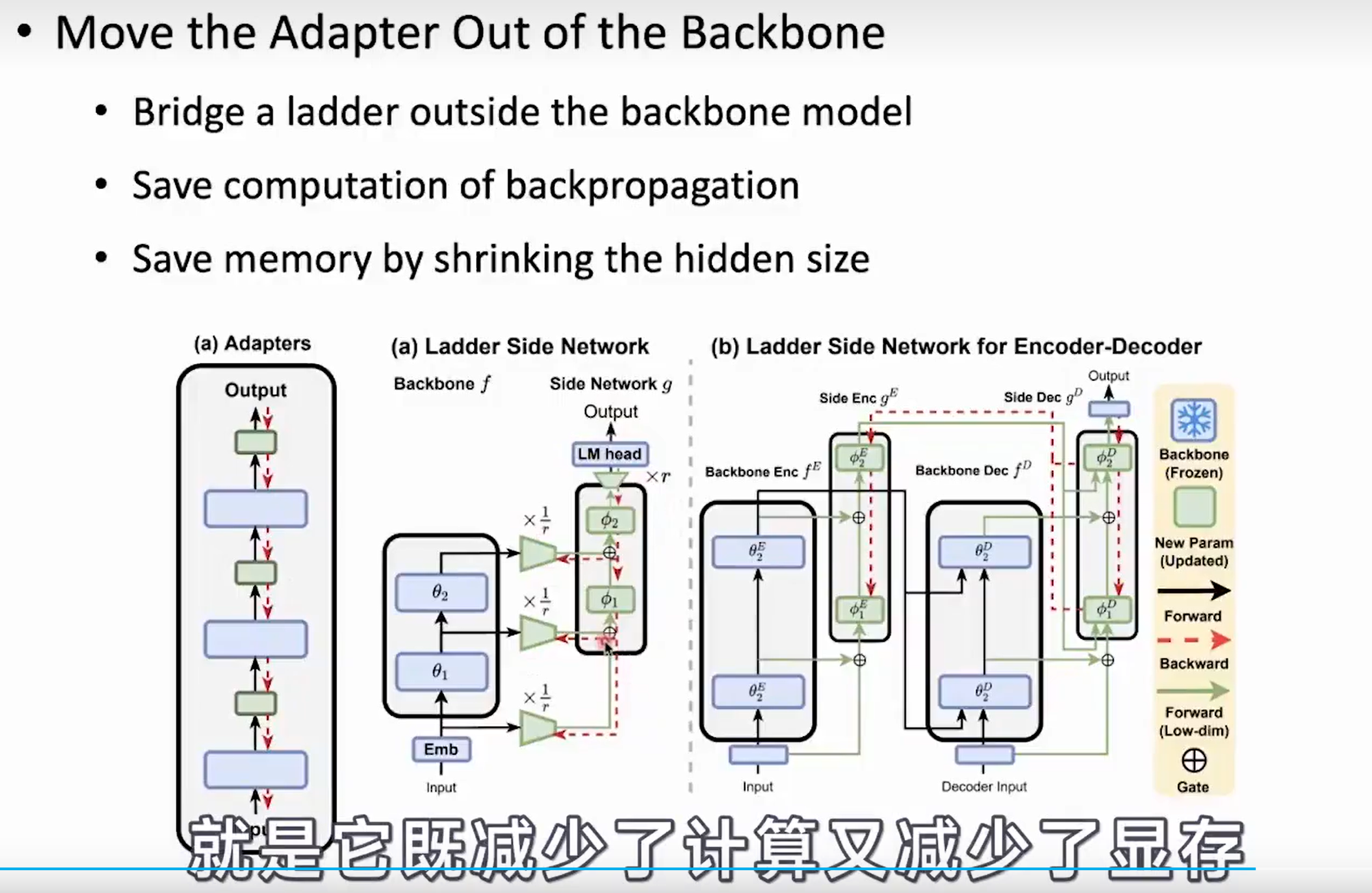

- Adapter-Tuning

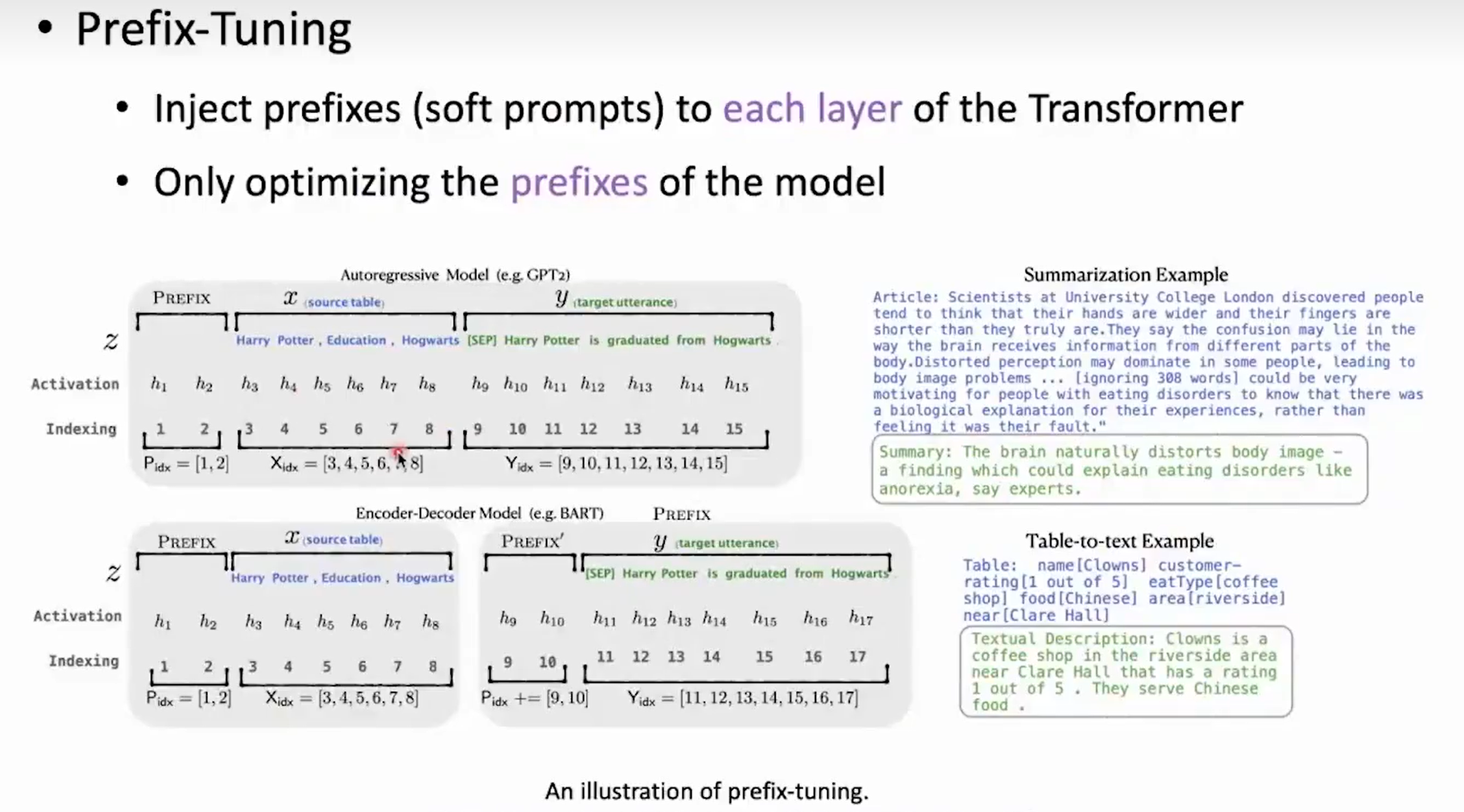

- Prefix-Tuning

-

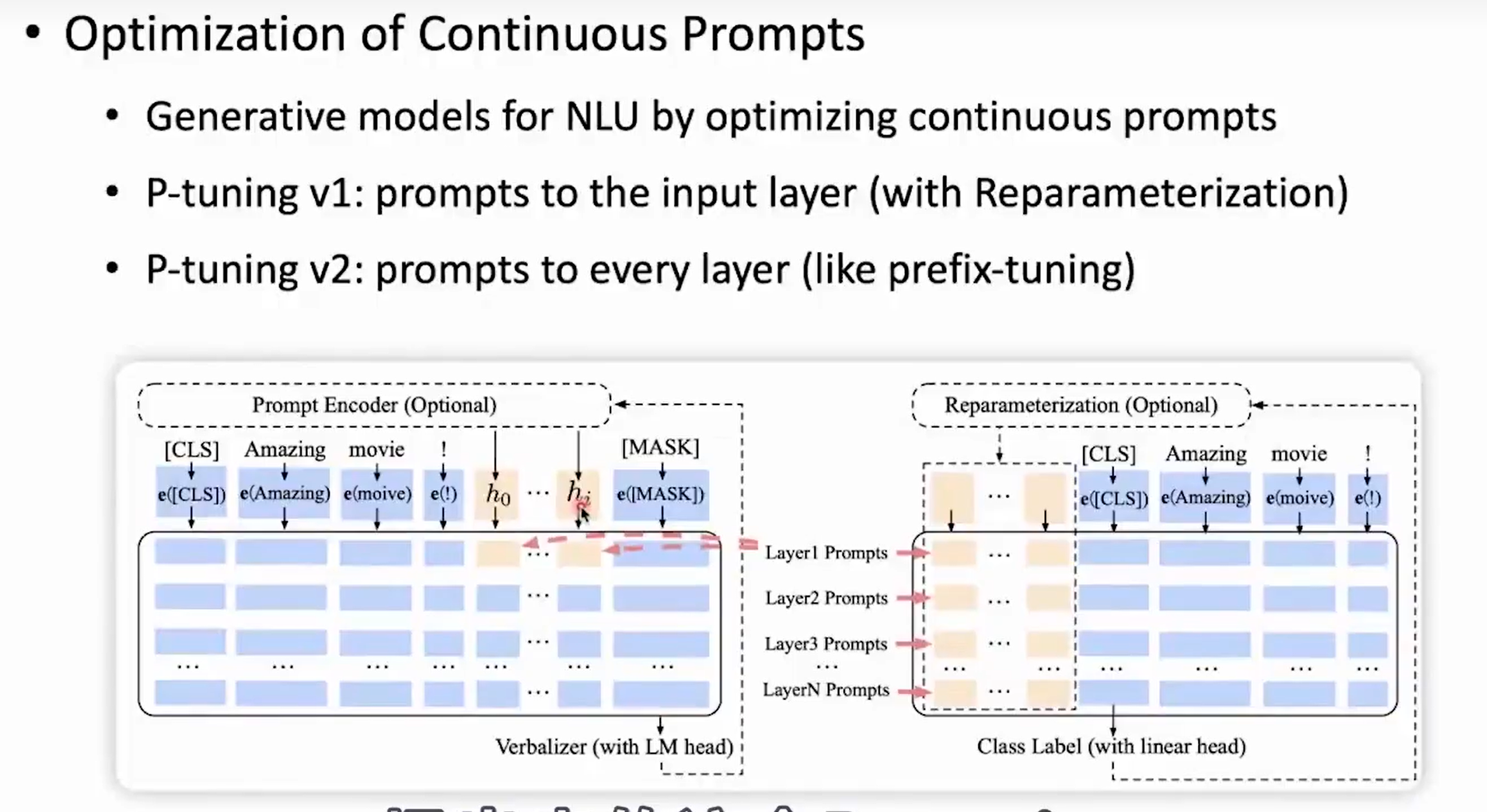

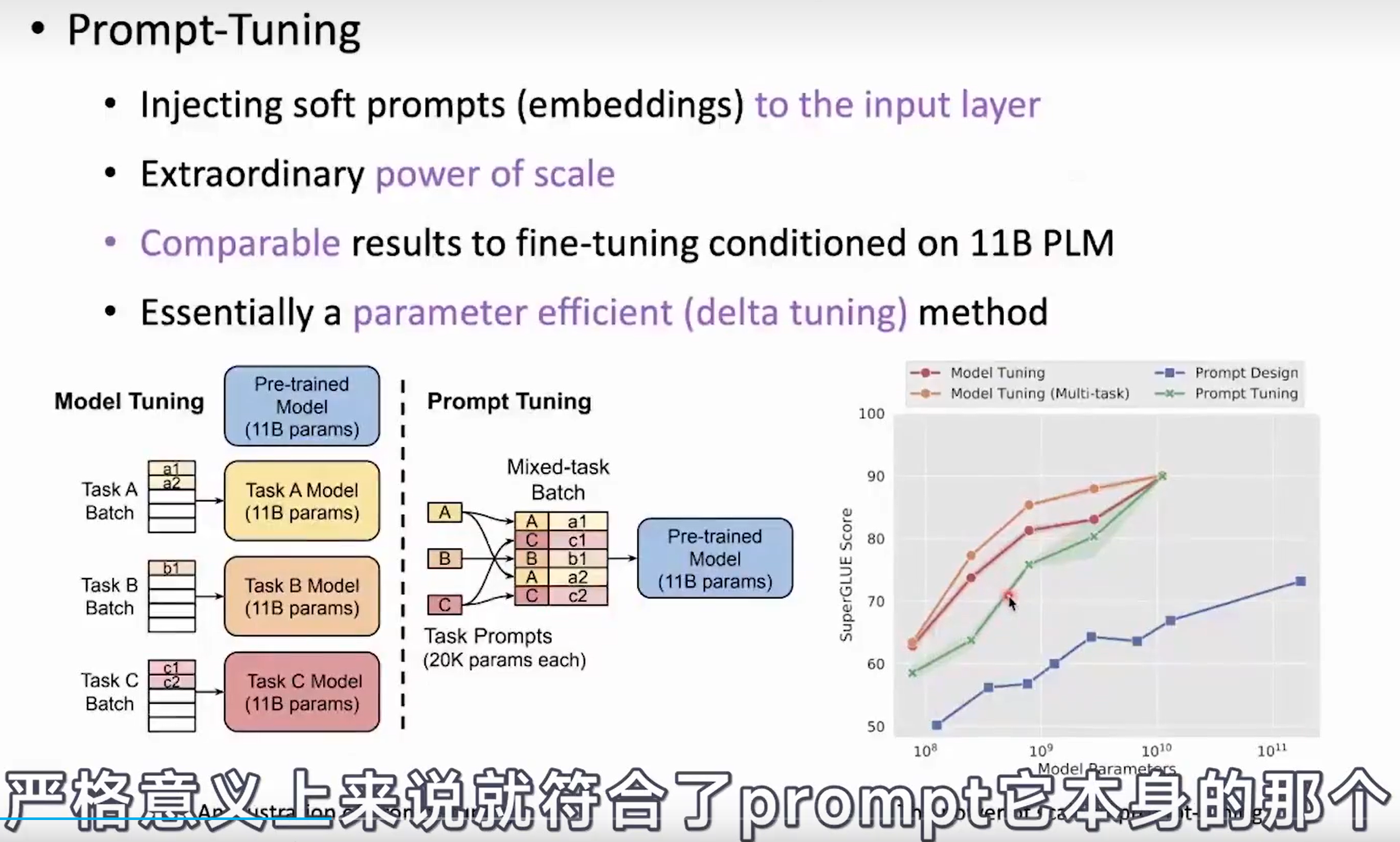

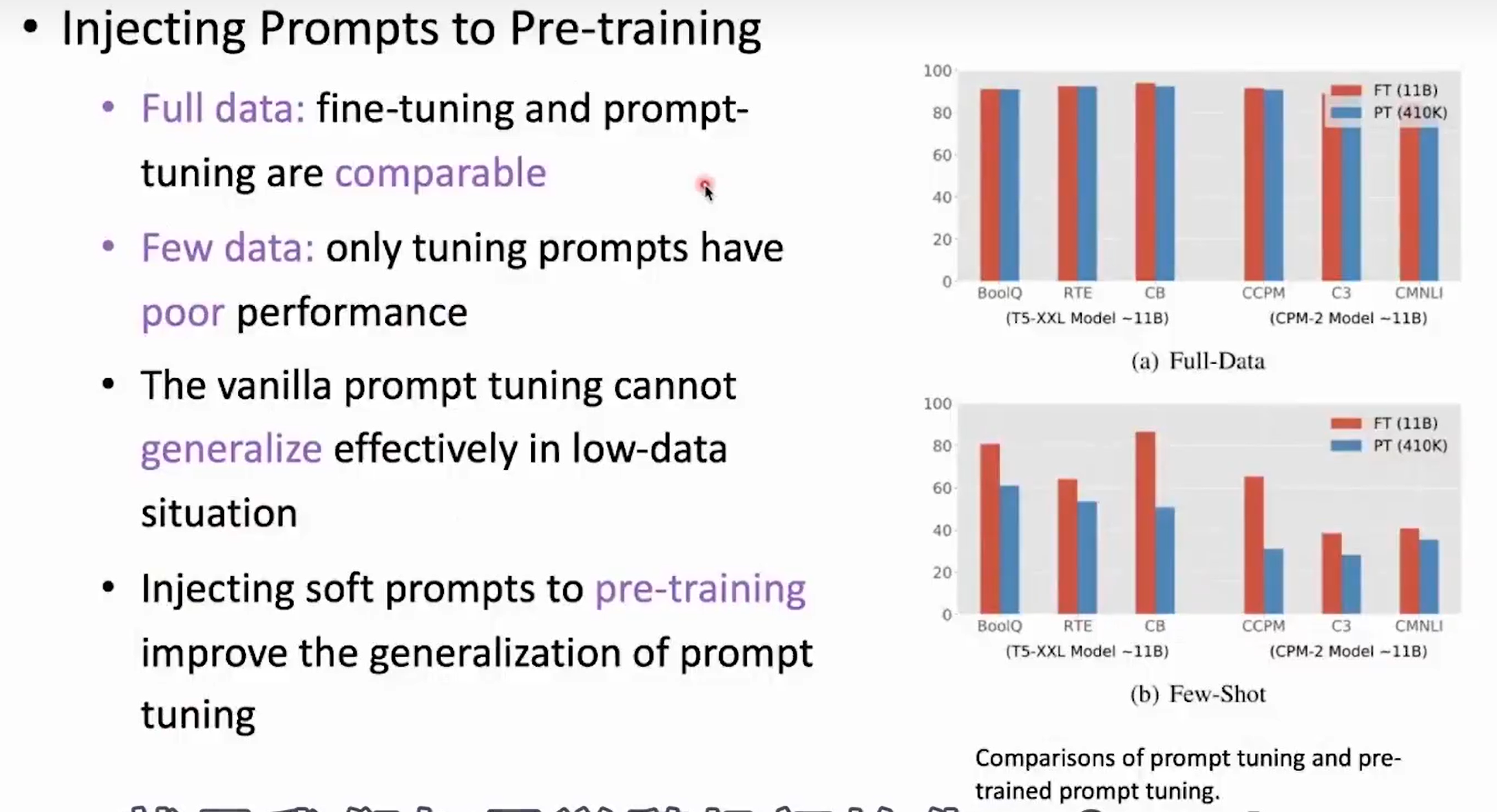

Prompt-Tuning

-

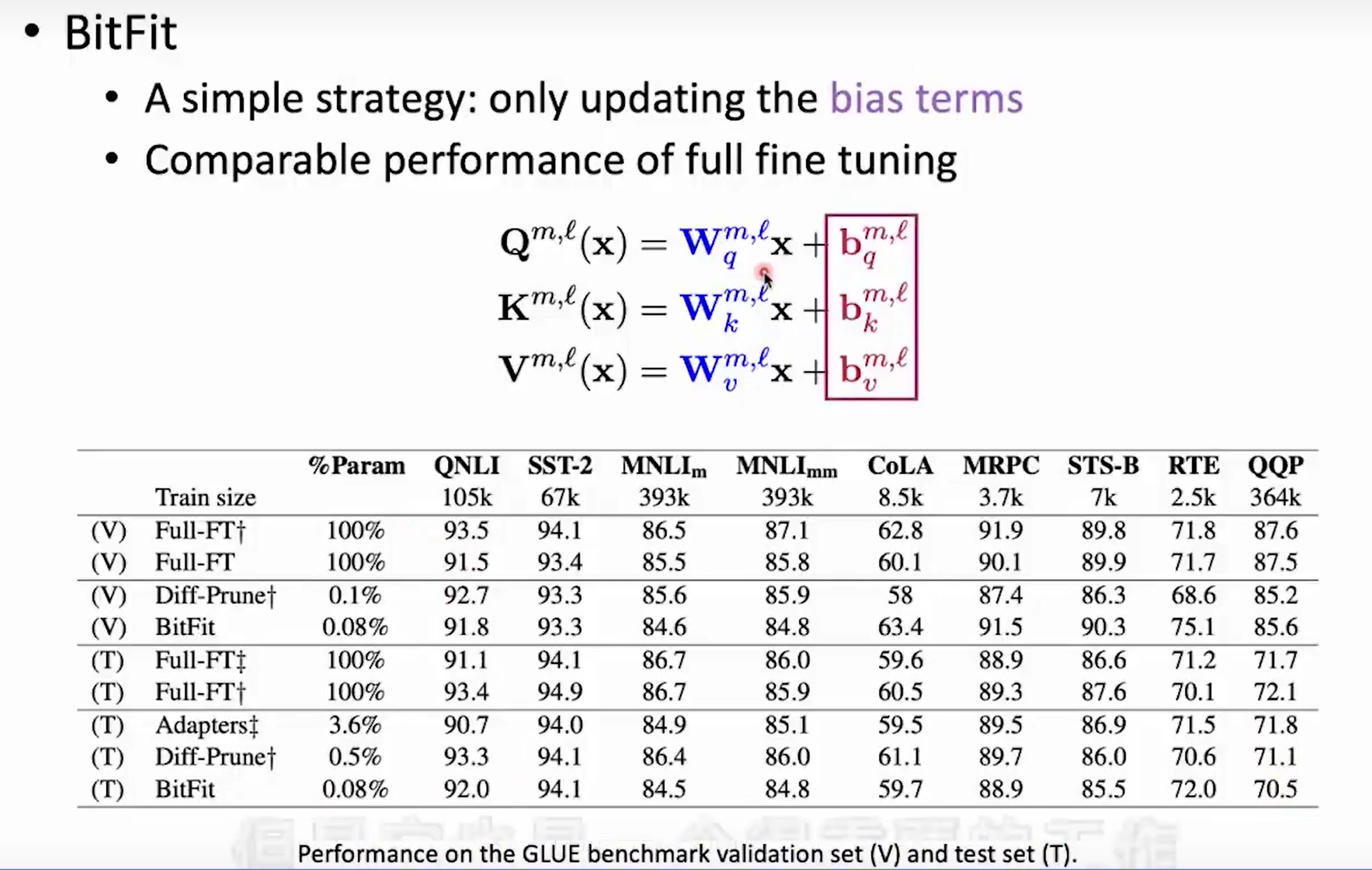

BitFit

总结

后会无期,未来可期!

浙公网安备 33010602011771号

浙公网安备 33010602011771号