2024-02-05 - 从零搭建ChatGLM和原理讲解 - 卢菁

摘要

2024-02-05 周一 老家 阴晴不定

课程内容

1. ChatGLM-6B 简介

关键词: 1B = 10 亿

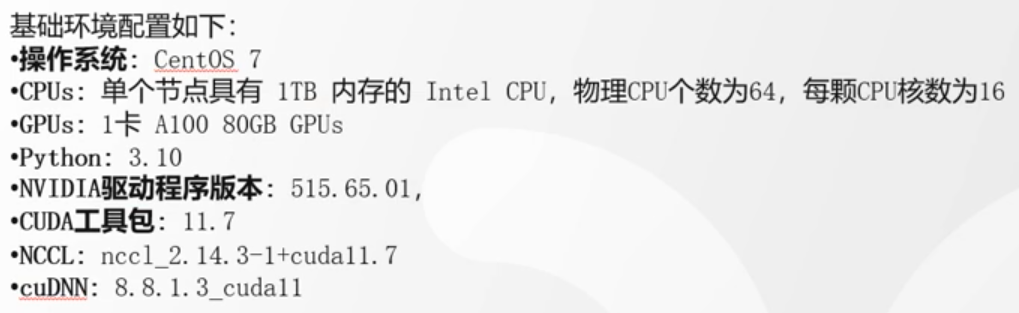

2. ChatGLM-6B 资源规格

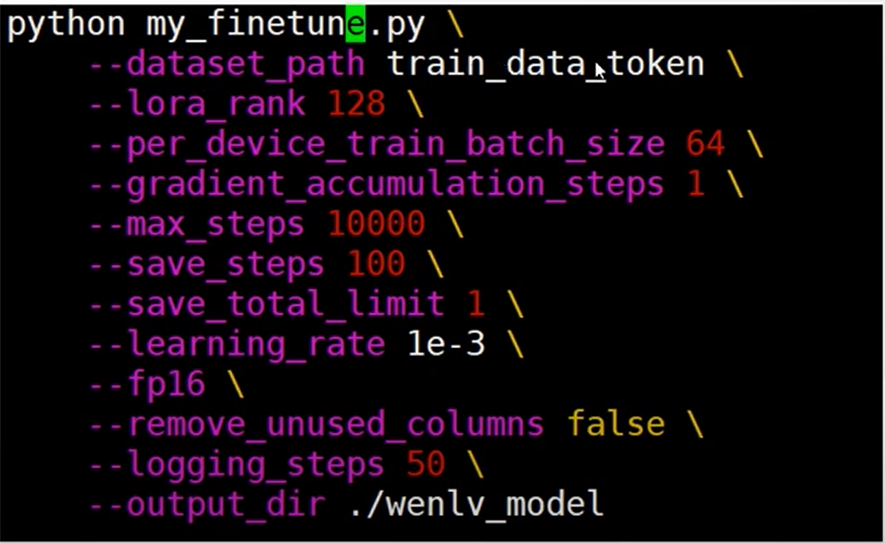

3. ChatGLM-6B 微调代码

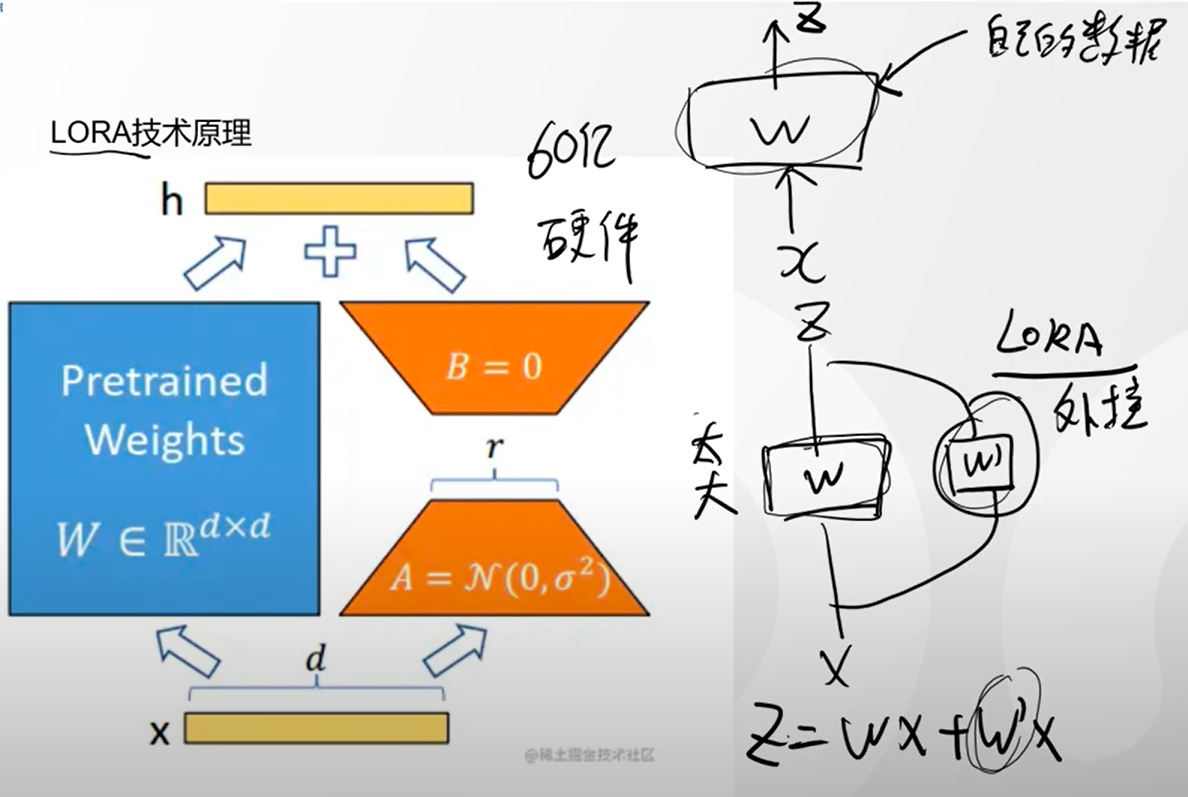

4. Lora 技术原理

关键词: 模型公式为 Z=WX+wX ,因为 W 相对来说比较大,因此通过增加一个小的变量 w 就可以做到 Z 的变化和调整,因此微调就是增加一个辅助变量从而达到对最后结果的变更的作用,这也是大模型中常用的技术,不然变更 W 付出的代价太大了。

理解: r 就是一个可变的超参,r 越大微调的数据影响也就越大,这个在文生图时做过实验测试,r 的可解释性却比较模糊,目前还没有理论依据,所以把对 r 的调整也就理解为炼丹。

原生模型+外挂就是微调

5. 大模型结构

关键点:

所有的 NLP 大模型都是 transformer 结构

- Mask attention 的策略不同;

- 训练任务目标不同;

总结

后会无期,未来可期!