2024-02-04-大模型微调实战之chatglm全系解析 -卢菁

摘要

2024-02-04 周日 老家 阴

小记: 昨天大扫除,搞到灰头土脸,今天乖乖的学习大模型。

课程内容

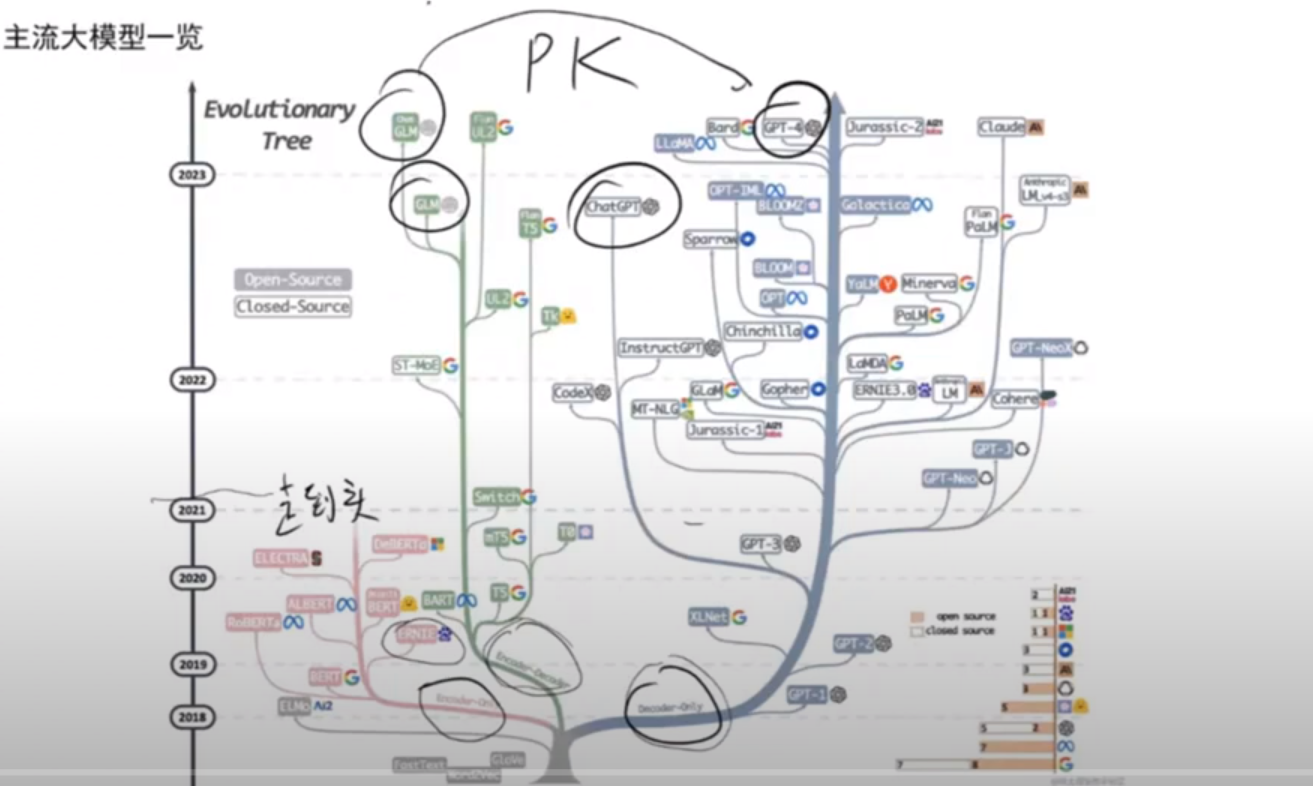

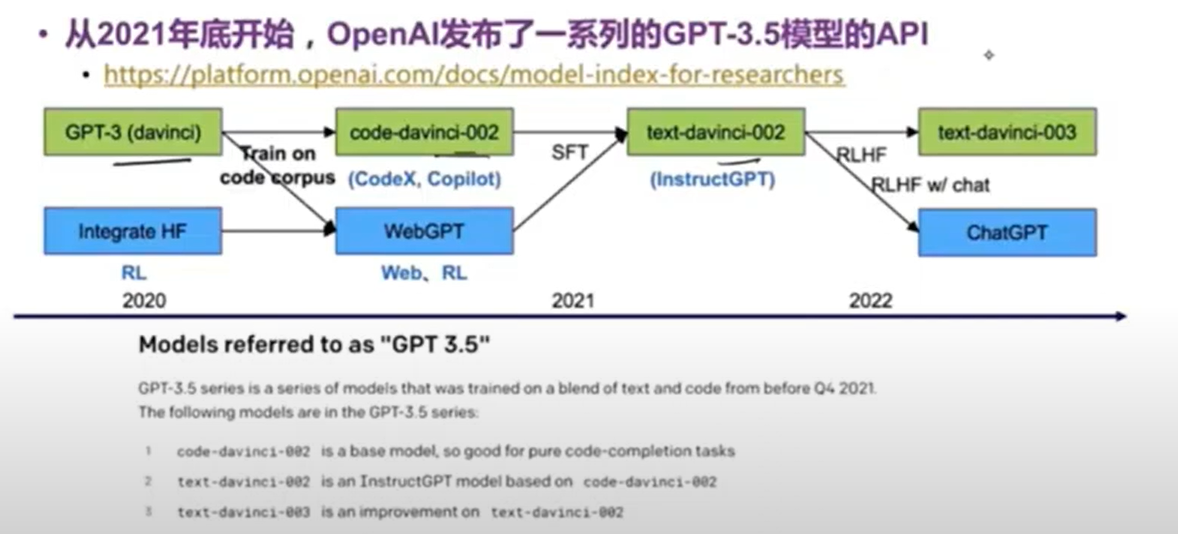

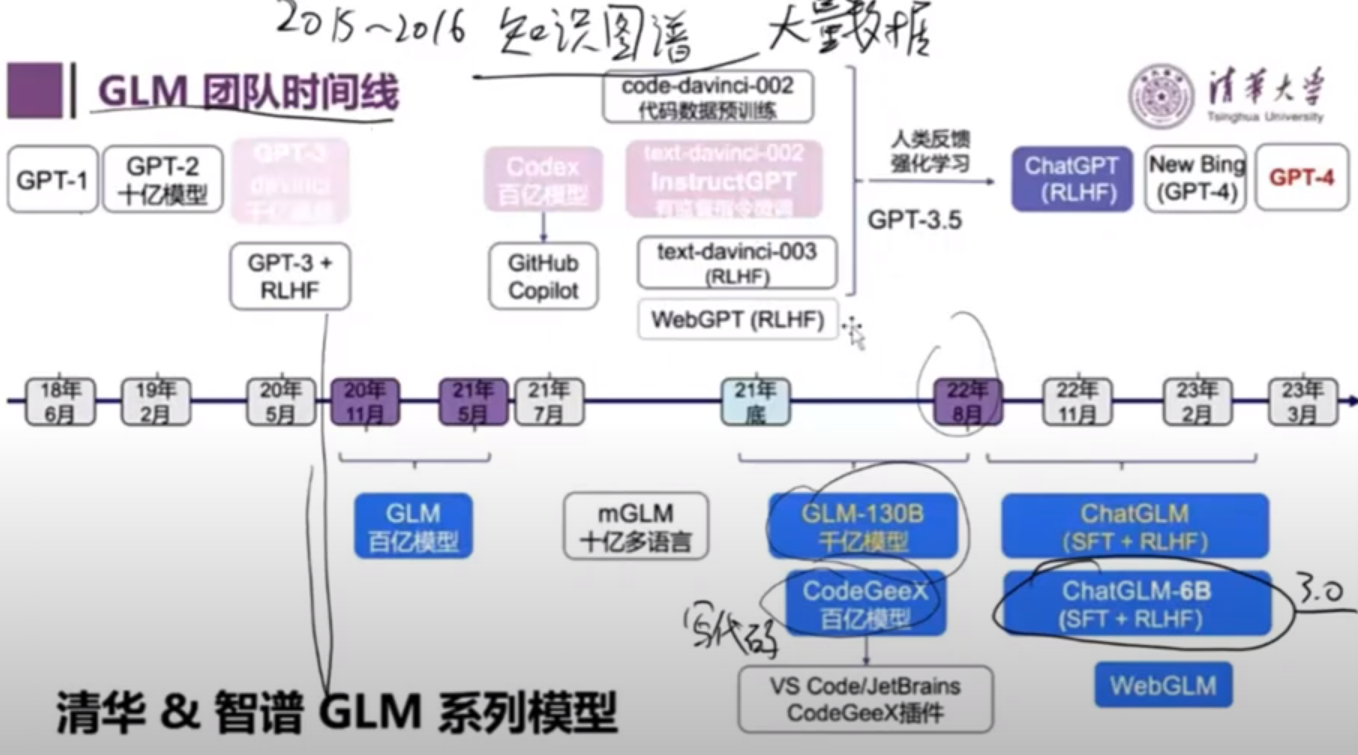

1. 主流大模型一览

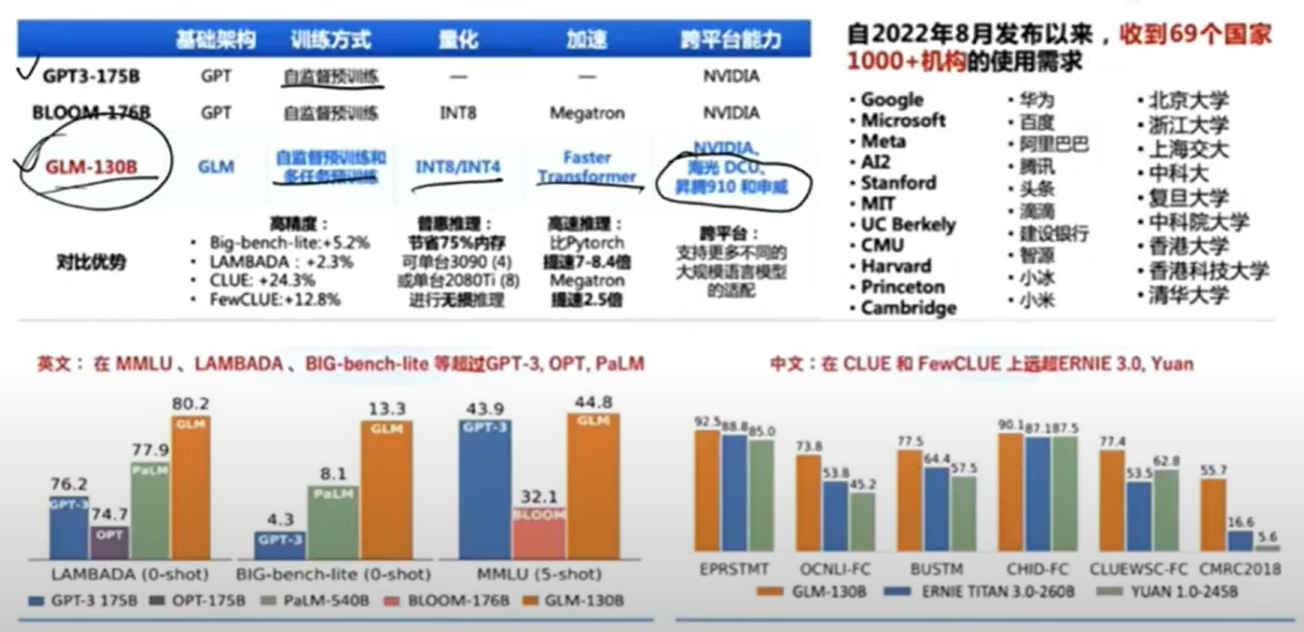

2. 大模型对比一览

3. 产品全线对标

4. 国内大模型流派

关键点: 国内大模型三大流派

- 清华 glm

- 百度

- 各类套壳(只要套llama,版权诉讼考量)

5. 轻量大模型(1.5B 与 3B 主要运行在 cpu上,更适合落地)

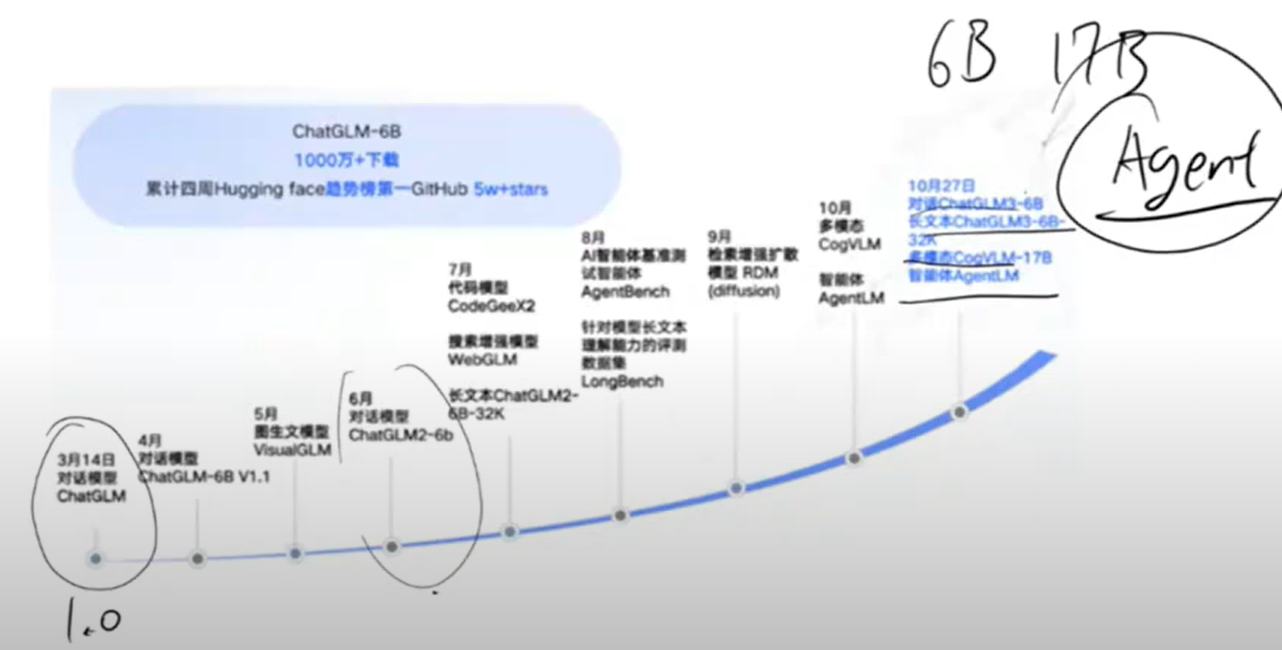

6. GLM 3.0 优势

- 更强大的基础模型(资源来源和语义资料更加丰富)

- 更完整的功能支持(Agent能力)

- 更加全面的开源序列,支持商业落地

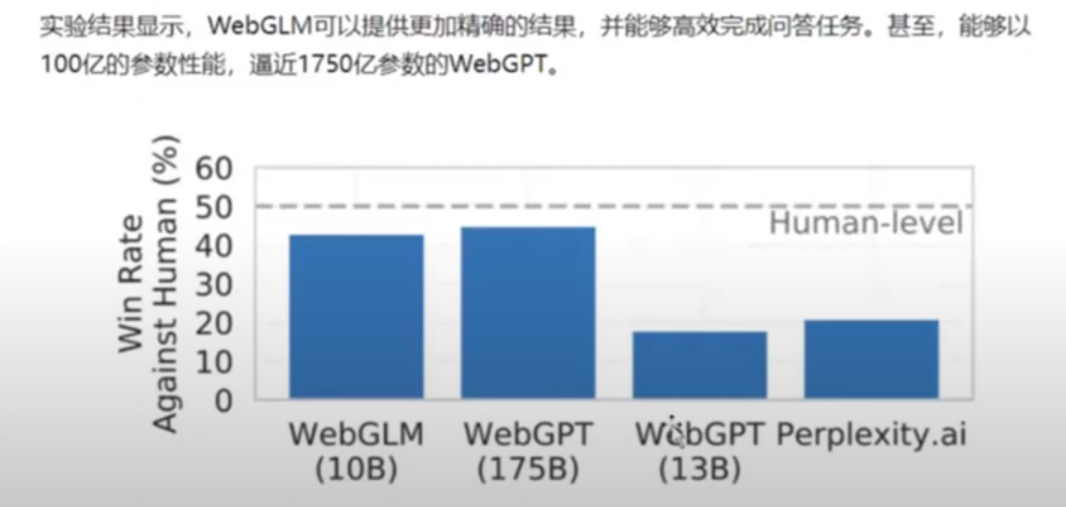

7. 搜索增强: WEBGPT vs WEBGML

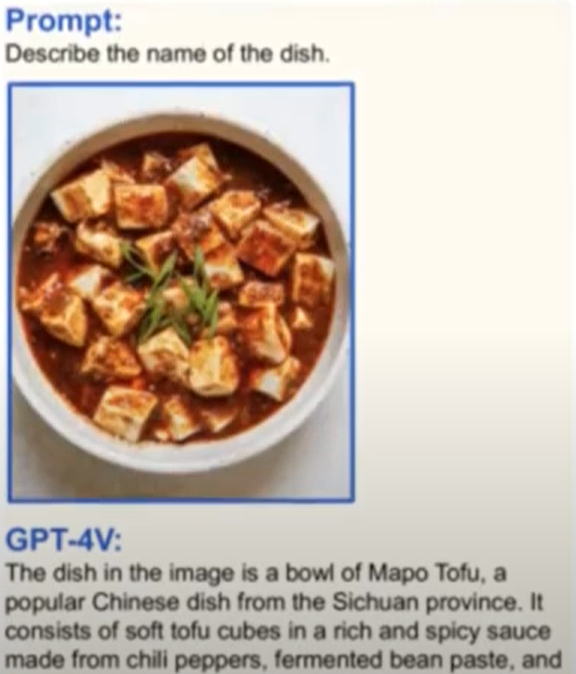

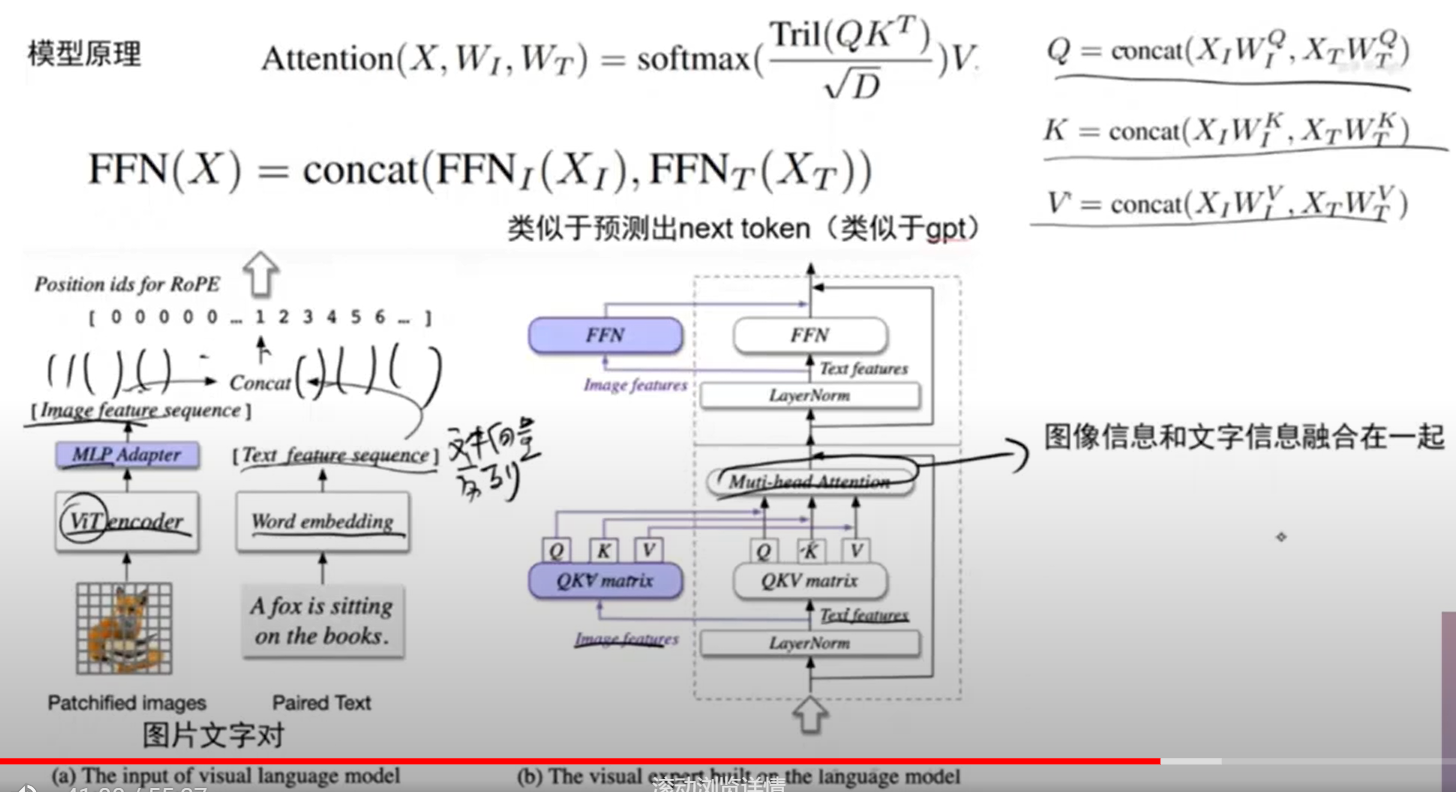

8. 图文理解: GPT-4V VS CogVLM

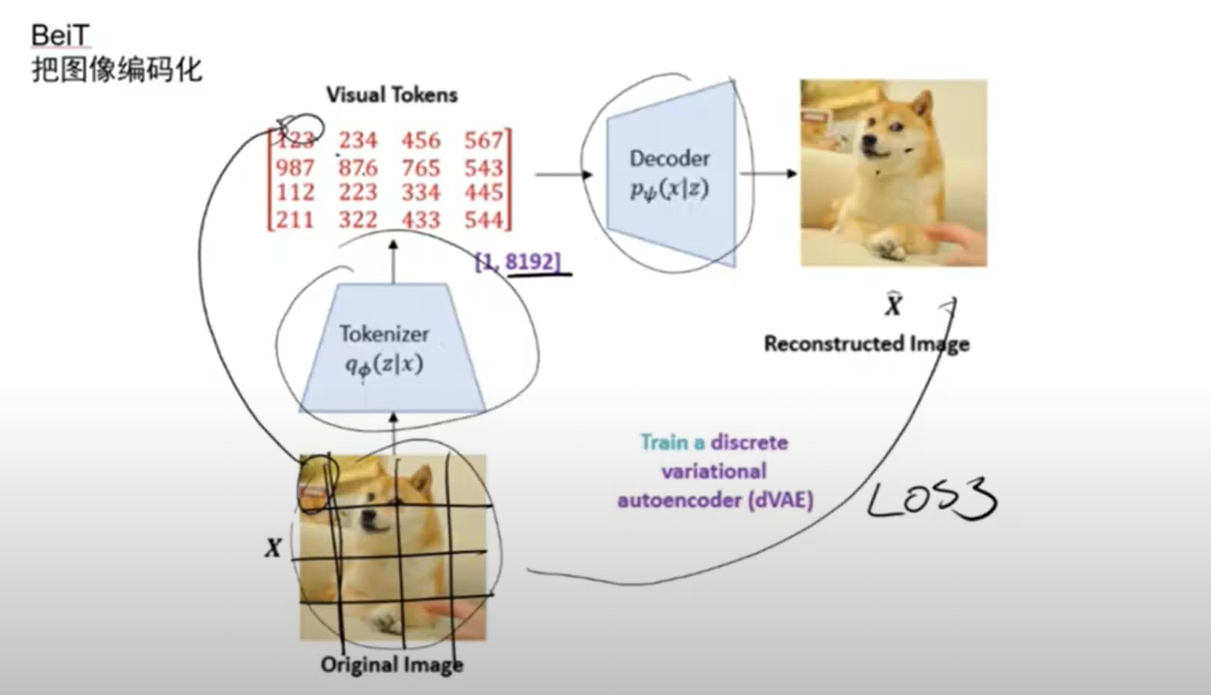

- 模型原理

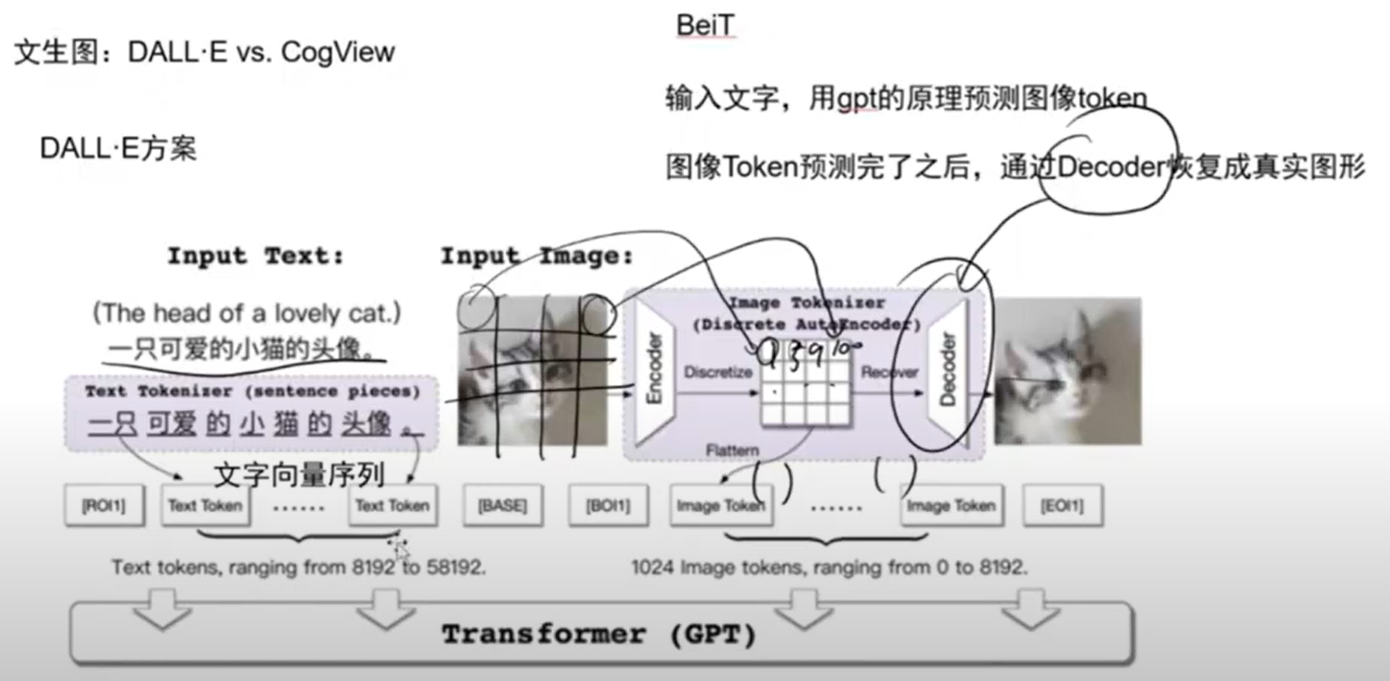

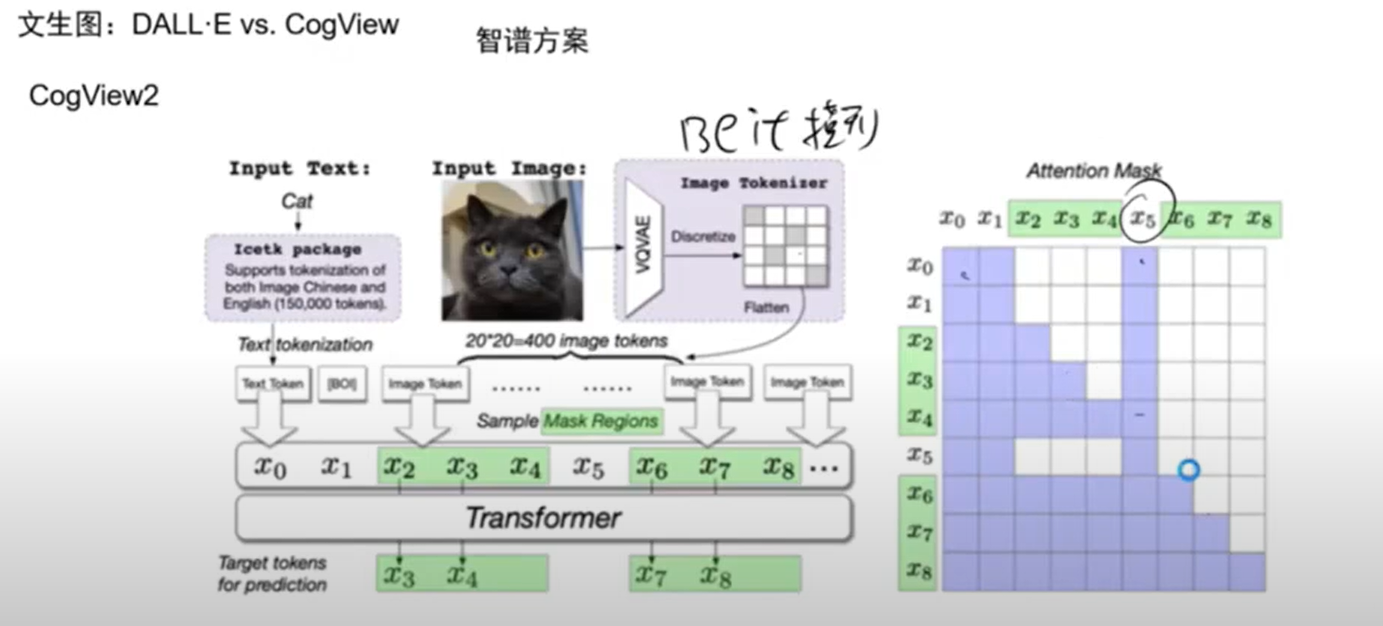

9. 文生图: DALL'E vs CogView

- 模型原理

10. 代码生成: CodeX vs CodeGenX

得益于 ChatGLM2 的升级,CodeGeeX 不仅可以更好的支持中英文输入,以及最大的8192序列长度,并且各项性能指标也取得了大幅提升。

- 模型原理

总结

心得: 大模型绝对说不上百花齐放,根源还是基础模型提供的原始能力,很多公司基于基础大模型结合垂直业务领域进行训练从而获得的模型能力,主导者还是少数派的,普通人也是可以进行模型训练的,玩噱头的人都很聪明的,但是沉下心来进行研究的却是最难得的。

后会无期,未来可期!

浙公网安备 33010602011771号

浙公网安备 33010602011771号