岭回归

转自华夏35度http://www.cnblogs.com/zhangchaoyang

Data Mining

Ridge Regression岭回归

数值计算方法的“稳定性”是指在计算过程中舍入误差是可以控制的。

对于有些矩阵,矩阵中某个元素的一个很小的变动,会引起最后计算结果误差很大,这种矩阵称为“病态矩阵”。有些时候不正确的计算方法也会使一个正常的矩阵在运算中表现出病态。对于高斯消去法来说,如果主元(即对角线上的元素)上的元素很小,在计算时就会表现出病态的特征。

回归分析中常用的最小二乘法是一种无偏估计。

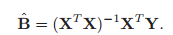

当X列满秩时,有

X+表示X的广义逆(或叫伪逆)。

当X不是列满秩,或者某些列之间的线性相关性比较大时,XTX的行列式接近于0,即XTX接近于奇异,计算(XTX)-1时误差会很大。此时传统的最小二乘法缺乏稳定性与可靠性。

岭回归是对最小二乘回归的一种补充,它损失了无偏性,来换取高的数值稳定性,从而得到较高的计算精度。

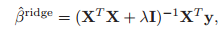

当XTX的行列式接近于0时,我们将其主对角元素都加上一个数k,可以使矩阵为奇异的风险大降低。于是:

(I是单位矩阵)

随着k的增大,B(k)中各元素bi(k)的绝对值均趋于不断变小,它们相对于正确值bi的偏差也越来越大。k趋于无穷大时,B(k)趋于0。b(k)随k的改变而变化的轨迹,就称为岭迹。实际计算中可选非常多的k值,做出一个岭迹图,看看这个图在取哪个值的时候变稳定了,那就确定k值了。

X不满足列满秩,换句话就是说样本向量之间具有高度的相关性(如果每一列是一个向量的话)。遇到列向量相关的情形,岭回归是一种处理方法,也可以用主成分分析PCA来进行降维。

两个角度看岭回归 -- 方差扩大 + 2范数惩罚

=====================

方差扩大,在这里,你将看到岭的概念

=====================

在回归分析中最小二乘法是最常用的方法,使用最小二乘法的一个前提是|X'X|不为零,即矩阵X'X非奇异,当所有变量之间有较强的线性相关性时,或者变量之间的数据变化比较小或者部分变量之间有线性相关性时,矩阵X'X的行列式比较小,甚至趋近于0,一般在实际应用中处理:当<0.01时常被称为病态矩阵,它表明最小二乘法并非在各方面都尽善尽美,因为这种矩阵在计算过程中极易造成约数误差,因此得到的数据往往缺乏稳定性和可靠性。

岭回归是在自变量信息矩阵的主对角线元素上人为地加入一个非负因子,从而使回归系数的估计稍有偏差、而估计的稳定性却可能明显提高的一种回归分析方法,它是最小二乘法的一种补充,岭回归可以修复病态矩阵,达到较好的效果。

线性回归分析的正规方程组可以写成:

X'Xb = X'Y (1)

其最小平方解则为:

b = (X'X)-1X'Y (2)

式(1)和(2)中的为自变量的n x m阶矩阵,X'为X的转置,(X'X)为对称的m x m方阵,通常称为信息矩阵(协方差矩阵),(X'X)-1为(X'X)的逆阵,Y为因变量的nx1向量,b为待解元,即回归系数的mx1向量,这里的n为观察值组数,m为待估计的回归系数个数。当|X'X|约等于0时,矩阵X'X为病态矩阵,这样最小偏二乘法就会产生较大的误差,b^是b的无偏估计,但很不稳定,在具体取值上与真值有较大的偏差,甚至有时会出现与实际经济意义不符的正负号。

如果我们在的主对角线元素上加上一个非负因子,即令:

b(k)= (X'X + kIm) -1X'Y (3)

(Im为单位矩阵),那么b(k)和b有何不同呢(下文在这些统计数后均加标记(k),便于与最小二乘法,即k=0的统计数相区别)?最先研究这一问题的是Hoerl和Kennard以及Marquardt[5],他们的基本结论是:b(k)是k的非线性函数;k=0时,b(k)=b同为最小平方估计数;而后,随着k的增大,b(k)中各元素bi(k)的绝对值均趋于不断变小(由于自变数间的相关,个别bi(k)可能有小范围的向上波动或改变正、负号),它们对bi的偏差也将愈来愈大;如果k->∞,则b(k)->0。b(k)随k的改变而变化的轨迹,就称为岭迹,参见图1,岭迹图表明,的加入使成为回归系数的有偏估计数。

总结:

岭回归也是用于处理自变量之间高度相关的情形。只是跟主成分回归的具体估计方法不同。线性回归的计算用的是最小二乘估计法,当自变量之间高度相关时,最小二乘回归估计的参数估计值会不稳定,这时如果在公式里加点东西,让它变得稳定,那就解决了这一问题了。岭回归就是这个思想,把最小二乘估计里加个k,改变它的估计值,使估计结果变稳定。至于k应该多大呢?可以根据岭迹图来判断,估计这就是岭回归名称的由来。你可以选非常多的k值,可以做出一个岭迹图,看看这个图在取哪个值的时候变稳定了,那就确定k值了,然后整个参数估计不稳定的问题就解决了。

=====================

带二范数惩罚的最小二乘回归

=====================

是的,岭回归就是一个带二范数惩罚的最小二乘回归,和带一范数惩罚的最小二乘回归LASSO有的一拼啊

链接:https://www.zhihu.com/question/28221429/answer/50909208

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

@董可人我今天要是再失眠明天我也不会让你睡好的!

最小二乘法是对普通线性回归参数估计的一种方法,目标是是loss function达到最小,而此时的loss function是误差平方和。

岭回归和普通线性回归的区别,我们可以从三种方式来看。

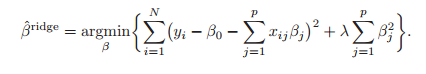

1. 最优化问题的不同 (我比较懒,公式就贴照片了),

对于岭回归,我们的最优化问题多了后面这些beta的平方和。

多元线性回归的OLS回归不仅仅可以看成是对loss function的最小化,得出的结果也是Y在X的线性空间上的投影。

2 从多变量回归的变量选择来说,普通的多元线性回归要做的是变量的剔除和筛选,而岭回归是一种shrinkage的方法,就是收缩。这是什么意思呢, 比如做普通线性回归时候,如果某个变量t检验不显著,我们通常会将它剔除再做回归,如此往复(stepwise),最终筛选留下得到一个我们满意回归方程,但是在做岭回归的时候,我们并没有做变量的剔除,而是将这个变量的系数beta向0”收缩“,使得这个变量在回归方程中的影响变的很小。 于普通的多元线性回归相比,岭回归的变化更加smooth,或者说continuous。从这点上来说活,岭回归只是shrinkage methods中的一种,大家常说的lasso回归(貌似叫套索回归)其实也属于这种方法。

3. 从计算的角度,有人提到了多元线性回归的OLS 估计是

, 当存在很强的多重共线性时X'X是不可逆(或者接近不可逆)的,但是岭回归系数估计是

, 当存在很强的多重共线性时X'X是不可逆(或者接近不可逆)的,但是岭回归系数估计是

此时虽然对系数的估计是有偏的,但是提高了稳定性。

链接:https://www.zhihu.com/question/28221429/answer/53858036

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

比方说一个自变量是身高

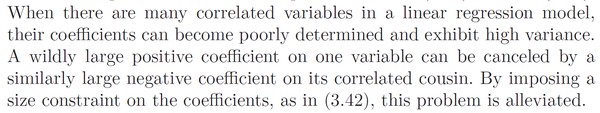

The Elements of Statistical Learning 第63页有提到这一点:

我觉得这个才是岭回归的motivation,正态先验充其量只是一个概率解释。