2.2 什么是神经网络

长宽减少,高度增加

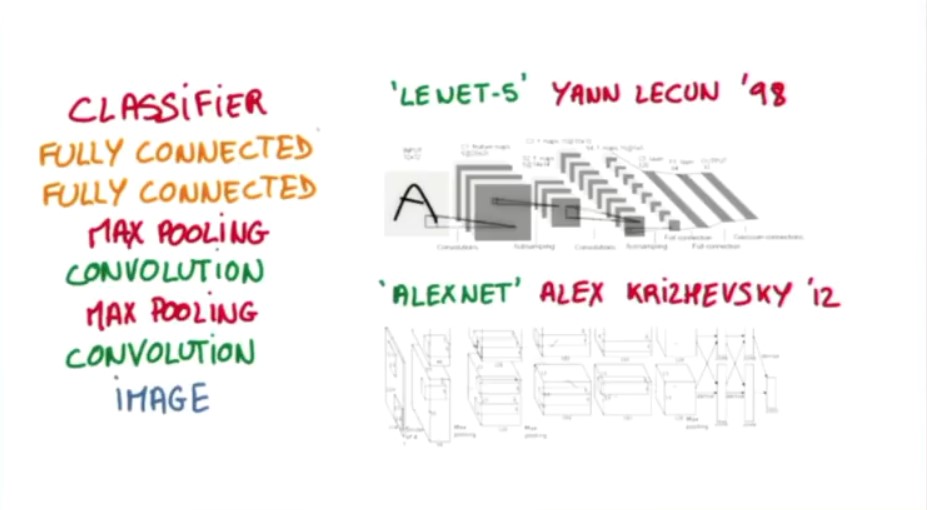

常见结构:

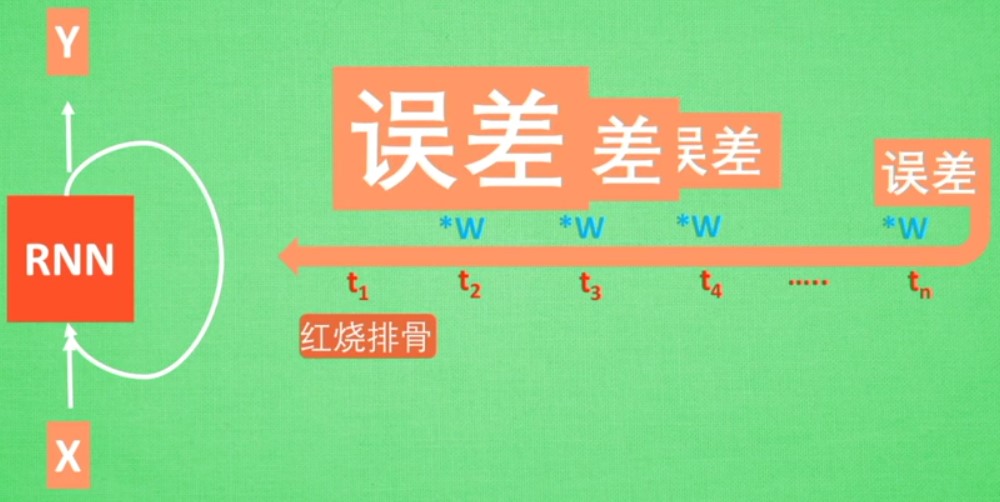

RNN

解决输入数据之间有前后关联的——记住之前发生的东西

RNN有很多形式

应用:描述照片,翻译,作曲等等

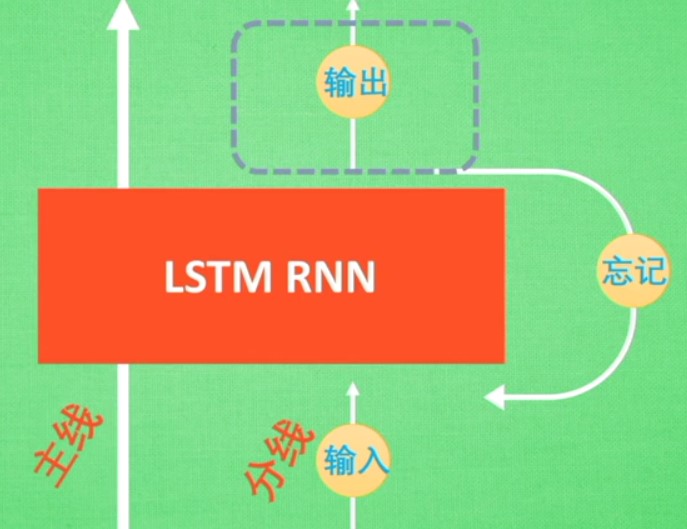

LSTM RNN

长短期记忆

传统的RNN的弊端:梯度消失或者梯度爆炸

LSTM:多了三个控制器:输入控制器(判断输入的重要性);输出控制器();忘记控制器

2.6 自编码autocoder

可以像pca一样降维

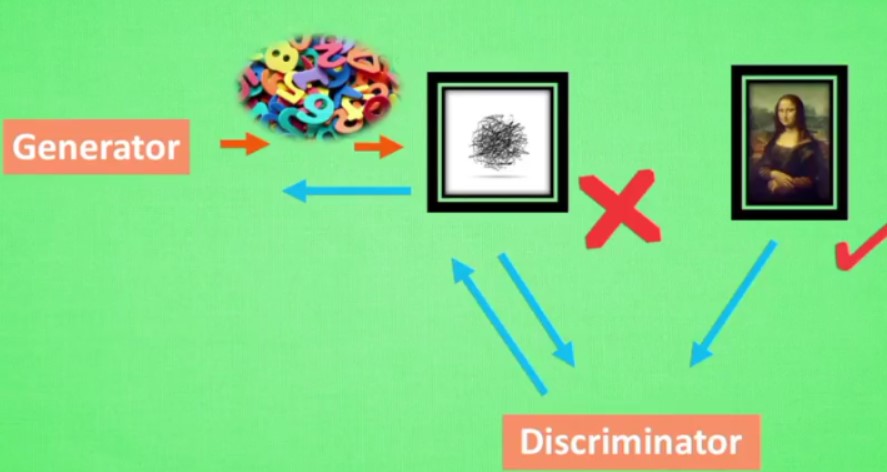

2.7 GAN

随机数来生成有意义的作品

2.8

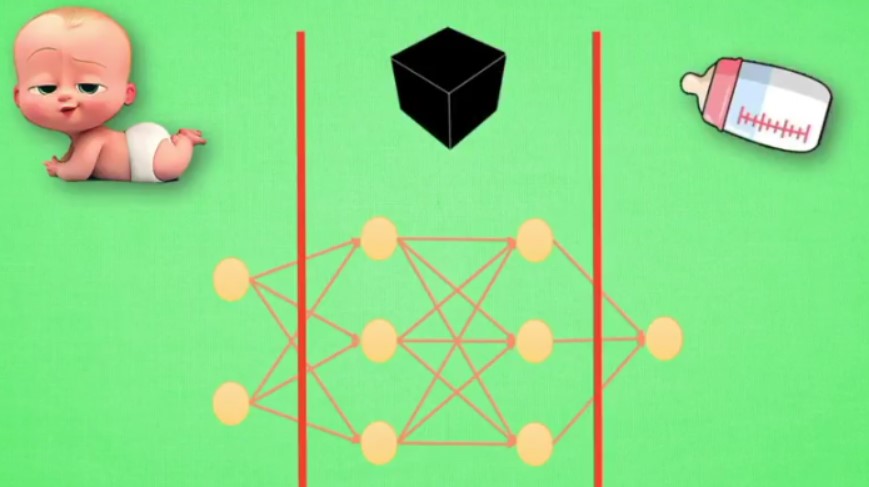

神经网络可以看做是一个黑盒

但是其实黑盒里面就是对输入的不断抽象,可以看做是一个新的输入的表示

## 2.9 神经网络:梯度下降

梯度下降来自优化问题

但是有可能陷入局部最优

2.10 站在巨人的肩膀上,迁移学习

借鉴已有的资源,不是所有人都有大量的计算资源

借鉴已经训练的神经网络

替换最后一层,前面的神经层不再训练

不是所有时候都要用到迁移学习,如果神经网络简单,就不需要迁移学习,不然反而可能会造成一定的干扰