场景题:百万数据插入Redis有哪些实现方案?

在面试的过程当中,偶尔会遇到一些场景题,虽然这些场景题归根到底还是技术问题,但他通常比常规的八股题要稍微难一些,因为他考验的是你对于技术的整体理解、应用,以及变通的能力。

那么今天咱们就来看一道,在面试中国平安时遇到的一道场景题:将百万数据插入到 Redis,有哪些实现方案?

1.Redis 优势与挑战

首先,Redis 作为一个开源的内存数据结构存储系统,支持多种数据结构,如字符串、哈希表、列表、集合和有序集合等,它具有以下显著优势:

- 高速读写:Redis 将数据存储在内存中,能够实现极快的读写操作,非常适合对性能要求高的场景。

- 丰富的数据结构:可以根据不同的业务需求选择合适的数据结构来存储数据。

- 支持持久化:可以将数据持久化到硬盘,保证数据的安全性。

但是,当需要插入百万数据时,也面临着一些挑战:

- 内存压力:大量数据可能会占用大量内存,需要合理规划内存使用。

- 性能瓶颈:如果插入操作不当,可能会导致性能下降,甚至影响系统的正常运行。

那怎么来解决这些问题呢?接下来我们一起来看。

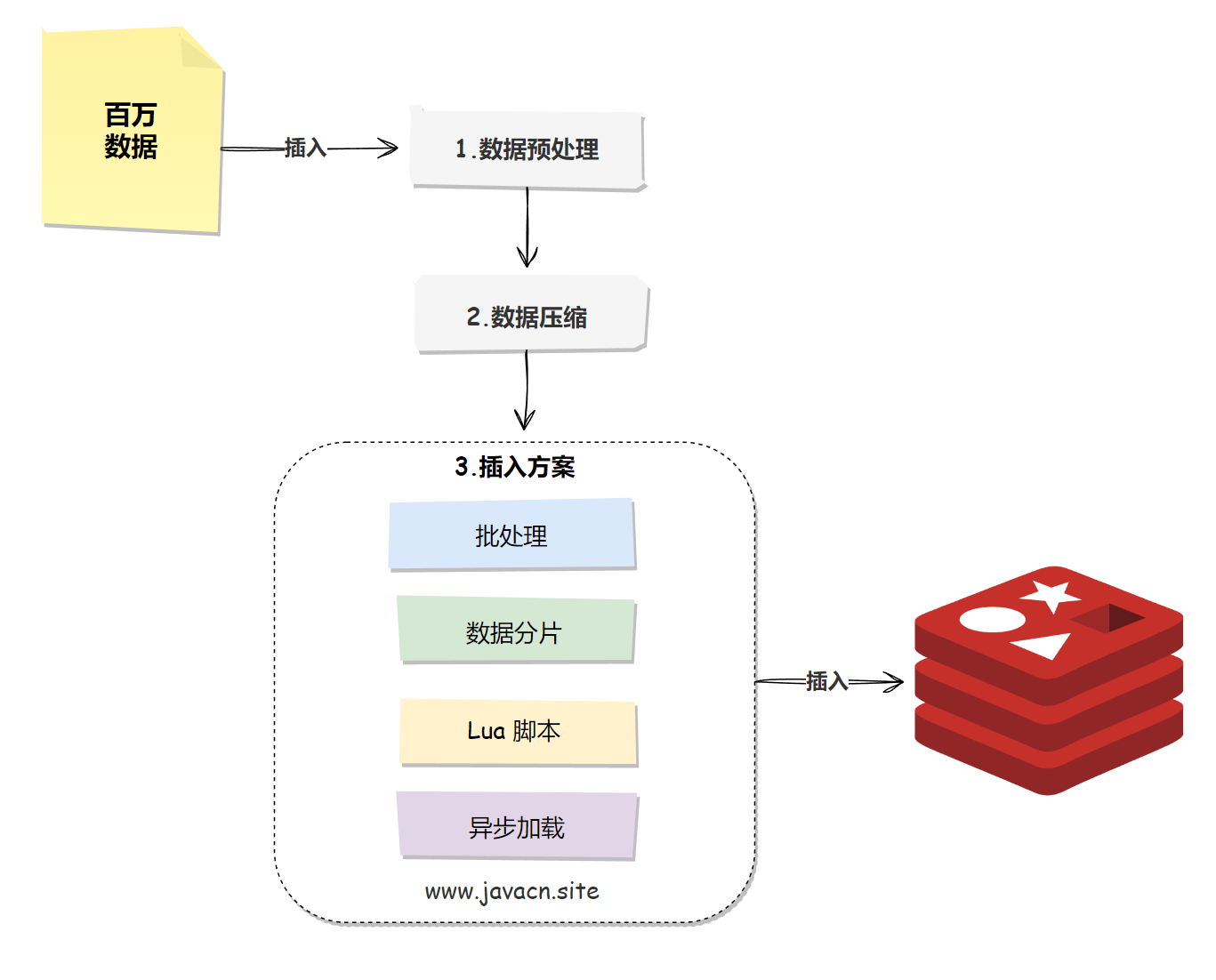

2.实现方案概述

百万数据插入 Redis 的整体执行流程如下:

3.前置工作:预处理和压缩

在开始执行数据插入之前,可以先进行以下操作:

- 数据预处理:在写入之前对数据进行必要的预处理,比如去除重复数据、转换数据格式等,可以减少实际写入 Redis 的数据量,提高效率。

- 数据压缩:如果存储的数据可以进行压缩的情况下,可以考虑使用 Redis 的压缩功能(如 LZF、Snappy 等压缩算法)来减少内存占用。压缩后的数据占用更少的内存,可以提高存储容量和存取速度。

4.插入方案

百万级数据插入 Redis 可以采取的方案有以下几个:

- 批处理

- 数据分片

- 使用 Lua 脚本

- 异步加载

接下来,我们分别看来。

4.1 批处理

Redis 批处理的手段有以下两个:

- 使用管道技术(Pipeline):允许客户端发送多个命令到服务器,而不需要等待每个命令的回复。这减少了网络延迟的影响,提高了写入速度。

- 使用批量操作指令:如使用 MSET 或 HMSET 命令可以一次设置多个键值对或哈希表字段,这比单独使用 SET 或 HSET 要快得多。

4.2 数据分片

数据分片指的是使用 Redis 的分片功能,将数据分布在多个 Redis 实例或节点上,可以考虑使用 Redis 集群。集群模式下,数据可以分布在多个节点上,从而分散负载并提高写入吞吐量。

4.3 使用 Lua 脚本

也可以通过 Lua 脚本将多个操作组合成一个原子操作,减少客户端与服务器之间的通信次数。

4.4 异步加载

将一个大任务分成多个小任务,然后再通过异步加载的方式批量写入 Redis,这样可以避免阻塞主线程,提高应用的整体响应性。

获取更多企业面试真题,加 V:VipStone【备注:平安】。

5.优化建议

除了以上手段之外,我们还可以通过以下手段优化 Redis:

- 调整 Redis 配置参数:根据实际情况调整 Redis 的内存限制、持久化策略等参数,以提高性能和稳定性。

- 监控内存使用情况:使用 Redis 的监控工具,实时监控内存使用情况,避免内存溢出。

小结

将百万数据插入到 Redis 是一个具有挑战性的任务,但通过合理选择实现方案和进行性能优化,可以高效地完成任务。以上实现方法都有各自的优缺点,开发者可以根据实际情况选择最适合的方案。同时,注意调整 Redis 的配置参数和监控内存使用情况,以确保系统的稳定运行。

本文已收录到我的面试小站 www.javacn.site,其中包含的内容有:Redis、JVM、并发、并发、MySQL、Spring、Spring MVC、Spring Boot、Spring Cloud、MyBatis、设计模式、消息队列等模块。

浙公网安备 33010602011771号

浙公网安备 33010602011771号