【Python爬虫学习(2)】requests库的使用

一、介绍

Requests是用Python语言编写,基于Urllib,采用Apache2 Licensed开源协议的HTTP库。比Urllib更加方便。

二、安装Requests

Win+R输入cmd,打开命令行窗口,输入命令安装:pip install requests

三、使用方法

1、requests库的两个重要对象

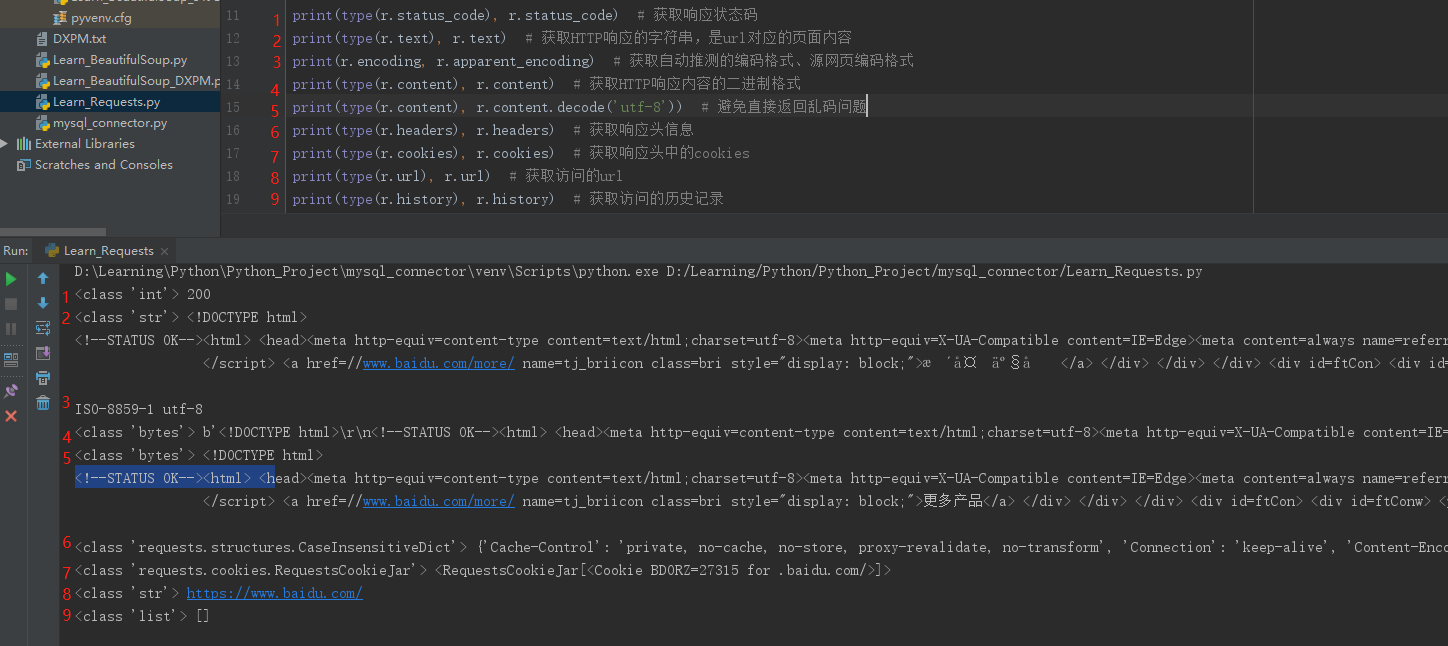

r = requests.get(url)

r:是一个Response对象,一个包含服务器资源的对象

.get(url):是一个Request对象,构造一个向服务器请求资源的Request。

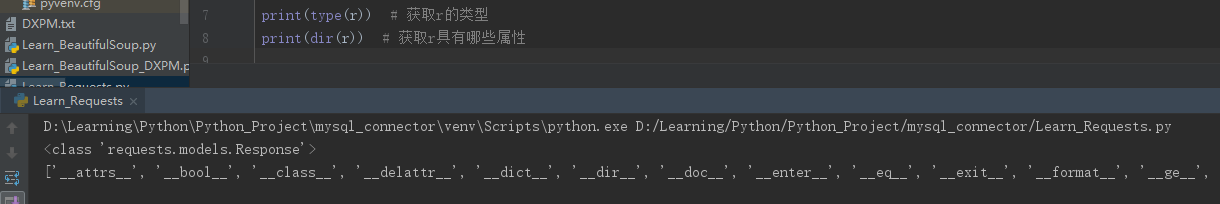

获取r的类型:type(r)

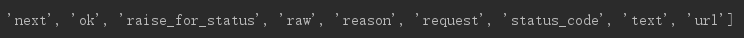

显示r具有的属性:dir(r)

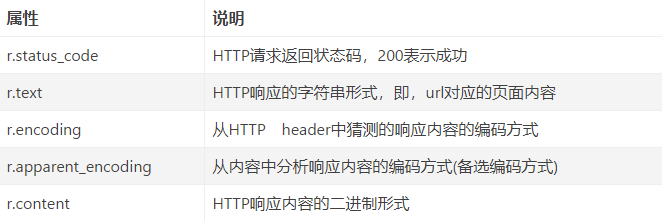

其中重要的常用的几个属性如下:

2、Requests库主要方法解析

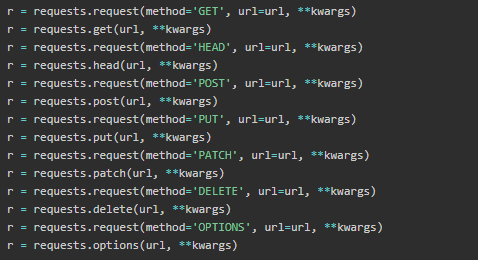

2.1、7种主要方法简介

备注:get,head是从服务器获取信息到本地;put,post,patch,delete是从本地向服务器提交信息。通过url和命令管理资源,操作独立无状态,网络通道和服务器成了黑盒子。

2.2、方法写法

r = requests.request(method, url, **kwagrs)

method是请求方式,对应get、head、post、put、patch、delete、options等7种方法

url是获取页面的url链接

**kwagrs是控制访问的参数,有13个

注:r = requests.request(method='GET', url = url, **kwargs)等价于r = requests.get(url, **kwargs)

2.3、**kwagrs详解

**kwagrs是控制访问的参数,均为可选项,有13种。

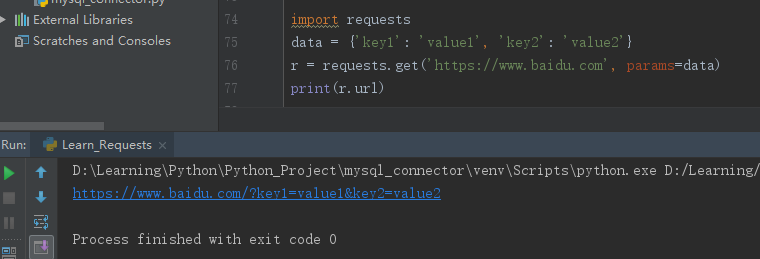

(1)params:字典或字节序列,作为参数增加到url中,使用这个参数可以把一些键值对以?key1=value1&key2=value2的模式增加到url中。

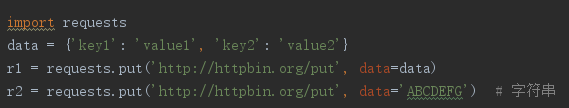

(2)data:字典,字节序列或文件对象,重点作为向服务器提供或提交资源,作为requests的内容,与params不同的是,data提交的数据并不放在url链接里, 而是放在url链接对应位置的地方作为数据来存储,它也可以接受一个字符串对象。

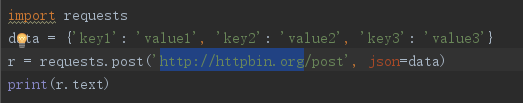

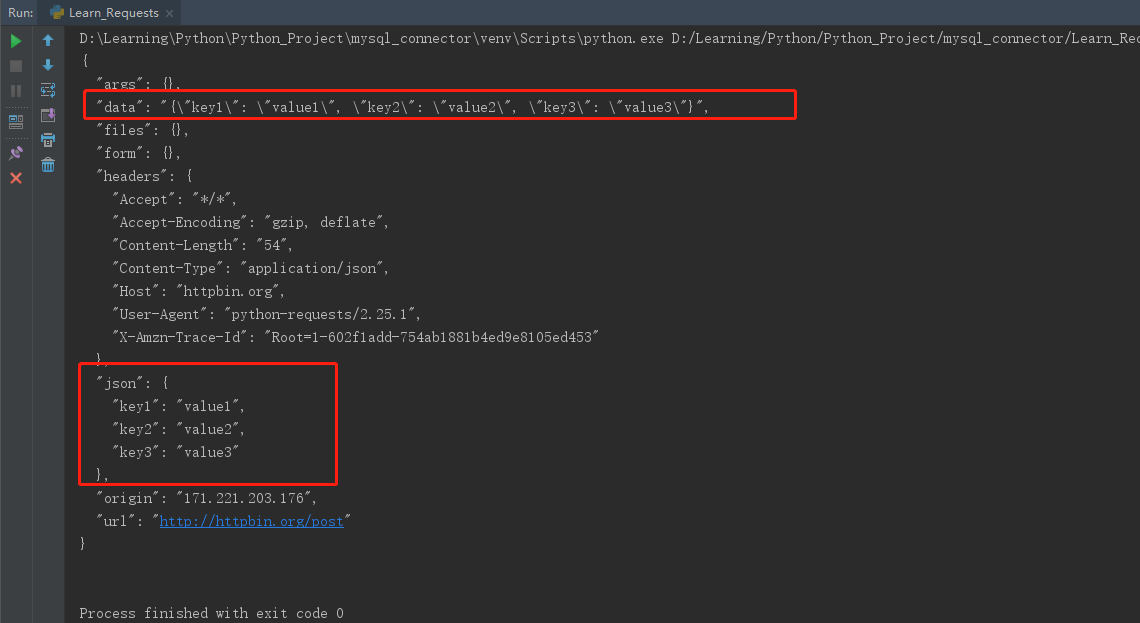

(3)json:json格式的数据,也是http最经常使用的数据格式,作为request的内容。

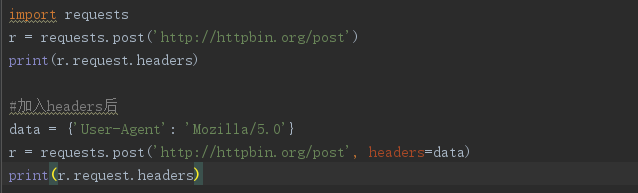

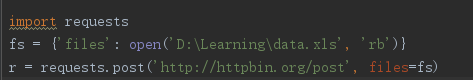

(4)headers:字典,可以用这个字段来定义http的访问的http头,可以用来模拟任何我们想模拟的浏览器来对url发起访问。

(5)cookies:字典或CookieJar,指的是从http中解析cookie

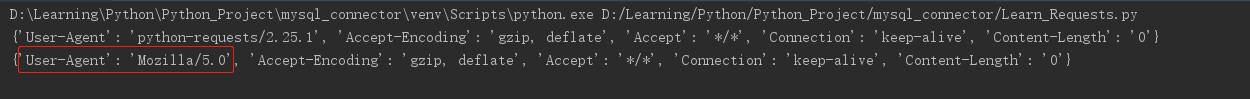

(6)auth:元组,用来支持http认证功能

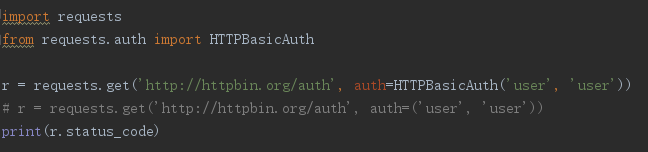

(7)files:字典,用来向服务器传输文件时使用的字段

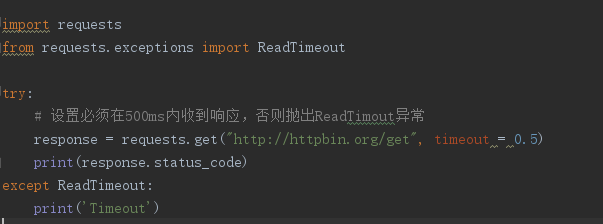

(8)timeout:设定超时时间,单位为秒,当发起一个get请求时可以设置一个timeout时间,如果在timeout时间内请求内容没有返回,将产生一个timeout的异常。

(9)proxies:字典,用来设置访问代理服务器,可以增加登录认证

(10)allow_redirects:开关,表示是否允许对url进行重定向,默认为True

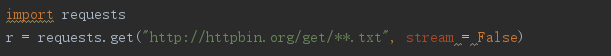

(11)stream:开关,指是否对获取内容进行立即下载,默认为True

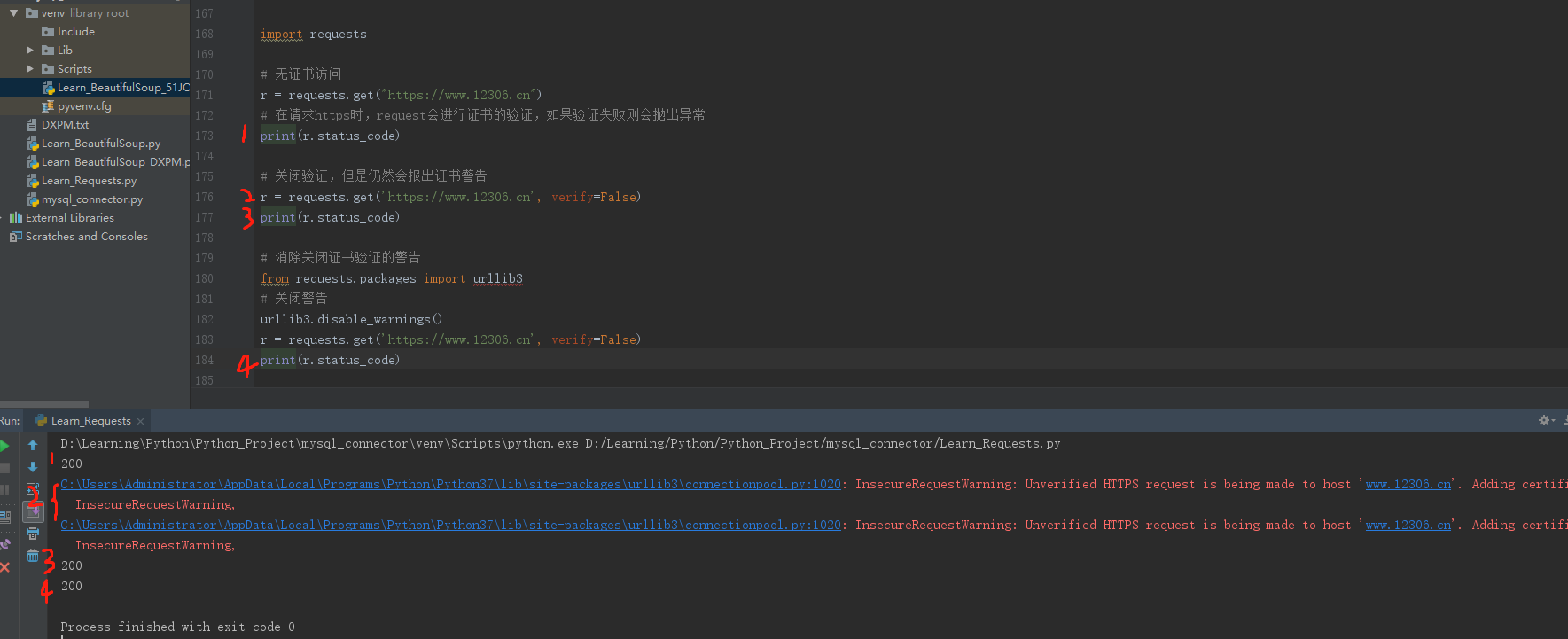

(12)verify:开关,用于认证SSL整数,默认为True

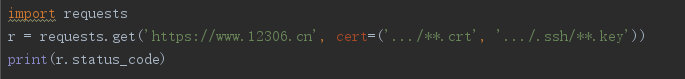

(13)cert:用于设置保存本地SSL证书路径

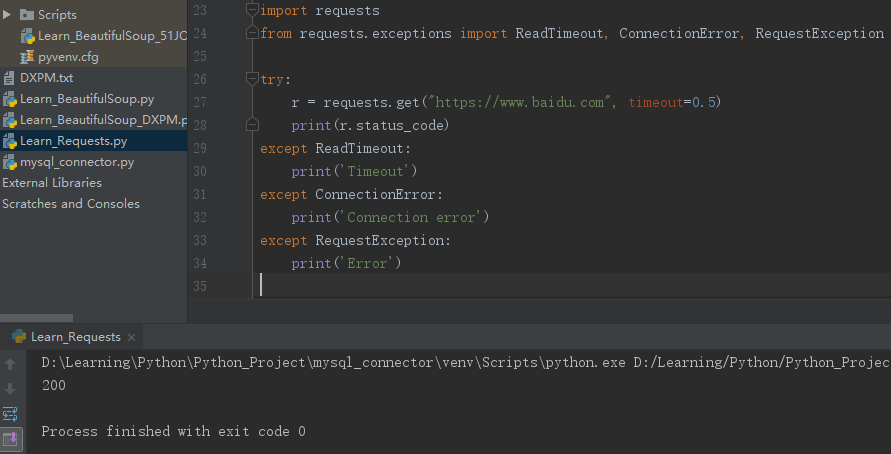

4、理解requests库的异常

5、理解Response的异常

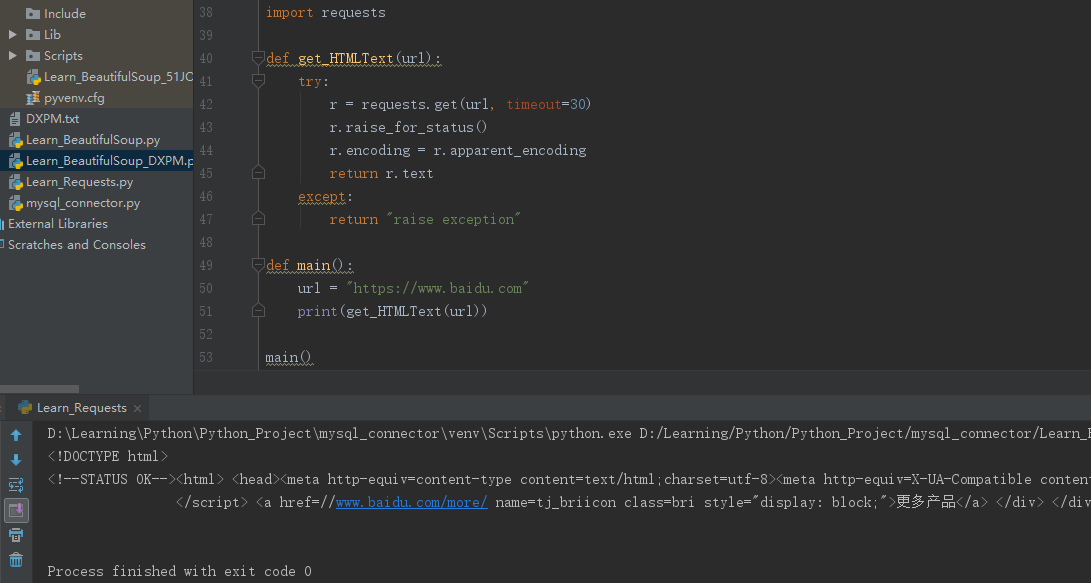

若r.status_code不是200,则产生异常requests.HTTPError

r.raise_for_status()方法内部判断r.status_code是否等于200,不需要增加额外的if语句,该语句便于利用try-except进行异常处理。

6、爬取网页通用代码框架