大数据篇:Spark

大数据篇:Spark

- Spark是什么

Spark是一个快速(基于内存),通用,可扩展的计算引擎,采用Scala语言编写。2009年诞生于UC Berkeley(加州大学伯克利分校,CAL的AMP实验室),2010年开源,2013年6月进入Apach孵化器,2014年成为Apach顶级项目,目前有1000+个活跃者。就是说用Spark就对了。

Spark支持Scala,Java,R,Python语言,并提供了几十种(目前80+种)高性能的算法,这些如果让我们自己来做,几乎不可能。

Spark得到众多公司支持,如:阿里、腾讯、京东、携程、百度、优酷、土豆、IBM、Cloudera、Hortonworks等。

- 如果没有Spark

解决MapReduce慢的问题而诞生,官网解释比同样的MapReduce任务快100倍!

1 内置模块

机器学习(MLlib),图计算(GraphicX),实时处理(SparkStreaming),SQL解析(SparkSql)

1.1 集群资源管理

Spark设计为可以高效的在一个计算节点到数千个计算节点之间伸缩计算,为了实现这样的要求,同时获得最大灵活性,Spark支持在各种集群资源管理器上运行,目前支持的3种如下:(上图中下三个)

- Hadoop YARN(国内几乎都用)

- Apach Mesos(国外使用较多)

- Standalone(Spark自带的资源调度器,需要在集群中的每台节点上配置Spark)

1.2 Spark Core

实现了Spark的基本功能,包含任务调度、内存管理、错误恢复、与存储系统交互等模块。其中还包含了对弹性分布式数据集(RDD:Resilient Distributed DataSet)的API定义

1.3 Spark SQL

是Spark用来操作结构化数据的程序包,通过Spark SQL 我们可以使用SQL或者HQL来查询数据。且支持多种数据源:Hive、Parquet、Json等

1.4 Spark Streaming

是Spark提供的对实时数据进行流式计算的组件

1.5 Spark MLlib

提供常见的机器学习功能和程序库,包括分类、回归、聚类、协同过滤等。还提供了模型评估、数据导入等额外的支持功能。

2 运行模式

2.1 核心概念介绍

-

Master

- Spark特有的资源调度系统Leader,掌控整个集群资源信息,类似于Yarn框架中的ResourceManager

- 监听Worker,看Worker是否正常工作

- Master对Worker、Application等的管理(接收Worker的注册并管理所有的Worker,接收Client提交的Application,调度等待Application并向Worker提交)

-

Worker

- Spark特有的资源调度Slave,有多个,每个Slave掌管着所有节点的资源信息,类似Yarn框架中的NodeManager

- 通过RegisterWorker注册到Master

- 定时发送心跳给Master

- 根据Master发送的Application配置进程环境,并启动ExecutorBackend(执行Task所需的进程)

-

Driver

- Spark的驱动器,是执行开发程序中的main方法的线程

- 负责开发人员编写SparkContext、RDD,以及进行RDD操作的代码执行,如果使用Spark Shell,那么启动时后台自启动了一个Spark驱动器,预加载一个叫做sc的SparkContext对象,如果驱动器终止,那么Spark应用也就结束了。

- 4大主要职责:

- 将用户程序转化为作业(Job)

- 在Executor之间调度任务(Task)

- 跟踪Executor的执行情况

- 通过UI展示查询运行情况

-

Excutor

- Spark Executor是一个工作节点,负责在Spark作业中运行任务,任务间相互独立。Spark应用启动时,Executor节点被同时启动,并且始终伴随着整个Spark应用的生命周期而存在,如果有Executor节点发生了故障或崩溃,Spark应用也可以继续执行,会将出错节点上的任务调度到其他Executor节点上继续运行

- 两个核心功能:

- 负责运行组成Spark应用的任务,并将结果返回给驱动器(Driver)

- 它通过自身块管理器(BlockManager)为用户程序中要求缓存的RDD提供内存式存储。RDD是直接存在Executor进程内的,因此任务可以在运行时充分利用缓存数据加速运算。

-

RDDs

- Resilient Distributed DataSet:弹性分布式数据集

- 一旦拥有SparkContext对象,就可以用它来创建RDD

-

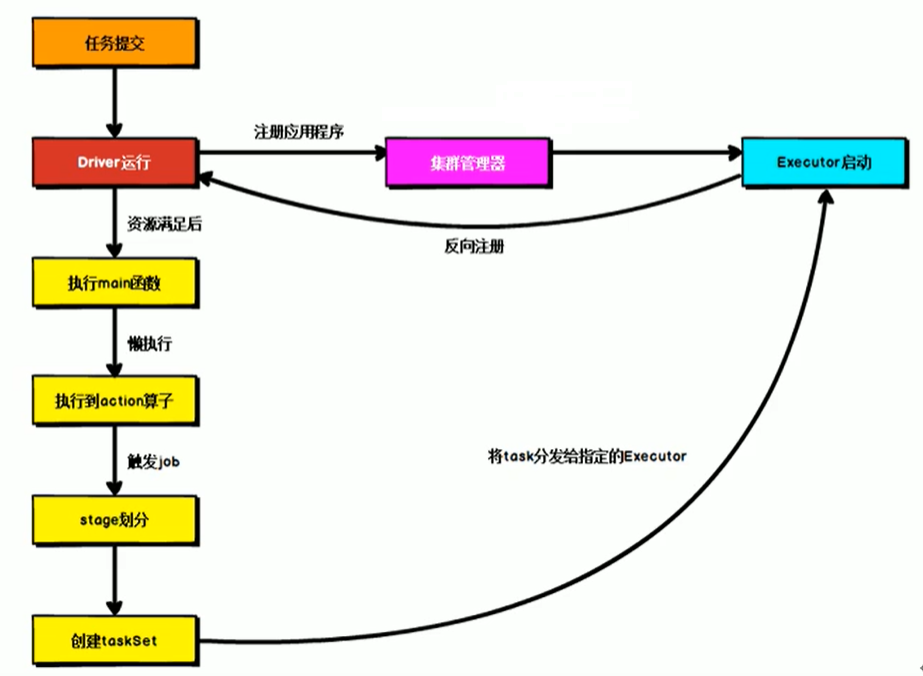

通用流程图

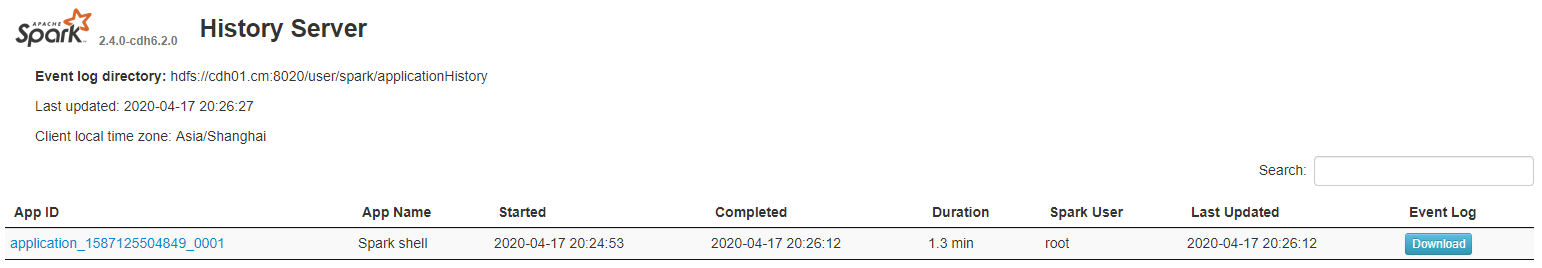

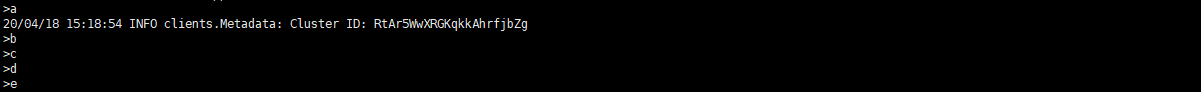

2.2 WordCount案例

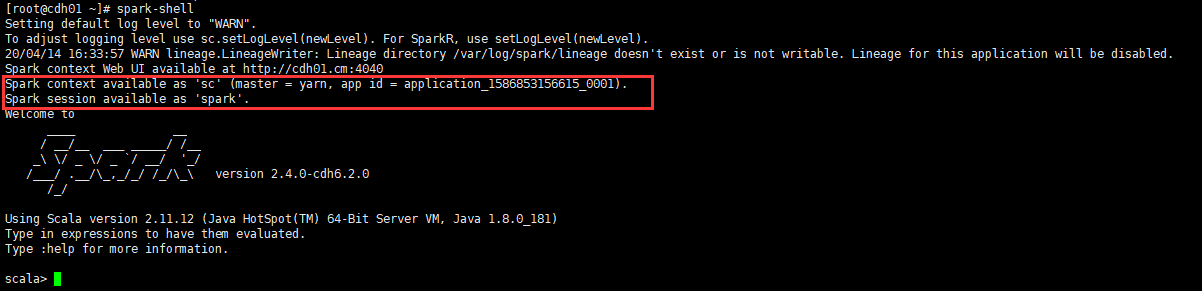

- Spark Shell方式

#创建word.txt文件

vim word.txt

#--->

hadoop hello spark

spark word

hello hadoop spark

#---<

#上传HDFS集群

hadoop dfs -put word.txt /

#链接客户端

spark-shell

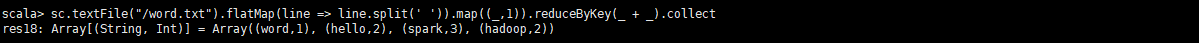

sc.textFile("/word.txt").flatMap(line => line.split(' ')).map((_,1)).reduceByKey(_ + _).collect

每个Spark应用程序都包含一个驱动程序,驱动程序负责把并行操作发布到集群上,驱动程序包含Spark应用中的主函数,定义了分布式数据集以应用在集群中,在前面的wordcount案例中,spark-shell就是我们的驱动程序,所以我们键入我们任何想要的操作,然后由它负责发布,驱动程序通过SparkContext对象来访问Spark,SparkContext对象相当于一个到Spark集群的链接

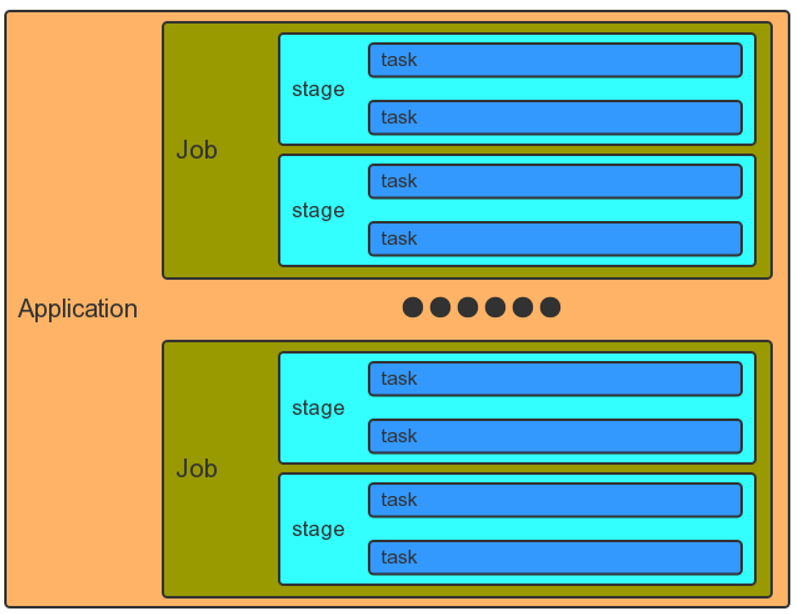

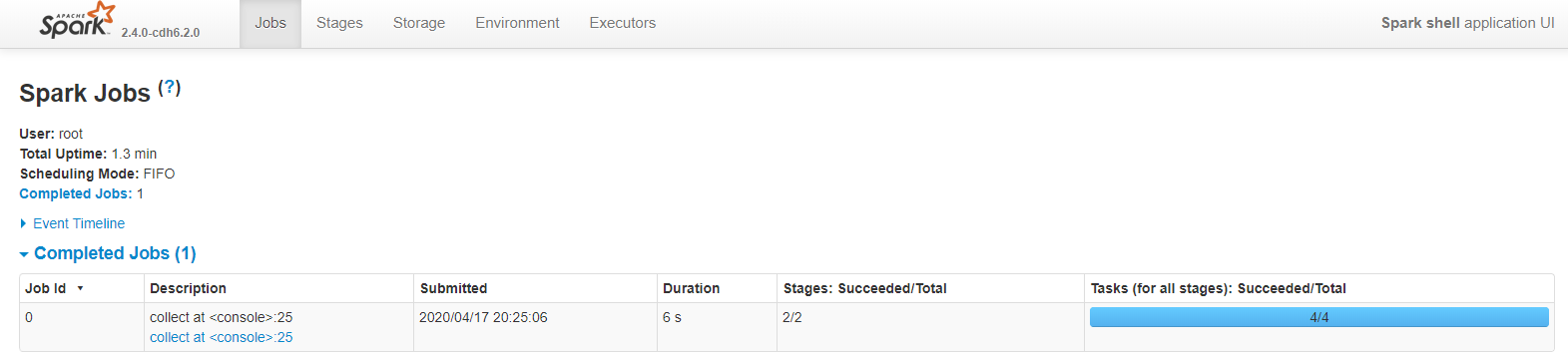

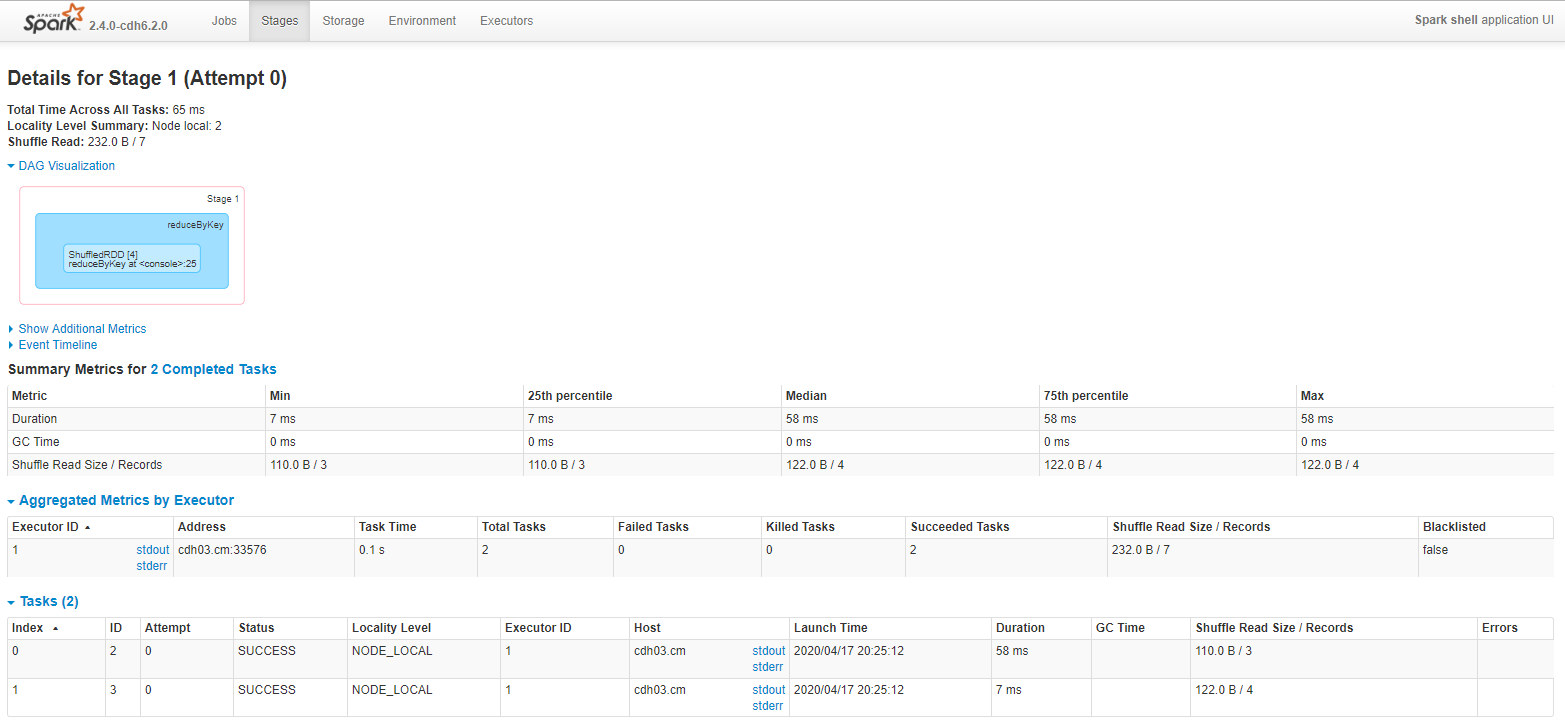

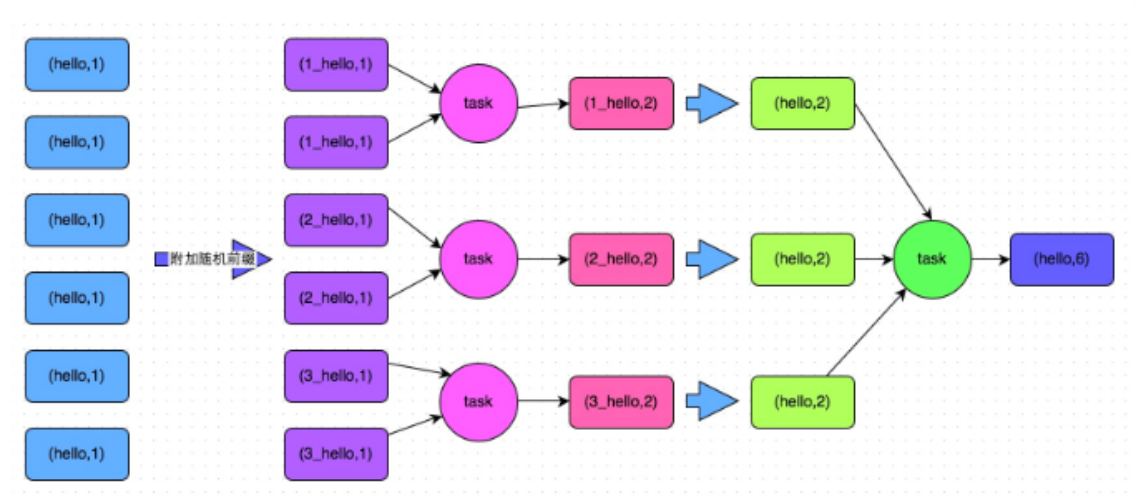

2.3 Job划分和调度

- Application应用

- 一个SparkContext就是一个Application

- Job作业:

- 一个行动算子(Action)就是一个Job

- Stage阶段:

- 一次宽依赖(一次shuffle)就是一个Stage,划分是从后往前划分

- Task任务:

- 一个核心就是一个Task,体现任务的并行度,常常根据核心数的1.5倍进行设置

- 使用WordCount案例分析

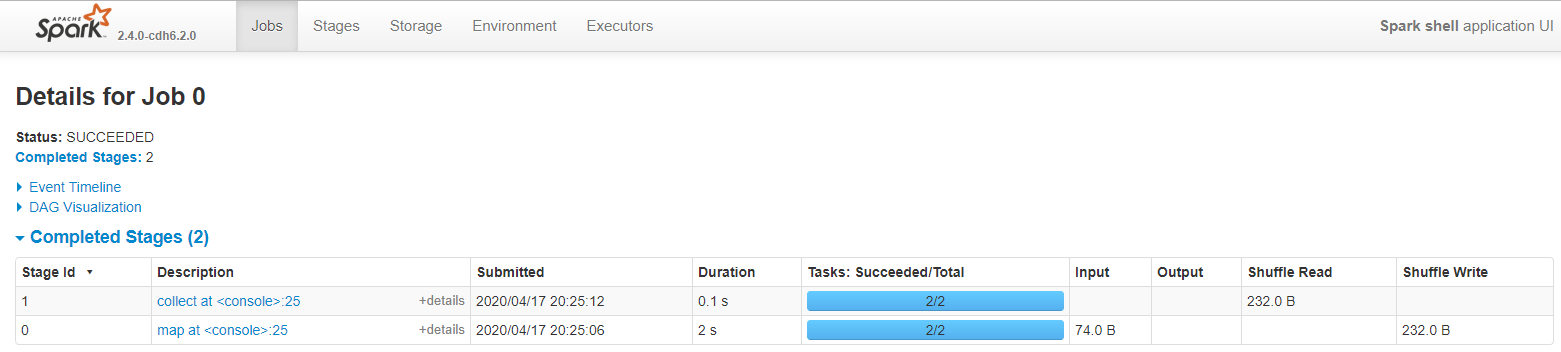

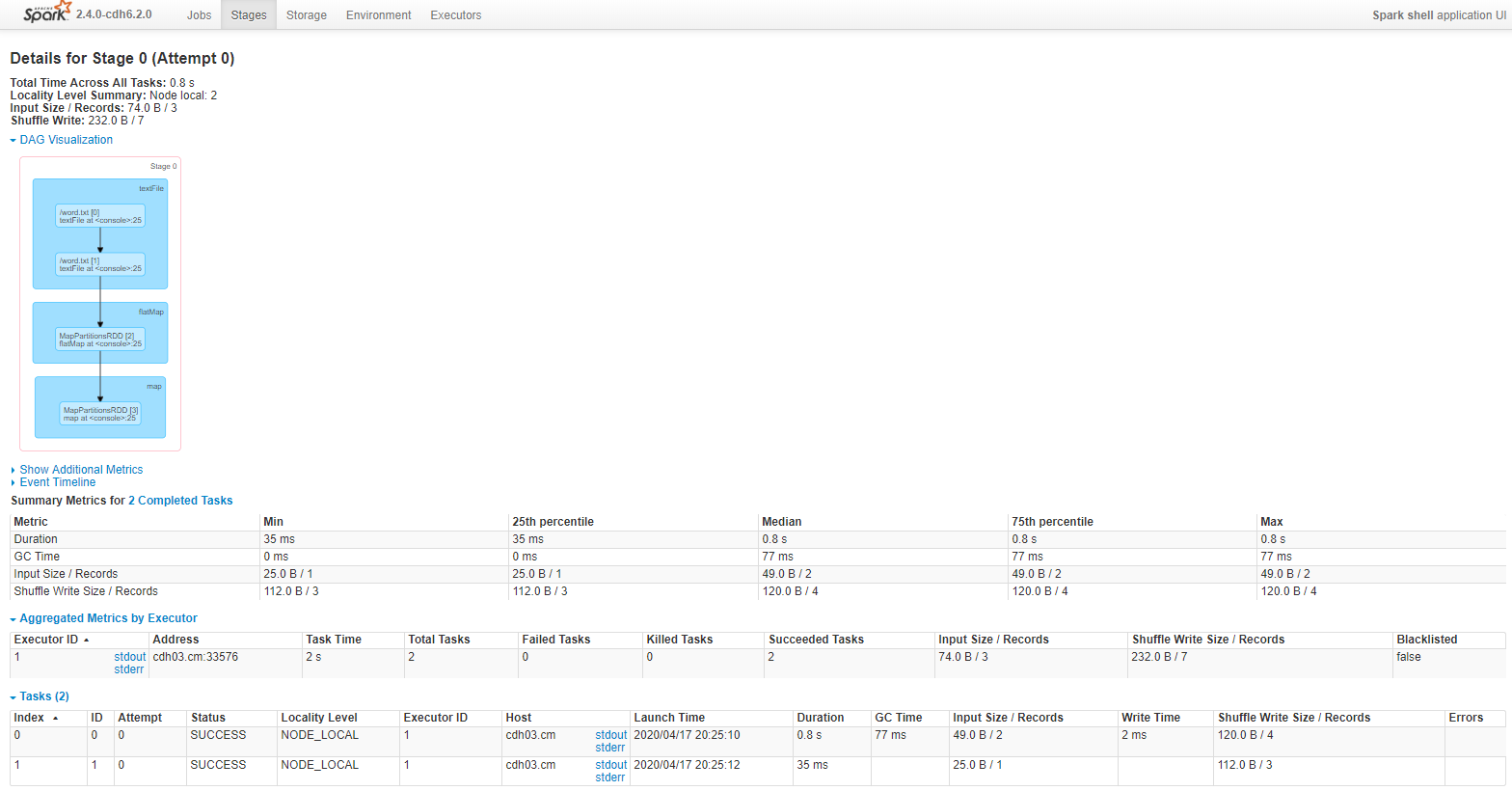

一个行动算子collect(),一个job

一次宽依赖shuffle算子reduceByKey(),切分成2个Stage阶段

Stage阶段,默认文件被切分成2份,所以有2个task

Stage阶段0

Stage阶段1

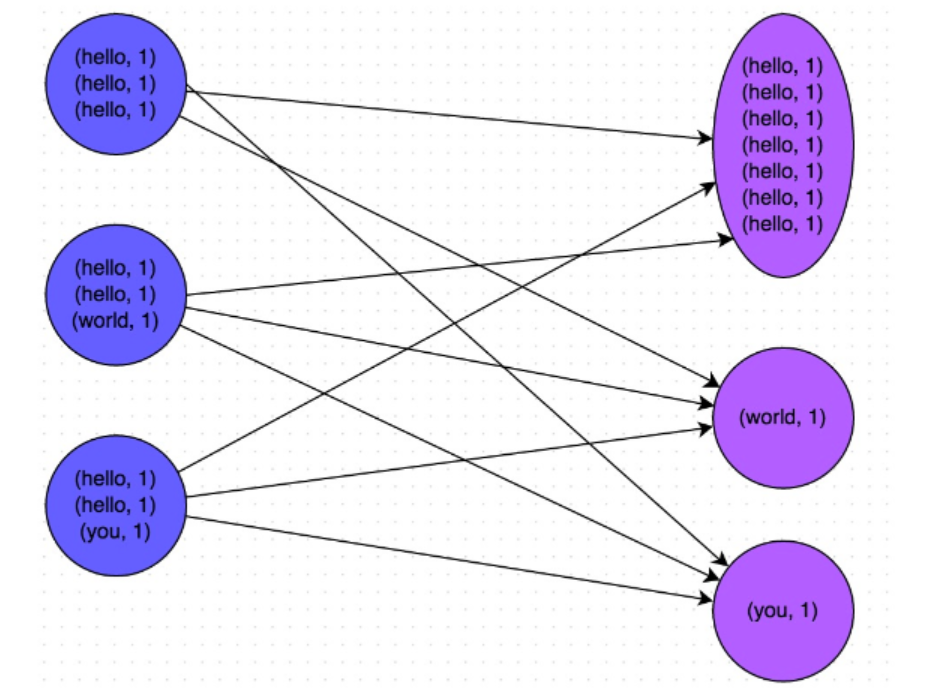

2.4 Shuffle洗牌

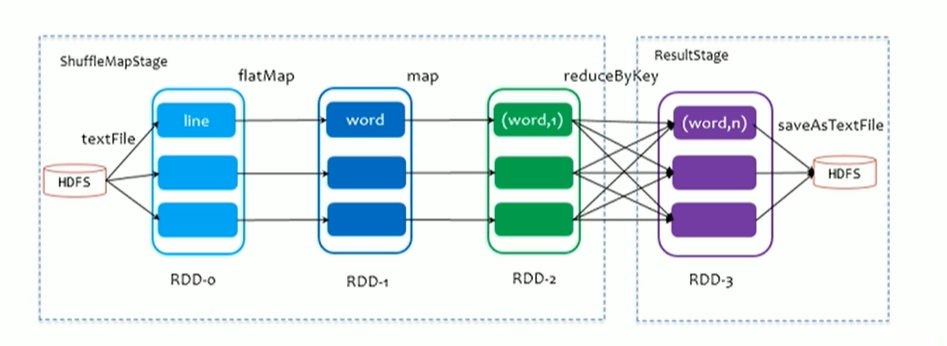

2.4.1 ShuffleMapStage And ResultStage

-

在划分stage时,最后一个stage称为FinalStage,本质上是一个ResultStage对象,前面所有的stage被称为ShuffleMapStage

-

ShuffleMapStage 的结束伴随着shuffle文件写磁盘

-

ResultStage对应代码中的action算子,即将一个函数应用在RDD的各个Partition(分区)的数据集上,意味着一个Job运行结束

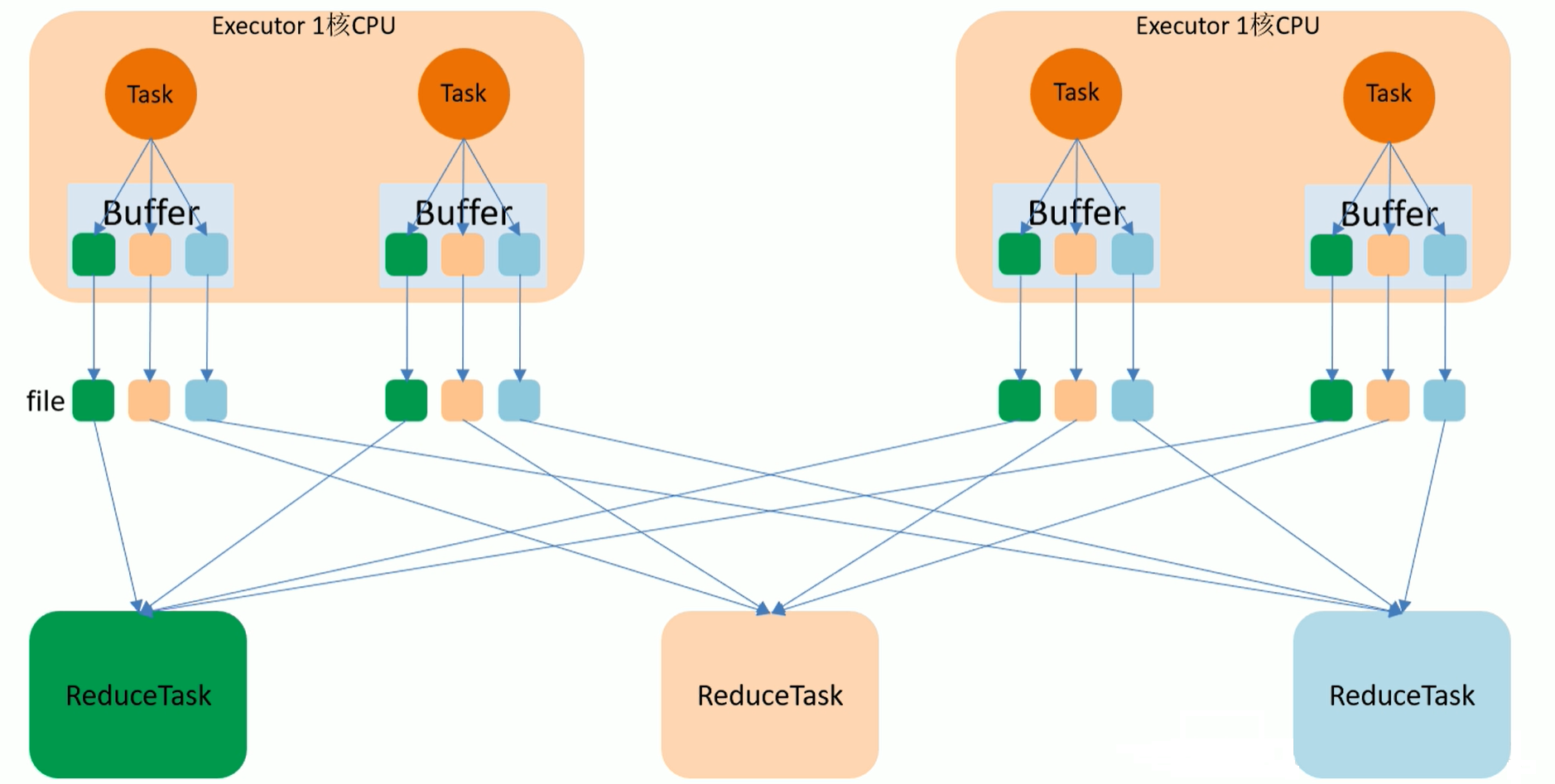

2.4.2 HashShuffle

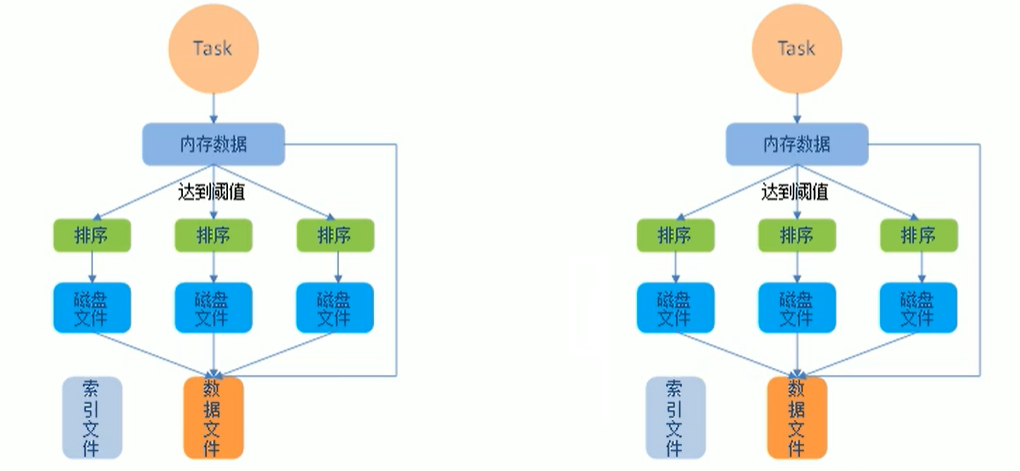

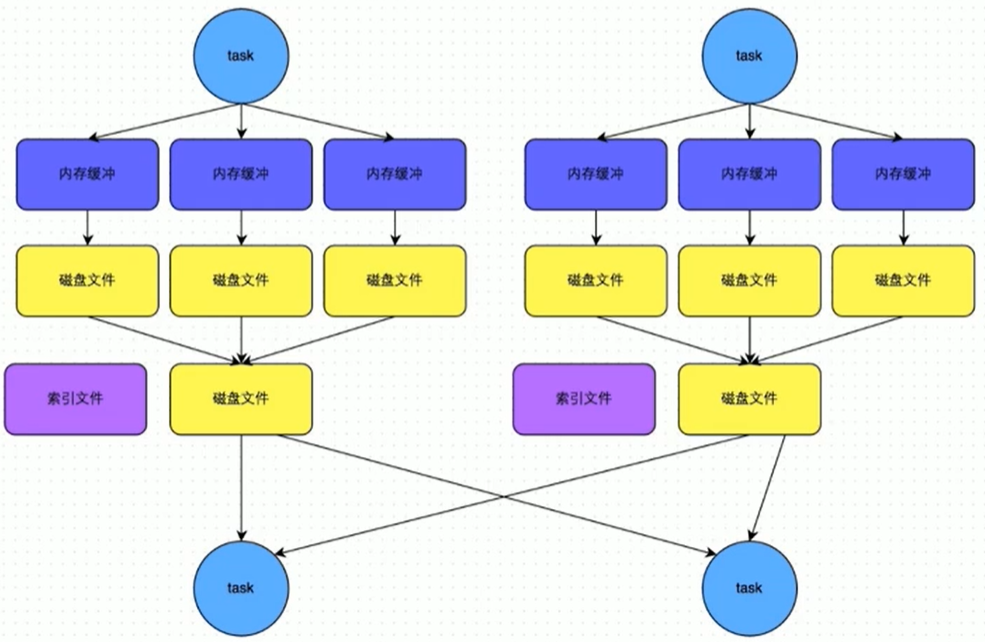

- 未优化HashShuffle流程图:目前已经没有了

如上图,最终结果会有12个小文件

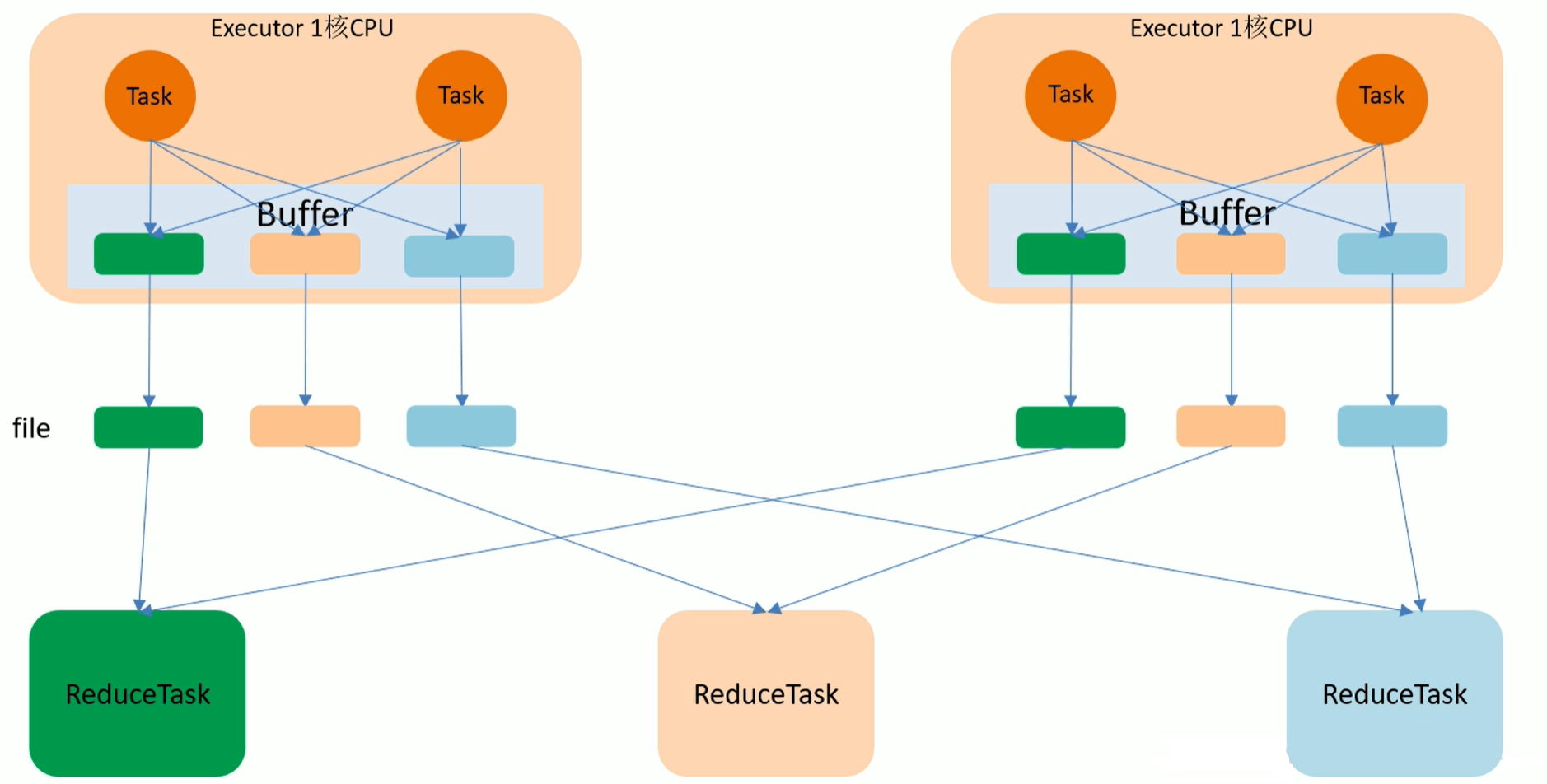

- 优化后HashShuffle流程图

如上图,最终结果会有6个小文件,比未优化前少了一半

2.4.3 SortShuffle

该模式下,数据会先写入一个数据结果,reduceByKey写入Map,一边通过Map局部聚合,一边写入内存,

Join算子写入ArrayList直接写入内存中,然后需要判断是否达到阀值,如果达到就会将内存数据写入磁盘,释放内存资源

2.4.4 Bypass SortShuffle

- Bypass SortShuffle运行机制触发条件

- shuffle map task 数量小于 spark.shuffle.sort.bypassMargeThreshold参数的值,默认为200

- 不是聚合类的shuffle算子

2.5 Submit语法

spark-submit \

--class <main-calss> \

--master <master-url> \

--deploy-mode <deploy-mode> \

--conf <key>=<value> \

... #其他 options

<application-jar> \

[application-arguments]

- --class:应用启动类全类名(如:org.apache.spark.examples.SparkPi)

- --master:指定master地址,默认本机Local(本地一般使用Local[*],集群一般使用yarn)

- --deploy-mode:是否发布到驱动worker节点(参数:cluster),或者作为一个本地客户端(参数:client),默认本地client

- --conf:任意Spark配置属性,格式key=value,如包含空格,可以加引号"key=value"

- application-jar:打包好的应用程序jar,包含依赖,这个URL在集群中全局课件,如HDFS上的jar->hdfs://path;如linux上的jar->file://path 且所有节点路径都需要包含这个jar

- application-arguments:给main()方法传参数

- --executor-memory 1G:指定每个executor可用内存为1G

- --total-executor-cores 6:指定所有executor使用的cpu核数为6个

- --executor-cores 2:表示每个executor使用的cpu的核数2个

2.6 Local模式

Local模式就是在一台计算机上运行Spark,通常用于开发中。(单机)

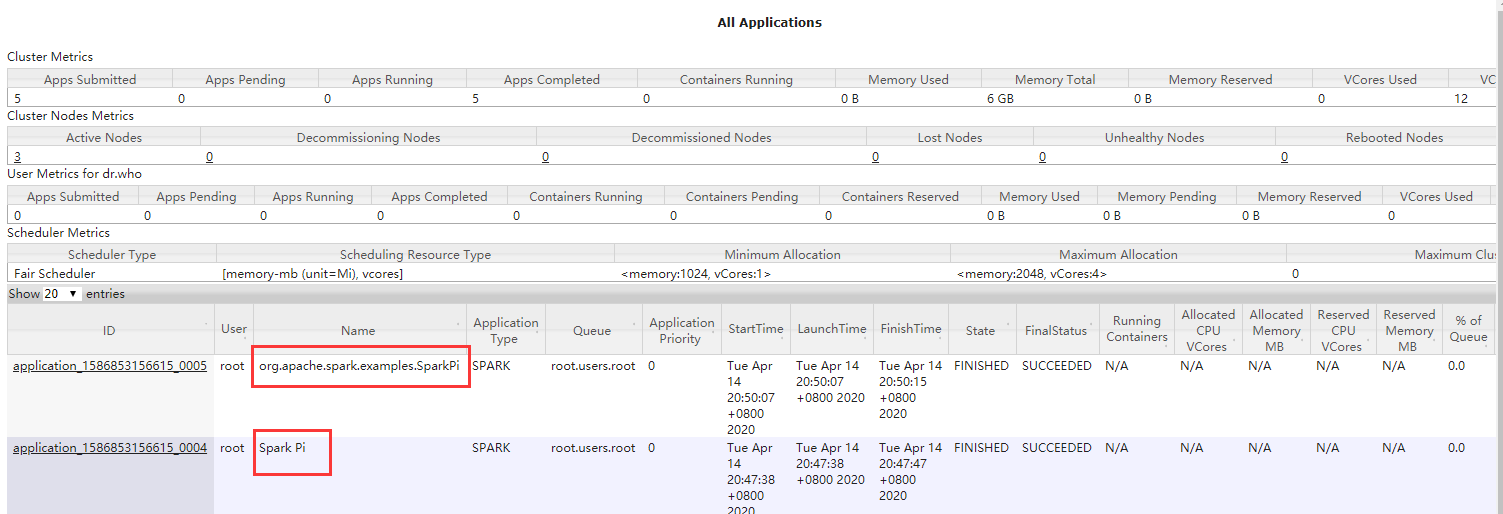

- Submit提交方式

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master local[*] \

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/spark/examples/jars/spark-examples_2.11-2.4.0-cdh6.2.0.jar 100

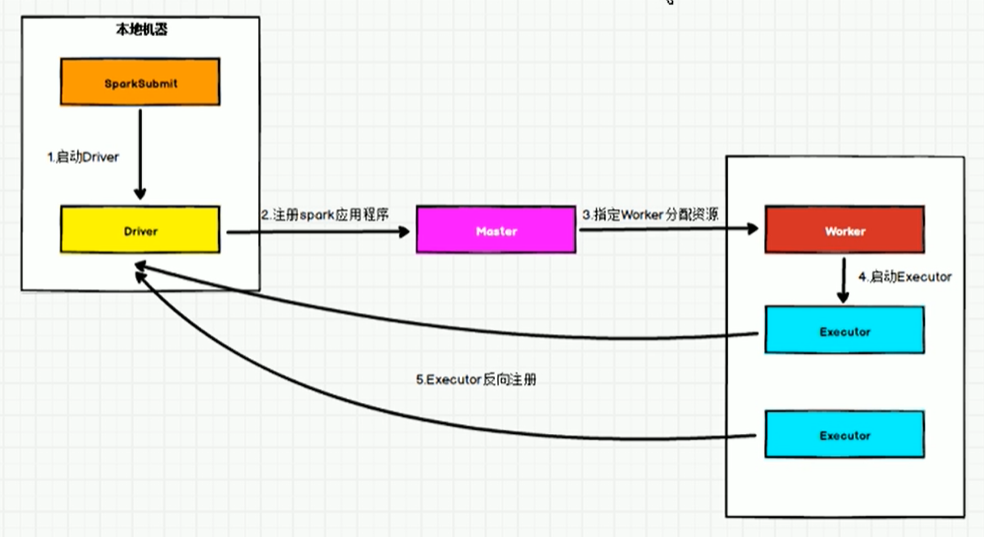

2.7 Standalone模式

构建一个由 Master + Slave 构成的Spark集群,Spark运行在集群中,只依赖Spark,不依赖别的组件(如:Yarn)。(独立的Spark集群)

#链接客户端

spark-shell --master spark://cdh01.cm:7337

参考wordCount案例

- Standalone-Client流程图

- Standalone-Cluster流程图

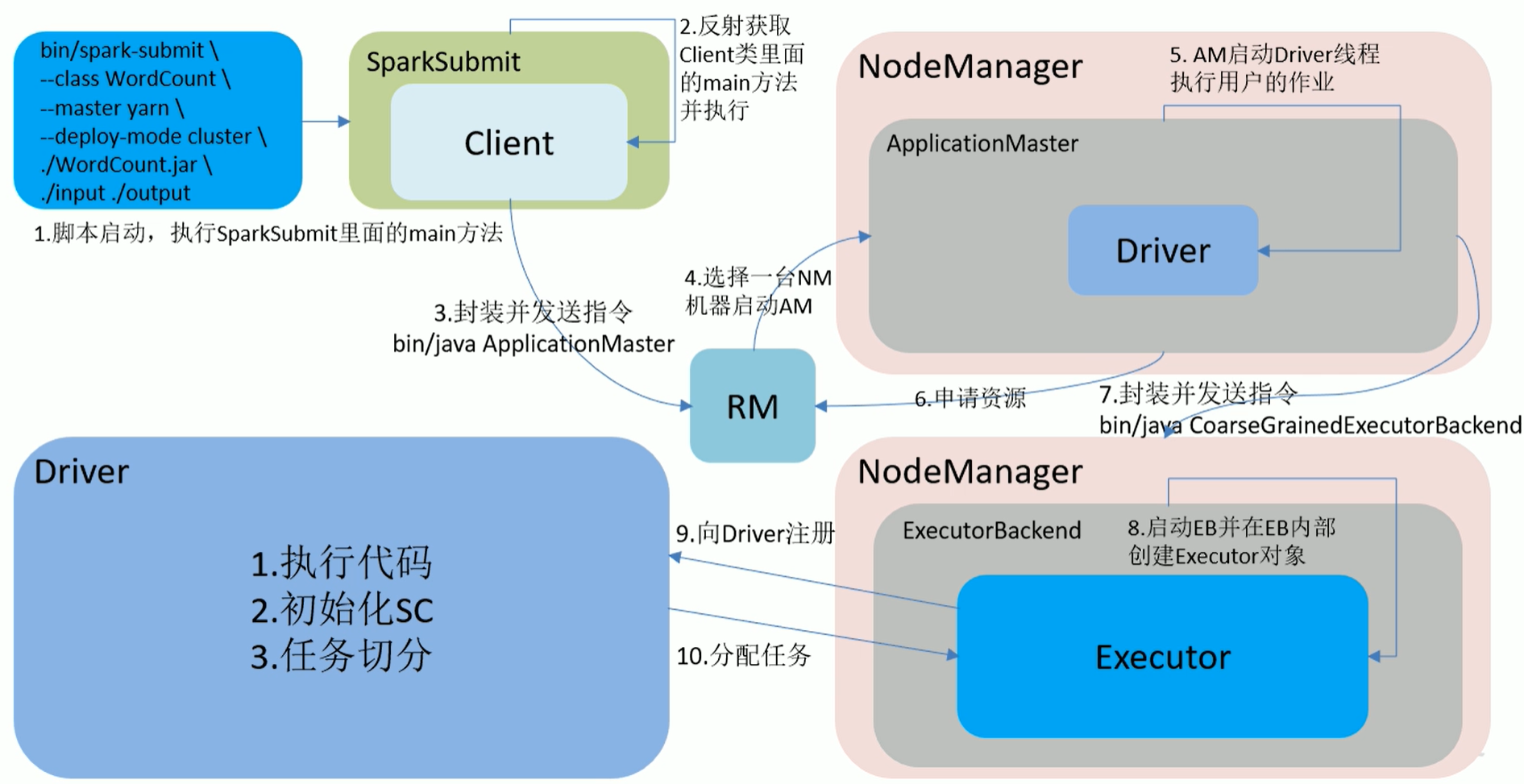

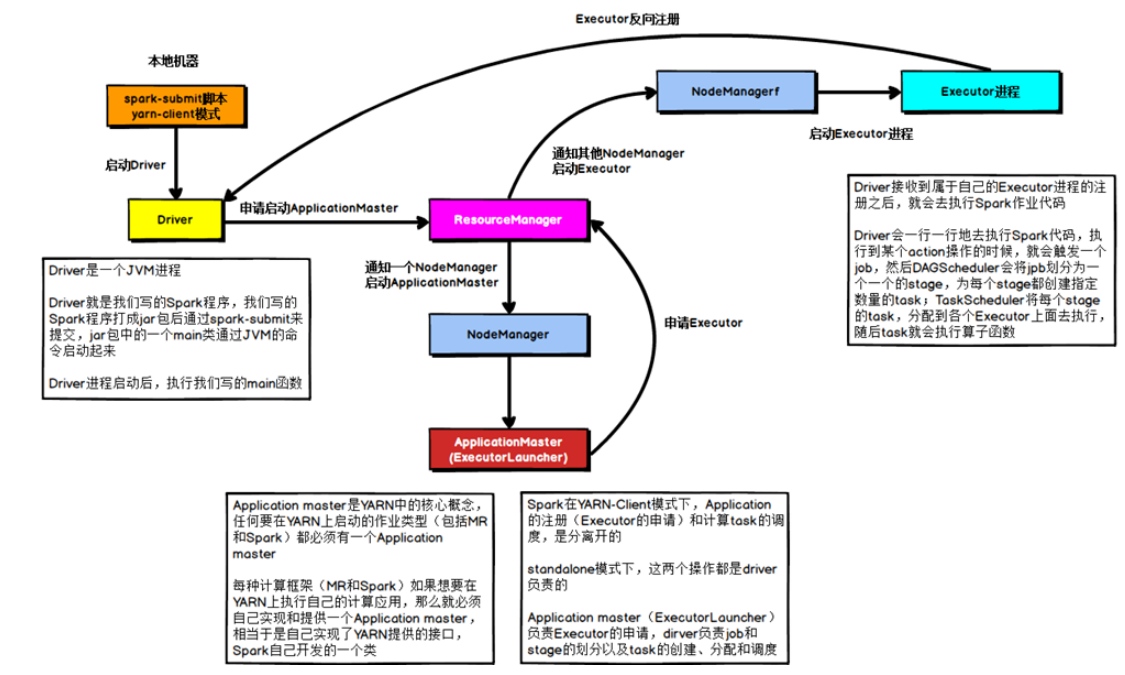

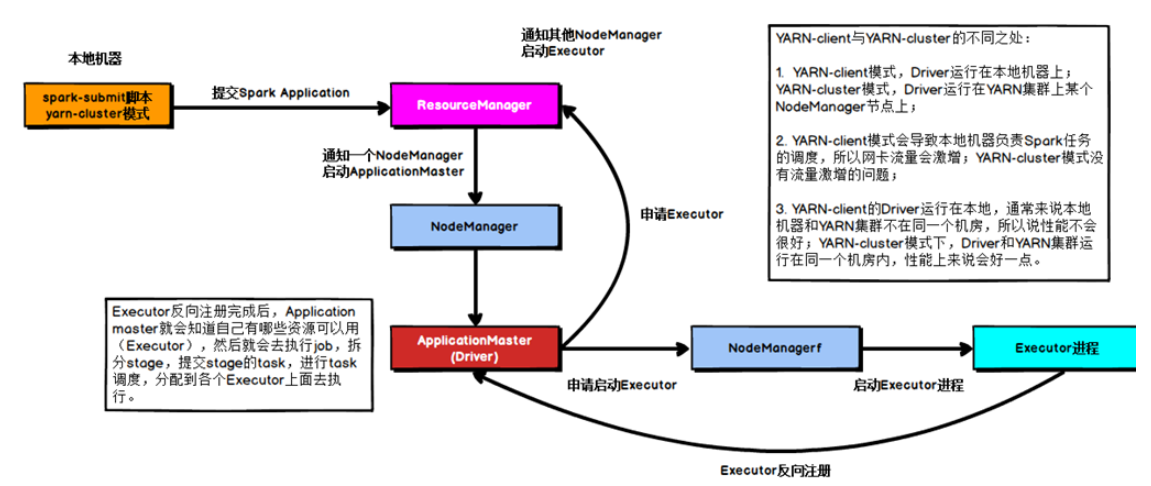

2.8 Yarn模式

Spark客户端可以直接连接Yarn,不需要构建Spark集群。

有yarn-client和yarn-cluster两种模式,主要区别在:Driver程序的运行节点不同。

yarn-client:Driver程序运行在客户端,适用于交互、调试,希望立即看见APP输出

yarn-cluster:Driver程序运行在由ResourceManager启动的ApplicationMaster上,适用于生产环境

- Yarn-Client流程图

- Yarn-Cluster流程图

- 客户端模式:Driver是在Client端,日志结果可以直接在后台看见

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode client \

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/spark/examples/jars/spark-examples_2.11-2.4.0-cdh6.2.0.jar 100

- 集群模式:Driver是在NodeManager端,日志结果需要通过监控日志查看

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode cluster \

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/spark/examples/jars/spark-examples_2.11-2.4.0-cdh6.2.0.jar 100

3 使用IDEA开发Spark

- pom.xml

<dependencies>

<!-- scala -->

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.11.12</version>

</dependency>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-compiler</artifactId>

<version>2.11.12</version>

</dependency>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-reflect</artifactId>

<version>2.11.12</version>

</dependency>

<!-- Spark Core -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.11</artifactId>

<version>2.4.0</version>

</dependency>

<!-- Spark SQL -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.11</artifactId>

<version>2.4.0</version>

</dependency>

<!-- Spark On Hive -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_2.11</artifactId>

<version>2.4.0</version>

</dependency>

<!-- Hbase On Spark-->

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-spark</artifactId>

<version>2.1.0-cdh6.2.0</version>

</dependency>

<!-- Spark Streaming -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_2.11</artifactId>

<version>2.4.0</version>

</dependency>

<!-- Spark Streaming Kafka-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming-kafka-0-10_2.11</artifactId>

<version>2.4.0</version>

</dependency>

<!-- Kafka -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka_2.12</artifactId>

<version>2.1.0</version>

</dependency>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-tools</artifactId>

<version>2.1.0</version>

</dependency>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.1.0</version>

</dependency>

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-examples</artifactId>

<version>2.1.0</version>

</dependency>

<!--mysql依赖的jar包-->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.47</version>

</dependency>

</dependencies>

<repositories>

<repository>

<id>cloudera</id>

<url>https://repository.cloudera.com/artifactory/cloudera-repos/</url>

</repository>

</repositories>

<build>

<plugins>

<!-- 在maven项目中既有java又有scala代码时配置 maven-scala-plugin 插件打包时可以将两类代码一起打包 -->

<plugin>

<groupId>org.scala-tools</groupId>

<artifactId>maven-scala-plugin</artifactId>

<version>2.15.2</version>

<executions>

<execution>

<goals>

<goal>compile</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

</plugin>

<plugin>

<!-- MAVEN 编译使用的JDK版本 -->

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.3</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

<encoding>UTF-8</encoding>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<version>3.0.0</version>

<executions>

<execution>

<phase>package</phase><!--绑定到package生命周期阶段-->

<goals>

<goal>single</goal><!--只运行一次-->

</goals>

</execution>

</executions>

<configuration>

<!--<finalName></finalName><!–主类入口–>-->

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-surefire-plugin</artifactId>

<version>2.10</version>

<configuration>

<skip>true</skip>

</configuration>

</plugin>

</plugins>

</build>

-

WorkCount案例

- 在resources文件夹下,新建word.csv文件

hello,spark hello,scala,hadoop hello,hdfs hello,spark,hadoop hello- WorkCount.scala

import org.apache.spark.{SparkConf, SparkContext} object WorkCount { def main(args: Array[String]): Unit = { val conf = new SparkConf().setAppName("WorkCount").setMaster("local[*]") val sc = new SparkContext(conf) val tuples: Array[(String, Int)] = sc.textFile(ClassLoader.getSystemResource("word.csv").getPath) .flatMap(_.split(",")) .map((_, 1)) .reduceByKey(_ + _) .collect() tuples.foreach(println) } }结果:

(scala,1)

(hello,5)

(spark,2)

(hadoop,2)

(hdfs,1)

4 Spark Core

4.1 什么是RDD

Resilient Distributed DataSet:弹性分布式数据集,是Spark中最基本数据抽象,可以理解为数据集合。

在代码中是一个抽象类,它代表一个弹性的、不可变的、可分区,里面的元素可并行计算的集合。

4.2 RDD的五个主要特性

- 分区性

- 多个分区,分区可以看成是数据集的基本组成单位

- 对于RDD来说,每个分区都会被一个计算任务处理,并决定了并行计算的粒度。

- 用户可以在创建RDD时,指定RDD的分区数,如果没有指定,那么采用默认值(程序所分配到的CPU Coure的数目)

- 每个分配的储存是由BlockManager实现的,每个分区都会被逻辑映射成BlockManager的一个Block,而这个Block会被一个Task负责计算。

- 计算每个分区的函数

- Spark中RDD的计算是以分区为单位的,每个RDD都会实现compute函数以达到这个目的

- 依赖性

- RDD的每次转换都会生成一个新的RDD,所以RDD之间会形成类似于流水线一样的前后依赖关系,在部分分区数据丢失时,Spark可以通过这个依赖关系重新计算丢失的分区数据,而不是对RDD的所有分区进行重新计算。

- 对储存键值对的RDD,还有一个可选的分区器

- 只有对key-value的RDD,才会有Partitioner,非key-value的RDD的Rartitioner的值是None

- Partitioner不但决定了RDD的分区数量,也决定了parent RDD Shuffle输出时的分区数量

- 默认是HashPartitioner,还有RangePartition,自定义分区

- 储存每个分区优先位置的列表(本地计算性)

- 比如对于一个HDFS文件来说,这个列表保存的就是每个Partition所在文件快的位置,按照“移动数据不如移动计算”的理念,Spark在进行任务调度的时候,会尽可能地将计算任务分配到其所要处理数据块的储存位置。

4.3 Transformation和Action算子

在Spark中,Transformation算子(也称转换算子),在没有Action算子(也称行动算子)去触发的时候,是不会执行的,可以理解为懒算子,而Action算子可以理解为触发算子,常用Action算子如下:

- redece:通过函数聚集RDD的所有元素,先聚合分区内的数据,在聚合分区间的数据(预聚合)

- collect:以数组的形式返回RDD中的所有元素,所有数据都会被拉到Driver端,内存开销很大,所以慎用

- count:返回RDD中元素个数

- take:返回RDD中前N个元素组成的数组

- first:返回RDD中的第一个元素,类似于tack(1)

- takeOrdered:返回排序后的前N个元素,默认升序,数据也会拉到Driver端

- aggregate:分区内聚合后,在分区间聚合

- fold:aggregate简化操作,如果分区内和分区间算法一样,则可以使用

- saveAsTextFile:将数据集的元素以textFile的形式保存到HDFS文件系统或者其他文件系统,对每个元素,Spark都会调用toString方法转换为文本

- saveAsSequenceFile:将数据集的元素以Hadoop SquenceFile的形式保存到指定目录下,可以是HDFS或者其他文件系统

- saveAsObjectFile:将RDD中的元素序列化成对象,储存到文件中

- countByKey:针对k-v类型RDD,返回一个Map(Key,count),可以用来查看数据是否倾斜

- foreach:针对RDD中的每一个元素都执行一次函数,每个函数实在Executor上执行的

常用Transformation算子如下:

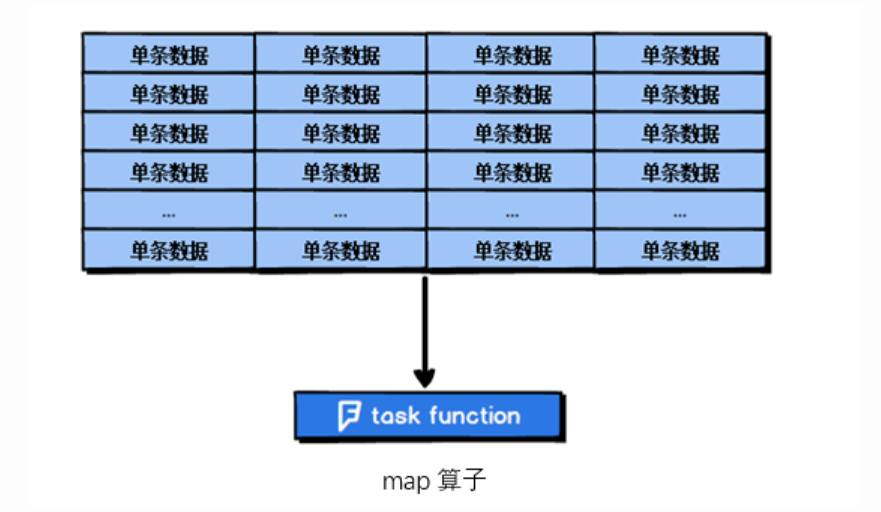

- map:输入变换函数应用于RDD中所有元素,转换其类型

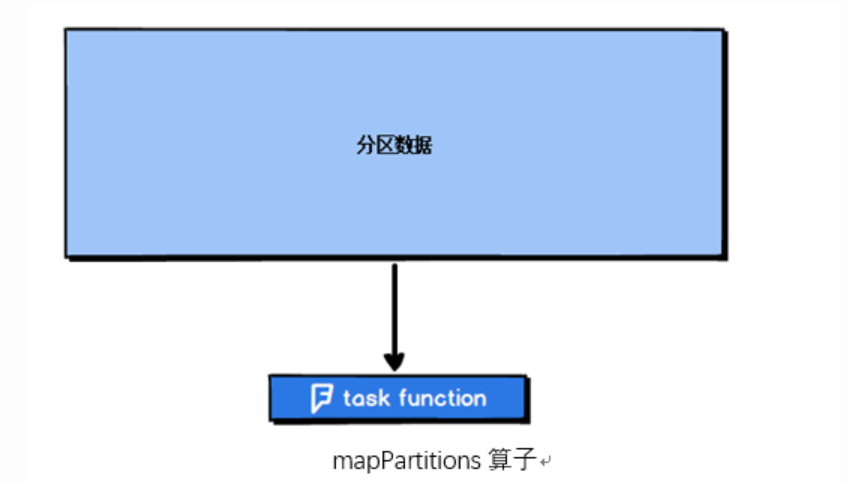

- mapPartitions:输入变换函数应用于每个分区中所有元素

- mapPartitionsWithIndex:输入变换函数应用于每个分区中所有元素,带有分区号

- filter:过滤算子

- flatMap:扁平化算子

- sample:抽样算子

- union:并集算子

- intersection:交集算子

- distinct:去重算子

- groupByKey:根据Key分组算子

- reduceByKey:根据Key聚合算子

- aggregateByKey:根据Key聚合算子

- sortByKey:根据Key排序算子

- join:链接算子

- coalesce:压缩分区算子

- repartition:重分区算子

4.4 RDD的创建

4.4.1 从集合中创建

object Demo {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("WorkCount").setMaster("local[*]")

val sc = new SparkContext(conf)

/**

* 通过parallelize方法传入序列得到RDD

* 传入分区数为1,结果为1 2 3 4 5 6 7 8 9 10

* 传入分区数大于1,结果顺序不定,因为数据被打散在2个分区里

* */

val rdd: RDD[Int] = sc.parallelize(1.to(10), 1)

rdd.foreach(x => print(x + "\t"))

}

}

4.4.2 从外部储存创建RDD

- 读取textFile

WordCount案例介绍了此种用法

- 读取Json文件

在idea中,resources目录下创建word.json文件

{"name": "zhangsa"}

{"name": "lisi", "age": 30}

{"name": "wangwu"}

["aa","bb"]

object Demo0 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("json").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.textFile(this.getClass().getClassLoader.getResource("word.json").getPath)

val rdd2: RDD[Option[Any]] = rdd1.map(JSON.parseFull(_))

rdd2.foreach(println)

/**

* Some(Map(name -> zhangsa))

* Some(Map(name -> wangwu))

* Some(List(aa, bb))

* Some(Map(name -> lisi, age -> 30.0))

* */

}

}

- 读取Object对象文件

object Demo1 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("object").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[Int] = sc.parallelize(Array(1,2,3,4,5))

// rdd1.saveAsObjectFile("hdfs://cdh01.cm/test")

val rdd2: RDD[Nothing] = sc.objectFile("hdfs://cdh01.cm/test")

rdd2.foreach(println)

/**

* 2

* 5

* 1

* 4

* 3

* */

}

}

4.4.3 从其他RDD转换得到新的RDD

- 根据RDD的数据类型的不同,整体分为2种RDD:Value类型,Key-Value类型(二维元组)

map()返回一个新的RDD,该RDD是由原RDD的每个元素经过函数转换后的值组成,主要作用就是转换结构。(不存在shuffle)

- 案例一:

object Demo2 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("map").setMaster("local[*]")

val sc = new SparkContext(conf)

/**

* map算子,一共有多少元素就会执行多少次,和分区数无关

**/

val rdd: RDD[Int] = sc.parallelize(1.to(10), 1)

val mapRdd: RDD[Int] = rdd.map(x => {

println("执行") //一共被执行10次

x * 2

})

val result: Array[Int] = mapRdd.collect()

result.foreach(x => print(x + "\t")) //2 4 6 8 10 12 14 16 18 20

}

}

- 案例二:

object demo3 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("mapPartitions").setMaster("local[*]")

val sc = new SparkContext(conf)

/**

* mapPartitions算子,一个分区内处理,几个分区就执行几次,优于map函数

**/

val rdd: RDD[Int] = sc.parallelize(1.to(10), 2)

val mapRdd: RDD[Int] = rdd.mapPartitions(it => {

println("执行") //分区2次,共打印2次

it.map(x => x * 2)

})

val result: Array[Int] = mapRdd.collect()

result.foreach(x => print(x + "\t")) //2 4 6 8 10 12 14 16 18 20

}

}

- 案例三:

object Demo4 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("mapPartitionsWithIndex").setMaster("local[*]")

val sc = new SparkContext(conf)

/**

* mapPartitionsWithIndex算子,一个分区内处理,几个分区就执行几次,返回带有分区号的结果集

**/

val rdd: RDD[Int] = sc.parallelize(1.to(10), 2)

val value: RDD[(Int, Int)] = rdd.mapPartitionsWithIndex((index, it) => it.map((index, _)))

val result: Array[(Int, Int)] = value.collect()

result.foreach(x => print(x + "\t")) //(0,1) (0,2) (0,3) (0,4) (0,5) (1,6) (1,7) (1,8) (1,9) (1,10)

}

}

4.5 flatMap

扁平化(不存在shuffle)

object Demo5 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("flatMap").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[(String, Int)] = sc.parallelize(Array(("A", 1), ("B", 2), ("C", 3)))

val map_result: RDD[String] = rdd.map(ele => ele._1 + ele._2)

val flatMap_result: RDD[Char] = rdd.flatMap(ele => ele._1 + ele._2)

/**

* C3

* A1

* B2

**/

map_result.foreach(println)

/**

* B

* A

* C

* 1

* 2

* 3

**/

flatMap_result.foreach(println)

}

}

4.6 glom

将每一个分区的元素合并成一个数组,形成新的RDD类型:RDD[Array[T]] (不存在shuffle)

object Demo6 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("glom").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1.to(10), 3)

val result: RDD[Array[Int]] = rdd.glom()

/**

* 1,2,3

* 7,8,9,10

* 4,5,6

* */

result.foreach(x=>{

println(x.toList.mkString(","))

})

}

}

4.7 groupBy

根据条件函数分组(存在shuffle)

object Demo7 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("groupBy").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1.to(10))

val result1: RDD[(Int, Iterable[Int])] = rdd.groupBy(x => x % 2)

val result2: RDD[(Boolean, Iterable[Int])] = rdd.groupBy(x => x % 2 == 0)

/**

* (0,CompactBuffer(2, 4, 6, 8, 10))

* (1,CompactBuffer(1, 3, 5, 7, 9))

**/

result1.foreach(println)

/**

* (true,CompactBuffer(2, 4, 6, 8, 10))

* (false,CompactBuffer(1, 3, 5, 7, 9))

**/

result2.foreach(println)

}

}

4.8 filter

过滤(不存在shuffle)

object Demo8 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("filter").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1.to(10))

val result: RDD[Int] = rdd.filter(x => x % 2 == 0)

result.foreach(x => print(x + "\t")) //6 10 8 4 2

}

}

4.9 sample

sample(withReplacement,fraction,seed)抽样,常用在解决定位大key问题

- 以指定的随机种子随机抽样出比例为fraction的数据(抽取到的数量是size*fraction),注意:得到的结果并不能保证准确的比例,也就是说fraction只决定了这个数被选中的比率,并不是从数据中抽出多少百分比的数据,决定的不是个数,而是比率。

- withReplacement表示抽出的数据是否放回,true为有放回抽样,flase为无放回抽样,放回表示数据有可能会被重复抽取到,false则不可能重复抽取到,如果为false则fraction必须在[0,1]内,是true则大于0即可。

- seed用于指定随机数生成器种子,一般默认的,或者传入当前的时间戳,(如果传入定值,每次取出结果一样)

object Demo9 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("sample").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1.to(10))

/**

* 不放回抽样

* 从结果中可以看出,抽出结果没有重复

* */

val result1: RDD[Int] = rdd.sample(false,0.5)

result1.foreach(println)

/**

* 放回抽样

* 从结果中可以看出,抽出结果有重复

* */

val result2: RDD[Int] = rdd.sample(true,2)

result2.foreach(println)

}

}

4.10 distinct

distinct([numTasks])去重,参数表示任务数量,默认值和分区数保持一致(不存在shuffle)

object Demo10 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("distinct").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(Array(1,2,3,4,2,3,4,3,4,5))

val result: RDD[Int] = rdd.distinct(2)

result.foreach(println)

}

}

4.11 coalesce

coalesce(numPatitions)缩减,缩减分区到指定数量,用于大数据集过滤后,提高小数据集的执行效率,只能减不能加。(不存在shuffle)

object Demo11 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("coalesce").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1.to(10),5)

println(rdd.partitions.length) //5

val result: RDD[Int] = rdd.coalesce(2)

println(result.partitions.length) //2

}

}

4.12 repartition

repartition(numPatitions)更改分区,更改分区到指定数量,可加可减,但是减少还是使用coalesce,将这个理解为增加。(存在shuffle)

object Demo12 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("repartition").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1.to(10),2)

println(rdd.partitions.length) //2

val result: RDD[Int] = rdd.repartition(5)

println(result.partitions.length) //5

}

}

4.13 sortBy

排序(存在shuffle)

object Demo13 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("sortBy").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(Array(4, 2, 3, 1, 5), 1)

val result1: RDD[Int] = rdd.sortBy(x => x, false)

result1.foreach(x => print(x + "\t")) //5 4 3 2 1

val result2: RDD[Int] = rdd.sortBy(x => x, true)

result2.foreach(x => print(x + "\t")) //1 2 3 4 5

}

}

4.14 RDD与RDD互交

- 并集:union

- 差集:subtract

- 交集:intersection

- 笛卡尔积:cartesian

- 拉链:zip

object Demo14 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("RDD AND RDD").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[Int] = sc.parallelize(1.to(5))

val rdd2: RDD[Int] = sc.parallelize(3.to(8))

//并集

rdd1.union(rdd2).collect().foreach(x => print(x + "\t")) //1 2 3 4 5 3 4 5 6 7 8

//差集

rdd1.subtract(rdd2).collect().foreach(x => print(x + "\t")) //1 2

//交集

rdd1.intersection(rdd2).collect().foreach(x => print(x + "\t")) //3 4 5\

//笛卡尔积

/*(1,3) (1,4) (1,5) (1,6) (1,7) (1,8)

(2,3) (2,4) (2,5) (2,6) (2,7) (2,8)

(3,3) (3,4) (3,5) (3,6) (3,7) (3,8)

(4,3) (4,4) (4,5) (4,6) (4,7) (4,8)

(5,3) (5,4) (5,5) (5,6) (5,7) (5,8)*/

rdd1.cartesian(rdd2).collect().foreach(x => print(x + "\t"))

//拉链:必须保证RDD分区元素数量相同

val rdd3: RDD[Int] = sc.parallelize(1.to(5))

val rdd4: RDD[Int] = sc.parallelize(2.to(6))

rdd3.zip(rdd4).collect().foreach(x => print(x + "\t")) //(1,2) (2,3) (3,4) (4,5) (5,6)

}

}

4.15 k-v类型 partitionBy

大多数Spark算子都可以用在任意类型的RDD上,但是有一些比较特殊的操作只能用在key-value类型的RDD上

使用HashPartitioner分区器

object Demo15 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("partitionBy").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

println(rdd2.partitions.length) //1

println(rdd2.partitioner) //None

val rdd3: RDD[(String, Int)] = rdd2.partitionBy(new HashPartitioner(2))

println(rdd3.partitions.length) //2

println(rdd3.partitioner) //Some(org.apache.spark.HashPartitioner@2)

val result: RDD[(Int, (String, Int))] = rdd3.mapPartitionsWithIndex((index, it) => {

it.map(x => (index, (x._1, x._2)))

})

result.foreach(println)

/**

* (1,(spark,1))

* (0,(hello,1))

* (0,(hadooop,1))

* (0,(hello,1))

**/

}

}

自定义分区器

object Demo16 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("partitionBy").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

println(rdd2.partitions.length) //1

println(rdd2.partitioner) //None

val rdd3: RDD[(String, Int)] = rdd2.partitionBy(new MyPatitioner(2))

println(rdd3.partitions.length) //2

println(rdd3.partitioner) //Some(com.test.sparkcore.MyPatitioner@769a58e5)

val result: RDD[(Int, (String, Int))] = rdd3.mapPartitionsWithIndex((index, it) => {

it.map(x => (index, (x._1, x._2)))

})

result.foreach(println)

/**

* (0,(hadooop,1))

* (1,(hello,1))

* (0,(spark,1))

* (1,(hello,1))

**/

}

}

class MyPatitioner(num: Int) extends Partitioner {

override def numPartitions: Int = num

override def getPartition(key: Any): Int = {

System.identityHashCode(key) % num.abs

}

}

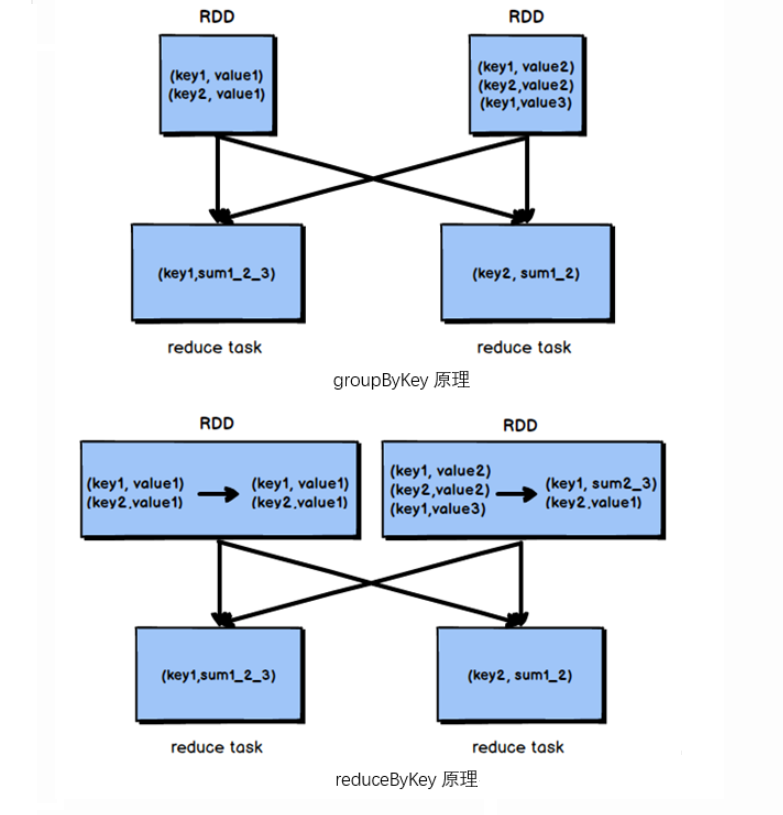

4.16 k-v类型 reduceByKey

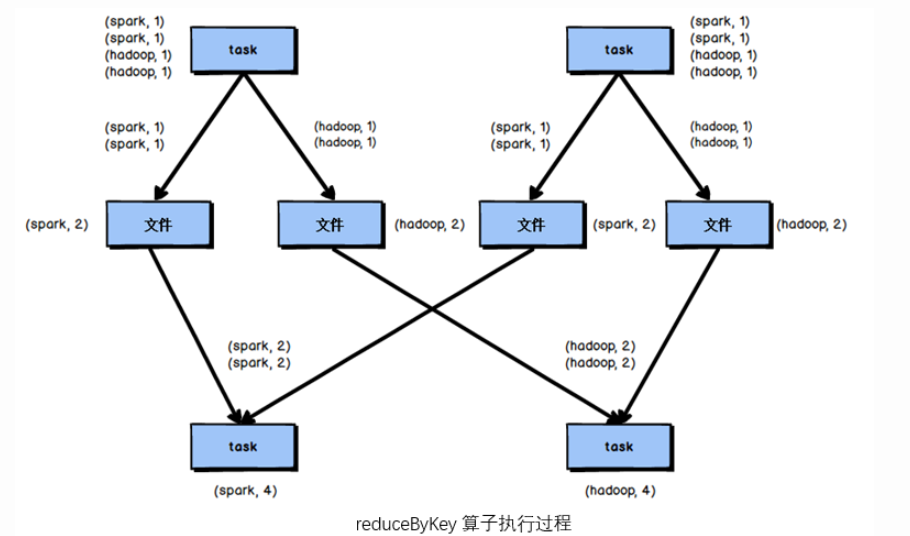

reduceByKey(V , V)=>V 根据key进行聚合,在shuffle之前会有combine(预聚合)操作

object Demo17 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("reduceByKey").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

val result: RDD[(String, Int)] = rdd2.reduceByKey(_ + _)

result.foreach(x => print(x + "\t")) //(spark,1) (hadooop,1) (hello,2)

}

}

4.17 k-v类型 groupByKey

根据key进行分组,直接shuffle

object Demo18 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("groupByKey").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

val result: RDD[(String, Iterable[Int])] = rdd2.groupByKey()

result.foreach(x => print(x + "\t")) //(spark,CompactBuffer(1)) (hadooop,CompactBuffer(1)) (hello,CompactBuffer(1, 1))

result.map(x=>(x._1,x._2.size)).foreach(x => print(x + "\t")) //(spark,1) (hadooop,1) (hello,2)

}

}

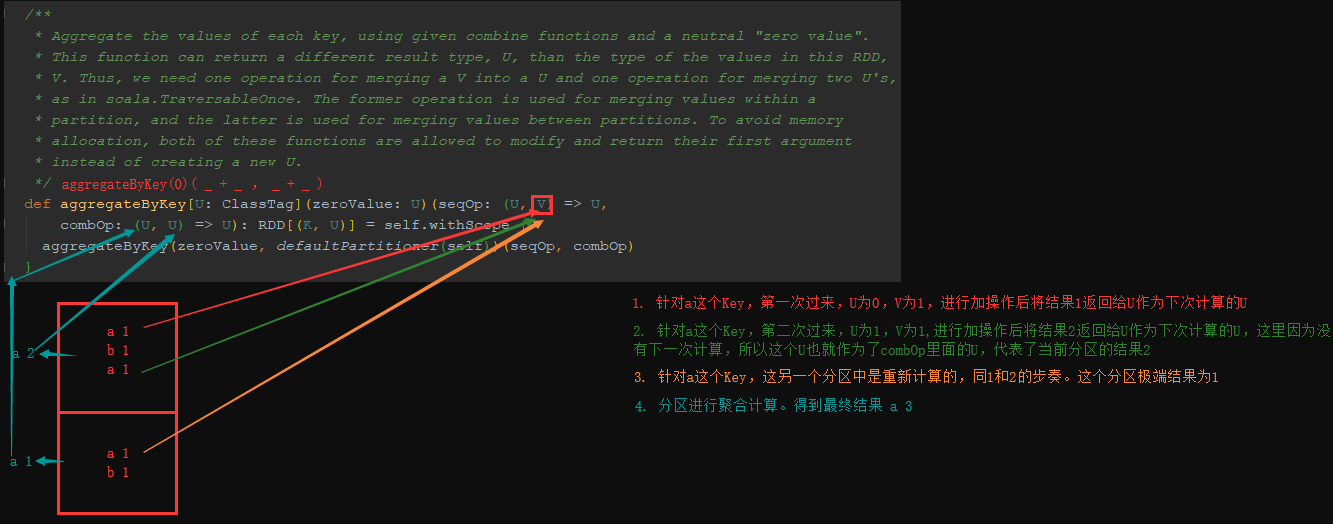

4.18 k-v类型 aggrateByKey

aggrateByKey(zero : U)(( U , V )=>U , (U , U)=>U)

基于Key分组然后去聚合的操作,耗费资源太多,这时可以使用reduceByKey或aggrateByKey算子去提高性能

aggrateByKey分区内聚合,后在进行shuffle聚合。

object Demo19 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("aggregateByKey").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

val result: RDD[(String, Int)] = rdd2.aggregateByKey(0)(_ + _, _ + _)

result.foreach(x => print(x + "\t")) //(spark,1) (hadooop,1) (hello,2)

}

}

4.19 k-v类型 foldByKey

foldByKey(zero : V)((V , V)=>V) 折叠计算,没有aggrateByKey灵活,如果分区内和分区外聚合计算不一样,则不行

object Demo20 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("foldByKey").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

val result: RDD[(String, Int)] = rdd2.foldByKey(0)(_+_)

result.foreach(x => print(x + "\t")) //(spark,1) (hadooop,1) (hello,2)

}

}

4.20 k-v类型 combineByKey

combineByKey(V=>U,(U , V)=>U , (U , U)=>U) 根据Key组合计算

object Demo21 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("combineByKey").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

val result: RDD[(String, Int)] = rdd2.combineByKey(v => v, (c: Int, v: Int) => c + v, (c1: Int, c2: Int) => c1 + c2)

result.foreach(x => print(x + "\t")) //(spark,1) (hadooop,1) (hello,2)

}

}

4.21 k-v类型 sortByKey

根据Key排序

object Demo22 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("sortByKey").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("ahello", "bhadooop", "chello", "dspark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

rdd2.sortByKey(false).foreach(x => print(x + "\t")) //(dspark,1) (chello,1) (bhadooop,1) (ahello,1)

}

}

4.22 k-v类型 mapValues

只对value操作的map转换操作

object Demo23 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("mapValues").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hello", "hadooop", "hello", "spark"), 1)

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

rdd2.mapValues(x => x + 1).foreach(x => print(x + "\t")) //(hello,2) (hadooop,2) (hello,2) (spark,2)

}

}

4.23 k-v类型 join

object Demo24 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("join").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[(String, Int)] = sc.parallelize(Array(("a",10),("b",10),("a",20),("d",10)))

val rdd2: RDD[(String, Int)] = sc.parallelize(Array(("a",30),("b",20),("c",10)))

//内连接 (a,(10,30)) (b,(10,20)) (a,(20,30))

rdd1.join(rdd2).foreach(x => print(x + "\t"))

//左链接(b,(10,Some(20))) (d,(10,None)) (a,(10,Some(30))) (a,(20,Some(30)))

rdd1.leftOuterJoin(rdd2).foreach(x => print(x + "\t"))

//右链接(c,(None,10)) (a,(Some(10),30)) (b,(Some(10),20)) (a,(Some(20),30))

rdd1.rightOuterJoin(rdd2).foreach(x => print(x + "\t"))

//全链接(b,(Some(10),Some(20))) (c,(None,Some(10))) (d,(Some(10),None)) (a,(Some(10),Some(30))) (a,(Some(20),Some(30)))

rdd1.fullOuterJoin(rdd2).foreach(x => print(x + "\t"))

}

}

4.24 k-v类型 cogroup

根据Key聚合RDD

object Demo25 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("cogroup").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[(String, Int)] = sc.parallelize(Array(("a",10),("b",10),("a",20),("d",10)))

val rdd2: RDD[(String, Int)] = sc.parallelize(Array(("a",30),("b",20),("c",10)))

/**

* (c,(CompactBuffer(),CompactBuffer(10)))

* (b,(CompactBuffer(10),CompactBuffer(20)))

* (a,(CompactBuffer(10, 20),CompactBuffer(30)))

* (d,(CompactBuffer(10),CompactBuffer()))

*/

rdd1.cogroup(rdd2).foreach(println)

}

}

4.25 keyo序列化

在分布式应用中,经常会进行IO操作,传递对象,而网络传输过程中就必须要序列化。

Java序列化可以序列化任何类,比较灵活,但是相当慢,并且序列化后对象的提交也比较大。

Spark出于性能考虑,在2.0以后,开始支持kryo序列化机制,速度是Serializable的10倍以上,当RDD在Shuffle数据的时候,简单数据类型,简单数据类型数组,字符串类型已经使用kryo来序列化。

object Demo26 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf()

.setAppName("keyo")

.setMaster("local[*]")

//替换默认序列化机制

.set("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

//注册需要使用的kryo序列化自定义类

.registerKryoClasses(Array(classOf[MySearcher]))

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("hadoop yarn", "hadoop hdfs", "c"))

val rdd2: RDD[String] = MySearcher("hadoop").getMathcRddByQuery(rdd1)

rdd2.foreach(println)

}

}

case class MySearcher(val query: String) {

def getMathcRddByQuery(rdd: RDD[String]): RDD[String] = {

rdd.filter(x => x.contains(query))

}

}

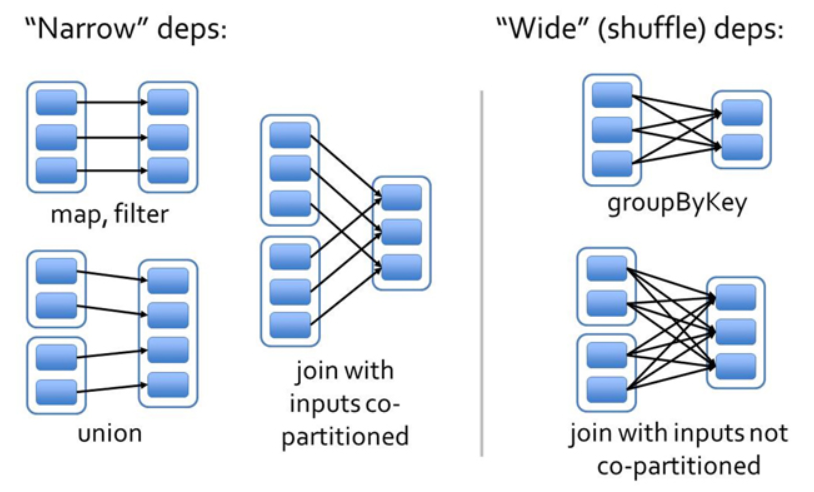

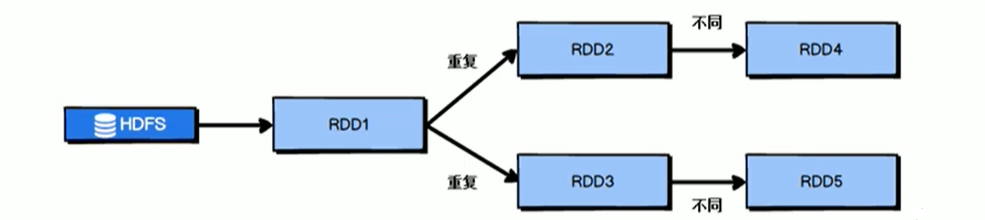

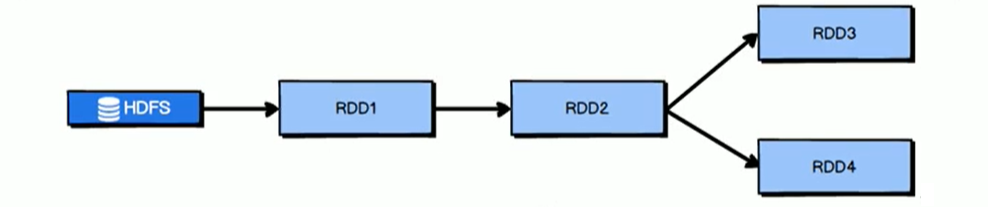

4.26 依赖

-

窄依赖:(不会shuffle)

- 如果RDD2由RDD1计算得到,则RDD2就是子RDD,RDD1就是父RDD

- 如果依赖关系在设计的时候就可以确定,而不需要考虑父RDD分区中的记录,并且父RDD中的每个分区最多只有一个子分区,这就叫窄依赖

- 父RDD的每个分区中的数据最多被一个子RDD的分区使用

-

宽依赖:(会shuffle)

- 宽依赖往往对应着shuffle操作,需要在运行过程中将同一个父RDD的分区传入到不同的子RDD分区中。

- 对于宽依赖,重算的父RDD分区对应多个子RDD分区,这样实际上父RDD 中只有一部分的数据是被用于恢复这个丢失的子RDD分区的,另一部分对应子RDD的其它未丢失分区,这就造成了多余的计算;

- 宽依赖中子RDD分区通常来自多个父RDD分区,极端情况下,所有的父RDD分区都要进行重新计算。

4.27 持久化

object Demo27 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("cache").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[String] = sc.parallelize(Array("a", "b", "c"))

val rdd2: RDD[String] = rdd1.flatMap(x => {

println("执行flatMap操作")

x.split("")

})

val rdd3: RDD[(String, Int)] = rdd2.map((_, 1))

/** 持久化到内存 */

//rdd3.cache() //持久化到内存

/**

* 持久化到磁盘

* DISK_ONLY:持久化到磁盘

* DISK_ONLY_2:持久化到磁盘并且存一个副本(2个文件)

* MEMORY_ONLY:持久化到内存

* MEMORY_ONLY_2:持久化到内存并且存一个副本(2个文件)

* MEMORY_ONLY_SER:持久化到内存,并且序列化

* MEMORY_ONLY_SER_2:持久化到内存,并且序列化,还要存一个副本(2个文件)

* MEMORY_AND_DISK:持久化到内存和磁盘

* MEMORY_AND_DISK_2:持久化到内存和磁盘并且存一个副本(2个文件)

* MEMORY_AND_DISK_SER:持久化到内存和磁盘,并且序列化

* MEMORY_AND_DISK_SER_2:持久化到内存和磁盘,并且序列化,还要存一个副本(2个文件)

* OFF_HEAP:持久化在堆外内存中,Spark自己管理的内存

* */

rdd3.persist(StorageLevel.DISK_ONLY) //持久化到磁盘

rdd3.collect.foreach(x => print(x + "\t"))

println("------------")

//输出语句不会执行

rdd3.collect.foreach(x => print(x + "\t"))

}

}

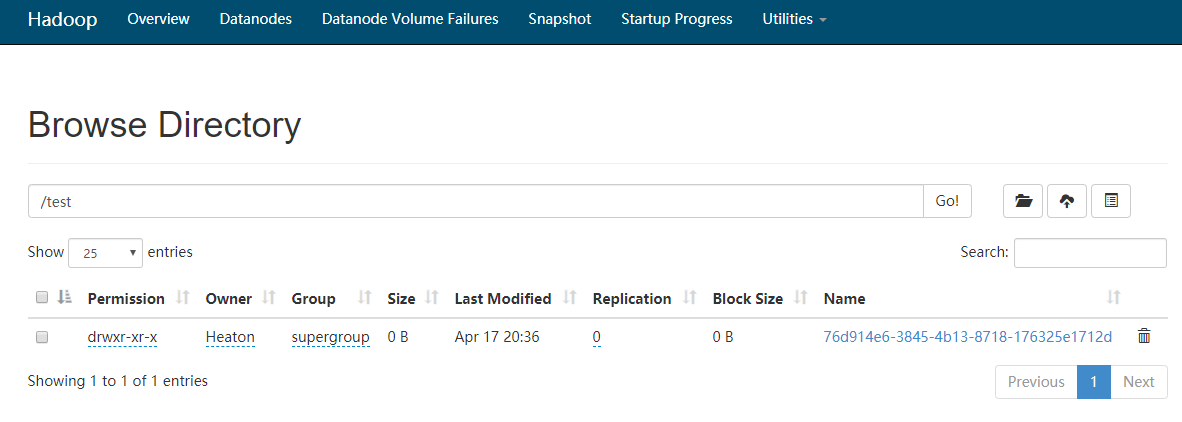

4.28 checkpoint

持久化只是将数据保存在BlockManager中,而RDD的Lineage是不变的,但是checkpoint执行完后,RDD已经没有之前所谓的依赖了,而只是一个强行为其设定的checkpointRDD,RDD的Lineage改变了。

持久化的数据丢失可能性更大,磁盘、内存都有可能会存在数据丢失情况。但是checkpoint的数据通常是储存在如HDFS等容错、高可用的文件系统,数据丢失可能性较小。

默认情况下,如果某个RDD没有持久化,但是设置了checkpoint Job想要将RDD的数据写入文件系统,需要全部重新计算一次,再将计算出来的RDD数据checkpoint到文件系统,所以,建议对checkpoint的RDD使用十九画,这样RDD只需要计算一次就可以了。

object Demo28 {

def main(args: Array[String]): Unit = {

//设置当前用户

System.setProperty("HADOOP_USER_NAME", "Heaton")

val conf = new SparkConf().setAppName("checkpoint").setMaster("local[*]")

val sc = new SparkContext(conf)

//设置checkpoint目录

sc.setCheckpointDir("hdfs://cdh01.cm:8020/test")

val rdd1: RDD[String] = sc.parallelize(Array("abc"))

val rdd2: RDD[(String, Int)] = rdd1.map((_, 1))

/**

* 标记RDD2的checkpoint

* RDD2会被保存到文件中,并且会切断到父RDD的引用,该持久化操作,必须在job运行之前调用

* 如果不进行持久化操作,那么在保存到文件的时候需要重新计算

**/

rdd2.cache()

rdd2.collect.foreach(x => print(x + "\t"))

rdd2.collect.foreach(x => print(x + "\t"))

}

}

4.29 累加器

4.29.1 累加器问题抛出

object Demo29 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("Accumulator").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[Int] = sc.parallelize(Array(1, 2, 3, 4, 5), 2)

var a = 1

rdd1.foreach(x => {

a += 1

println("rdd: "+a)

})

println("-----")

println("main: "+a)

/**

* rdd: 2

* rdd: 2

* rdd: 3

* rdd: 3

* rdd: 4

* -----

* main: 1

* */

}

}

从上面可以看出,2个问题:

- 变量是在RDD分区中进行累加,并且2个RDD分区中的变量不同

- 最后并没有main方法中的变量值改变

考虑到main方法中的a变量是在Driver端,而RDD分区又是在Excutor端进行计算,所以只是拿了一个Driver端的镜像,而且不同步回Driver端

在实际开发中,我们需要进行这种累加,这时就用到了累加器

4.29.2 累加器案例

Spark提供了一些常用累加器,主要针对值类型

object Demo30 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("Accumulator").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[Int] = sc.parallelize(Array(1, 2, 3, 4, 5), 2)

val acc: util.LongAccumulator = sc.longAccumulator("acc")

rdd1.foreach(x => {

acc.add(1)

println("rdd: "+acc.value)

})

println("-----")

println("main: "+acc.count)

/**

* rdd: 1

* rdd: 1

* rdd: 2

* rdd: 2

* rdd: 3

* -----

* main: 5

* */

}

}

如上代码,我们发现累加器是分区内先累加,再分区间累加

4.29.3 自定义累加器

- 案例一:自定义Int累加器

object Demo31 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("Accumulator").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[Int] = sc.parallelize(Array(1, 2, 3, 4, 5), 2)

val acc = new MyAccumulator

//注册累加器

sc.register(acc)

rdd1.foreach(x => {

acc.add(1)

println("rdd: " + acc.value)

})

println("-----")

println("main: " + acc.value)

/**

* rdd: 1

* rdd: 1

* rdd: 2

* rdd: 3

* rdd: 2

* -----

* main: 5

**/

}

}

class MyAccumulator extends AccumulatorV2[Int, Int] {

var sum: Int = 0

//判断累加的值是不是空

override def isZero: Boolean = sum == 0

//如何把累加器copy到Executor

override def copy(): AccumulatorV2[Int, Int] = {

val accumulator = new MyAccumulator

accumulator.sum = sum

accumulator

}

//重置值

override def reset(): Unit = {

sum = 0

}

//分区内的累加

override def add(v: Int): Unit = {

sum += v

}

//分区间的累加,累加器最终的值

override def merge(other: AccumulatorV2[Int, Int]): Unit = {

other match {

case o: MyAccumulator => this.sum += o.sum

case _ =>

}

}

override def value: Int = this.sum

}

- 案例二:自定义map平均值累加器

object Demo32 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("partitionBy").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd1: RDD[Int] = sc.parallelize(Array(1, 2, 3, 4, 5), 2)

val acc = new MyAccumulator

//注册累加器

sc.register(acc)

rdd1.foreach(x => {

acc.add(x)

})

println("main: " + acc.value)

/**main: Map(sum -> 15.0, count -> 17.0, avg -> 0.8823529411764706) */

}

}

class MyAccumulator extends AccumulatorV2[Int, Map[String, Double]] {

var map: Map[String, Double] = Map[String, Double]()

//判断累加的值是不是空

override def isZero: Boolean = map.isEmpty

//如何把累加器copy到Executor

override def copy(): AccumulatorV2[Int, Map[String, Double]] = {

val accumulator = new MyAccumulator

accumulator.map ++= map

accumulator

}

//重置值

override def reset(): Unit = {

map = Map[String, Double]()

}

//分区内的累加

override def add(v: Int): Unit = {

map += "sum" -> (map.getOrElse("sum", 0d) + v)

map += "count" -> (map.getOrElse("sum", 0d) + 1)

}

//分区间的累加,累加器最终的值

override def merge(other: AccumulatorV2[Int, Map[String, Double]]): Unit = {

other match {

case o: MyAccumulator =>

this.map += "sum" -> (map.getOrElse("sum", 0d) + o.map.getOrElse("sum", 0d))

this.map += "count" -> (map.getOrElse("count", 0d) + o.map.getOrElse("count", 0d))

case _ =>

}

}

override def value: Map[String, Double] = {

map += "avg" -> map.getOrElse("sum", 0d) / map.getOrElse("count", 1d)

map

}

}

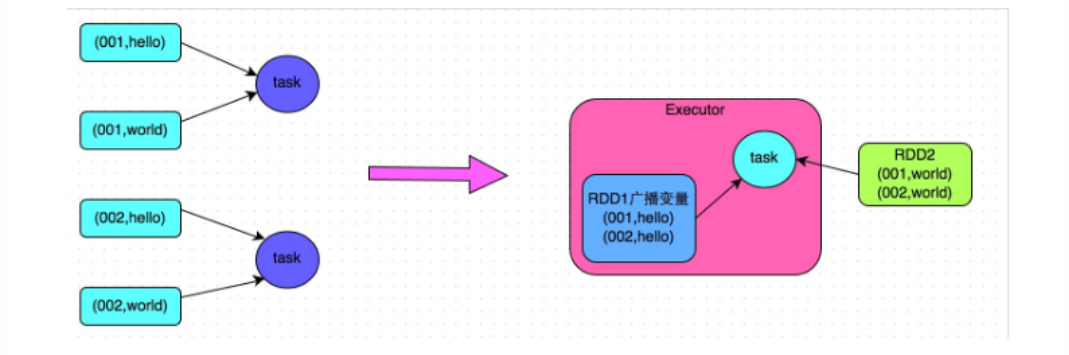

4.30 广播变量

广播变量在每个节点上保存一个只读的变量的缓存,而不用给每个task来传送一个copy

object Demo33 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("partitionBy").setMaster("local[*]")

val sc = new SparkContext(conf)

val rdd: RDD[String] = sc.parallelize(Array("a", "b"))

val broadArr: Broadcast[Array[Int]] = sc.broadcast(Array(1, 2))

rdd.foreach(x => {

val value: Array[Int] = broadArr.value

println(value.toList)

})

/**

* List(1, 2)

* List(1, 2)

* */

}

}

5 Spark SQL

Spark SQL是Spark用于结构化数据处理的Spark模块。如:Mysql,Hbase,Hive

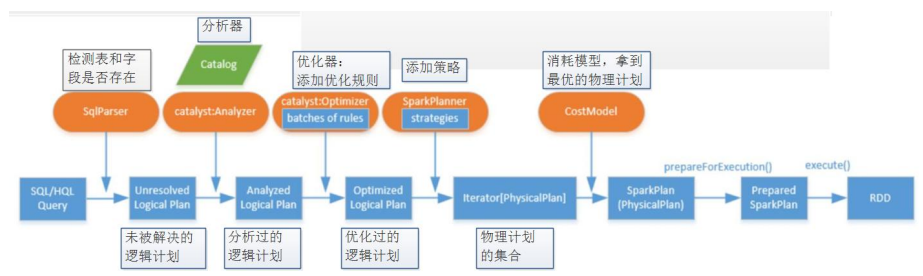

Spark SQL将SQL转换成RDD,然后提交到集群执行,执行效率非常快,而且使只会写SQL的同学可以直接开发

Spark SQL提供了2个编程抽象,等同于Spark Core中的RDD,分别是:DataFrame,DataSet

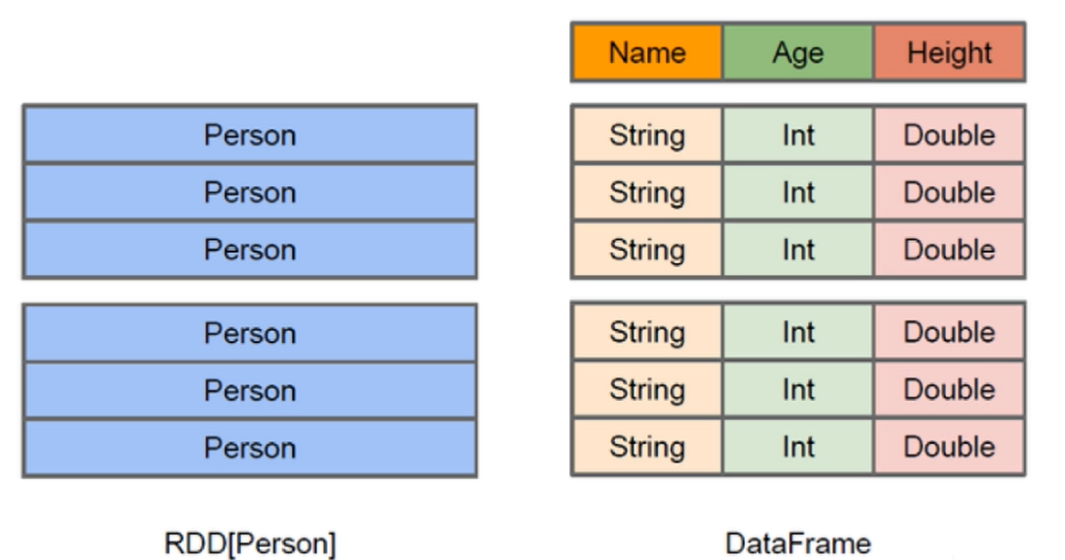

5.1 DataFrame

与RDD类似,DataFrame是一个分布式的数据容器

DataFrame更像是传统数据库的二维表格,除了数据以外,还记录了数据的结构信息(Schema)

与Hive类似,DataFrame也支持嵌套数据类型(Struct、Array、Map)

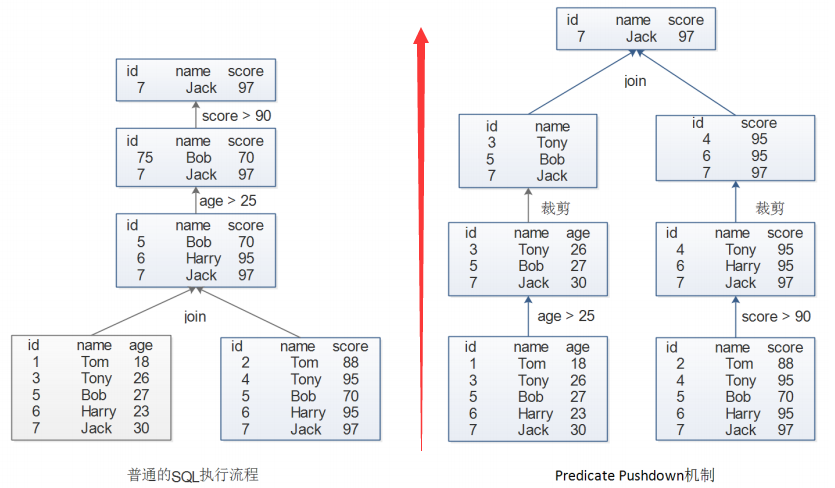

- 底层架构

- Predicate Pushdown 机制

5.2 DataSet

DataSet是DataFrame的一个扩展,是SparkSQL1.6后新增的数据抽象,API友好

scala样例类支持非常好,用样例类在DataSet中定义数据结构信息,样例类中每个属性的没成直接映射到DataSet中的字段名称。

DataFrame是DataSet的特例,DataFrame=DataSet[Row],可以通过as方法将DataFrame转换成DataSet,Row是一个类型,可以是Person、Animal,所有的表结构信息都用Row来表示

DataFrame只知道字段,不知道字段类型,而DataSet不仅知道字段,还知道类型。

DataSet具有强类型的数据集合,需要提供对应的类型信息。

5.3 SparkSession

从Spark2.0开始,SparkSession是Spark新的查询起始点,其内部封装了SparkContext,所以计算实际上是由SparkContext完成

5.4 DataFrame编程

5.4.1 解析Json数据

- 读取Json文件

在idea中,resources目录下创建student.json文件

{"id":1,"name": "zhangsa", "age": 10}

{"id":2,"name": "lisi", "age": 20}

{"id":3,"name": "wangwu", "age": 30}

{"id":4,"name": "zhaoliu", "age": 12}

{"id":5,"name": "hahaqi", "age": 24}

{"id":6,"name": "xixiba", "age": 33}

object SparkSQLDemo1 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder().appName("demo1").master("local[*]") getOrCreate()

val frame: DataFrame = spark.read.json(this.getClass.getClassLoader.getResource("student.json").getPath)

frame.show(100)

/**

* +---+---+-------+

* |age| id| name|

* +---+---+-------+

* | 10| 1|zhangsa|

* | 20| 2| lisi|

* | 30| 3| wangwu|

* | 12| 4|zhaoliu|

* | 24| 5| hahaqi|

* | 33| 6| xixiba|

* +---+---+-------+

*/

println(frame.schema)

/**

* StructType(StructField(age,LongType,true), StructField(id,LongType,true), StructField(name,StringType,true))

*/

}

}

5.4.2 TempView

- 在使用sql查询之前需要注册临时视图

- createTempView():注册视图,当前Session有效

- createOrReplaceTempView():注册视图,当前Session有效,如果已经存在,那么替换

- createGlobalTempView():注册全局视图,在所有Session中生效

- createOrReplaceGlobalTempView():注册全局视图,在所有Session中生效,如果已经存在,那么替换

使用全局视图,需要在表名前添加global_tmp,如student表,写法为:global_tmp.student

object SparkSQLDemo2 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder().appName("demo2").master("local[*]") getOrCreate()

val frame: DataFrame = spark.read.json(this.getClass.getClassLoader.getResource("student.json").getPath)

frame.createOrReplaceTempView("student")

val result: DataFrame = spark.sql("select * from student where age >= 20")

result.show()

/**

* +---+---+------+

* |age| id| name|

* +---+---+------+

* | 20| 2| lisi|

* | 30| 3|wangwu|

* | 24| 5|hahaqi|

* | 33| 6|xixiba|

* +---+---+------+

*/

}

}

5.5 DataSet编程

- DataSet简单使用

object SparkSQLDemo3 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder().appName("demo3").master("local[*]") getOrCreate()

import spark.implicits._

val sRDD: Dataset[Student] = Seq(Student(1,"zhangsan",15),Student(2,"lisi",16)).toDS

sRDD.foreach(s=>{

println(s.name+":"+s.age)

})

/**

* zhangsan:15

* lisi:16

* */

}

}

case class Student(id: Long, name: String, age: Long)

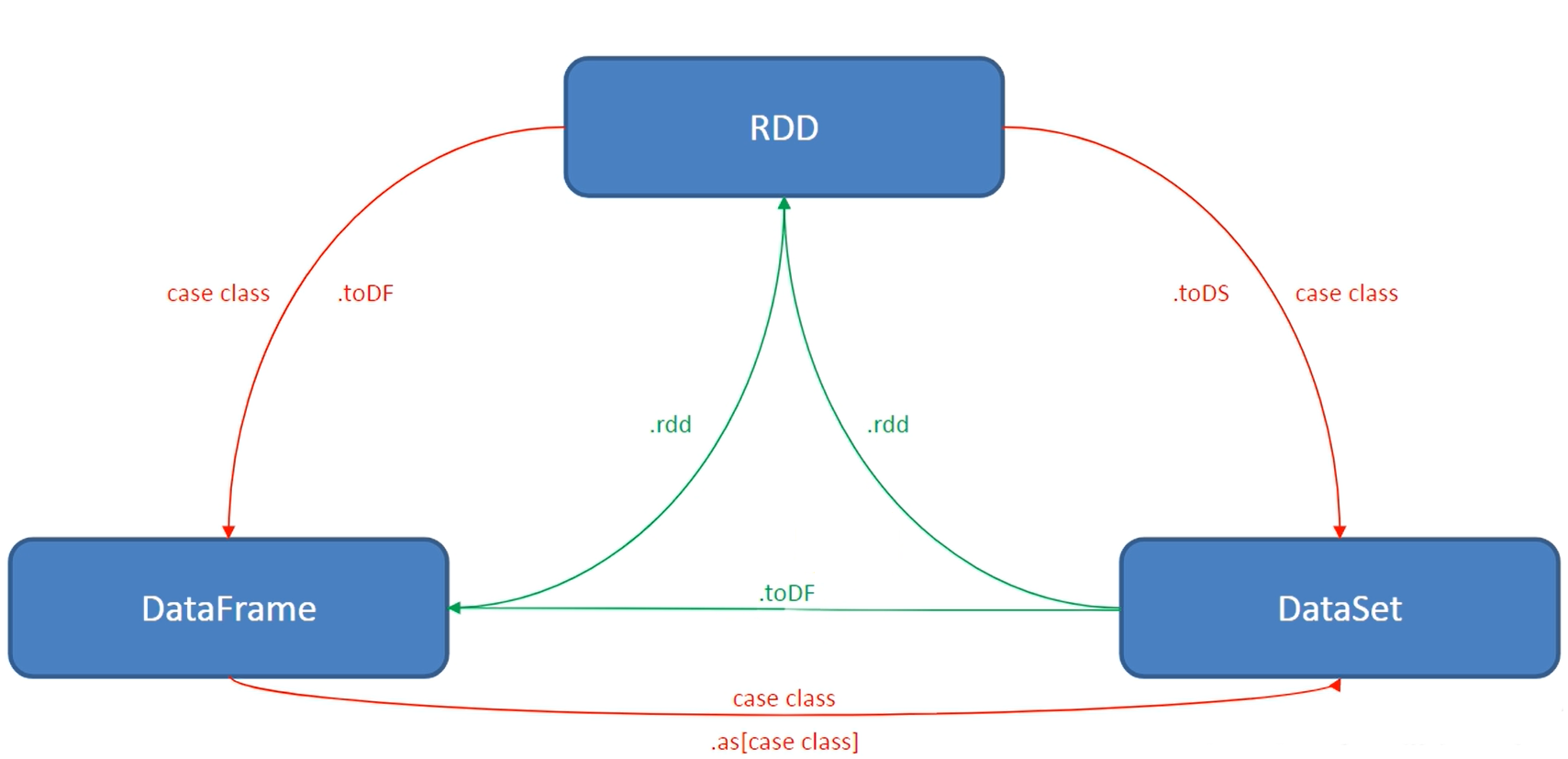

5.6 DataSet和DataFrame和RDD互相转换

涉及到RDD,DataFrame,DataSet之间操作时,需要隐式转换导入: import spark.implicits._ 这里的spark不是报名,而是代表了SparkSession的那个对象名,所以必须先创建SparkSession对象在导入

RDD转DF:toDF

RDD转DS:toDS

DF转RDD:rdd

DS转RDD:rdd

DS转DF:toDF

DF转DS:as

- 创建student.csv文件

1,zhangsa,10

2,lisi,20

3,wangwu,30

object SparkSQLDemo4 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder().appName("demo4").master("local[*]") getOrCreate()

import spark.implicits._

val rdd: RDD[String] = spark.sparkContext.textFile(this.getClass.getClassLoader.getResource("student.csv").getPath)

val studentRDD: RDD[Student] = rdd.map(x => {

val arr: Array[String] = x.split(",")

Student(arr(0).toLong, arr(1), arr(2).toLong)

})

/** 1. RDD转DF

* +---+-------+---+

* | id| name|age|

* +---+-------+---+

* | 1|zhangsa| 10|

* | 2| lisi| 20|

* | 3| wangwu| 30|

* +---+-------+---+

* */

val df1: DataFrame = studentRDD.toDF()

df1.show()

/** 2. RDD转DS

* +---+-------+---+

* | id| name|age|

* +---+-------+---+

* | 1|zhangsa| 10|

* | 2| lisi| 20|

* | 3| wangwu| 30|

* +---+-------+---+

* */

val ds1: Dataset[Student] = studentRDD.toDS()

ds1.show()

/** 3. DF转RDD

* List([1,zhangsa,10], [2,lisi,20], [3,wangwu,30])

* */

val rdd1: RDD[Row] = df1.rdd

println(rdd1.collect.toList)

/** 4. DS转RDD

* List(Student(1,zhangsa,10), Student(2,lisi,20), Student(3,wangwu,30))

* */

val rdd2: RDD[Student] = ds1.rdd

println(rdd2.collect.toList)

/** 5. DS转DF

* +---+-------+---+

* | id| name|age|

* +---+-------+---+

* | 1|zhangsa| 10|

* | 2| lisi| 20|

* | 3| wangwu| 30|

* +---+-------+---+

* */

val df2: DataFrame = ds1.toDF()

df2.show()

/** 6. DF转DS

* +---+-------+---+

* | id| name|age|

* +---+-------+---+

* | 1|zhangsa| 10|

* | 2| lisi| 20|

* | 3| wangwu| 30|

* +---+-------+---+

* */

val ds2: Dataset[Student] = df2.as[Student]

ds2.show()

}

}

case class Student(id: Long, name: String, age: Long)

5.7 UDF函数:一对一

object SparkSQLDemo5 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder().appName("demo5").master("local[*]") getOrCreate()

//注册函数

val toUpper: UserDefinedFunction = spark.udf.register("toUpper", (s: String) => s.toUpperCase)

val frame: DataFrame = spark.read.json(this.getClass.getClassLoader.getResource("student.json").getPath)

frame.createOrReplaceTempView("student")

val result: DataFrame = spark.sql("select id,toUpper(name),age from student where age >= 20")

result.show()

/**

* +---+-----------------+---+

* | id|UDF:toUpper(name)|age|

* +---+-----------------+---+

* | 2| LISI| 20|

* | 3| WANGWU| 30|

* | 5| HAHAQI| 24|

* | 6| XIXIBA| 33|

* +---+-----------------+---+

**/

}

}

5.8 UDAF函数:多对一

object SparkSQLDemo6 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder().appName("demo6").master("local[*]") getOrCreate()

//注册函数

spark.udf.register("MyAvg", new MyAvg)

val frame: DataFrame = spark.read.json(this.getClass.getClassLoader.getResource("student.json").getPath)

frame.createOrReplaceTempView("student")

frame.printSchema()

val result: DataFrame = spark.sql("select sum(age),count(1),MyAvg(age) from student")

result.show()

/**

* +--------+--------+----------+

* |sum(age)|count(1)|myavg(age)|

* +--------+--------+----------+

* | 129| 6| 21.5|

* +--------+--------+----------+

* */

}

}

class MyAvg extends UserDefinedAggregateFunction {

//输入数据类型

override def inputSchema: StructType = StructType(StructField("input", LongType) :: Nil)

//缓冲区中值的类型

override def bufferSchema: StructType = StructType(StructField("sum", DoubleType) :: StructField("count", LongType) :: Nil)

//最终输出数据类型

override def dataType: DataType = DoubleType

//输入和输出之间的确定性,一般都是true

override def deterministic: Boolean = true

//缓冲区中值的初始化

override def initialize(buffer: MutableAggregationBuffer): Unit = {

//sum

buffer(0) = 0.0d

//count

buffer(1) = 0L

}

//分区内聚合

override def update(buffer: MutableAggregationBuffer, input: Row): Unit = {

//如果值不为空

if (!input.isNullAt(0)) {

buffer(0) = buffer.getDouble(0) + input.getLong(0)

buffer(1) = buffer.getLong(1) + 1

}

}

//分区间聚合

override def merge(buffer1: MutableAggregationBuffer, buffer2: Row): Unit = {

//如果值不为空

if (!buffer2.isNullAt(0)) {

buffer1(0) = buffer1.getDouble(0) + buffer2.getDouble(0)

buffer1(1) = buffer1.getLong(1) + buffer2.getLong(1)

}

}

//最终输出的值

override def evaluate(buffer: Row): Any = {

new DecimalFormat(".00").format(buffer.getDouble(0) / buffer.getLong(1)).toDouble

}

}

5.9 UDTF函数:一对多

需要使用Hive的UDTF

import java.util.ArrayList

import org.apache.hadoop.hive.ql.exec.{UDFArgumentException, UDFArgumentLengthException}

import org.apache.hadoop.hive.ql.udf.generic.GenericUDTF

import org.apache.hadoop.hive.serde2.objectinspector.primitive.PrimitiveObjectInspectorFactory

import org.apache.hadoop.hive.serde2.objectinspector.{ObjectInspector, ObjectInspectorFactory, StructObjectInspector}

import org.apache.spark.sql.{DataFrame, SparkSession}

object SparkSQLDemo7 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder()

.appName("demo7")

.master("local[*]")

.enableHiveSupport() //启用hive

.getOrCreate()

import spark.implicits._

//注册utdf算子,这里无法使用sparkSession.udf.register(),注意包全路径

spark.sql("CREATE TEMPORARY FUNCTION MySplit as 'com.xx.xx.MySplit'")

val frame: DataFrame = spark.sparkContext.parallelize(Array("a,b,c,d")).toDF("word")

frame.createOrReplaceTempView("test")

val result: DataFrame = spark.sql("select MySplit(word,',') from test")

result.show()

/**

* +----+

* |col1|

* +----+

* | a|

* | b|

* | c|

* | d|

* +----+

*/

}

}

class MySplit extends GenericUDTF {

override def initialize(args: Array[ObjectInspector]): StructObjectInspector = {

if (args.length != 2) {

throw new UDFArgumentLengthException("UserDefinedUDTF takes only two argument")

}

if (args(0).getCategory() != ObjectInspector.Category.PRIMITIVE) {

throw new UDFArgumentException("UserDefinedUDTF takes string as a parameter")

}

//列名,会被用户传递的覆盖

val fieldNames: ArrayList[String] = new ArrayList[String]()

fieldNames.add("col1")

//返回列以什么格式输出,这里是string,添加几个就是几个列,和上面的名字个数对应个数。

var fieldOIs: ArrayList[ObjectInspector] = new ArrayList[ObjectInspector]()

fieldOIs.add(PrimitiveObjectInspectorFactory.javaStringObjectInspector)

ObjectInspectorFactory.getStandardStructObjectInspector(fieldNames, fieldOIs)

}

override def process(objects: Array[AnyRef]): Unit = {

//获取数据

val data: String = objects(0).toString

//获取分隔符

val splitKey: String = objects(1).toString()

//切分数据

val words: Array[String] = data.split(splitKey)

//遍历写出

words.foreach(x => {

//将数据放入集合

var tmp: Array[String] = new Array[String](1)

tmp(0) = x

//写出数据到缓冲区

forward(tmp)

})

}

override def close(): Unit = {

//没有流操作

}

}

5.10 读取Json数据拓展

- 读取嵌套json数据

{"name":"zhangsan","score":100,"infos":{"age":30,"gender":"man"}},

{"name":"lisi","score":66,"infos":{"age":28,"gender":"feman"}},

{"name":"wangwu","score":77,"infos":{"age":15,"gender":"feman"}}

object SparkSQLDemo8 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder()

.appName("demo8")

.master("local[*]")

.getOrCreate()

//读取嵌套的json文件

val frame: DataFrame = spark.read.json(this.getClass.getClassLoader.getResource("student.json").getPath)

frame.createOrReplaceTempView("infosView")

spark.sql("select name,infos.age,score,infos.gender from infosView").show(100)

/**

* +--------+---+-----+------+

* | name|age|score|gender|

* +--------+---+-----+------+

* |zhangsan| 30| 100| man|

* | lisi| 28| 66| feman|

* | wangwu| 15| 77| feman|

* +--------+---+-----+------+

**/

}

}

- 读取嵌套jsonArray数据

{"name":"zhangsan","age":18,"scores":[{"yuwen":98,"shuxue":90,"yingyu":100,"xueqi":1},{"yuwen":77,"shuxue":33,"yingyu":55,"xueqi":2}]},

{"name":"lisi","age":19,"scores":[{"yuwen":58,"shuxue":50,"yingyu":78,"xueqi":1},{"yuwen":66,"shuxue":88,"yingyu":66,"xueqi":2}]},

{"name":"wangwu","age":17,"scores":[{"yuwen":18,"shuxue":90,"yingyu":45,"xueqi":1},{"yuwen":88,"shuxue":77,"yingyu":44,"xueqi":2}]},

{"name":"zhaoliu","age":20,"scores":[{"yuwen":68,"shuxue":23,"yingyu":63,"xueqi":1},{"yuwen":44,"shuxue":55,"yingyu":77,"xueqi":2}]},

{"name":"tianqi","age":22,"scores":[{"yuwen":88,"shuxue":91,"yingyu":41,"xueqi":1},{"yuwen":55,"shuxue":66,"yingyu":88,"xueqi":2}]}

object SparkSQLDemo8 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder()

.appName("demo8")

.master("local[*]")

.getOrCreate()

//读取嵌套的json文件

val frame: DataFrame = spark.read.json(this.getClass.getClassLoader.getResource("student.json").getPath)

frame.createOrReplaceTempView("infosView")

spark.sql("select name,age,explode(scores) from infosView")

//不折叠显示

frame.show(false)

/**

* +---+--------+-----------------------------------+

* |age|name |scores |

* +---+--------+-----------------------------------+

* |18 |zhangsan|[[90, 1, 100, 98], [33, 2, 55, 77]]|

* |19 |lisi |[[50, 1, 78, 58], [88, 2, 66, 66]] |

* |17 |wangwu |[[90, 1, 45, 18], [77, 2, 44, 88]] |

* |20 |zhaoliu |[[23, 1, 63, 68], [55, 2, 77, 44]] |

* |22 |tianqi |[[91, 1, 41, 88], [66, 2, 88, 55]] |

* +---+--------+-----------------------------------+

*/

}

}

5.11 读取Mysql数据

- 使用Mysql

create database spark;

use spark;

create table person(id varchar(12),name varchar(12),age int(10));

insert into person values('1','zhangsan',18),('2','lisi',19),('3','wangwu',20);

object SparkSQLDemo9 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder()

.appName("demo9")

.master("local[*]")

.getOrCreate()

val frame: DataFrame = spark.read.format("jdbc")

.option("url", "jdbc:mysql://localhost:3306/spark")

.option("driver", "com.mysql.jdbc.Driver")

.option("user", "root")

.option("password", "root")

.option("dbtable", "person")

.load()

frame.show()

/**

* +---+--------+---+

* | id| name|age|

* +---+--------+---+

* | 1|zhangsan| 18|

* | 2| lisi| 19|

* | 3| wangwu| 20|

* +---+--------+---+

*/

}

}

5.12 读取Hive数据

- 使用Hive

//创建数据库

CREATE DATABASE dwd

//创建表

CREATE EXTERNAL TABLE `dwd.student`(

`ID` bigint COMMENT '',

`CreatedBy` string COMMENT '创建人',

`CreatedTime` string COMMENT '创建时间',

`UpdatedBy` string COMMENT '更新人',

`UpdatedTime` string COMMENT '更新时间',

`Version` int COMMENT '版本号',

`name` string COMMENT '姓名'

) COMMENT '学生表'

PARTITIONED BY (

`dt` String COMMENT 'partition'

)

row format delimited fields terminated by '\t'

stored as parquet

location '/warehouse/dwd/test/student/'

tblproperties ("parquet.compression"="snappy")

//添加数据

INSERT INTO TABLE dwd.student partition(dt='2020-04-05') VALUES(1,"heaton","2020-04-05","","","1","zhangsan")

INSERT INTO TABLE dwd.student partition(dt='2020-04-06') VALUES(2,"heaton","2020-04-06","","","1","lisi")

- 将服务端配置hive-site.xml,放入resources路径

object SparkSQLDemo10 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder()

.appName("demo10")

.master("local[*]")

.enableHiveSupport() //启用hive

.getOrCreate()

spark.sql("select * from dwd.student").show()

/**

* +---+---------+-----------+---------+-----------+-------+--------+----------+

* | id|createdby|createdtime|updatedby|updatedtime|version| name| dt|

* +---+---------+-----------+---------+-----------+-------+--------+----------+

* | 1| heaton| 2020-04-05| | | 1|zhangsan|2020-04-05|

* | 2| heaton| 2020-04-06| | | 1| lisi|2020-04-06|

* +---+---------+-----------+---------+-----------+-------+--------+----------+

*/

}

}

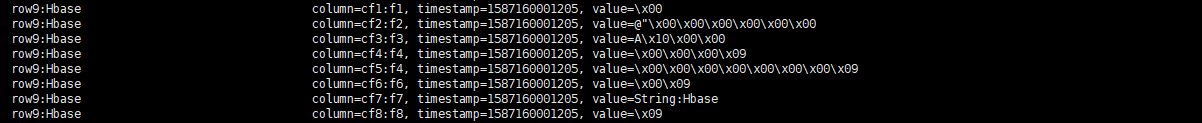

5.13 读取Hbase数据

object SparkSQLDemo11 {

def main(args: Array[String]): Unit = {

//创建sparksession

val spark = SparkSession.builder()

.appName("demo11")

.config("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

.master("local[*]")

.getOrCreate()

import spark.implicits._

val hconf: Configuration = HBaseConfiguration.create

hconf.set(HConstants.ZOOKEEPER_QUORUM, "cdh01.cm,cdh02.cm,cdh03.cm")

hconf.set(HConstants.ZOOKEEPER_CLIENT_PORT, "2181")

//一定要创建这个hbaseContext, 因为后面写入时会用到它,不然空指针

val hBaseContext = new HBaseContext(spark.sparkContext, hconf)

//构建DataSet

val ds1: Dataset[HBaseRecord] = spark.sparkContext.parallelize(1.to(256)).map(i => new HBaseRecord(i, "Hbase")).toDS()

//定义映射的catalog

val catalog: String = "{" +

" \"table\":{\"namespace\":\"default\", \"name\":\"test1\"}," +

" \"rowkey\":\"key\"," +

" \"columns\":{" +

" \"f0\":{\"cf\":\"rowkey\", \"col\":\"key\", \"type\":\"string\"}," +

" \"f1\":{\"cf\":\"cf1\", \"col\":\"f1\", \"type\":\"boolean\"}," +

" \"f2\":{\"cf\":\"cf2\", \"col\":\"f2\", \"type\":\"double\"}," +

" \"f3\":{\"cf\":\"cf3\", \"col\":\"f3\", \"type\":\"float\"}," +

" \"f4\":{\"cf\":\"cf4\", \"col\":\"f4\", \"type\":\"int\"}," +

" \"f5\":{\"cf\":\"cf5\", \"col\":\"f4\", \"type\":\"bigint\"}," +

" \"f6\":{\"cf\":\"cf6\", \"col\":\"f6\", \"type\":\"smallint\"}," +

" \"f7\":{\"cf\":\"cf7\", \"col\":\"f7\", \"type\":\"string\"}," +

" \"f8\":{\"cf\":\"cf8\", \"col\":\"f8\", \"type\":\"tinyint\"}" +

" }" +

" }"

//数据写入Hbase

ds1.write

.format("org.apache.hadoop.hbase.spark")

.option(HBaseTableCatalog.tableCatalog, catalog)

.option(HBaseTableCatalog.newTable, 5)

.mode(SaveMode.Overwrite) //写入5个分区

.save()

//读取Hbase数据

val ds2: DataFrame = spark.read

.format("org.apache.hadoop.hbase.spark")

.option(HBaseTableCatalog.tableCatalog, catalog)

.load()

ds2.show(10)

/**

* +------------+-----+---+---+------------+-----+-----+---+---+

* | f7| f1| f4| f6| f0| f3| f2| f5| f8|

* +------------+-----+---+---+------------+-----+-----+---+---+

* |String:Hbase| true|100|100|row100:Hbase|100.0|100.0|100|100|

* |String:Hbase|false|101|101|row101:Hbase|101.0|101.0|101|101|

* |String:Hbase| true|102|102|row102:Hbase|102.0|102.0|102|102|

* |String:Hbase|false|103|103|row103:Hbase|103.0|103.0|103|103|

* |String:Hbase| true|104|104|row104:Hbase|104.0|104.0|104|104|

* |String:Hbase|false|105|105|row105:Hbase|105.0|105.0|105|105|

* |String:Hbase| true|106|106|row106:Hbase|106.0|106.0|106|106|

* |String:Hbase|false|107|107|row107:Hbase|107.0|107.0|107|107|

* |String:Hbase| true|108|108|row108:Hbase|108.0|108.0|108|108|

* |String:Hbase|false|109|109|row109:Hbase|109.0|109.0|109|109|

* +------------+-----+---+---+------------+-----+-----+---+---+

*/

}

}

case class HBaseRecord(f0: String, f1: Boolean, f2: Double, f3: Float, f4: Int, f5: Long, f6: Short, f7: String, f8: Byte) {

def this(i: Int, s: String) {

this(s"row$i:$s", i % 2 == 0, i.toDouble, i.toFloat, i, i.toLong, i.toShort, s"String:$s", i.toByte)

}

}

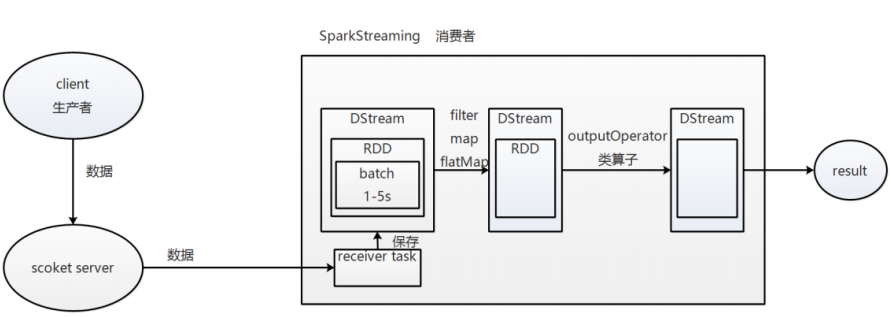

6 Spark Streaming

Spark Streaming是Spark核心API扩展,用于构建弹性、高吞吐、容错的在线数据流的流式处理程序

数据来源有多种:Kafla、Flume、TCP等

Spark Streaming中提供的高级抽象:Discretized stream,DStream表示一个连续的数据流,可以由来自数据源的输入数据流来创建,也可以通过在其他DStream上转换得到,一个DStream是由一个RDD序列来表示的,对DStream的操作都会转换成对其里面的RDD的操作

- 执行流程

Receiver task 是 7*24h 一直在执行,一直接收数据,将接收到的数据保存到 batch 中,假设 batch interval 为 5s,

那么把接收到的数据每隔 5s 切割到一个 batch,因为 batch 是没有分布式计算的特性的,而 RDD 有,

所以把 batch 封装到 RDD 中,又把 RDD 封装到DStream 中进行计算,在第 5s 的时候,计算前 5s 的数据,

假设计算 5s 的数据只需要 3s,那么第 5-8s 一边计算任务,一边接收数据,第 9-11s 只是接收数据,然后在第 10s 的时

候,循环上面的操作。如果 job 执行时间大于 batch interval,那么未执行的数据会越攒越多,最终导致 Spark集群崩溃。注意:Receiver (接收器)在新版本中已经去除了。

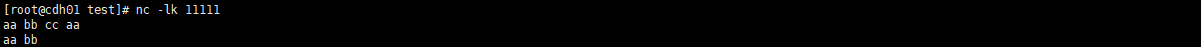

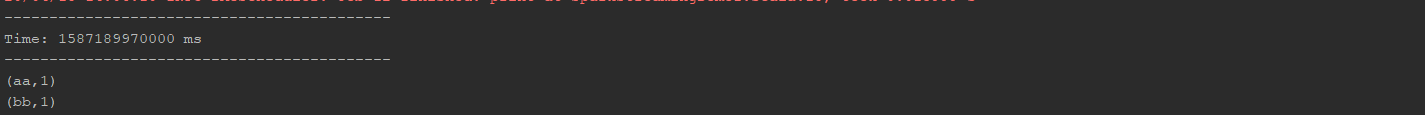

6.1 端口监听案例

object SparkStreamingDemo1 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("demo1").setMaster("local[*]")

//创建一个10秒封装一次数据的StreamingContext

val ssc: StreamingContext = new StreamingContext(conf, Seconds(10))

//监控cdh01.cm上11111端口

val lines: ReceiverInputDStream[String] = ssc.socketTextStream("cdh01.cm", 11111)

val words: DStream[(String, Int)] = lines.flatMap(_.split(" "))

.map(word => (word, 1))

.reduceByKey(_ + _)

//行动算子打印

words.print()

//启动StreamingContext并等待终止

ssc.start()

ssc.awaitTermination()

}

}

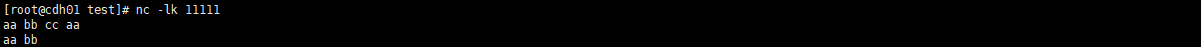

- 监听服务器,间隔10秒发送数据测试如下

nc -lk 11111

6.2 对接Kafka

生产中这种是最常用的方式

object SparkStreamingDemo2 {

def main(args: Array[String]): Unit = {

val brokers = "cdh01.cm:9092,cdh02.cm:9092,cdh03.cm:9092"

val topic = "bigdata"

val cgroup = "test"

val params: Map[String, Object] = Map(

ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG -> brokers,

ConsumerConfig.GROUP_ID_CONFIG -> cgroup,

ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG -> "org.apache.kafka.common.serialization.StringDeserializer",

ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG -> "org.apache.kafka.common.serialization.StringDeserializer"

)

val conf: SparkConf = new SparkConf().setAppName("demo2").set("spark.serializer", "org.apache.spark.serializer.KryoSerializer").setMaster("local[*]")

//创建一个10秒封装一次数据的StreamingContext

val ssc: StreamingContext = new StreamingContext(conf, Seconds(10))

//Streaming对接kafka

val kafkaDStream: InputDStream[ConsumerRecord[String, String]] = KafkaUtils.createDirectStream[String, String](

ssc,

LocationStrategies.PreferConsistent,

ConsumerStrategies.Subscribe[String, String](List(topic), params)

)

kafkaDStream.print

//启动StreamingContext并等待终止

ssc.start()

ssc.awaitTermination()

}

}

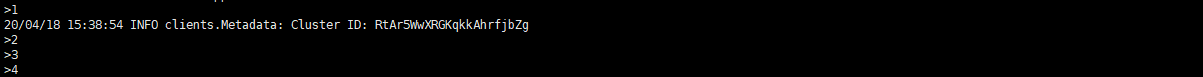

- 使用Kafka

kafka-console-producer --broker-list cdh01.cm:9092,cdh02.cm:9092,cdh03.cm:9092 --topic bigdata

ConsumerRecord(topic = bigdata, partition = 0, offset = 13, CreateTime = 1587194334601, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = a)

ConsumerRecord(topic = bigdata, partition = 0, offset = 14, CreateTime = 1587194335215, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = b)

ConsumerRecord(topic = bigdata, partition = 0, offset = 15, CreateTime = 1587194335975, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = c)

ConsumerRecord(topic = bigdata, partition = 0, offset = 16, CreateTime = 1587194336887, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = d)

ConsumerRecord(topic = bigdata, partition = 0, offset = 17, CreateTime = 1587194337912, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = e)

6.3 Checkpoint

Spark的一种持久化方式,并不推荐

这种方式很容易做到,但是有以下的缺点:

多次输出,结果必须满足幂等性

事务性不可选

如果代码变更不能从Checkpoint恢复,不过你可以同时运行新任务和旧任务,因为输出结果具有等幂性

object SparkStreamingDemo3 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("demo3").set("spark.serializer", "org.apache.spark.serializer.KryoSerializer").setMaster("local[*]")

val ssc: StreamingContext = StreamingContext.getActiveOrCreate("./ck", createSSC)

//启动StreamingContext并等待终止

ssc.start()

ssc.awaitTermination()

}

def createSSC() : StreamingContext = {

val brokers = "cdh01.cm:9092,cdh02.cm:9092,cdh03.cm:9092"

val topic = "bigdata"

val cgroup = "test"

val params: Map[String, Object] = Map(

ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG -> brokers,

ConsumerConfig.GROUP_ID_CONFIG -> cgroup,

ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG -> "org.apache.kafka.common.serialization.StringDeserializer",

ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG -> "org.apache.kafka.common.serialization.StringDeserializer"

)

val conf: SparkConf = new SparkConf().setAppName("demo2").set("spark.serializer", "org.apache.spark.serializer.KryoSerializer").setMaster("local[*]")

//创建一个10秒封装一次数据的StreamingContext

val ssc: StreamingContext = new StreamingContext(conf, Seconds(10))

//设置检查点

ssc.checkpoint("./ck")

//Streaming对接kafka

val kafkaDStream: InputDStream[ConsumerRecord[String, String]] = KafkaUtils.createDirectStream[String, String](

ssc,

LocationStrategies.PreferConsistent,

ConsumerStrategies.Subscribe[String, String](List(topic), params)

)

kafkaDStream.print

ssc

}

}

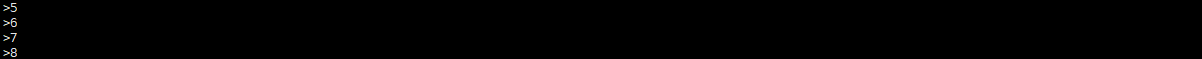

- 使用Kafka

kafka-console-producer --broker-list cdh01.cm:9092,cdh02.cm:9092,cdh03.cm:9092 --topic bigdata

ConsumerRecord(topic = bigdata, partition = 0, offset = 18, CreateTime = 1587195534875, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 1)

ConsumerRecord(topic = bigdata, partition = 0, offset = 19, CreateTime = 1587195535127, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 2)

ConsumerRecord(topic = bigdata, partition = 0, offset = 20, CreateTime = 1587195535439, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 3)

ConsumerRecord(topic = bigdata, partition = 0, offset = 21, CreateTime = 1587195535903, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 4)

- 将程序关闭,在Kafka中继续写入数据,在启动程序

ConsumerRecord(topic = bigdata, partition = 0, offset = 22, CreateTime = 1587195646015, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 5)

ConsumerRecord(topic = bigdata, partition = 0, offset = 23, CreateTime = 1587195646639, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 6)

ConsumerRecord(topic = bigdata, partition = 0, offset = 24, CreateTime = 1587195647207, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 7)

ConsumerRecord(topic = bigdata, partition = 0, offset = 25, CreateTime = 1587195647647, serialized key size = -1, serialized value size = 1, headers = RecordHeaders(headers = [], isReadOnly = false), key = null, value = 8)

6.4 转换算子

| Transformation | 含义 |

|---|---|

| map(func) | 通过函数func传递源DStream的每个元素,返回一个新的DStream。 |

| flatMap(func) | 类似于map,但是每个输入项可以映射到0或多个输出项。 |

| filter(func) | 通过只选择func返回true的源DStream的记录来返回一个新的DStream。 |

| repartition(numPartitions) | 重分区,通过创建或多或少的分区来更改此DStream中的并行度级别。 |

| union(otherStream) | 返回一个新的DStream,它包含源DStream和其他DStream中的元素的联合。 |

| count() | 通过计算源DStream的每个RDD中的元素数量,返回一个新的单元素RDD DStream。 |

| reduce(func) | 使用func函数(函数接受两个参数并返回一个参数)聚合源DStream的每个RDD中的元素,从而返回单元素RDDs的新DStream。这个函数应该是结合律和交换律的,这样才能并行计算。 |

| countByValue() | 当对K类型的元素的DStream调用时,返回一个新的(K, Long)对的DStream,其中每个键的值是它在源DStream的每个RDD中的频率。 |

| reduceByKey(func, [numTasks]) | 当对(K, V)对的DStream调用时,返回一个新的(K, V)对的DStream,其中每个键的值使用给定的reduce函数进行聚合。注意:默认情况下,这将使用Spark的默认并行任务数量(本地模式为2,在集群模式下,该数量由config属性Spark .default.parallelism决定)来进行分组。我们可以传递一个可选的numTasks参数来设置不同数量的任务。 |

| join(otherStream, [numTasks]) | 当调用两个(K, V)和(K, W)对的DStream时,返回一个新的(K, (V, W))对的DStream,其中包含每个Key的所有元素对。 |

| cogroup(otherStream, [numTasks]) | 当调用(K, V)和(K, W)对的DStream时,返回一个新的(K, Seq[V], Seq[W])元组DStream。 |

| transform(func) | 通过将RDD-to-RDD函数应用于源DStream的每个RDD,返回一个新的DStream。它可以用于应用DStream API中没有公开的任何RDD操作。例如将数据流中的每个批处理与另一个数据集连接的功能并不直接在DStream API中公开。但是你可以很容易地使用transform来实现这一点。这带来了非常强大的可能性。例如,可以通过将输入数据流与预先计算的垃圾信息(也可能是使用Spark生成的)结合起来进行实时数据清理 |

| updateStateByKey(func) | 返回一个新的“state”DStream,其中每个Key的状态通过将给定的函数应用于Key的前一个状态和Key的新值来更新。这可以用于维护每个Key的任意状态数据。要使用它,您需要执行两个步骤:(1).定义状态——状态可以是任意数据类型;(2).定义状态更新函数——用函数指定如何使用输入流中的前一个状态和新值更新状态。 |

object SparkStreamingDemo4 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("demo4").setMaster("local[*]")

//创建一个10秒封装一次数据的StreamingContext

val ssc: StreamingContext = new StreamingContext(conf, Seconds(10))

//监控cdh01.cm上11111端口

val lines: ReceiverInputDStream[String] = ssc.socketTextStream("cdh01.cm", 11111)

//转换成RDD操作

val words: DStream[(String, Int)] = lines.transform(rdd => {

rdd.flatMap(_.split(" ")).map(word => (word, 1)).reduceByKey(_ + _)

})

//行动算子打印

words.print()

//启动StreamingContext并等待终止

ssc.start()

ssc.awaitTermination()

}

}

- 监听服务器,间隔10秒发送数据测试如下

nc -lk 11111

6.5 行动算子

| Output Operation | 含义 |

|---|---|

| print() | 在运行流应用程序的驱动程序节点上打印DStream中每批数据的前10个元素。这对于开发和调试非常有用。这在Python API中称为pprint()。 |

| saveAsTextFiles(prefix, [suffix]) | 将此DStream的内容保存为文本文件。每个批处理间隔的文件名是根据前缀和后缀生成的:“prefix- time_in_ms [.suffix]”。 |

| saveAsObjectFiles(prefix, [suffix]) | 将此DStream的内容保存为序列化Java对象的sequencefile。每个批处理间隔的文件名是根据前缀和后缀生成的:“prefix- time_in_ms [.suffix]”。这在Python API中是不可用的。 |

| saveAsHadoopFiles(prefix, [suffix]) | 将这个DStream的内容保存为Hadoop文件。每个批处理间隔的文件名是根据前缀和后缀生成的:“prefix- time_in_ms [.suffix]”。这在Python API中是不可用的。 |

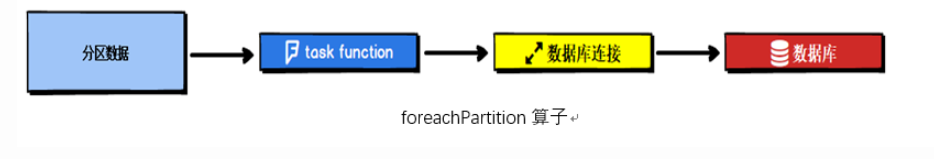

| foreachRDD(func) | 对流生成的每个RDD应用函数func的最通用输出操作符。这个函数应该将每个RDD中的数据推送到外部系统,例如将RDD保存到文件中,或者通过网络将其写入数据库。请注意,函数func是在运行流应用程序的驱动程序进程中执行的,其中通常会有RDD操作,这将强制流RDDs的计算。在func中创建远程连接时可以使用foreachPartition 替换foreach操作以降低系统的总体吞吐量 |

6.6 有状态转换

使用updateStateByKey配合检查点,可以做到从头开始保存数据。

object SparkStreamingDemo5 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("demo5").setMaster("local[*]")

//创建一个10秒封装一次数据的StreamingContext

val ssc: StreamingContext = new StreamingContext(conf, Seconds(10))

//使用updateStateByKey必须设置检查点

ssc.checkpoint("./ck")

//监控cdh01.cm上11111端口

val lines: ReceiverInputDStream[String] = ssc.socketTextStream("cdh01.cm", 11111)

def f(seq: Seq[Int], opt: Option[Int]): Some[Int] = {

Some(seq.sum + opt.getOrElse(0)

)

}

//使用updateStateByKey,根据Key保存前面接收序列里的数据为一个序列

val words: DStream[(String, Int)] = lines.flatMap(_.split(" ")).map((_, 1)).updateStateByKey(f)

//行动算子打印

words.print()

//启动StreamingContext并等待终止

ssc.start()

ssc.awaitTermination()

}

}

- 监听服务器,间隔10秒发送数据测试如下

nc -lk 11111

(aa,1)

(dd,1)

(bb,1)

(cc,1)

- 间隔10秒后

(aa,3)

(dd,1)

(bb,1)

(cc,3)

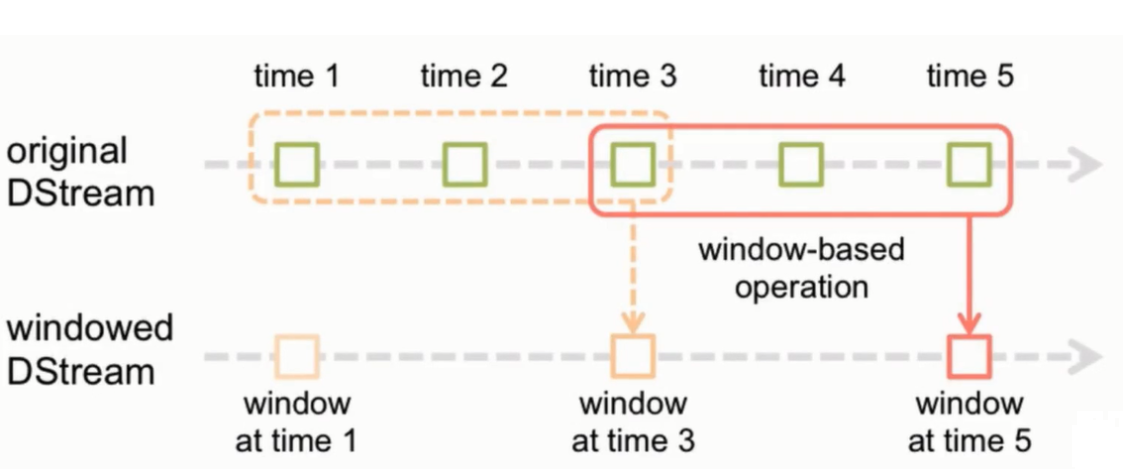

6.7 窗口函数

窗口计算,允许你在滑动的数据窗口上应用转换。

每当窗口滑过源DStream时,属于该窗口的源RDDs就被组合起来并对其进行操作,从而生成窗口化DStream的RDDs。

上图中操作应用于最后3个时间单位的数据,并以2个时间单位进行移动。这表明任何窗口操作都需要指定两个参数:

窗口长度(windowLength)——窗口的持续时间

滑动间隔(slideInterval)——执行窗口操作的间隔

这两个参数必须是批处理间隔的倍数

| Transformation | 含义 |

|---|---|

| window(windowLength, slideInterval) | 返回一个新的DStream,它是基于源DStream的窗口批次计算的。 |

| countByWindow(windowLength, slideInterval) | 返回流中元素的滑动窗口计数。 |

| reduceByWindow(func, windowLength, slideInterval) | 返回一个新的单元素流,该流是使用func在滑动间隔上聚合流中的元素创建的。这个函数应该是结合律和交换律的,这样才能并行地正确计算。 |

| reduceByKeyAndWindow(func, windowLength, slideInterval, [numTasks]) | 当对(K, V)对的DStream调用时,返回一个新的(K, V)对的DStream,其中每个Key的值使用给定的reduce函数func在滑动窗口中分批聚合。注意:默认情况下,这将使用Spark的默认并行任务数量(本地模式为2,在集群模式下,该数量由config属性Spark .default.parallelism决定)来进行分组。您可以传递一个可选的numTasks参数来设置不同数量的任务。 |

| reduceByKeyAndWindow(func, invFunc, windowLength, slideInterval, [numTasks]) | 上面reduceByKeyAndWindow()的一个更有效的版本,其中每个窗口的reduce值是使用前一个窗口的reduce值增量计算的。这是通过减少进入滑动窗口的新数据和“反向减少”离开窗口的旧数据来实现的。例如,在窗口滑动时“添加”和“减去”键的计数。但是,它只适用于“可逆约简函数”,即具有相应“逆约简”函数的约简函数(取invFunc参数)。与reduceByKeyAndWindow类似,reduce任务的数量可以通过一个可选参数进行配置。注意,必须启用checkpoint才能使用此操作。 |

| countByValueAndWindow(windowLength, slideInterval, [numTasks]) | 当对(K, V)对的DStream调用时,返回一个新的(K, Long)对的DStream,其中每个Key的值是它在滑动窗口中的频率。与reduceByKeyAndWindow类似,reduce任务的数量可以通过一个可选参数进行配置。 |

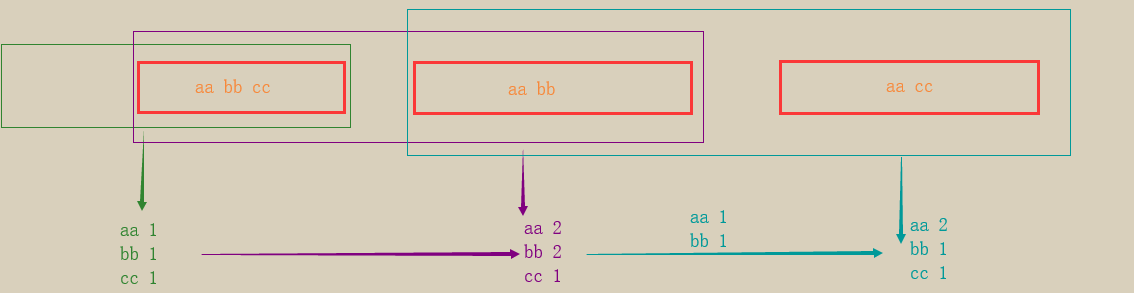

object SparkStreamingDemo6 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("demo6").setMaster("local[*]")

//创建一个10秒封装一次数据的StreamingContext

val ssc: StreamingContext = new StreamingContext(conf, Seconds(5))

//监控cdh01.cm上11111端口

val lines: ReceiverInputDStream[String] = ssc.socketTextStream("cdh01.cm", 11111)

// Duration.of(10,TimeUnit.SECONDS)

//使用窗口,比封装数据时间多一倍,意思是相当于包含两个窗口,滑动间隔为一个窗口

val words: DStream[(String, Int)] = lines.window(Seconds(10), Seconds(5)).flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _)

//行动算子打印

words.print()

//启动StreamingContext并等待终止

ssc.start()

ssc.awaitTermination()

}

}

- 监听服务器,间隔10秒发送数据测试如下

nc -lk 11111

每间隔5秒输如一行,结果集如下

(aa,1)

(bb,1)

(cc,1)

(aa,2)

(bb,2)

(cc,1)

(aa,2)

(bb,1)

(cc,1)

- 图解

7 Spark内存管理

7.1 堆内和堆外内存

作为一个JVM进程,Executor的内存管理建立在JVM的内存管理之上,Spark对JVM的堆内(On-head)空间进行了更为详细的分配,以充分利用内存。同时,Spark引入了堆外(Off-head)内存,使之可以直接在工作节点的系统内存中开辟空间,进一步优化了内存的使用。堆内内存受到JVM统一管理,堆外内存式直接向操作系统进行内存的申请和释放。

- 堆内内存

堆内内存的大小,由Spark应用程序启动时的 executor-memory 或 spark.executor.memory参数配置,Executor内运行的并发任务共享JVM堆内内存,这些任务在缓存RDD数据和广播(Broadcast)数据时占用的内存被规划为储存(Storage)内存,而这些任务在执行Shuffle时占用的内存被规划委执行(Executor)内存,剩余的部分不做特殊规划,那些Spark内部的对象实例,或者用户定义的Spark应用程序中的对象实例,均占用剩余的空间,不同的管理模式下,这三部分占用的空间大小各部相同

Spark对堆内内存的管理是一种逻辑上的“规划式”管理,因为对象实际占用内存的申请和释放都是由JVM完成,Spark只能在申请后和释放前记录这些内存

申请内存流程如下:

- Spark记录该对象释放的内存,删除该对象的引用

- 等待JVM的垃圾回收机制释放该对象占用的堆内内存

JVM的对象可以序列化的方式储存,序列化的过程是将对象转换成为二进制字节流,本质上可以理解为将非连续空间的链式储存转化为连续空间或块式储存,在访问时则需要进行序列化的逆过程--反序列化,将字节流转化成对象,序列化的方式可以节省存储空间,但增加了内存的读取时候的计算开销

对于 Spark 中序列化的对象,由于是字节流的形式,其占用的内存大小可直接计算,而对于非序列化的对象,其占用的内存是通过周期性地采样近似估算而得,即并不是每次新增的数据项都会计算一次占用的内存大小,这种方法降低了时间开销但是有可能误差较大,导致某一时刻的实际内存有可能远远超出预期[2]。此外,在被 Spark 标记为释放的对象实例,很有可能在实际上并没有被 JVM 回收,导致实际可用的内存小于 Spark 记录的可用内存。所以 Spark 并不能准确记录实际可用的堆内内存,从而也就无法完全避免内存溢出(OOM, Out of Memory)的异常。

虽然不能精准控制堆内内存的申请和释放,但 Spark 通过对存储内存和执行内存各自独立的规划管理,可以决定是否要在存储内存里缓存新的 RDD,以及是否为新的任务分配执行内存,在一定程度上可以提升内存的利用率,减少异常的出现。

- 堆外内存

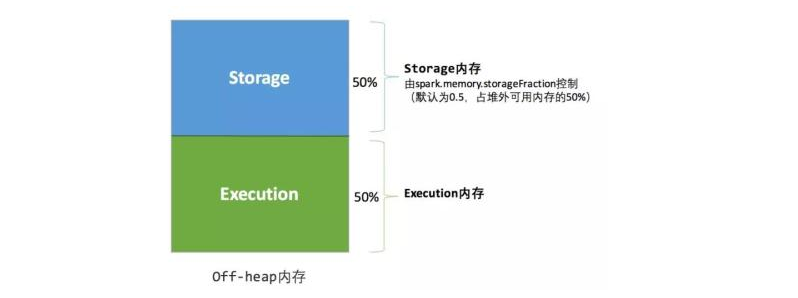

为了进一步优化内存的使用以及提高 Shuffle 时排序的效率,Spark 引入了堆外(Off-heap)内存,使之可以直接在工作节点的系统内存中开辟空间,存储经过序列化的二进制数据。利用 JDK Unsafe API(从 Spark 2.0 开始,在管理堆外的存储内存时不再基于 Tachyon,而是与堆外的执行内存一样,基于 JDK Unsafe API 实现[3]),Spark 可以直接操作系统堆外内存,减少了不必要的内存开销,以及频繁的 GC 扫描和回收,提升了处理性能。堆外内存可以被精确地申请和释放,而且序列化的数据占用的空间可以被精确计算,所以相比堆内内存来说降低了管理的难度,也降低了误差。

在默认情况下堆外内存并不启用,可通过配置 spark.memory.offHeap.enabled 参数启用,并由 spark.memory.offHeap.size 参数设定堆外空间的大小。除了没有 other 空间,堆外内存与堆内内存的划分方式相同,所有运行中的并发任务共享存储内存和执行内存。

7.2 内存空间管理

7.2.1 静态内存管理

在 Spark 最初采用的静态内存管理机制下,存储内存、执行内存和其他内存的大小在 Spark 应用程序运行期间均为固定的,但用户可以应用程序启动前进行配置

- 静态内存管理图-堆内

可用的堆内内存的大小需要按照下面的方式计算

- 可用的存储内存 = systemMaxMemory * spark.storage.memoryFraction * spark.storage.safetyFraction

- 可用的执行内存 = systemMaxMemory * spark.shuffle.memoryFraction * spark.shuffle.safetyFraction

其中 systemMaxMemory 取决于当前 JVM 堆内内存的大小,最后可用的执行内存或者存储内存要在此基础上与各自的 memoryFraction 参数和 safetyFraction 参数相乘得出。上述计算公式中的两个 safetyFraction 参数,其意义在于在逻辑上预留出 1-safetyFraction 这么一块保险区域,降低因实际内存超出当前预设范围而导致 OOM 的风险(上文提到,对于非序列化对象的内存采样估算会产生误差)。值得注意的是,这个预留的保险区域仅仅是一种逻辑上的规划,在具体使用时 Spark 并没有区别对待,和“其它内存”一样交给了 JVM 去管理。

堆外的空间分配较为简单,只有存储内存和执行内存,如图所示。可用的执行内存和存储内存占用的空间大小直接由参数 spark.memory.storageFraction 决定,由于堆外内存占用的空间可以被精确计算,所以无需再设定保险区域。

- 静态内存管理图- 堆外

静态内存管理机制实现起来较为简单,但如果用户不熟悉 Spark 的存储机制,或没有根据具体的数据规模和计算任务或做相应的配置,很容易造成"一半海水,一半火焰"的局面,即存储内存和执行内存中的一方剩余大量的空间,而另一方却早早被占满,不得不淘汰或移出旧的内容以存储新的内容。由于新的内存管理机制的出现,这种方式目前已经很少有开发者使用,出于兼容旧版本的应用程序的目的,Spark 仍然保留了它的实现。

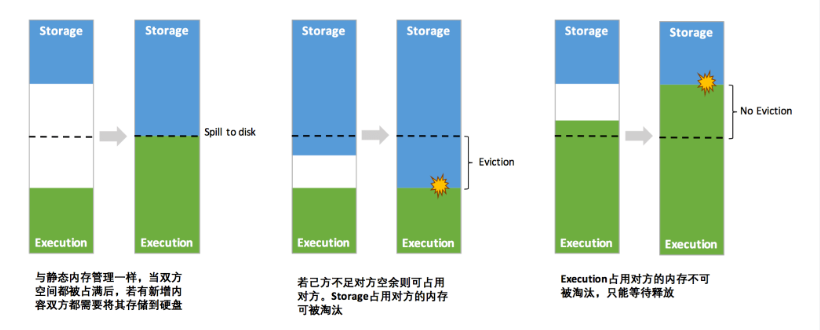

7.2.2 统一内存管理

- 动态占用机制图

凭借统一内存管理机制,Spark 在一定程度上提高了堆内和堆外内存资源的利用率,降低了开发者维护 Spark 内存的难度,但并不意味着开发者可以高枕无忧。譬如,所以如果存储内存的空间太大或者说缓存的数据过多,反而会导致频繁的全量垃圾回收,降低任务执行时的性能,因为缓存的 RDD 数据通常都是长期驻留内存的 。所以要想充分发挥 Spark 的性能,需要开发者进一步了解存储内存和执行内存各自的管理方式和实现原理。

7.2.3 存储内存管理

- RDD 的持久化机制

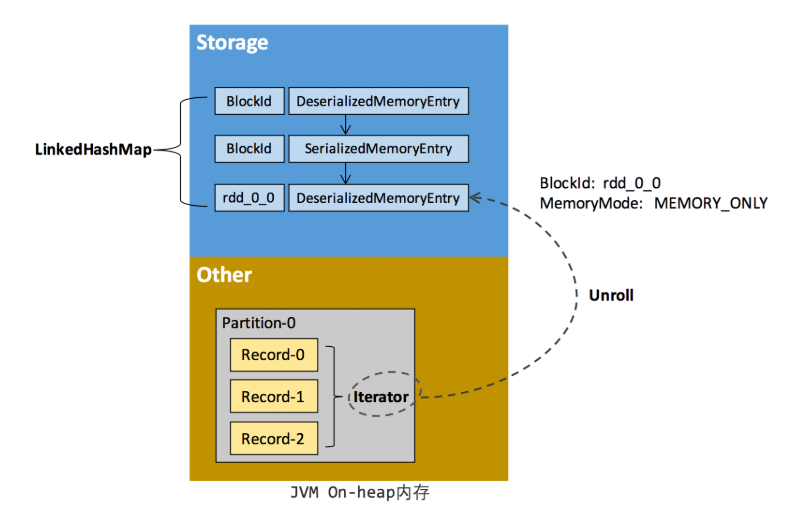

弹性分布式数据集(RDD)作为 Spark 最根本的数据抽象,是只读的分区记录(Partition)的集合,只能基于在稳定物理存储中的数据集上创建,或者在其他已有的 RDD 上执行转换(Transformation)操作产生一个新的 RDD。转换后的 RDD 与原始的 RDD 之间产生的依赖关系,构成了血统(Lineage)。凭借血统,Spark 保证了每一个 RDD 都可以被重新恢复。但 RDD 的所有转换都是惰性的,即只有当一个返回结果给 Driver 的行动(Action)发生时,Spark 才会创建任务读取 RDD,然后真正触发转换的执行。

Task 在启动之初读取一个分区时,会先判断这个分区是否已经被持久化,如果没有则需要检查 Checkpoint 或按照血统重新计算。所以如果一个 RDD 上要执行多次行动,可以在第一次行动中使用 persist 或 cache 方法,在内存或磁盘中持久化或缓存这个 RDD,从而在后面的行动时提升计算速度。事实上,cache 方法是使用默认的 MEMORY_ONLY 的存储级别将 RDD 持久化到内存,故缓存是一种特殊的持久化。 堆内和堆外存储内存的设计,便可以对缓存 RDD 时使用的内存做统一的规划和管 理 (存储内存的其他应用场景,如缓存 broadcast 数据,暂时不在本文的讨论范围之内)。

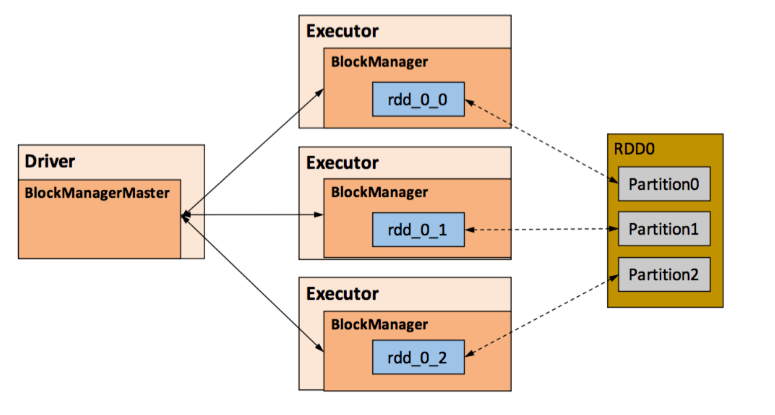

RDD 的持久化由 Spark 的 Storage 模块 [7] 负责,实现了 RDD 与物理存储的解耦合。Storage 模块负责管理 Spark 在计算过程中产生的数据,将那些在内存或磁盘、在本地或远程存取数据的功能封装了起来。在具体实现时 Driver 端和 Executor 端的 Storage 模块构成了主从式的架构,即 Driver 端的 BlockManager 为 Master,Executor 端的 BlockManager 为 Slave。Storage 模块在逻辑上以 Block 为基本存储单位,RDD 的每个 Partition 经过处理后唯一对应一个 Block(BlockId 的格式为 rdd_RDD-ID_PARTITION-ID )。Master 负责整个 Spark 应用程序的 Block 的元数据信息的管理和维护,而 Slave 需要将 Block 的更新等状态上报到 Master,同时接收 Master 的命令,例如新增或删除一个 RDD。

- Storage 模块示意图

在对 RDD 持久化时,Spark 规定的存储级别如下

- DISK_ONLY:持久化到磁盘