神经网络的小批量梯度下降(吴恩达)

首先应该理解到,梯度下降的最终目的就是使梯度为0,整个过程就是在神经网络计算下梯度朝向0梯度一步步前进,当全样本进行一次计算的时候成为一轮

梯度下降的方式有

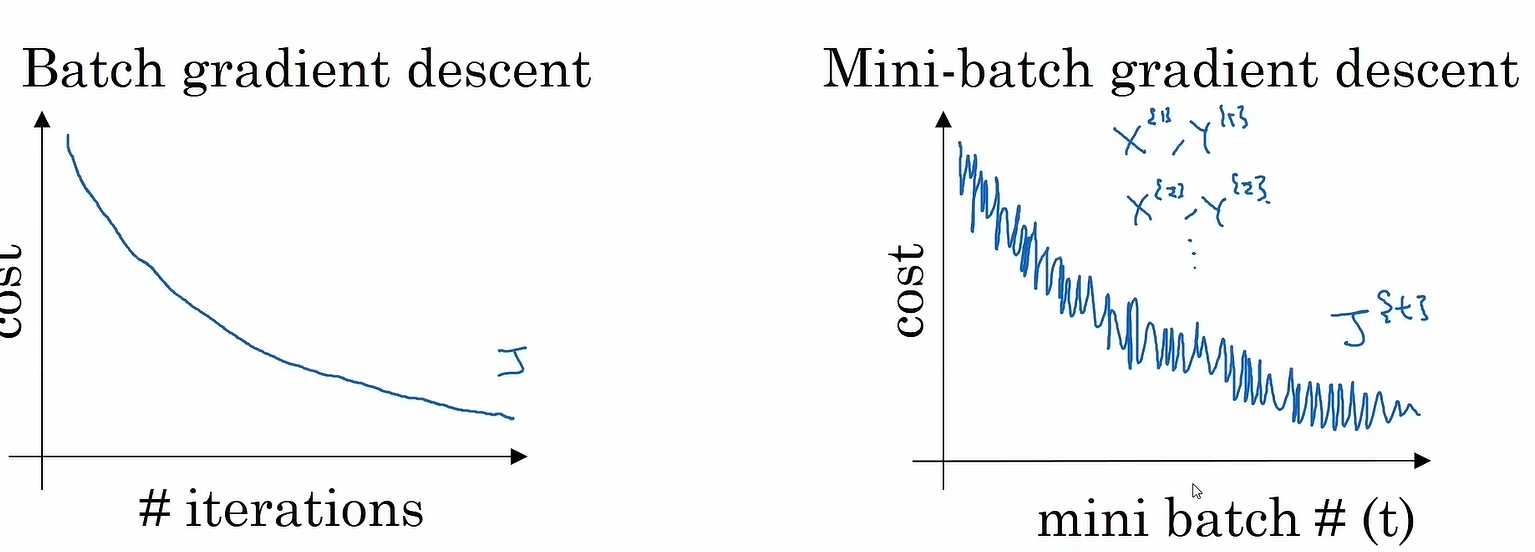

批量梯度下降:即对全样本进行梯度下降计算,一轮前进一步,速度慢,但前进方向稳定

随机梯度下降:即随机抽取样本进行梯度下降计算,速度快,但前进方向不稳定

小批量梯度下降:即将全样本n均等分成m份,一轮前进m步,速度较快,前进方向较为稳定(注:当m=n时则为随机梯度下降,m=1时则为批量梯度下降)

小批量梯度下降

性能原理:

由于将n份数据分为m批,每批都有n/m个数据,对每批进行训练时都梯度下降一步,则n份数据全部训练完时则下降m步,达到提高速度的目的同时梯度下降方向较随机梯度下降更为稳定

可行性:

根据统计学原理,部分样本可以某种程度上表达全样本的性质,所以每批样本都能一定程度代表总样本同时又具有一定的独立性,所以可以让单独一批样本计算出单独一步的梯度下降,但同时由于其独立性导致损失函数J与迭代次数的轨迹图并不是单调下降,如图。

使用注意

Mini-batch的batch大小一般应为2的幂数,如32、64、128等,因为这符合电脑的内存设计

同时要保证batch大小不超过CPU/GPU的内存大小,不然会报错

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通