学会transformer,只用这一片就够了,学不会来砍我!

2022年年底,由人工智能实验室OpenAI发布的对话式大型语言模型ChatGPT,以其强大的信息整合和对话能力惊艳全球,两个月内月活用户突破1亿。随着 ChatGPT 的爆火,不禁有人会产生疑问,如此强大的功能是如何实现的?

ChatGPT使用的是 Transformer 算法。OpenAI 通过使用巨大的语料库,使用 Transformer 架构的神经网络对我进行了预训练,使其能够对文本数据进行高效的处理和生成。那么问题来了,Transformer是什么,他是如何运行的,下面请听我娓娓道来。

1.transformer的结构

在了解transformer的结构之前,让我们先举一个例子。翻译软件大家都知道,随便打开一个翻译软件,进行一次英译汉,比如说我输入i love the 2022 Beijing Winter Games那么结果会输出什么呢?

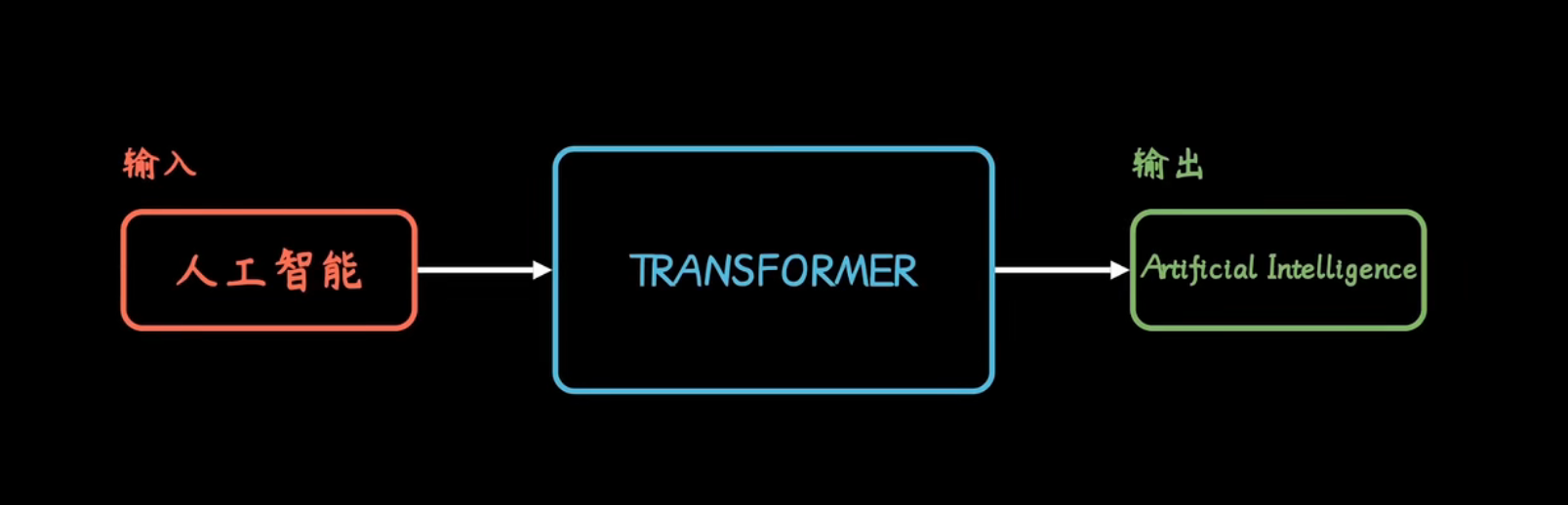

这里我们可以发现,机器成功的翻译出来我们所输入的信息,这里我们所输入的i love the 2022 Beijing Winter Games为输入值,系统输出的为我爱2022年北京冬奥会输出值,我们将软件所进行的不为人知的操作称之为黑箱,因此我们可以将将其分为三部分,输入值,黑箱,输出值,如下图所示。

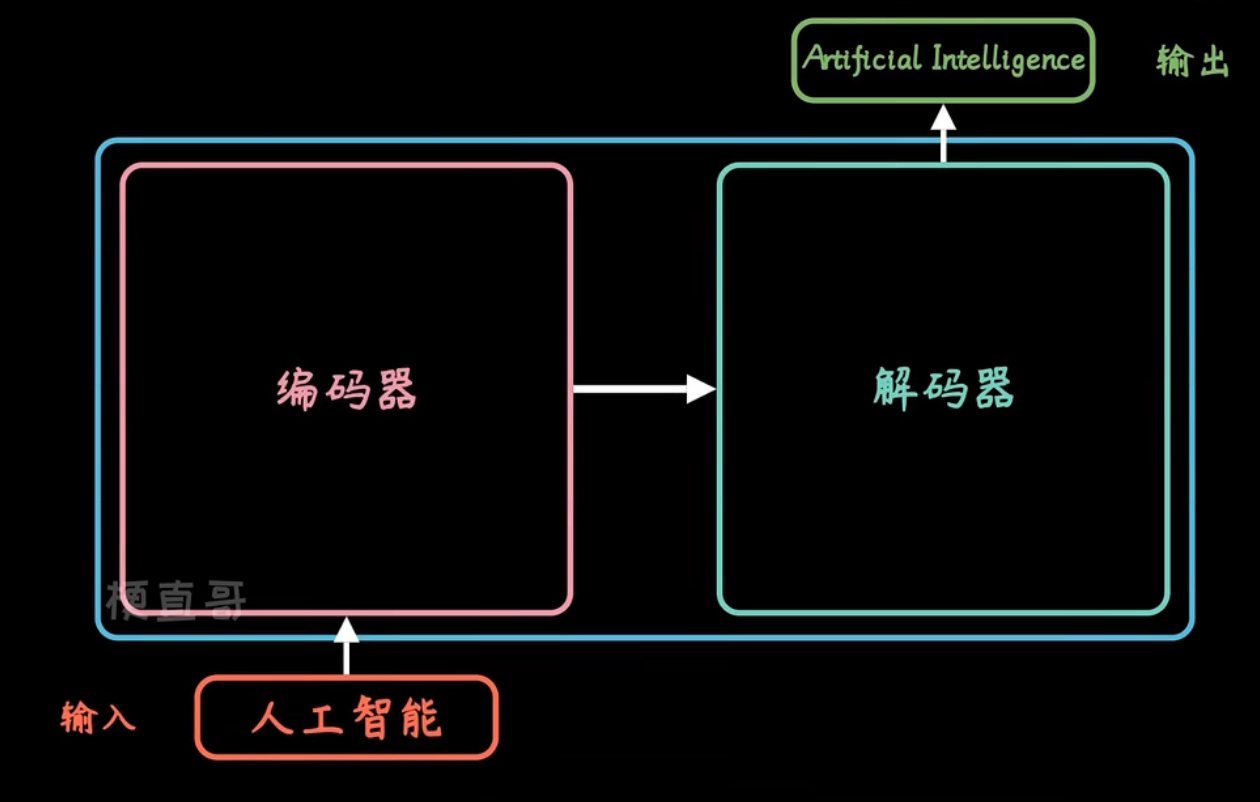

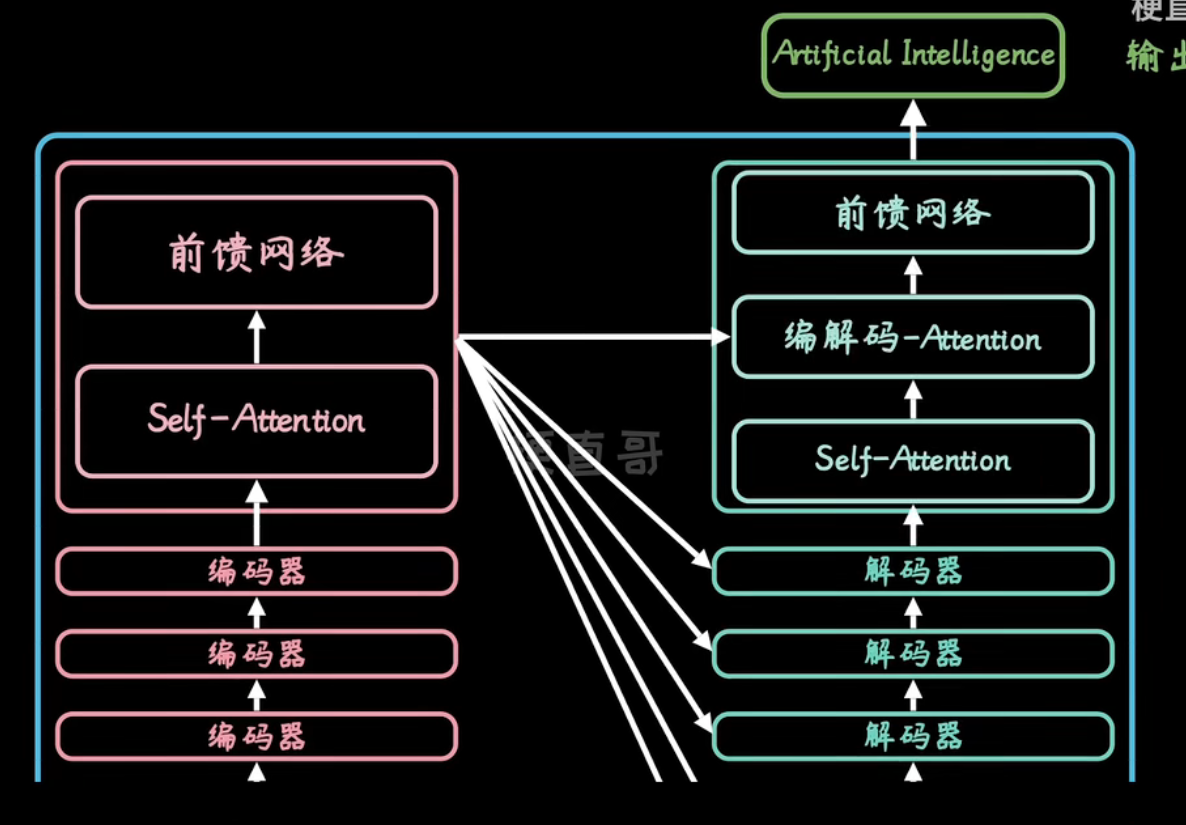

那么这个黑箱中又是什么呢?其实所谓的“黑箱”,就是Transformer,Transformer的构造很简单,有两大部分构成,由Encoder 和 Decoder,也就是编码器与解码器两大部分构成。

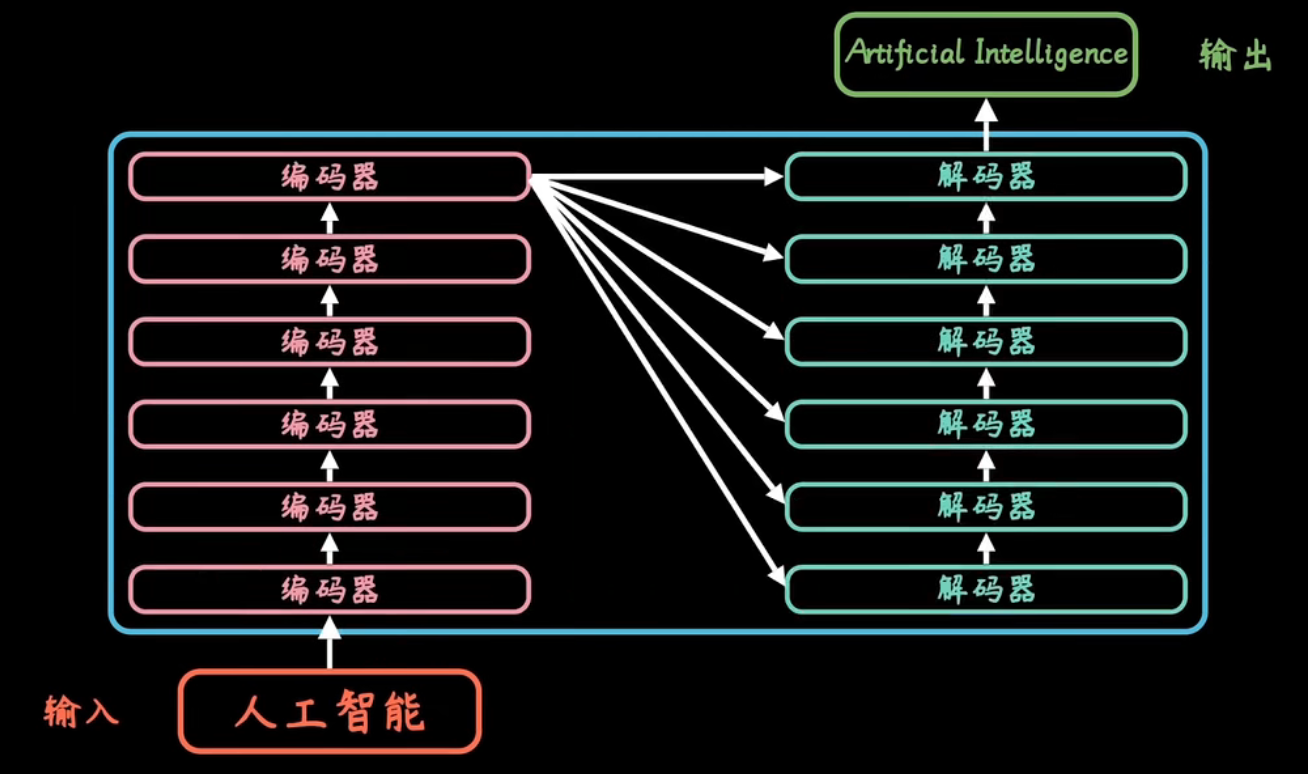

在一般情况下,Encoder和Decoder都分别有6个,因此如下所示

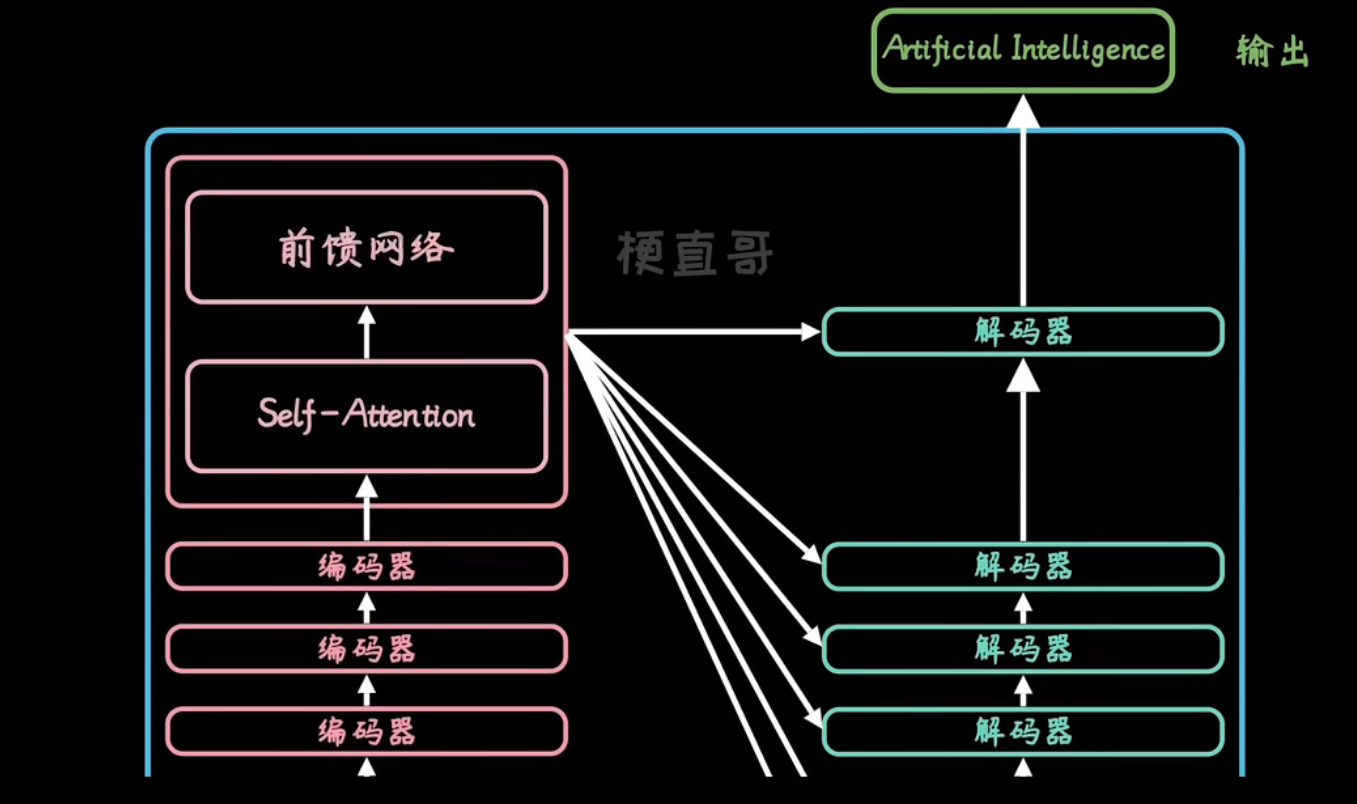

而这里的Encoder,又分为Self-Attention和前馈网络两个部分

Decoder,则在Self-Attention和前馈网络两个部分的基础上,增加了一个encoder-decoder-Attention

到这里,我们的基础架构就讲完了,那么肯定有同学会疑惑,Self-Attention和前馈网络以及encoder-decoder-Attention这些都是干什么的呢?以及transformer具体是如何工作呢?下面我来分别进行详细的讲解。

浙公网安备 33010602011771号

浙公网安备 33010602011771号