Logstash配置同步mysql到es配置

关于logstash安装:https://www.cnblogs.com/toov5/p/10301727.html

Logstash是一个开源数据收集引擎,具有实时管道功能。Logstash可以动态地将来自不同数据源的数据统一起来,并将数据标准化到你所选择的目的地

下面进一步详细说配置:

1 2 3 4 5 6 7 8 9 10 11 | jdbc_driver_library: jdbc mysql 驱动的路径,在上一步中已经下载jdbc_driver_class: 驱动类的名字,mysql 填 com.mysql.jdbc.Driver 就好了jdbc_connection_string: mysql 地址jdbc_user: mysql 用户jdbc_password: mysql 密码schedule: 执行 sql 时机,类似 crontab 的调度statement: 要执行的 sql,以 “:” 开头是定义的变量,可以通过 parameters 来设置变量,这里的 sql_last_value 是内置的变量,表示上一次 sql 执行中 update_time 的值,这里 update_time 条件是 >= 因为时间有可能相等,没有等号可能会漏掉一些增量use_column_value: 使用递增列的值tracking_column_type: 递增字段的类型,numeric 表示数值类型, timestamp 表示时间戳类型tracking_column: 递增字段的名称,这里使用 update_time 这一列,这列的类型是 timestamplast_run_metadata_path: 同步点文件,这个文件记录了上次的同步点,重启时会读取这个文件,这个文件可以手动修改 |

注意:

Crontab:官网 https://tool.lu/crontab/ 注意:Crontab表达式以分为单位

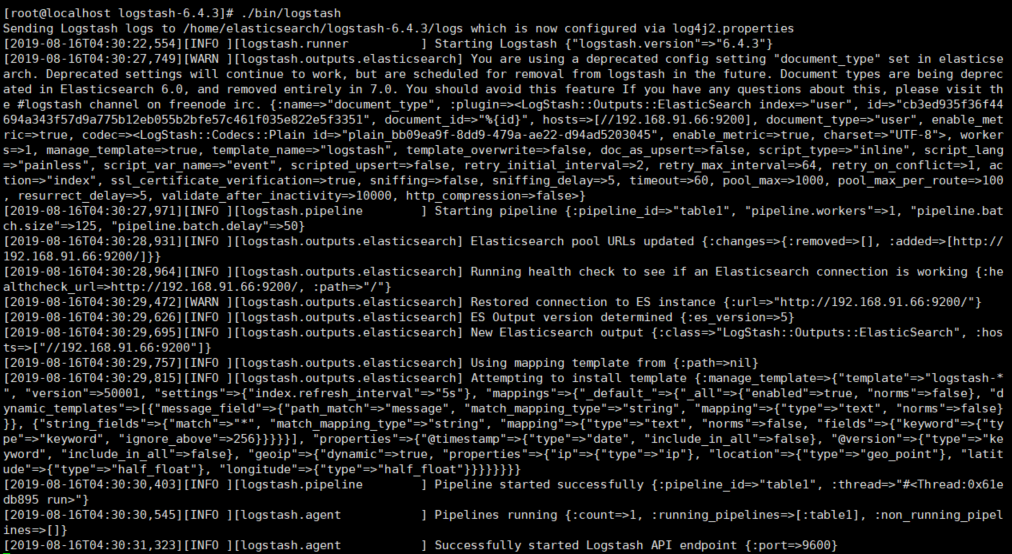

./bin/logstash -f mysql.conf 启动

原理:

Logstash --> 发送查询语句到MySQL,

Logstash -> 发送查询结果到ES

首次查询全部数据(根据时间1970年),记录最后一此数update_time,作为下一次修改时间查询的条件值。数据库新增或者修改、删除的时候都会记录时间。

where update_time >= xxxx-xx-xx

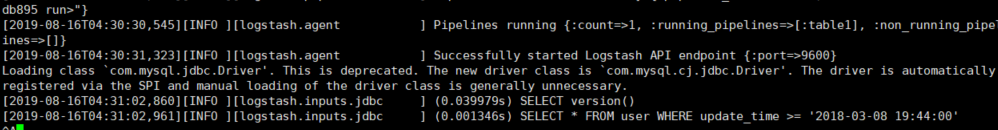

每隔一段时间查询一次。表里面必须有:update_time 字段

同步方式:

1. 主键的新增方式

2. update_time方式

比较:

使用 logstash-input-jdbc 插件读取 mysql 的数据,这个插件的工作原理比较简单,就是定时执行一个 sql,然后将 sql 执行的结果写入到流中,增量获取的方式没有通过 binlog 方式同步,而是用一个递增字段作为条件去查询,每次都记录当前查询的位置,由于递增的特性,只需要查询比当前大的记录即可获取这段时间内的全部增量,一般的递增字段有两种,AUTO_INCREMENT 的主键 id 和 ON UPDATE CURRENT_TIMESTAMP 的 update_time 字段,id 字段只适用于那种只有插入没有更新的表,update_time 更加通用一些,建议在 mysql 表设计的时候都增加一个 update_time 字段。

综上所述配置:

cd /home/elasticsearch/logstash-6.4.3/config

input {

jdbc {

jdbc_driver_library => "/home/mysql5.7/mysqlDriver/mysql-connector-java-8.0.13.jar"

jdbc_driver_class => "com.mysql.jdbc.Driver"

# 8.0以上版本:一定要把serverTimezone=UTC天加上

jdbc_connection_string => "jdbc:mysql://192.168.124.8:3306/test?characterEncoding=utf8&useSSL=false&serverTimezone=UTC&rewriteBatchedStatements=true"

jdbc_user => "root"

jdbc_password => "root"

schedule => "* * * * *"

statement => "SELECT * FROM user WHERE update_time >= :sql_last_value"

use_column_value => true

tracking_column_type => "timestamp"

tracking_column => "update_time"

last_run_metadata_path => "syncpoint_table"

}

}

output {

elasticsearch {

# ES的IP地址及端口

hosts => ["192.168.91.66:9200"]

# 索引名称 可自定义

index => "user"

# 需要关联的数据库中有有一个id字段,对应类型中的id

document_id => "%{id}"

document_type => "user"

}

stdout {

# JSON格式输出

codec => json_lines

}

}

将配置文件丢到config下: 名字为mysql.conf,随便起的

启动: ./bin/logstash ./config/mysql.conf

注意:因为我用的是mysql的最新的驱动8.多的版本,所以配置数据库的url时候一定要把serverTimezone=UTC天加上!

同时mysql数据库:

grant all privileges on *.* to 'root'@'%' identified by 'root' with grant option;

FLUSH PRIVILEGES;

很慢的,启动过程盯着日志:

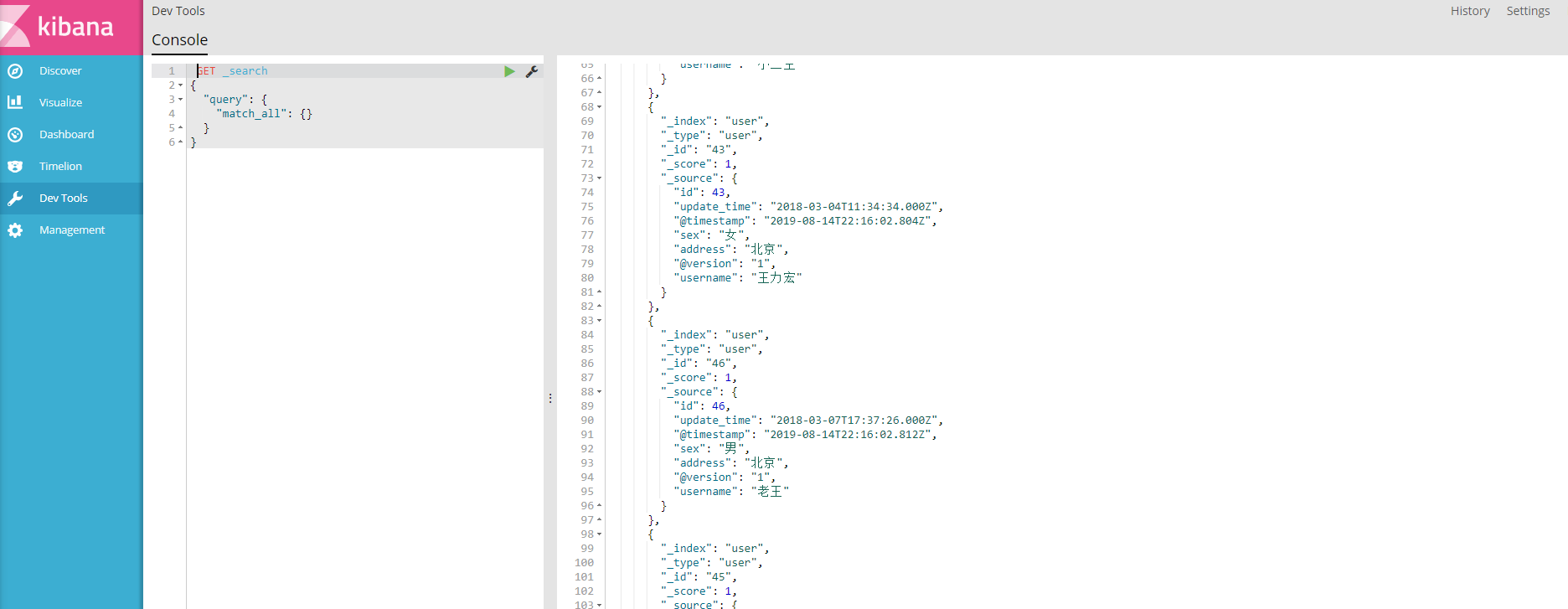

kinbana:

如果同步多个多个表:

配合多个上述的config,然后将其地址配置文件中:

追加到最后一行,可以配置多个。

启动方式为:

./bin/logstash

其他同步方案比较:

Logstash: 定时器方式, 实现简单

MQ: 实时性,复杂性更高,数据一致性好(自带重试,补偿)

补充:

ES集群搭建: https://www.cnblogs.com/toov5/p/11361413.html

kibana连接ES集群:

docker run -it -d -e ELASTICSEARCH_URL=http://127.0.0.1:9200 --name kibana --network=container:ES01 kibana

访问:

http://192.168.91.66:5601

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· winform 绘制太阳,地球,月球 运作规律

· AI与.NET技术实操系列(五):向量存储与相似性搜索在 .NET 中的实现

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)