Kafka数据查询工具——Offset Explorer

官方地址下载,有mac,windows和linux版本

https://www.kafkatool.com/download.html

1.查看kafka topic中的数据(支持byte,string和avro)

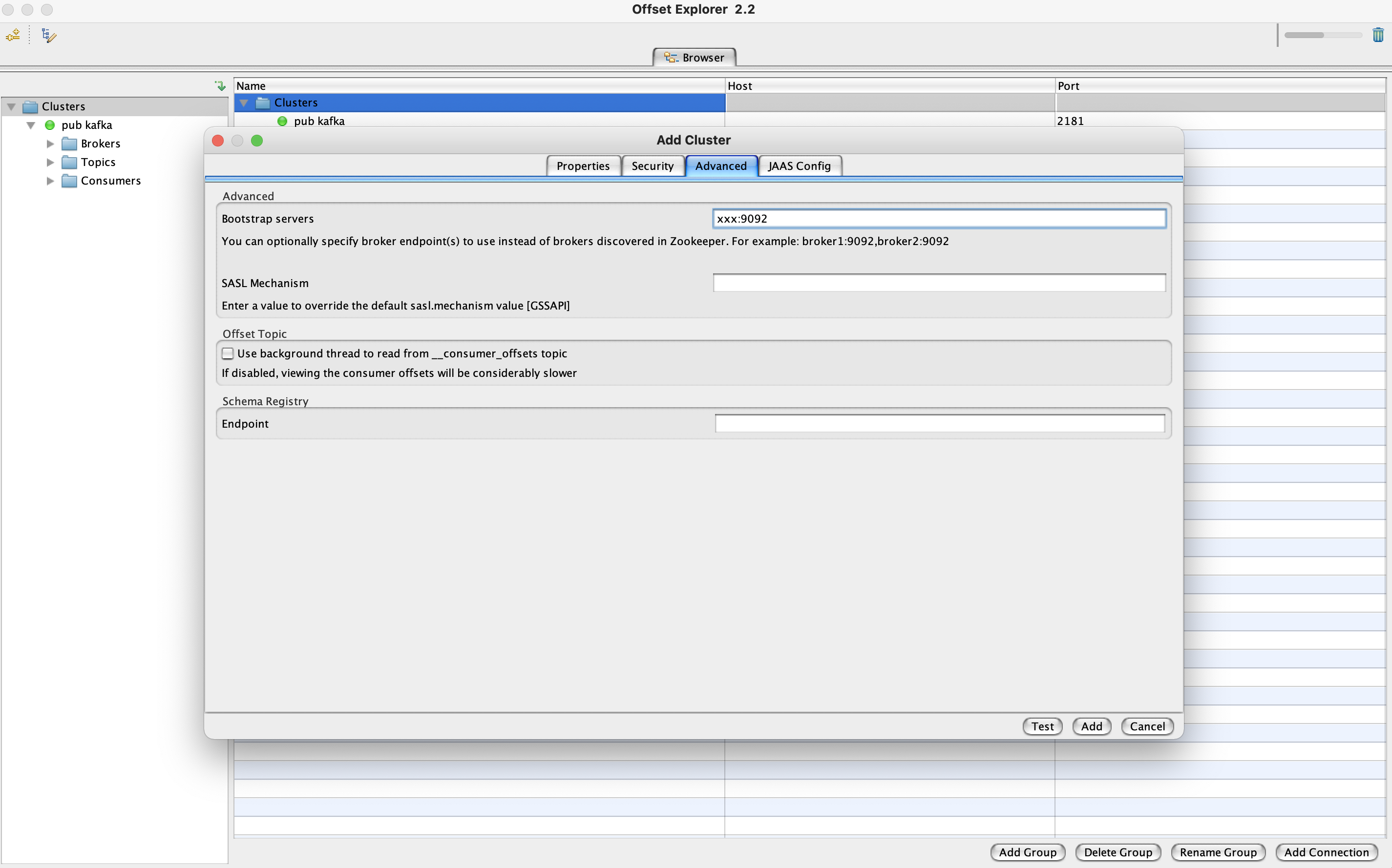

安装后添加kafka集群的地址,可以选择使用zk地址或者kafka的broker地址来连接集群,这里选择使用kafka broker地址来连接

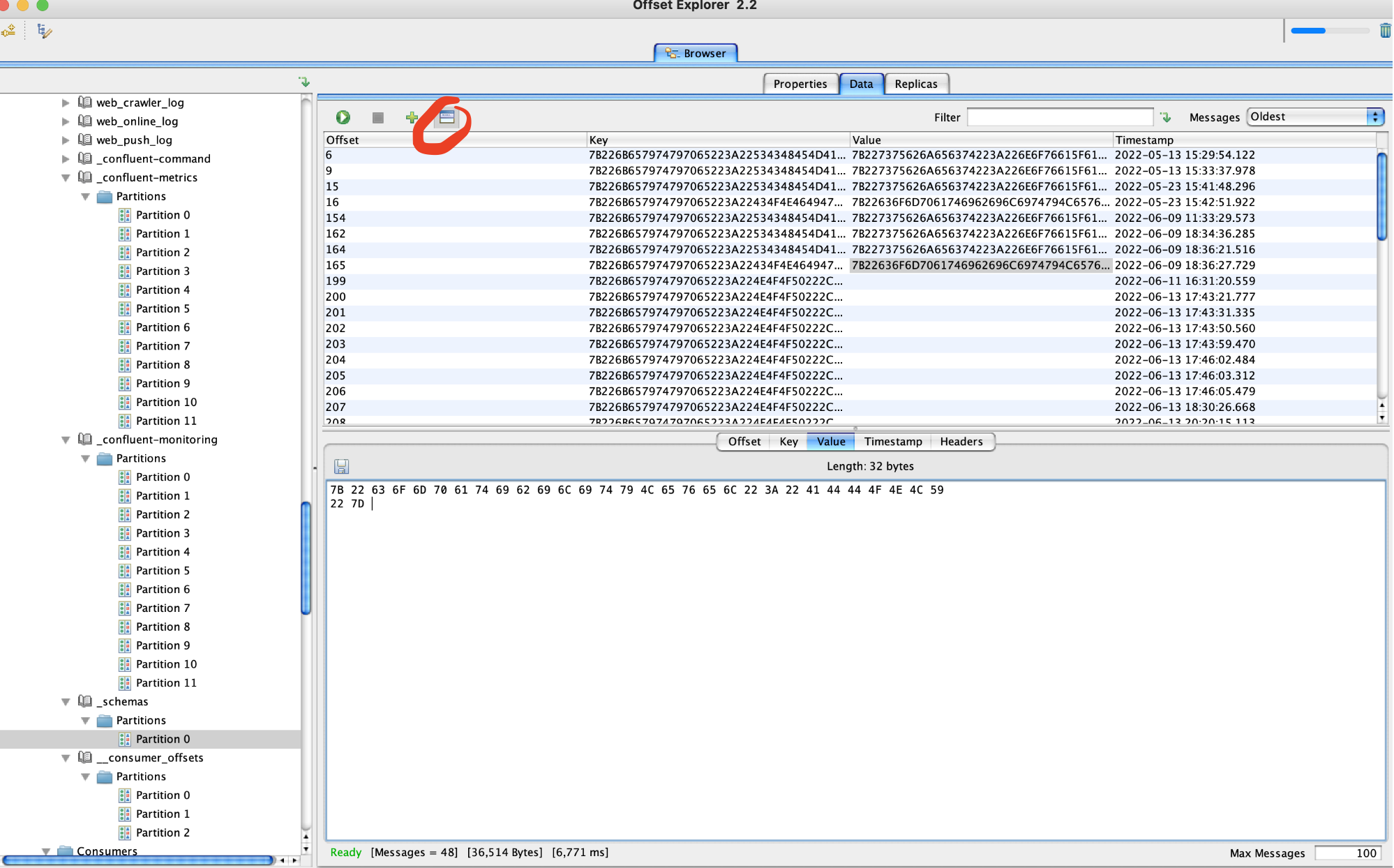

可以指定topic的partition和offset查看数据

默认查出来的数据是byte数组,即16进制的,可以借助在线转换工具将其转换成字符串后进行查看,比如

https://tool.lu/hexstr/

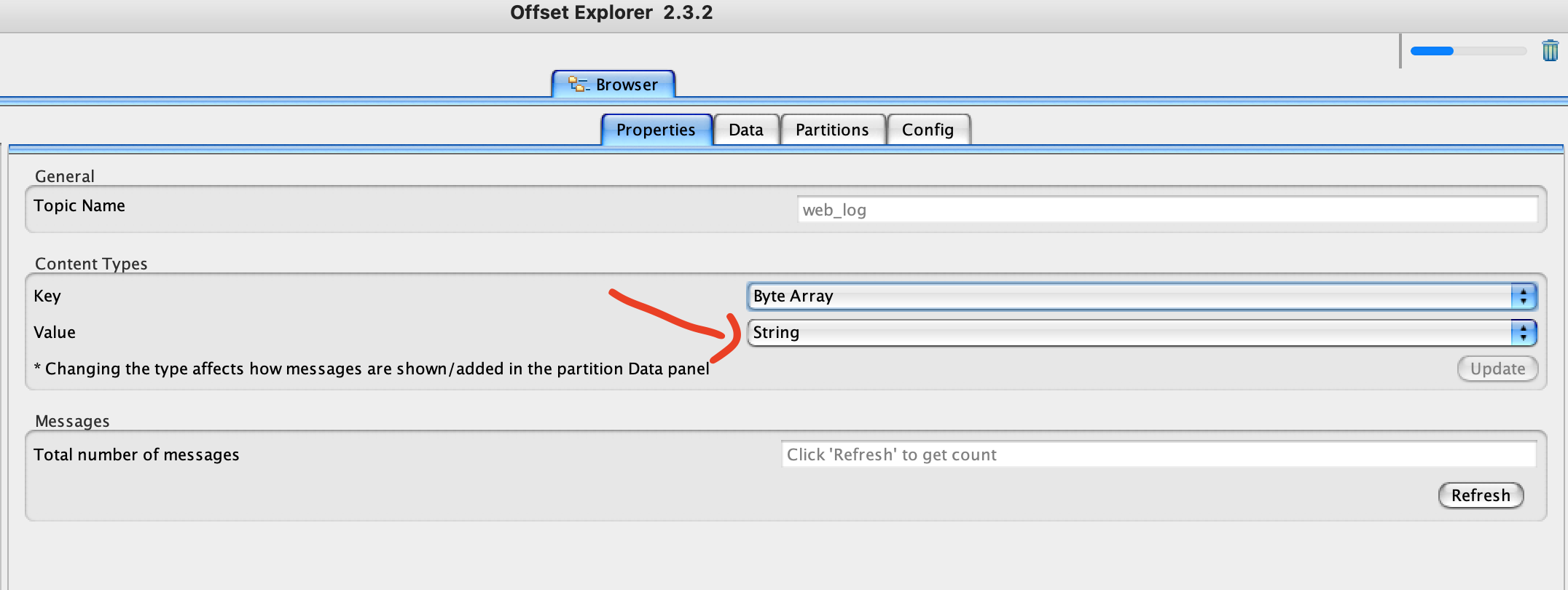

也可以在属性中设置value为String,这样就可以直接查看反序列化后字符串

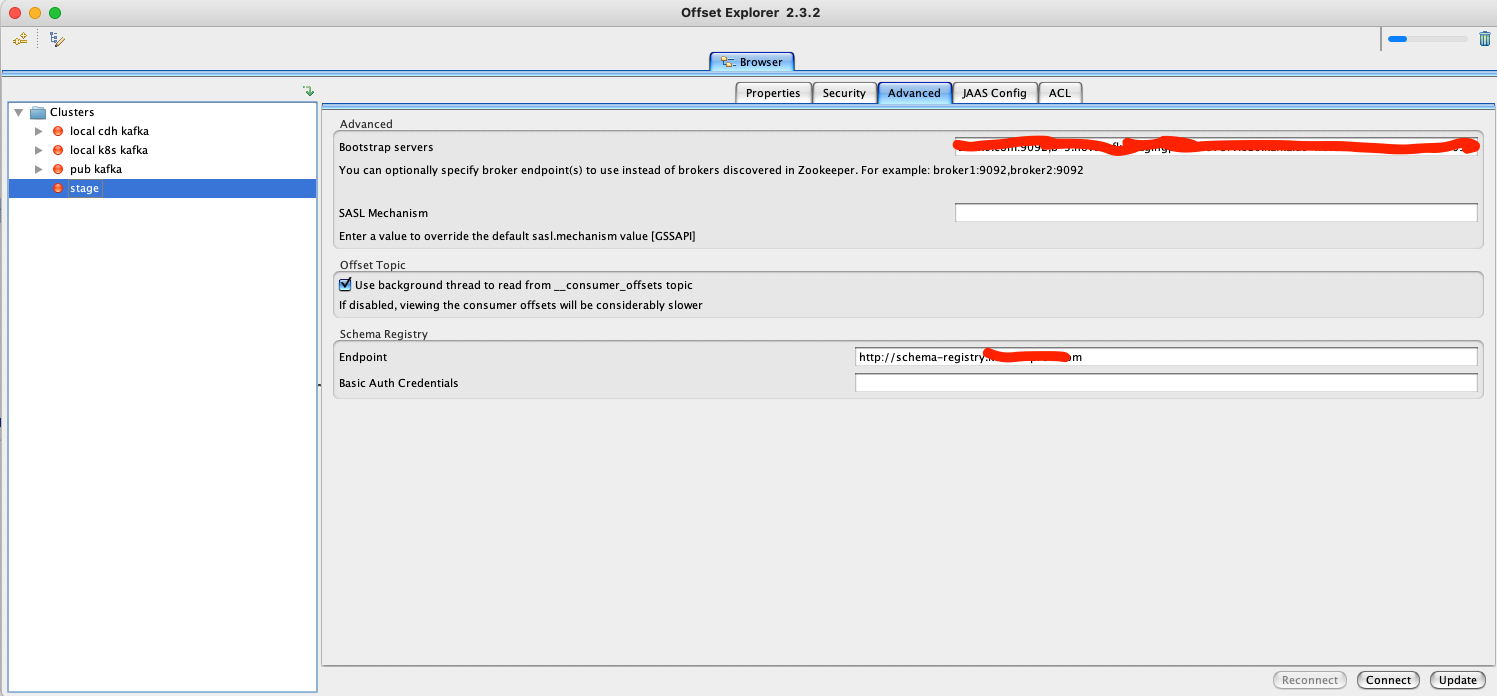

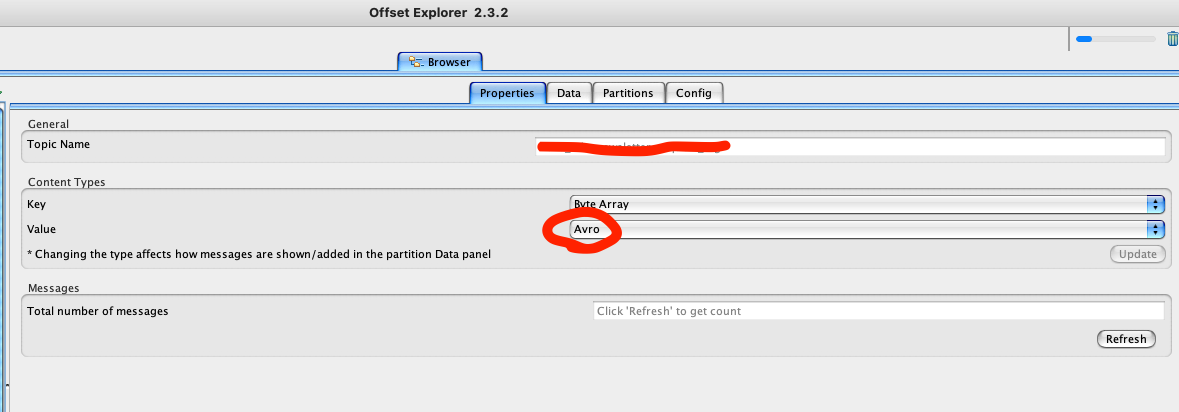

offset explorer的新版本也支持了对confluent schema registry和avro格式数据的支持,使用方法如下

调整offset explorer每次从topic取数的条数,原来的条数过多可能会比较卡,从每个partition取5000条调整成500条

给kafka集群配置schema registry的地址,注意需要加上http的前缀,然后update

给topic配置value的格式,设置成avro,然后update

可以看到解析后的avro数据

如果有报错的话,可以去查看日志,日志路径mac系统如下

/Applications/Offset Explorer 2.app/Contents/Resources/app/error.log

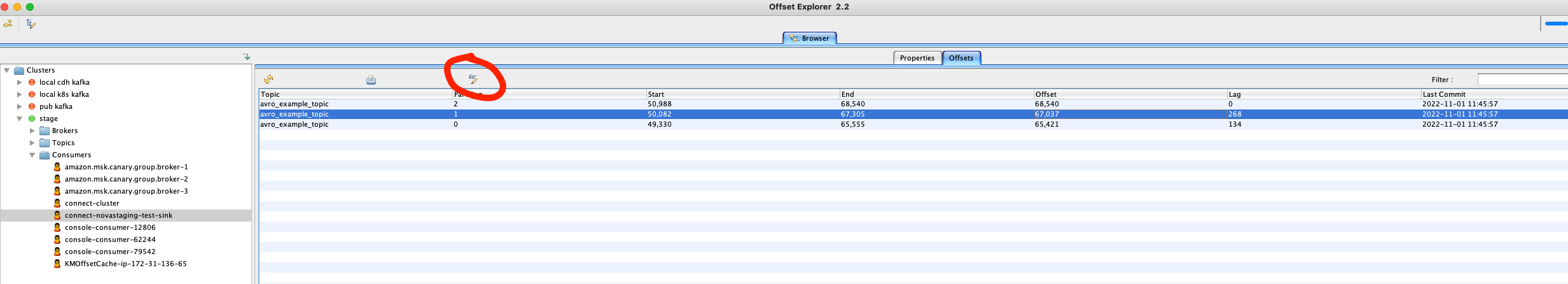

2.调整consumer的offset

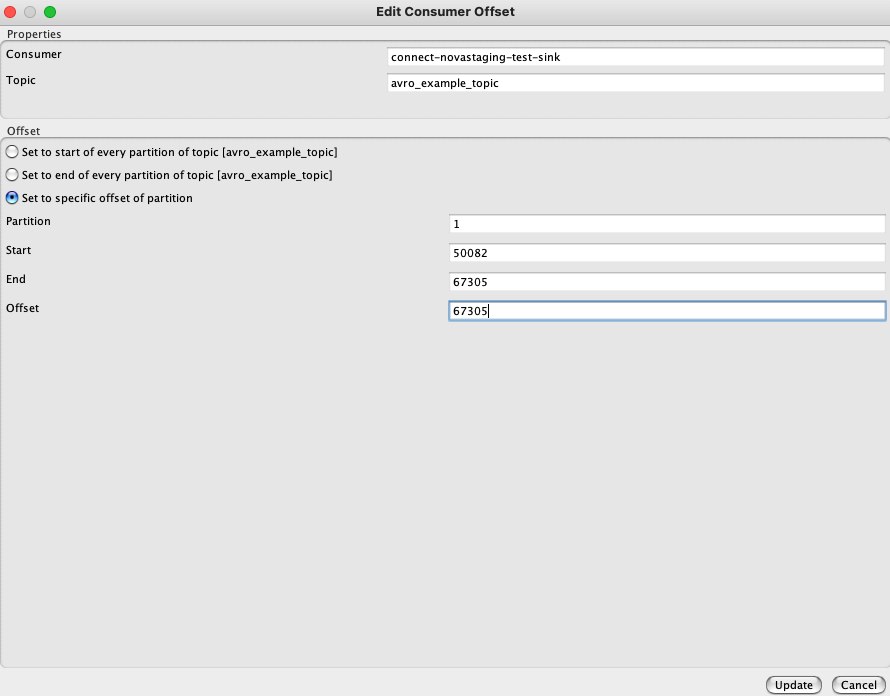

offset explorer也支持编辑consumer的offset,在consumer中选择你要修改offset的消费者,点击edit consumer offset

编辑specific offset后update

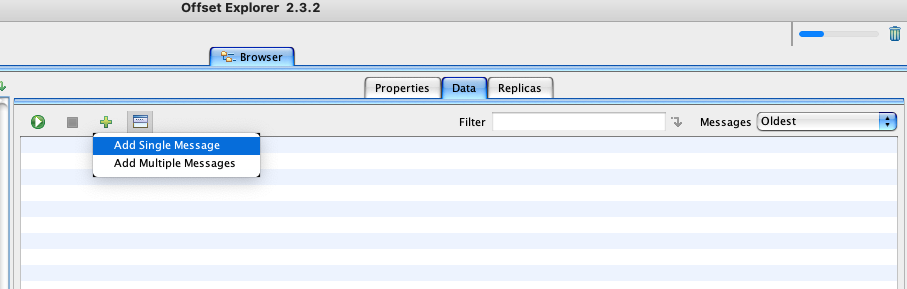

3.发送数据到kafka topic

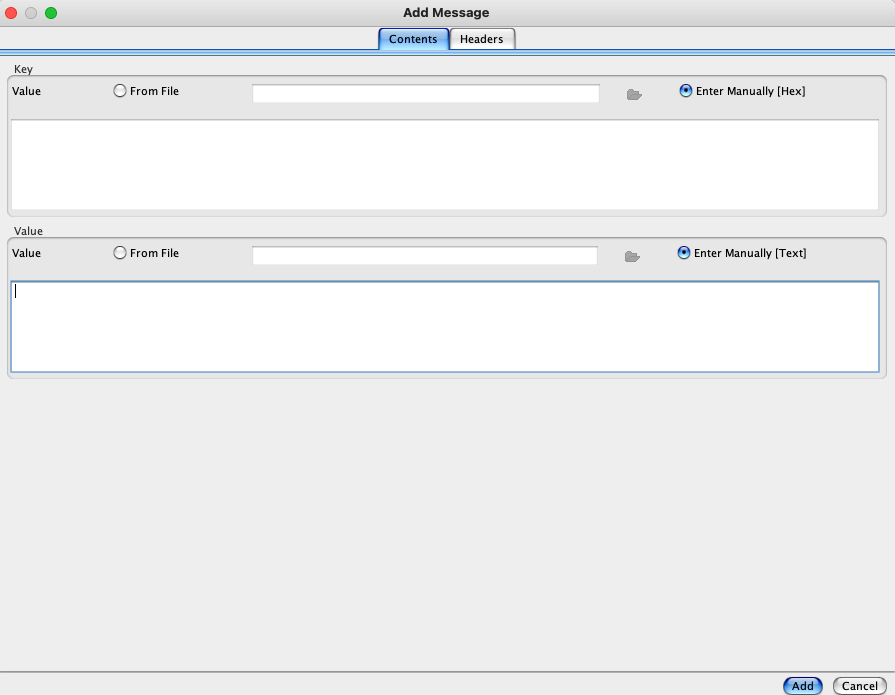

点到topic的具体某个partition,然后点击加好来add message

点击enter manually,所输入的消息需要和你设置的topic key和value格式对应,即value如果是string的话,需要输入文本;如果是byte的话,需要输入hex字节数组

本文只发表于博客园和tonglin0325的博客,作者:tonglin0325,转载请注明原文链接:https://www.cnblogs.com/tonglin0325/p/5276976.html