P9 为什么正则化可以减少过拟合

我们通过几个例子直观体会如何运作。

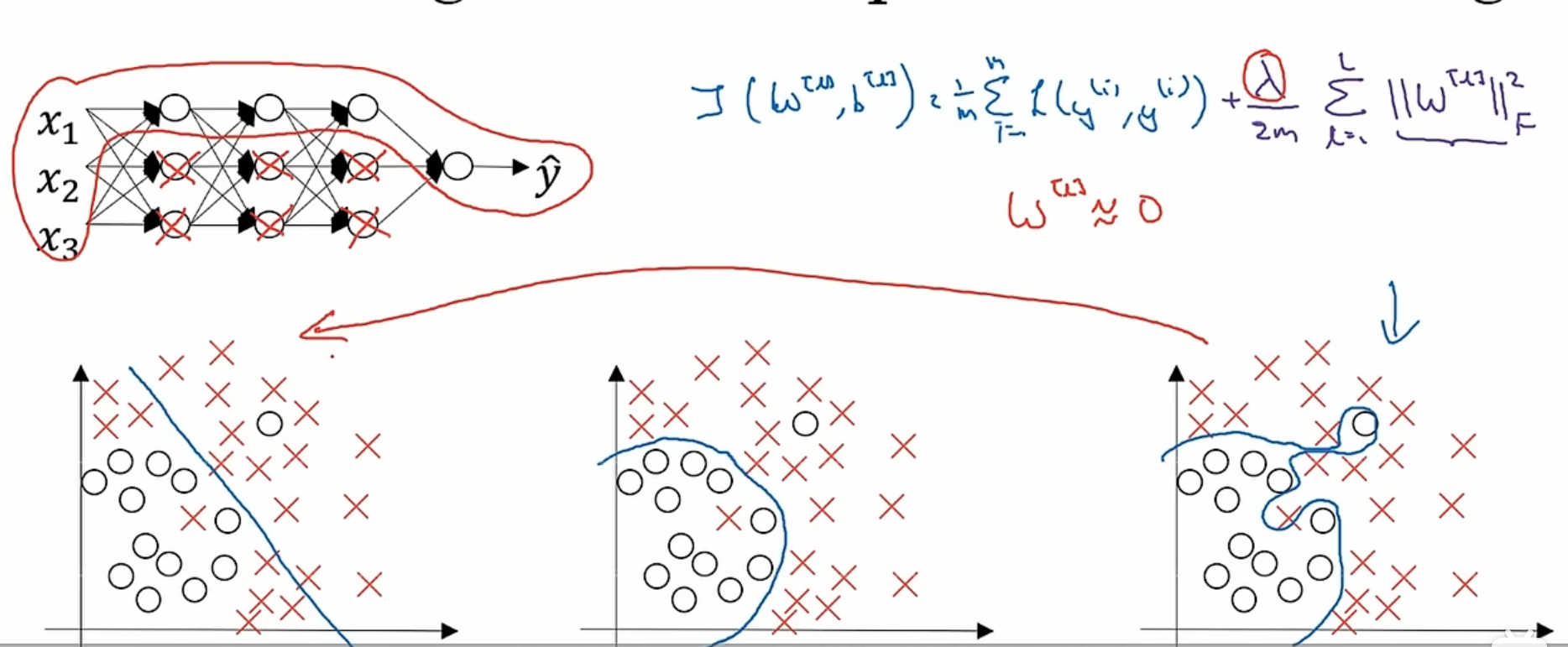

通过对神经网络的代价函数进行正则化,我们为什么可以解决过拟合???

一个比较直观的解释就是,当我们把λ 设置的非常大,权重矩阵w就会被设置为非常接近0的值,这个直观的理解就是把很多隐藏神经元的权重几乎设置成0了,这就导致这些隐藏神经元的影响被消除了,神经网络被大大简化了,从一个非常庞大的神经网络,从一个能够把训练集拟合的很好的神经网络变成一个规模变小的神经网络。这个算法会接近逻辑回归算法,也就是二分方法。

但是也有可能,我们的λ选择的太大,导致w矩阵太小,我们的神经网络太简单以至于不能很好的拟合数据,变成了更加接近欠拟合的状态。但是不用担心,λ存在一个中间值能够让图像变得“just right”

从λ变大,激活函数的角度看

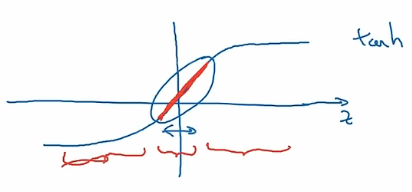

tanh函数:

当λ变大,w权重矩阵变小(因为在代价函数中w是这样变化的)

激活函数g(z)=tanh(z)

z=wa+b

所以我们看到z会随着w的变小而变小,最终函数tanh就变成红色的这一段趋近于线性函数的函数

如果说这样的激活函数代表了隐藏神经元的激活函数,那么这些函数都变成了线性的,简单的神经网络也会趋于线性,最后在函数图像上的呈现就是减少了弯弯曲曲的分类,而是以相对线性的方式拟合。