梯度下降法注意要点

1.不同的起始点,可能导致最后得到的局部最小值点不同。

2.同时更新:

以代价函数J(θ0,θ1)为例:

我们的目的就是要同时迭代更新θ0和θ1,直到下面这个式子收敛,这也是梯度下降法的核心

其中,j取值为0和1。

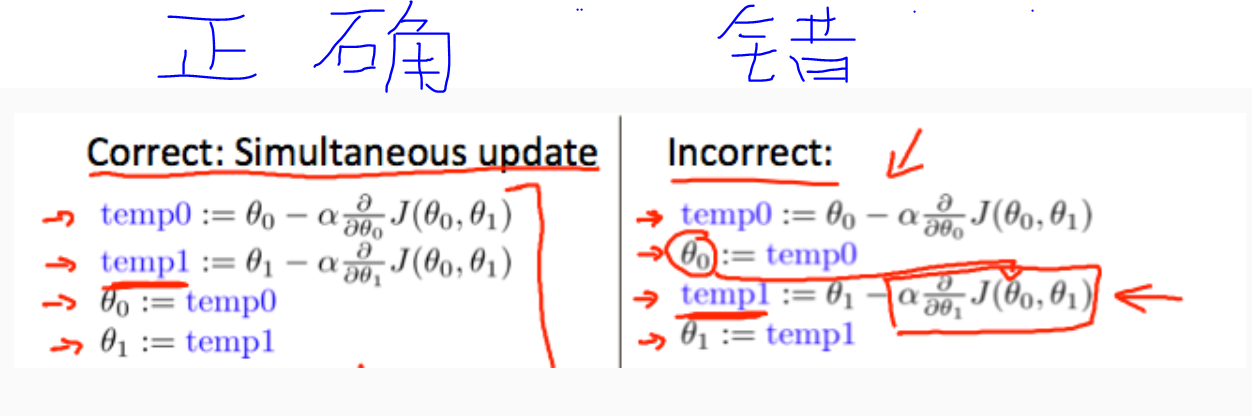

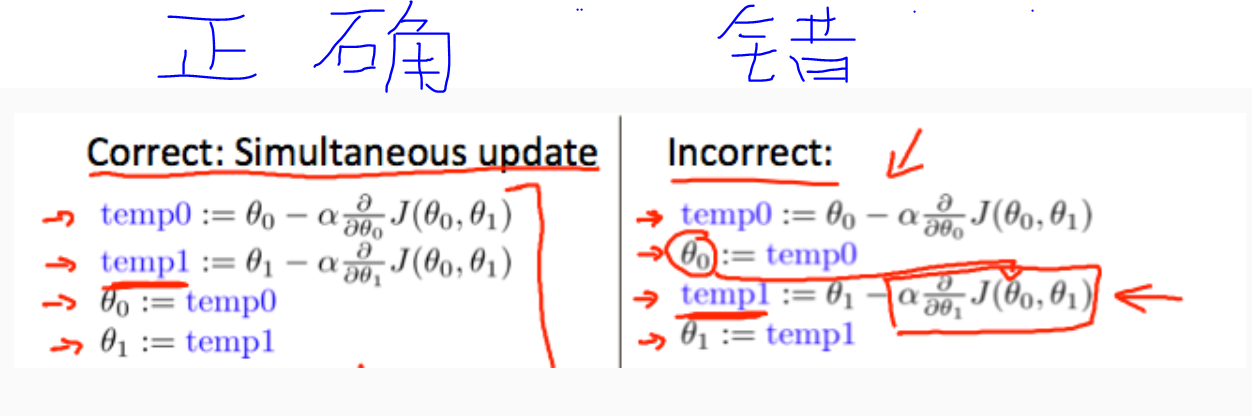

每次迭代的时候,我们需要同时更新θ1,θ2,...,θn,我个人的理解就是,先都用原来的θ1,θ2,...,θn,对各自的θj求完偏导数之后,再进行迭代更新:

直接上图,更能解释清楚:

1.不同的起始点,可能导致最后得到的局部最小值点不同。

2.同时更新:

以代价函数J(θ0,θ1)为例:

我们的目的就是要同时迭代更新θ0和θ1,直到下面这个式子收敛,这也是梯度下降法的核心

其中,j取值为0和1。

每次迭代的时候,我们需要同时更新θ1,θ2,...,θn,我个人的理解就是,先都用原来的θ1,θ2,...,θn,对各自的θj求完偏导数之后,再进行迭代更新:

直接上图,更能解释清楚: