assignment3

Assignment 3

Image Captioning with Vanilla RNNs

* jordn rnn is better than elman rnn ! why ? just look at their struture!

* lstm 是一种网络,还是网络中的 cell ?

* vanilla rnn 的梯度计算方法比较特殊~,采用的是把 时间序列中的梯度全部相加的方法(这样来看 ml 中的数学计算并不严谨 。rnn 为了防止梯度爆炸都能 clip !)

* 日狗了, tanh 的函数的导数公式在 cs231n 课件上有~,亏我搞的那么辛苦!

* rnn backward 为什么要那么算?

* 学会了用 matrix 做为 indx !

Image Captioning with LSTMs

* LSTM 都有 n 个变种

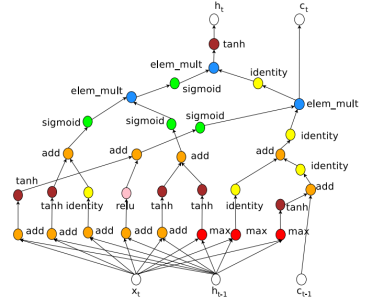

Q2.1 LSTM 结构图

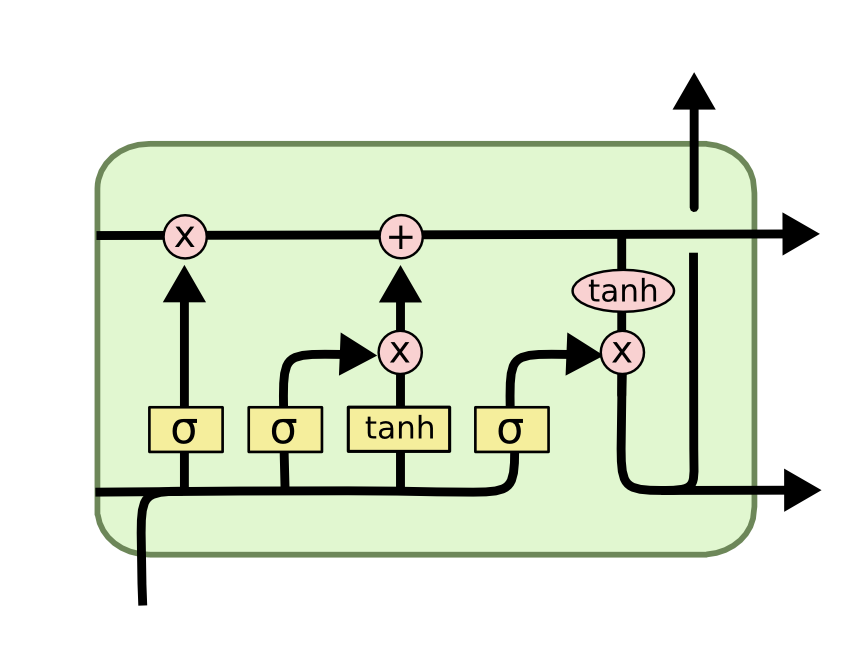

Q2.2 : LSTM 结构图 2

* 懒的去写 lstm_step_backward, 烦!

Network Visualization: Saliency maps, Class Visualization, and Fooling Images (15 points)

* 梯度方向全靠猜,不是正就是负。 梯度方向没有写错,只是场合不同。 有的例子是用来欺骗 算法的,有的例子是生成 和真实更近似的图片。所以处理梯度的方式不同!

Style Transfer (15 points)

* 为什么矩阵的 size 是那个样子,完全没看懂!

* 没有看论文,完全是手动开撸~

* 磕磕巴巴地做完本练习

j_inc_loss = torch.sum((img[:,:,:,1:] - img[:,:,:,:-1])**2)

i_inc_loss = torch.sum((img[:,:,1:,:] - img[:,:,:-1,:])**2) 这段代码有点靓!

Generative Adversarial Networks (15 points)

题外话

1. 江湖趣谈: 在 09 年时后,只有 word2vector 作者写的 rnn 能收敛!他采用 clip 操作来限制爆炸的梯度

2. 趣谈: dynet 的作者是个 “一言不合就造轮子的人!”

浙公网安备 33010602011771号

浙公网安备 33010602011771号