关于在scrapy中使用xpath

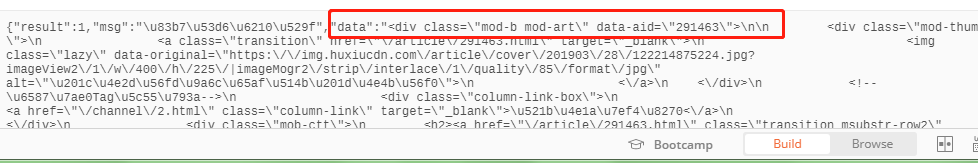

1. 还是以虎嗅为例,他给我返回的是一个json格式的json串

2.那么我需要操作的就是把json串转换成我们的字典格式再进行操作

str=json.loads(response.body)['data'] #这边是拿到响应体数据,然后进行序列化成字典,拿到字典中key为data的的值.是一个字符串

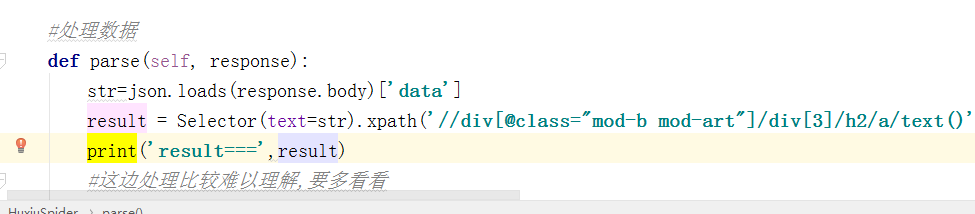

3.自己导入选择器

from scrapy.selector import Selector

4.使用Selector的xpath方法获取内容

result = Selector(text=你从json提取出来的str).xpath('你的xpath表达式').extract()

5.使用效果

我把上一篇虎嗅的在parse中修改了来示范一下

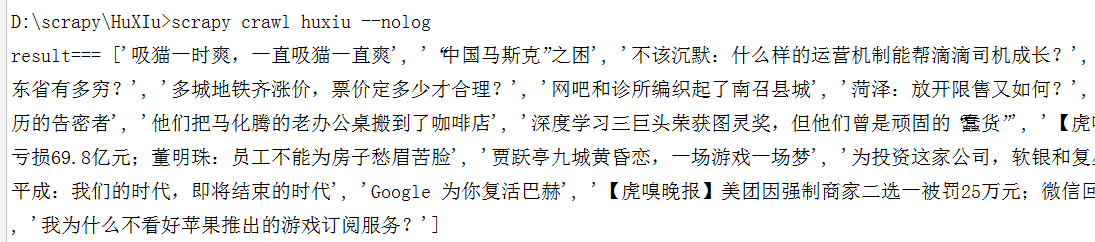

#处理数据 def parse(self, response): str=json.loads(response.body)['data'] result = Selector(text=str).xpath('//div[@class="mod-b mod-art"]/div[3]/h2/a/text()').extract() print('result===',result) #这边处理比较难以理解,要多看看

5.文档

当输入 response.selector 时, 您将获取到一个可以用于查询返回数据的selector(选择器),

以及映射到 response.selector.xpath() 、 response.selector.css() 的

快捷方法(shortcut): response.xpath() 和 response.css() 。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:基于图像分类模型对图像进行分类

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 25岁的心里话

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 闲置电脑爆改个人服务器(超详细) #公网映射 #Vmware虚拟网络编辑器