python新冠疫情分析-世界疫情数据爬取

事情发展:

1、毕业设计是关于疫情数据的可视化展示(基于java,需要做数据可视化,需要做管理员端对数据进行增删改查处理)

2、飞起来速度学爬虫,参考了非常多资料,比如b站的黑马爬取(报错,就是在切片那里),比如好多视频(爬取了腾讯的数据国外数据的url:https://view.inews.qq.com/g2/getOnsInfo?name=disease_foreign&callback=jQuery35106040382931116555_1642917468969&_=1642917468970 但是josn文件我用pprint出来之后将这些分类好这一块不会 导致一直报错也没有什么进展 当然也是在分片数据那里出了问题)

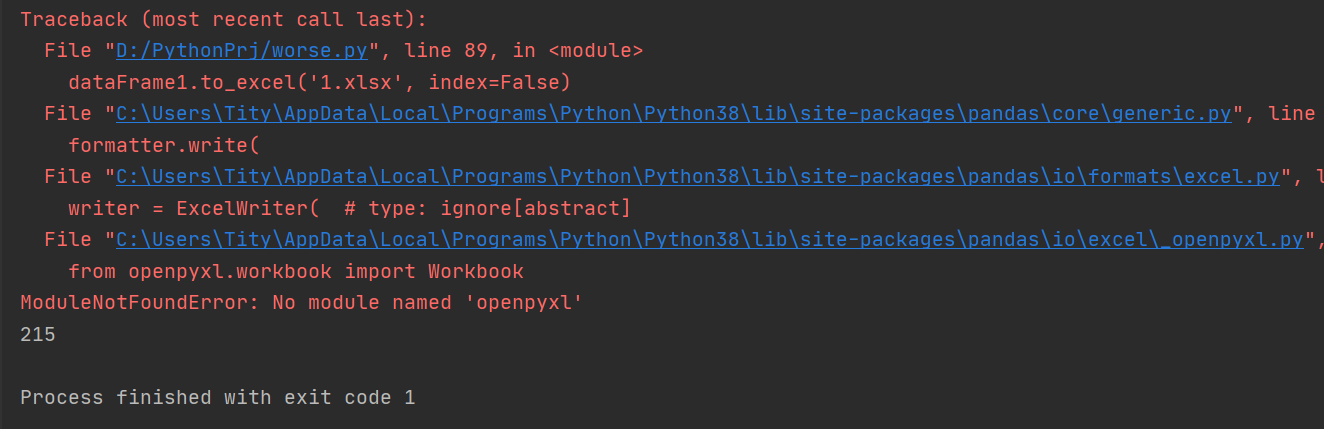

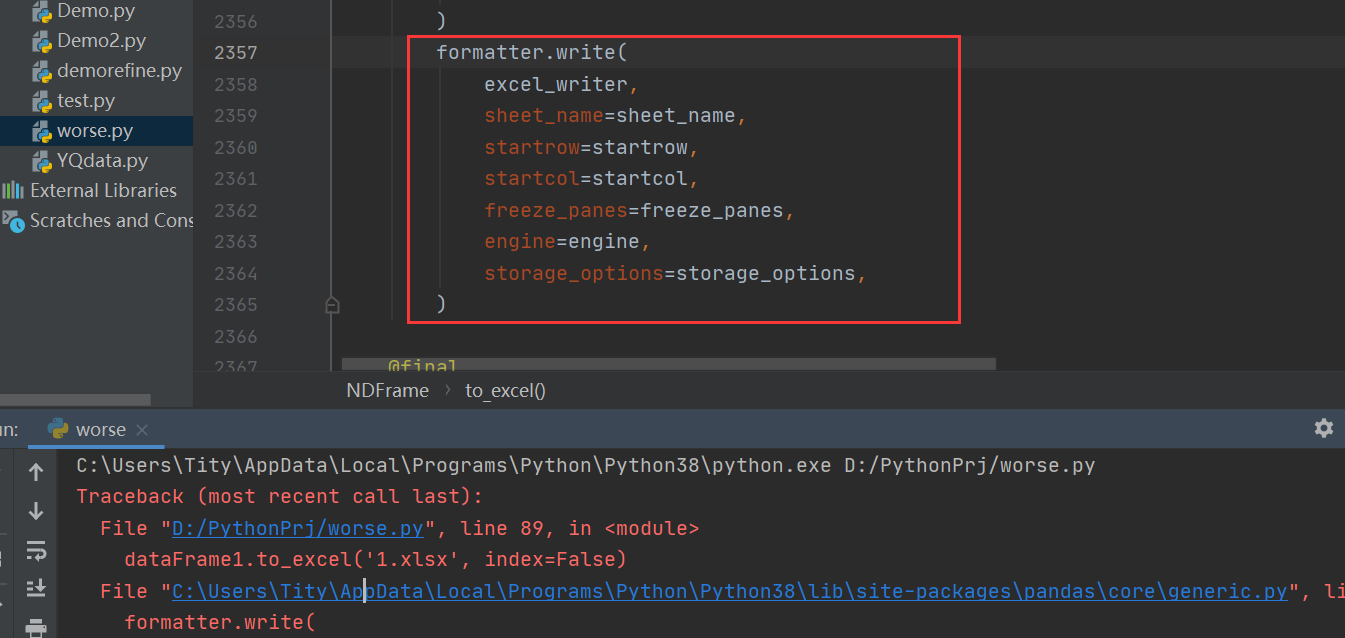

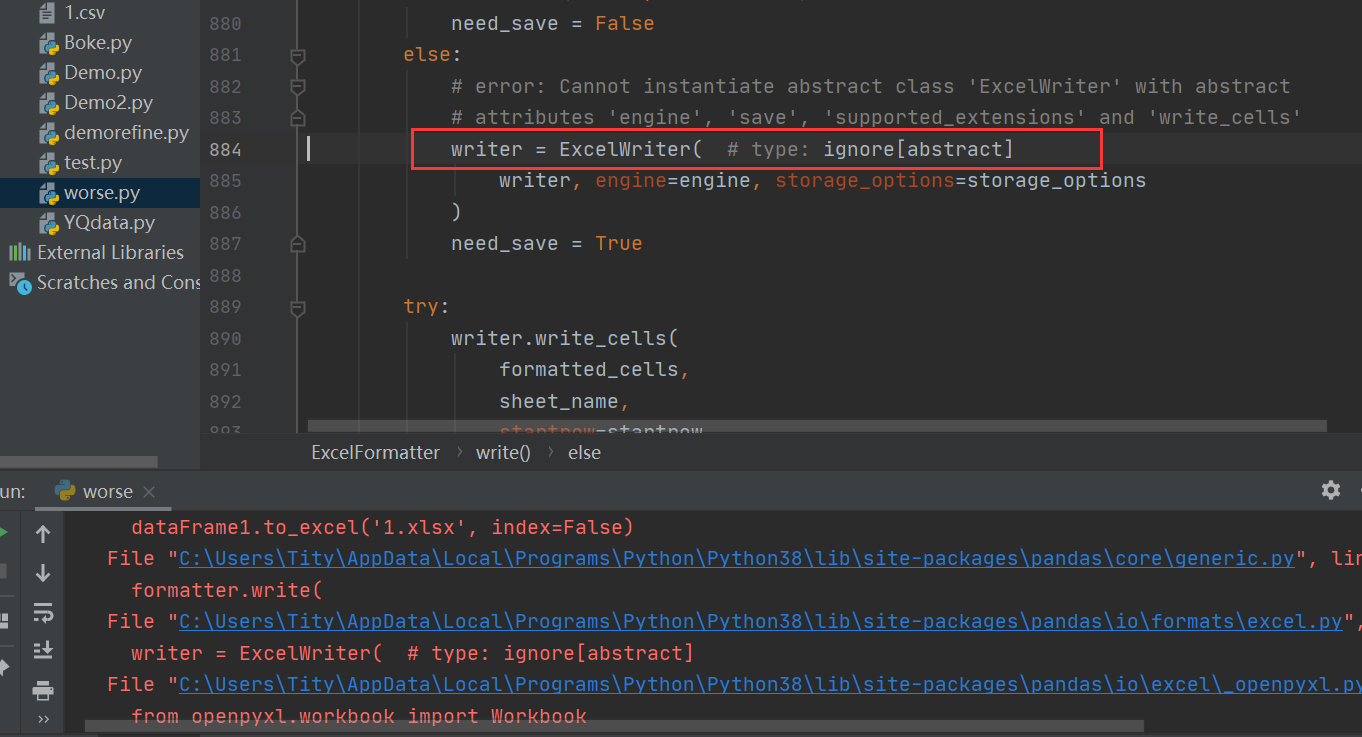

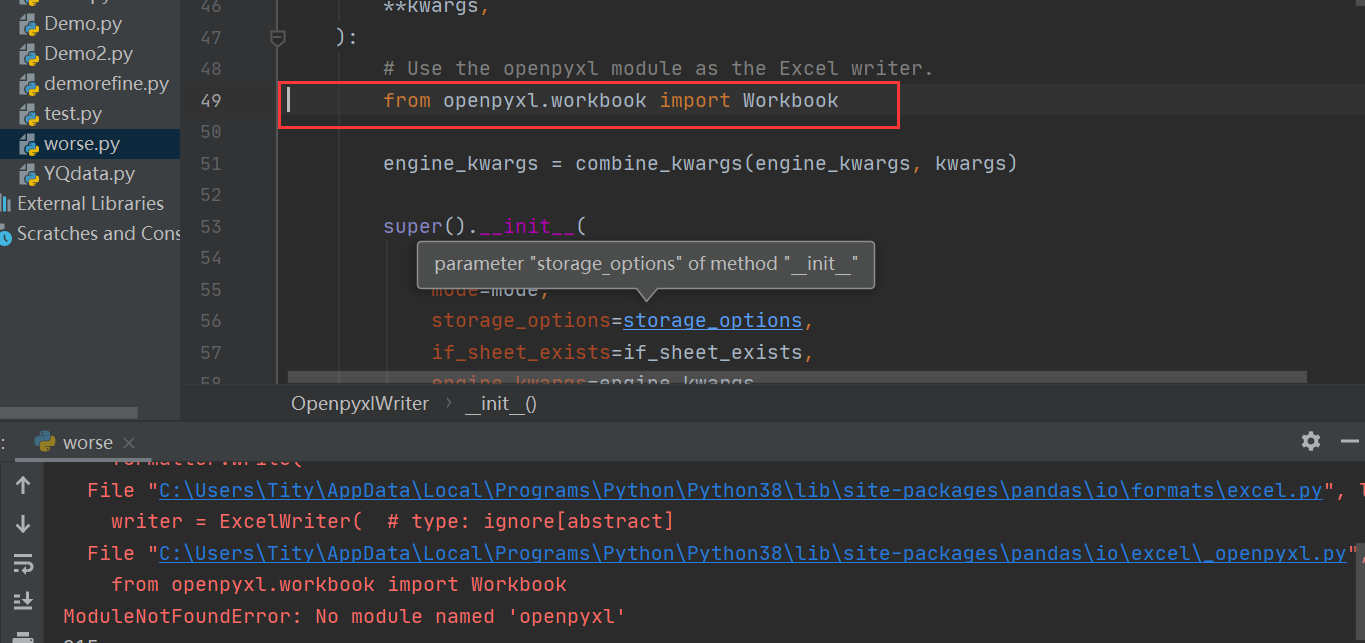

3、接下来就是看到了这篇文章,当然如果直接copy会直接报错 (写在下面了)

参考了文章: 新冠疫情分析(疫情数据爬取+数据分析+网页排版展示)_wang_chun1的博客-CSDN博客

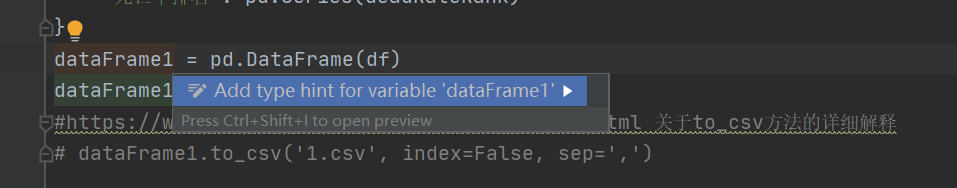

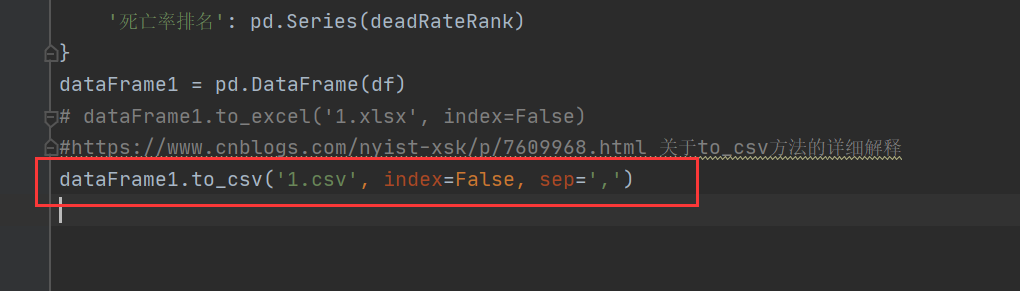

当然 存入数据库谁说一定要excel!!所以我看到报错都是关于存入excel,所以如果没办法处理问题,就换个方法逃避!

可耻但有效! 参考文章:

pandas库写入csv文件的几种方法 - 王涛5 - 博客园 (cnblogs.com)

python爬虫(1)——BeautifulSoup库函数find_all() (转) - xushukui - 博客园 (cnblogs.com)

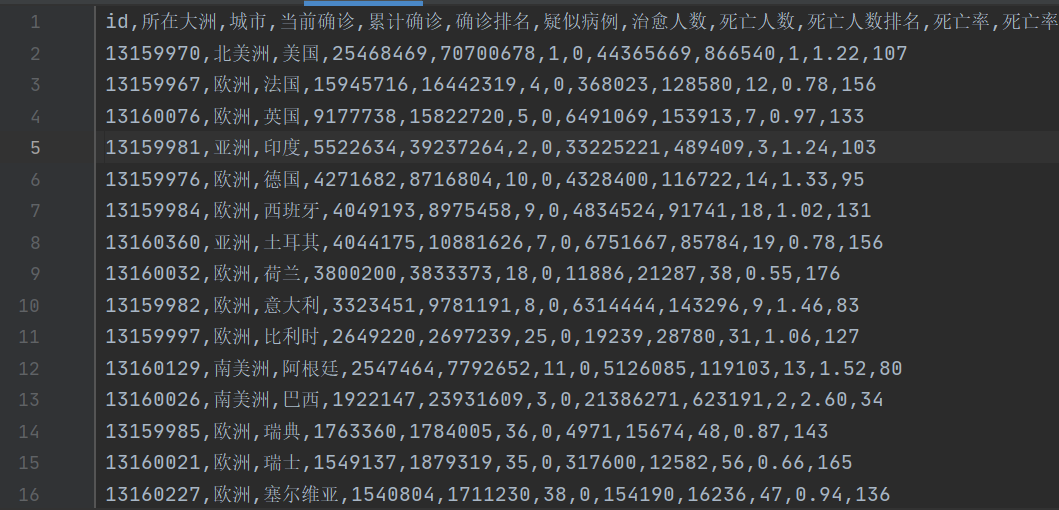

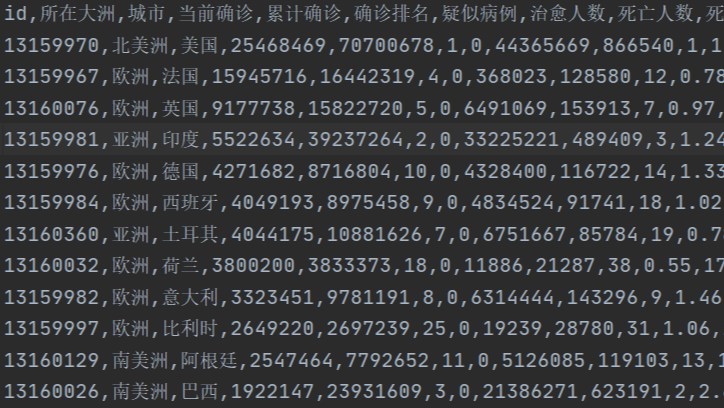

即可,最后运行生成的文件:

世界疫情数据爬虫

世界疫情数据爬虫