深度学习 概率知识

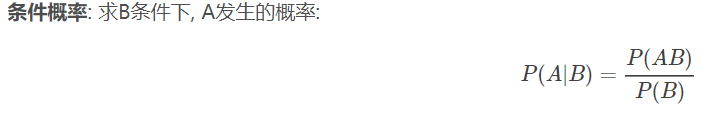

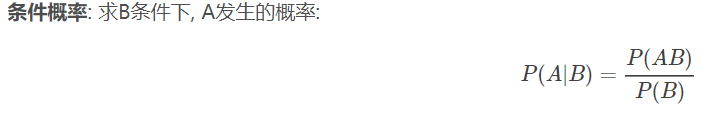

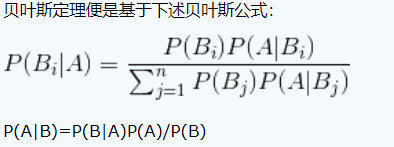

贝叶斯

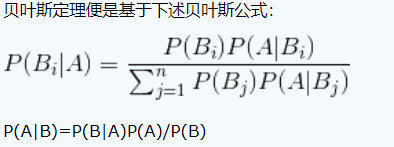

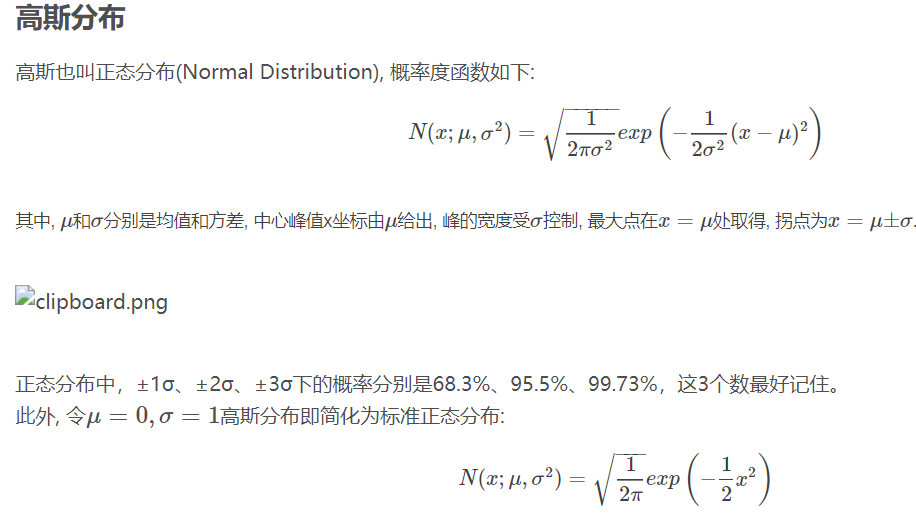

高斯分布

交叉熵

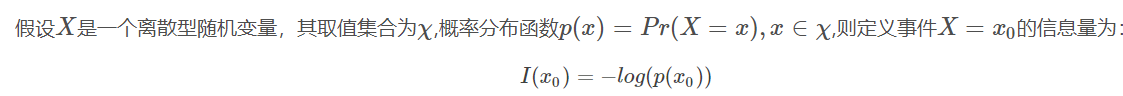

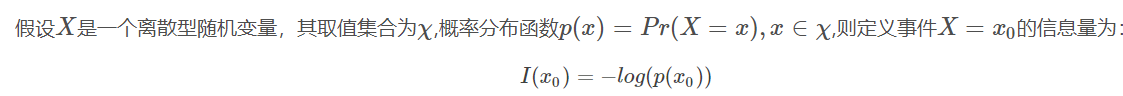

根据香浓理论,熵是描述信息量的一种度量,如果某一事件发生的概率越小,也就是不确定性越大,那么熵就越大,或者说是信息量越大

我们要让交叉熵尽可能地小,模型预测效果越好

在计算CrossEntropyLosss时,真实的label(一个标量)被处理成onehot编码的形式。

交叉熵在机器学习中的运用:引用博客https://blog.csdn.net/tsyccnh/article/details/79163834

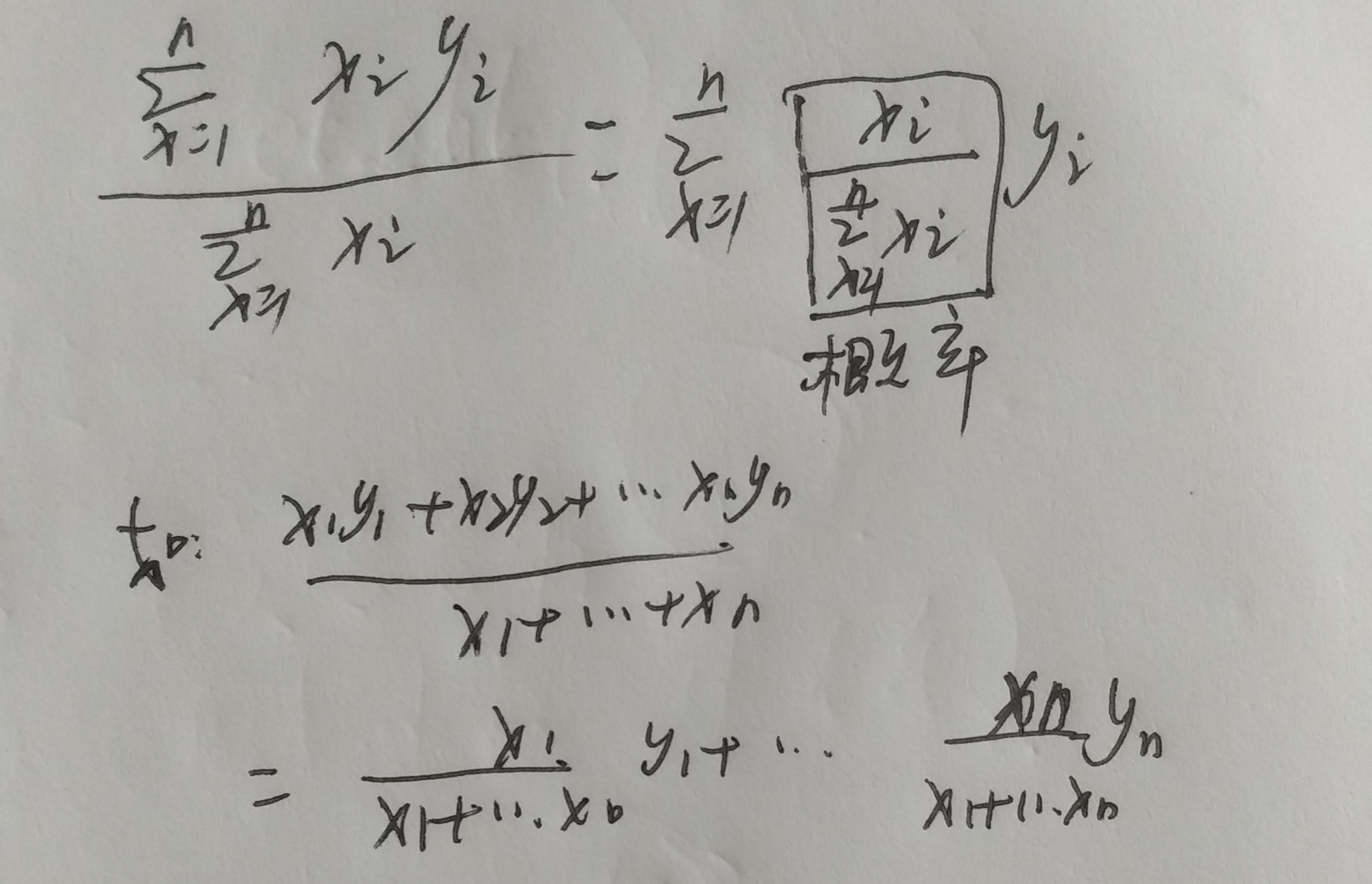

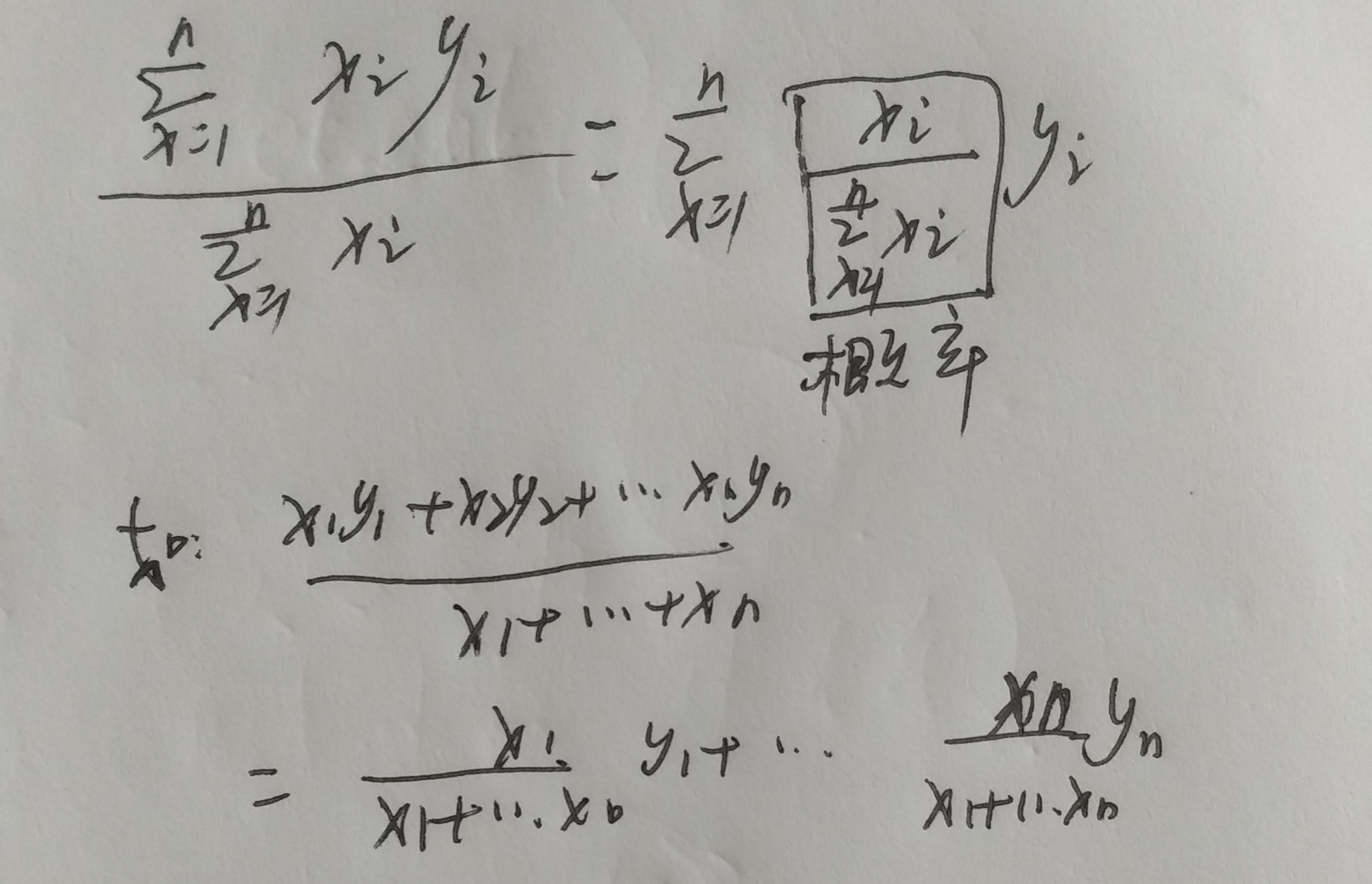

一些公式变形

贝叶斯

高斯分布

交叉熵

根据香浓理论,熵是描述信息量的一种度量,如果某一事件发生的概率越小,也就是不确定性越大,那么熵就越大,或者说是信息量越大

我们要让交叉熵尽可能地小,模型预测效果越好

在计算CrossEntropyLosss时,真实的label(一个标量)被处理成onehot编码的形式。

交叉熵在机器学习中的运用:引用博客https://blog.csdn.net/tsyccnh/article/details/79163834

一些公式变形

Powered by:

博客园

Copyright © 2025 cltt

Powered by .NET 9.0 on Kubernetes

|

|||||||||

| 日 | 一 | 二 | 三 | 四 | 五 | 六 | |||

|---|---|---|---|---|---|---|---|---|---|

| 23 | 24 | 25 | 26 | 27 | 28 | 1 | |||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 | |||

| 9 | 10 | 11 | 12 | 13 | 14 | 15 | |||

| 16 | 17 | 18 | 19 | 20 | 21 | 22 | |||

| 23 | 24 | 25 | 26 | 27 | 28 | 29 | |||

| 30 | 31 | 1 | 2 | 3 | 4 | 5 | |||

请问,断点训练 加载参数后loss先上升然后一直不变会是什么原因造成的?断开训练前loss一直呈下降趋势

windows10下可用,双击打开.ipynb

还是不好用

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构