Squeeze-and-Excitation Networks:SENet,早期cv中粗糙的注意力

Squeeze-and-Excitation Networks

* Authors: [[Jie Hu]], [[Li Shen]], [[Samuel Albanie]], [[Gang Sun]], [[Enhua Wu]]

初读印象

comment:: (SENet)以前的工作都是在提高CNN的空间编码能力。这篇论文提出了“Squeeze-and-Excitation”块,研究通道之间的关系。

Why

- 以前的工作都是依赖卷积层融合感受野内的空间和各通道的信息

- 在网络中加入更多可学习层

- VGG,ResNet(1×1卷积、BN),Highway networks。

- 改变各层网络的连接关系。

- 更改网络的计算函数(多尺度信息融合、空间变换)

- 搜索网络架构

- 注意力和门控机制

- 在网络中加入更多可学习层

卷积虽然也关注了通道间的相关性,但是这种相关性是和局部的空间信息相关性是混合在一起的,是局部和隐含的。

What

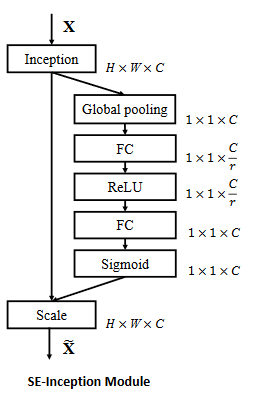

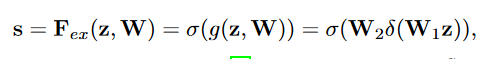

提出“Squeeze-and-Excitation”块,显式建模其卷积特征的信道之间的相互依赖性来提高网络产生的表示质量。

###How

###How

-

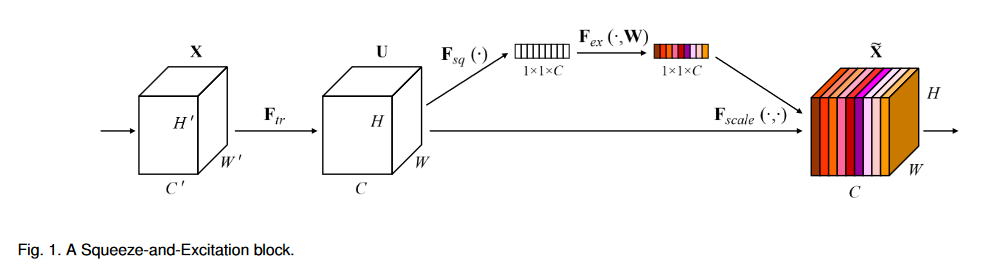

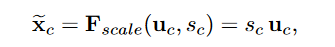

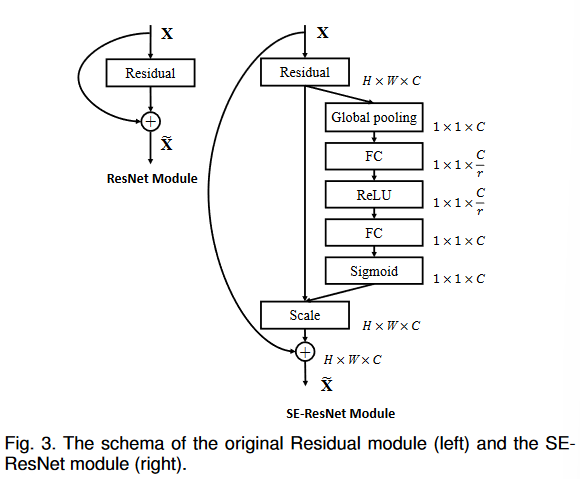

Squeeze-and-Excitation block

- 挤压(squeeze): 对每个通道做全局平均池化

- 激发(excitation)

-

-

有残差的SENet

有残差的SENet

-

Experiment

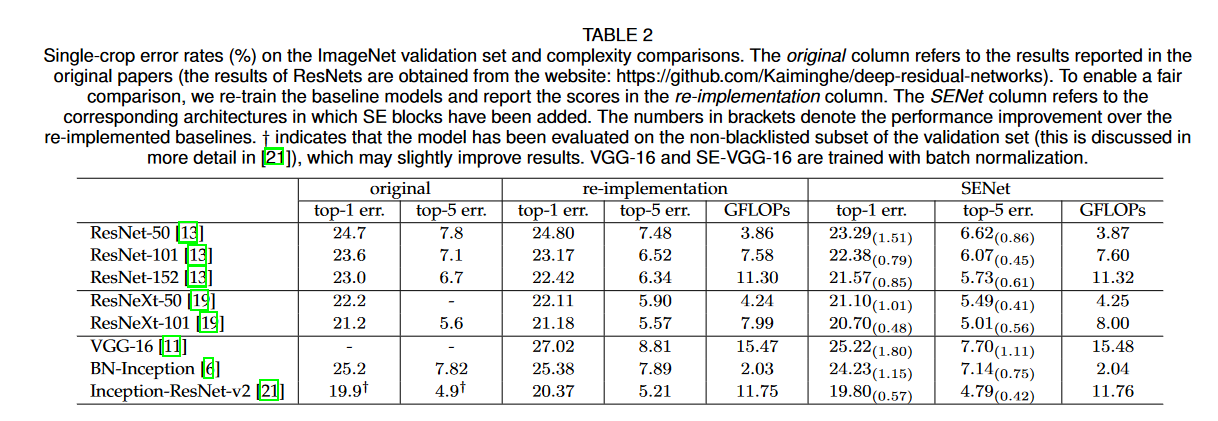

准确率和计算量对比:增加了SEblock的网络,准确度提升很大,相对的计算复杂度和参数!量增加不多

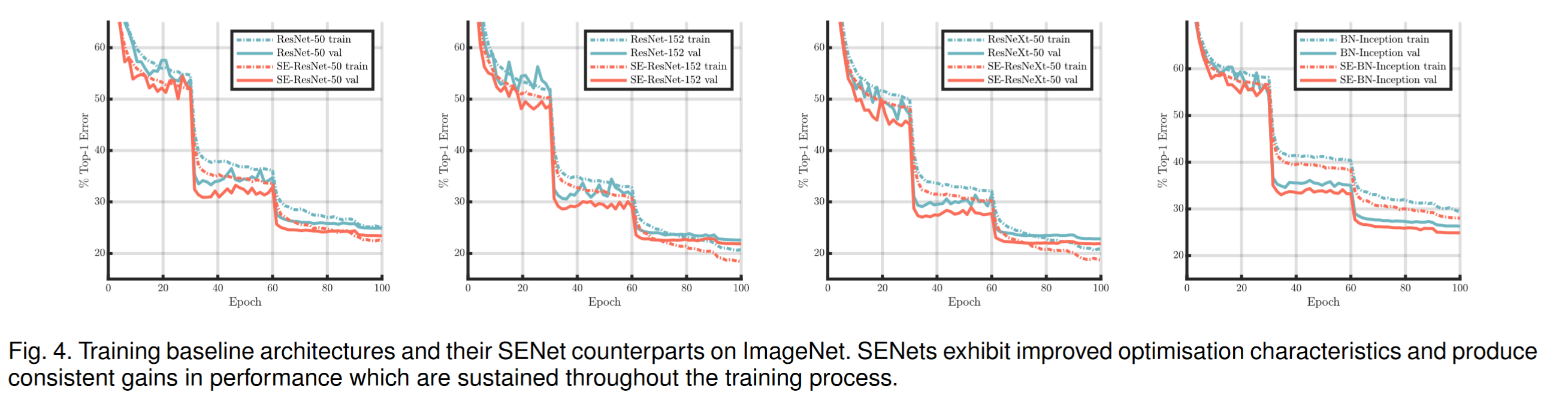

加入SEBlock能让模型更快收敛

加入SEBlock能让模型更快收敛

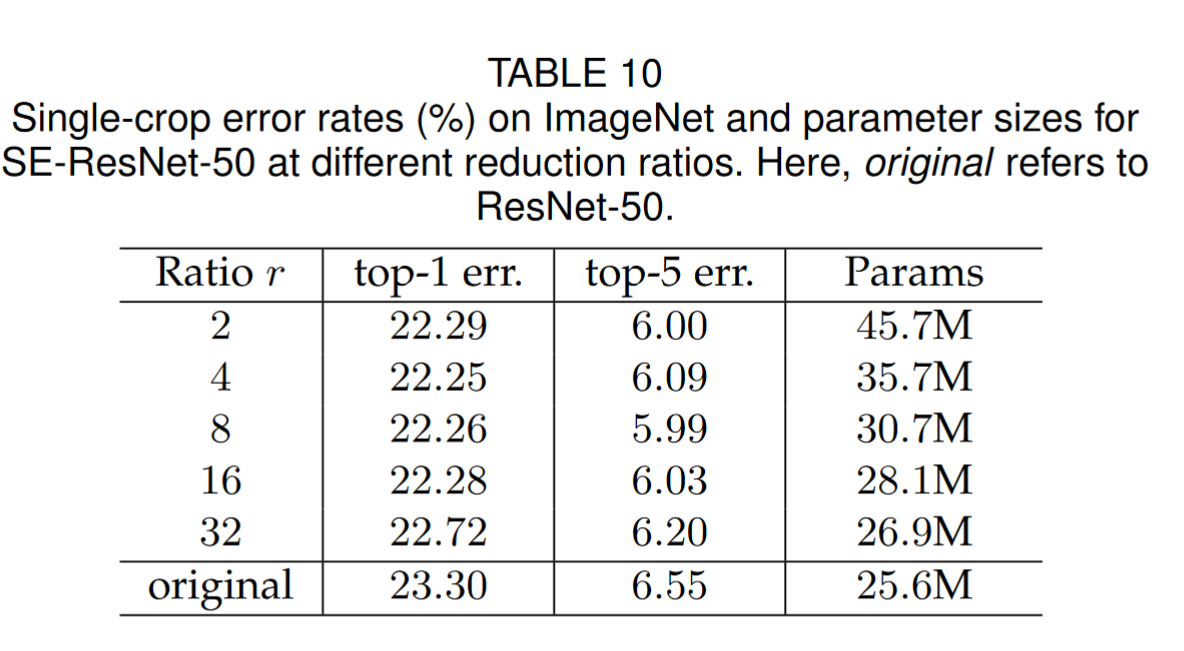

不同的压缩比例r:压缩比例对准确率的影响比较小

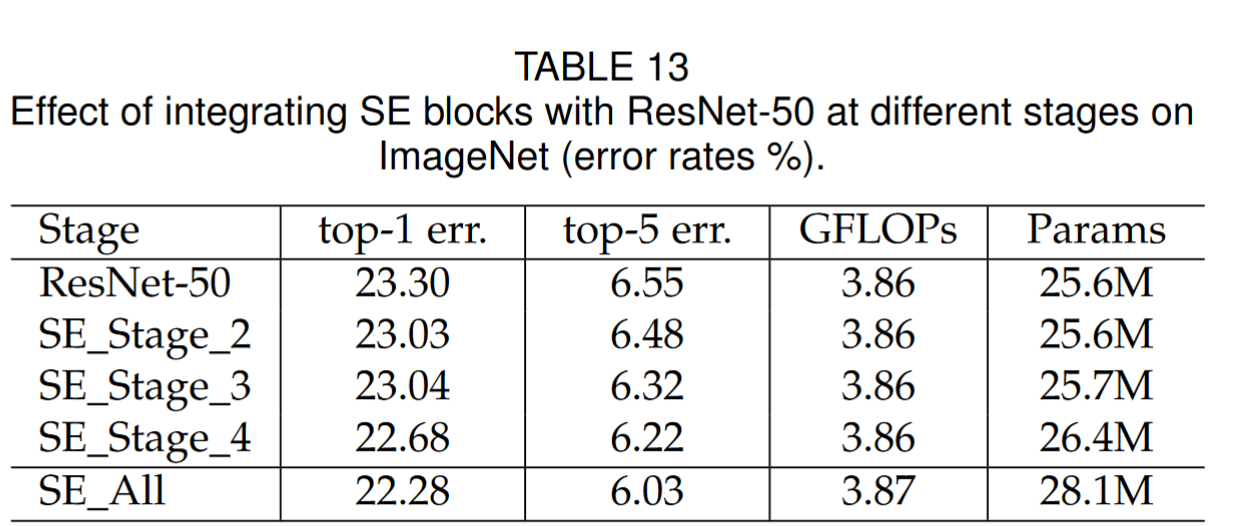

以Resnet50为例,分别在不同阶段加入SEBlock的效果

以Resnet50为例,分别在不同阶段加入SEBlock的效果

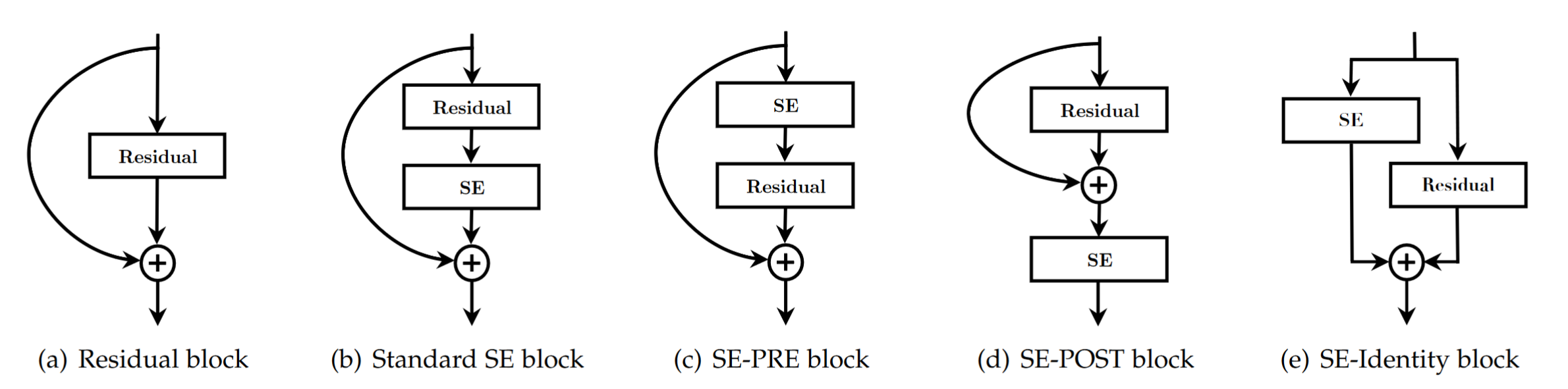

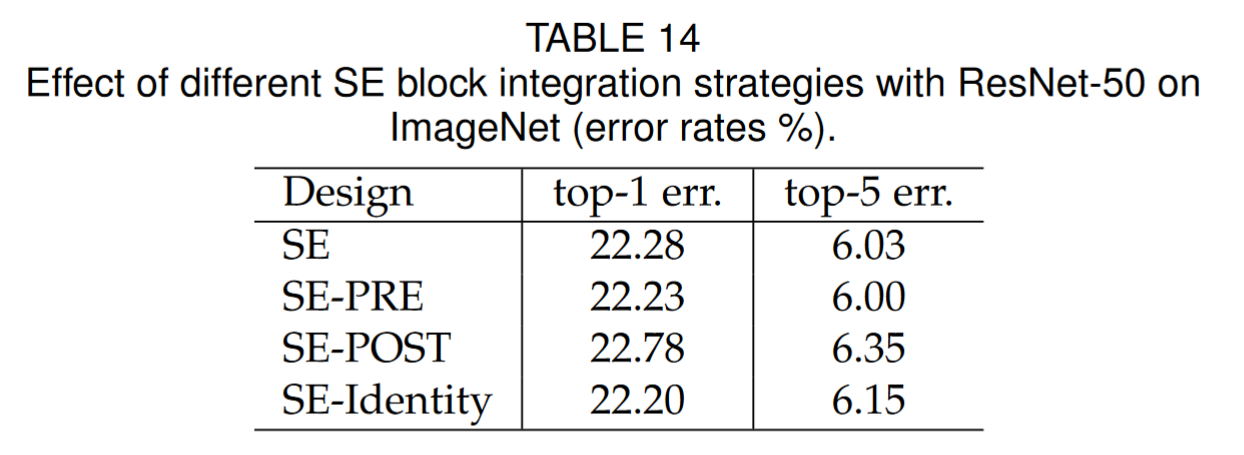

不同SEBlock位置的影响:b,c,e区别不大,d的效果比较差

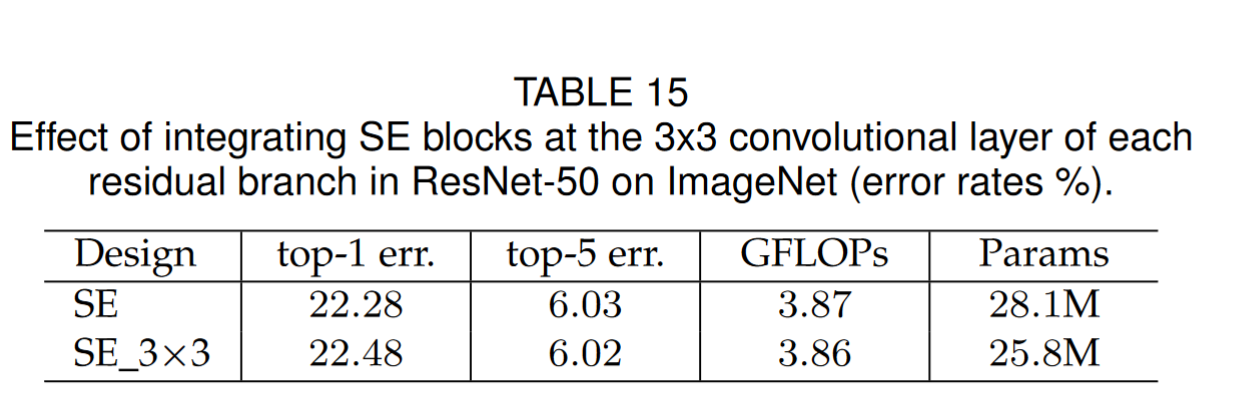

直接在resnet的3×3卷积后用SEBlock,因为此时通道数较少,计算量变小,但是准确率跟之前差不多

Conclusion

通过学习通道间的相互关系,重新分配各个通道的重要程度,来达到提高精确度的目的。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 三行代码完成国际化适配,妙~啊~

· .NET Core 中如何实现缓存的预热?