hadoop 3.x Replication与Availability不一致

看下面的文字前先确保你的Replication值不大于你设置的虚拟机数量

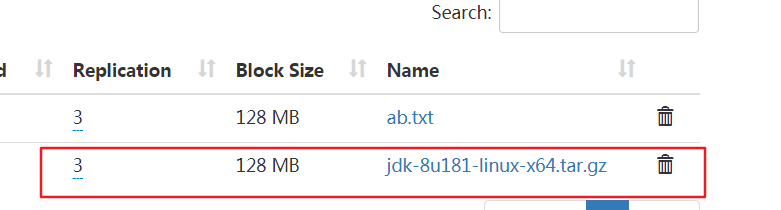

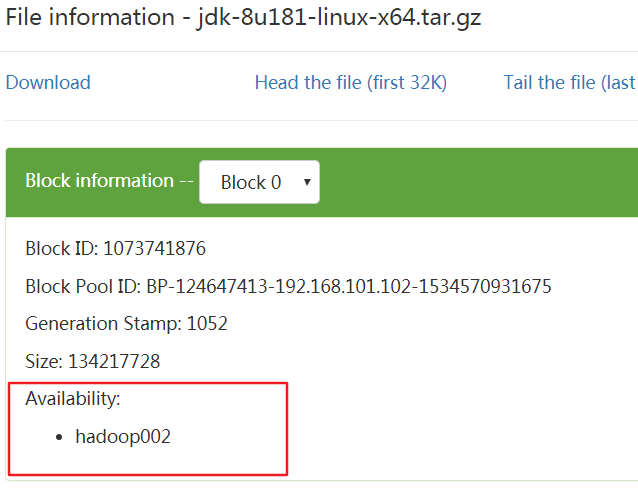

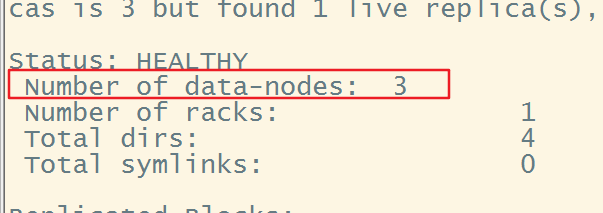

如图,显示的副本数为3,但是实际可用的只有一台机器,查看了下hadoop003,hadoop004两台机器,果然没有存储数据,刚开始以为上传的jdk只有一份是因为在修改副本为3之前创建的,所以只有一份,但是重新上传了一个文件后,发现依然显示副本为3,实际仍然只有一份,于是思考是不是datanode没启动?在hadoop003与hadoop004上jps均有datanode进程然而执行hadoop fsck -locations后发现果然number of data-nodes:1,应该是之前拷贝hadoop目录的时候其中包含的data目录没有被删除,导致在hadoop003与hadoop004中包含同一份data目录,这样就造成二者的datanode的version中的storgeId与datanodeuuid冲突.从而导致datanode启动失败

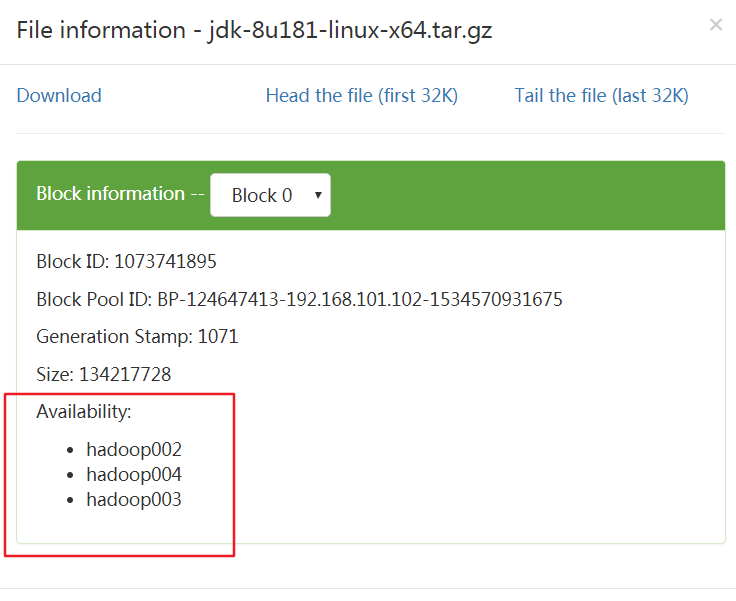

解决思路:关闭hdfs后,删除hadoop003与hadoop004下相应的data目录,然后重启hdfs即可,重启完成后重新检查下.执行hadoop fsck -locations.发现3个datanode全部成功启动

之后重新上传,就ok了,如果出现java.io.IOException: Got error, status=ERROR, status message , ack with firstBadLink as 192.168.101.103:9866,查看datanode的日志后如果java.net.NoRouteToHostException: No route to host那就是防火墙的问题了使用分发脚本关闭即可

,

浙公网安备 33010602011771号

浙公网安备 33010602011771号