拓端tecdat|R语言辅导ROC曲线评价分类器的好坏

原文链接:http://tecdat.cn/?p=18944

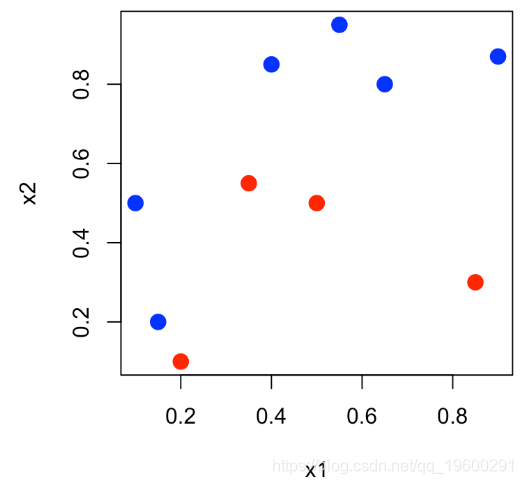

本文将使用一个小数据说明ROC曲线,其中n = 10个观测值,两个连续变量x_1和x_2,以及二元变量y∈{0,1}。

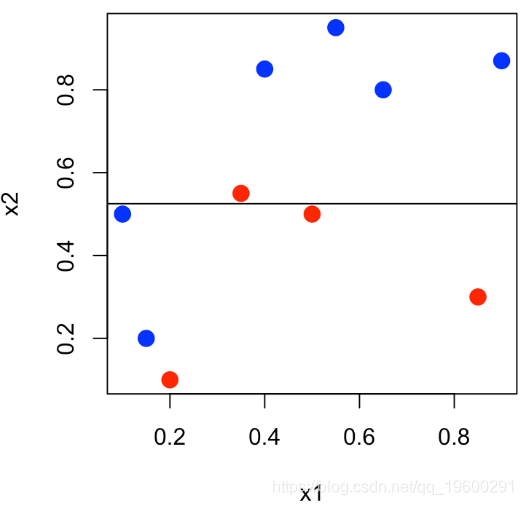

我们可以表示平面(x_1,x_2)中的点,并且对y∈{0,1}中的y 使用不同的颜色。

-

-

df = data.frame(x1=x1,x2=x2,y=as.factor(y))

-

plot(x1,x2,col=c("red","blue")[1+y],pch=19,cex=1.5)

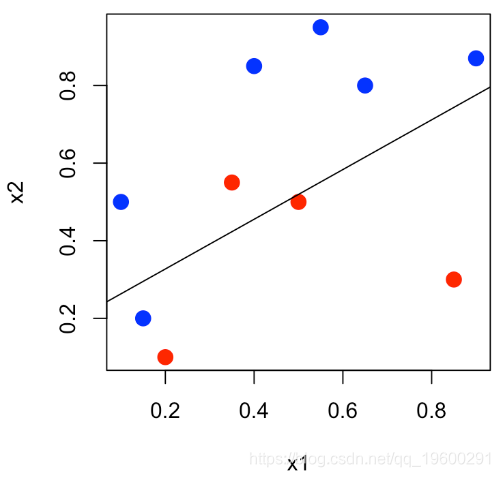

然后,我们可以进行逻辑回归,P(Y = 1∣x1,x2)= 1 +eβ0+β1x1 +β2x2eβ0+β1x1 +β2x2 ,

-

-

reg = glm(y~x1+x2,data=df,family=binomial(link = "logit"))

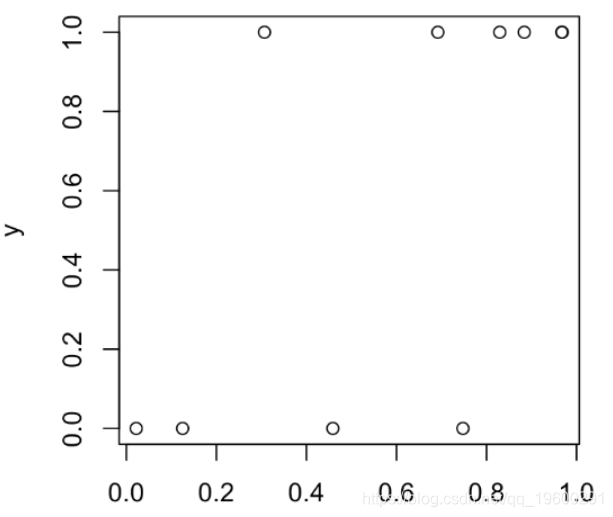

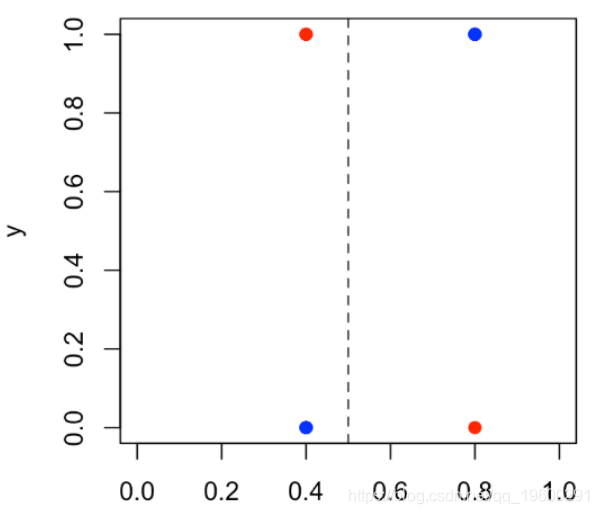

然后我们可以将y_i表示为得分的函数,即P(Y = 1∣x1,i ,x2,i),

-

-

S = predict(reg,type="response")

-

plot(S,y )

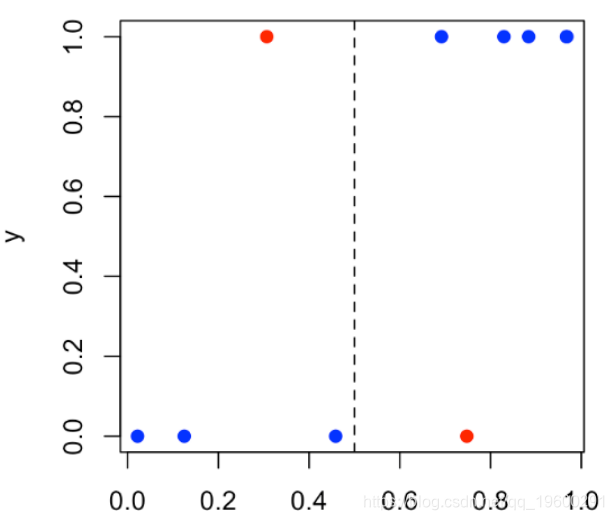

然后,我们将设定一个阈值(例如50%):如果Y取值1的概率超过阈值,我们将预测为1(否则为0)。在上图中,我们有4个点:阈值左侧的那些点(预测为0),如果位于底部,则分类很好,而位于顶部的分类很差;在阈值的右边(并且预测为1),如果它们位于顶部,则可以很好地分类,而底部则不能很好地分类

-

-

plot(S,y,

-

col=c("red","blue")[1+(y==Yhat)])

-

abline(v=s,lty=2)

颜色反映了分类的好坏:红点表示分类错误。我们可以在 下面的列联表(混淆矩阵)中找到所有这些内容 。

-

-

Y Yhat 0 1

-

0 3 1

-

1 1 5

在这里,我们感兴趣的是两个指标:假正例和真正例,

-

FP=sum((Ps==1)*(Y==0))/sum(Y==0)

-

TP=sum((Ps==1)*(Y==1))/sum(Y==1)

我们在给定的阈值(此处为50 %)处获得了该表。

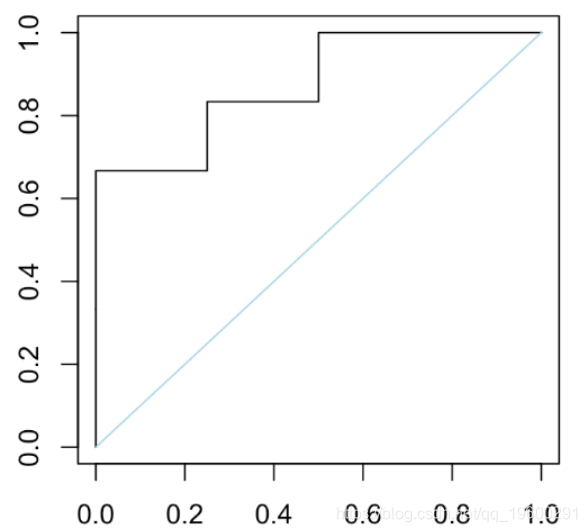

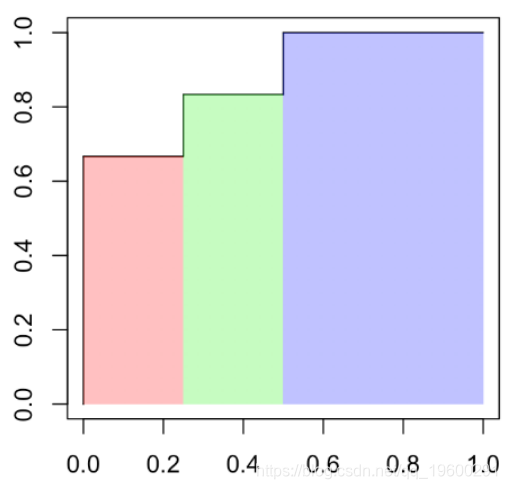

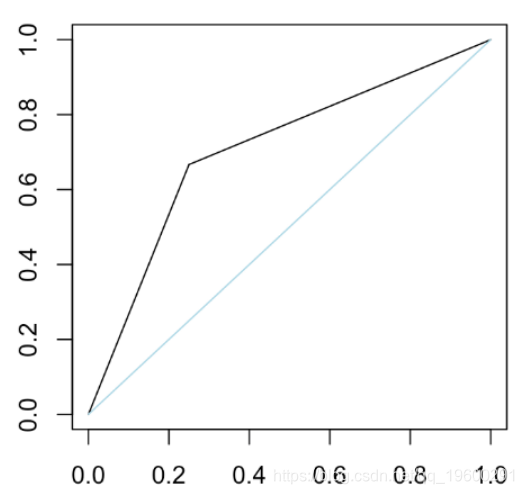

这组结果给出了ROC曲线。

-

-

-

plot(t(V),type="s" )

-

segments(0,0,1,1,col="light blue")

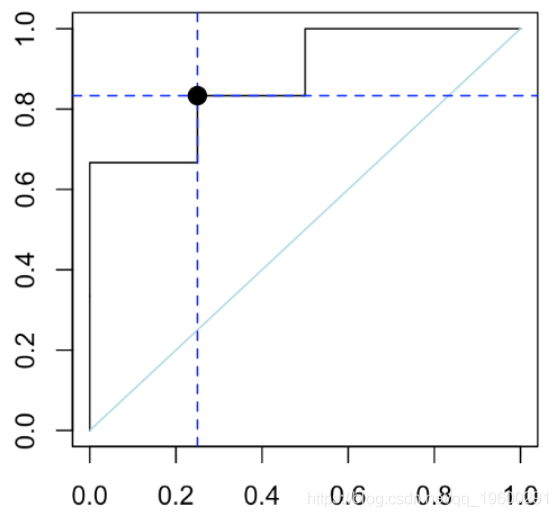

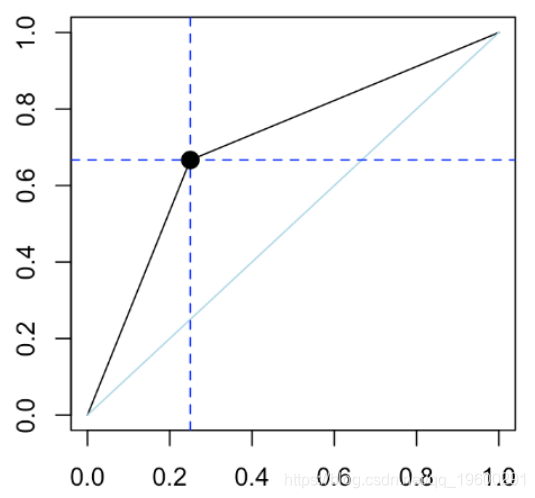

我们可以检查在曲线上阈值50%处的点

-

-

Y Yhat 0 1

-

0 3 1

-

1 1 5

-

(FP = sum((Yhat)*(Y==0))/sum(Y==0))

-

[1] 0.25

-

(TP = sum((Yhat==1)*(Y==1))/sum(Y==1))

-

[1] 0.83

-

-

plot(performance(pred,"tpr","fpr"))

一个有趣的量称为曲线下面积(或 AUC),可在此处手动计算(我们有一个简单的阶梯函数)

-

p2[1]*p2[2]+(p1[1]-p2[1])*p1[2]+(1-p1[1])

-

[1] 0.875

也可以用函数计算

-

auc.perf@y.values[[1]]

-

[1] 0.87

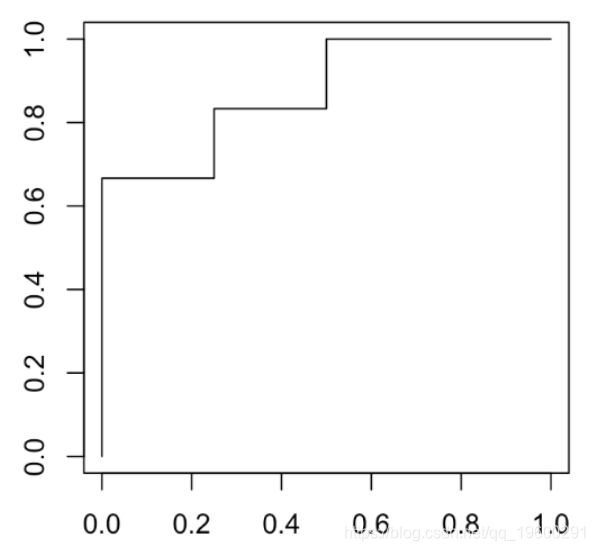

我们尝试另一个分类器:仍然是逻辑回归,但要考虑通过将第二个变量分割成两个而获得的因子1 [s,∞) x2)

abline(h=.525)

水平线不再是红色和蓝色一样多的线,而是与变量x_2相交的线。在这里,我们仅预测两个值:底部出现蓝色的概率为40%,顶部为蓝色的概率为80%。如果我们将观测值yi表示为预测概率的函数,则可以得出

plot(S,y,ylab="y",xlim=0:1)

50%的阈值,我们获得以下列联表

-

-

Y Yhat 0 1

-

0 3 2

-

1 1 4

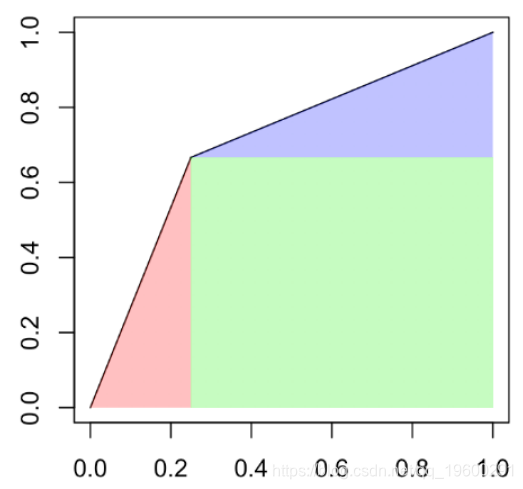

如果绘制ROC曲线,我们得到

-

-

plot(t(V),type="l"

-

segments(0,0,1,1,col="light blue")

这次,曲线是线性的。上图中的蓝色对角线恰好是随机分类器,这是我们随机预测的结果

-

pred = prediction(S,Y)

-

plot(performance(pred,"tpr","fpr"))

该点的阈值为50%。再次,我们可以计算曲线下的面积

-

-

p2[1]*p2[2]/2+(1-p1[1])*p1[2]+(1-p1[1])*(1-p1[2])/2

-

-

-

[1] 0.708

最受欢迎的见解

3.python中使用scikit-learn和pandas决策树

7.用机器学习识别不断变化的股市状况——隐马尔可夫模型的应用