从零学习大模型——使用GLM-4-9B + BGE-M3 + langchain + chroma建立的本地RAG应用(一)——环境准备

2024/7/19更新:由于GLM4在2024/7/16发布了新的更新,所以在这之后下载到本地的模型在依赖搭建时需要依照新版本的规定进行安装

# 升级pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip install fastapi==0.104.1

pip install uvicorn==0.24.0.post1

pip install requests==2.25.1

pip install modelscope==1.9.5

pip install transformers==4.42.4

pip install streamlit==1.24.0

pip install sentencepiece==0.2.0

pip install accelerate==0.32.1

pip install tiktoken==0.7.0

本项目基于DataWhaleChina的self-llm教程与llm-universe及Langchain官方文档等资料开发,旨在实现全部本地化的RAG应用。

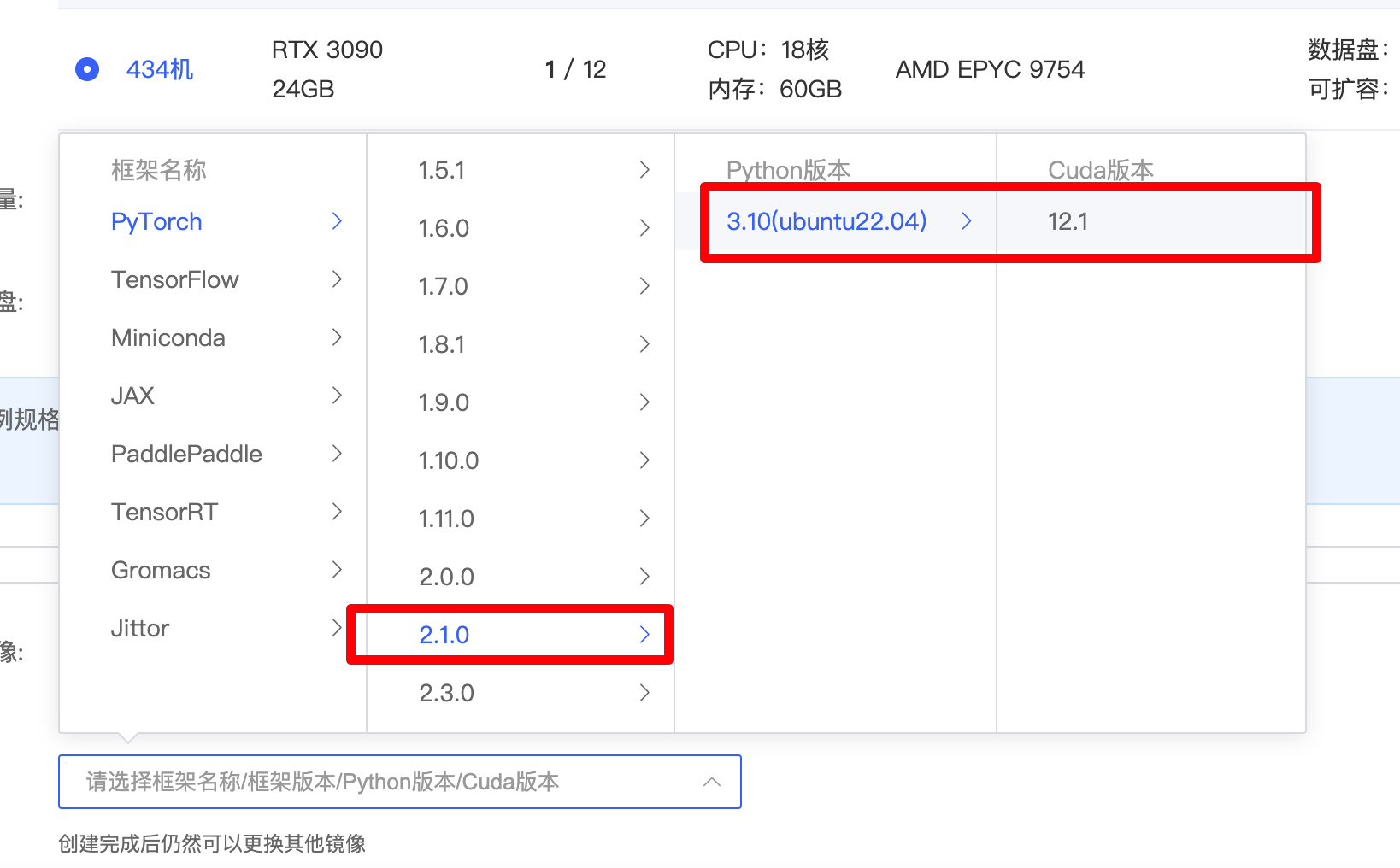

本项目使用AutoDL的云服务器进行开发。在 AutoDL 平台中租一个 3090 等 24G 显存的显卡机器,如下图所示镜像选择 PyTorch-->2.1.0-->3.10(ubuntu22.04)-->12.1。

接下来打开刚刚租用服务器的 JupyterLab,并且打开其中的终端。进行环境配置与依赖安装,注意要依次执行每一行pip install语句。

# 升级pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip install fastapi==0.104.1

pip install uvicorn==0.24.0.post1

pip install requests==2.25.1

pip install modelscope==1.9.5

pip install transformers==4.41.2

pip install streamlit==1.24.0

pip install sentencepiece==0.1.99

pip install accelerate==0.24.1

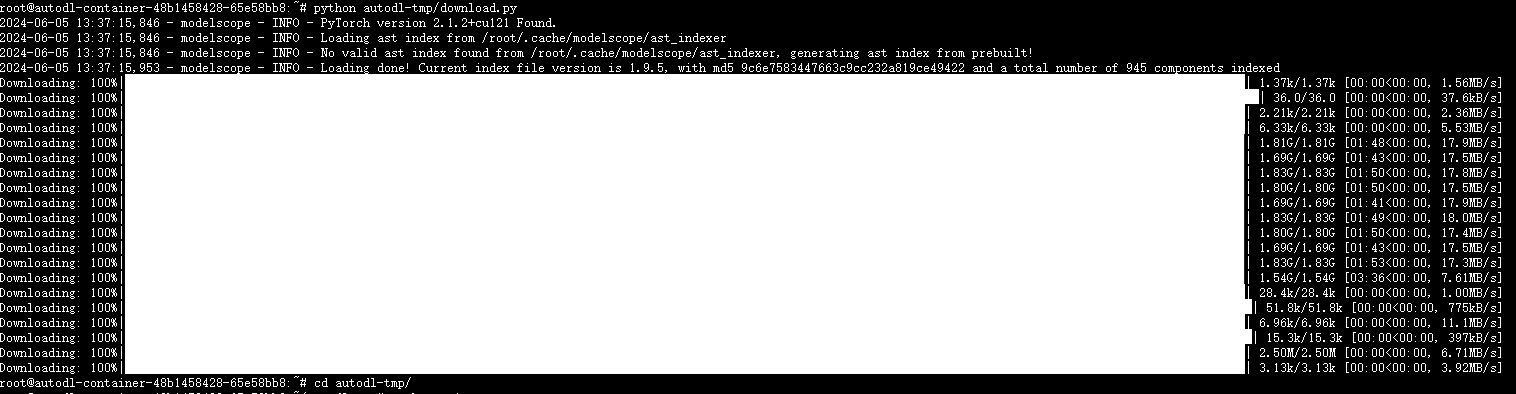

pip install tiktoken==0.7.0项目中下载的模型建议使用魔搭社区的源,较为稳定快速。在/root/autodl-tmp路径下新建一个python文件download.py内容如下:

import torch

from modelscope import snapshot_download, AutoModel, AutoTokenizer

import os

model_dir = snapshot_download('ZhipuAI/glm-4-9b-chat', cache_dir='/root/autodl-tmp', revision='master')然后在终端执行命令:

cd /root/auto-tmp

python download.py终端出现下图结果表示下载成功。

然后运行pip install langchain==0.2.1,为后续接入langchain做准备。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列1:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· 【杂谈】分布式事务——高大上的无用知识?