寒假生活指导01

今天看了spark的安装视频,进行了spark的基础学习。

rdd:

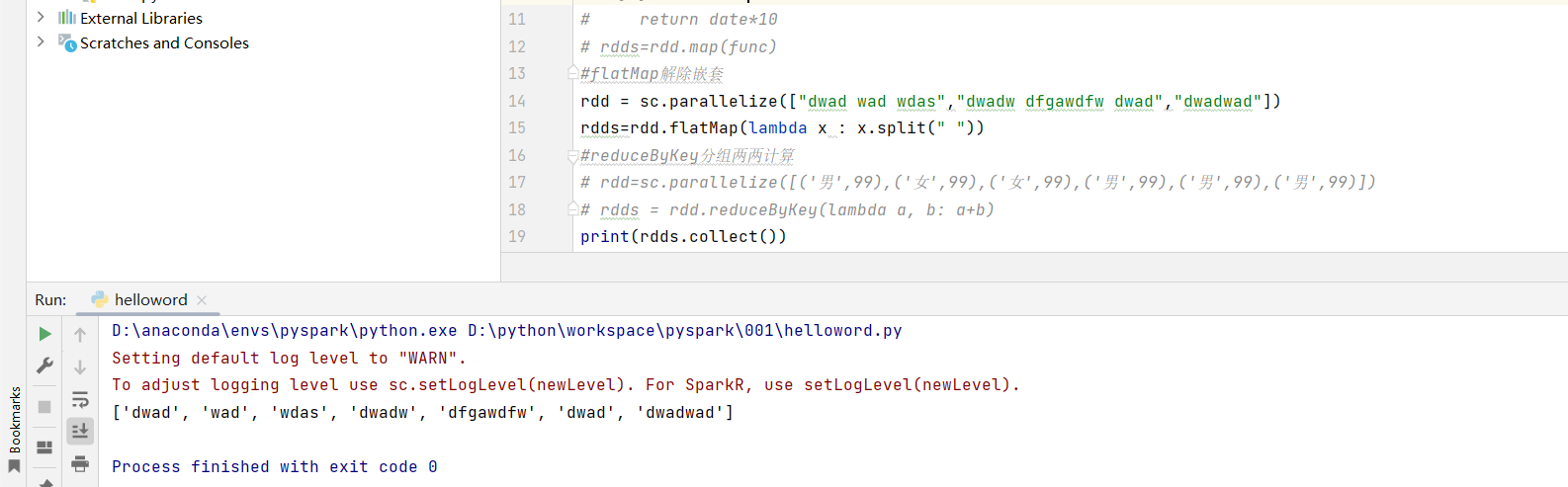

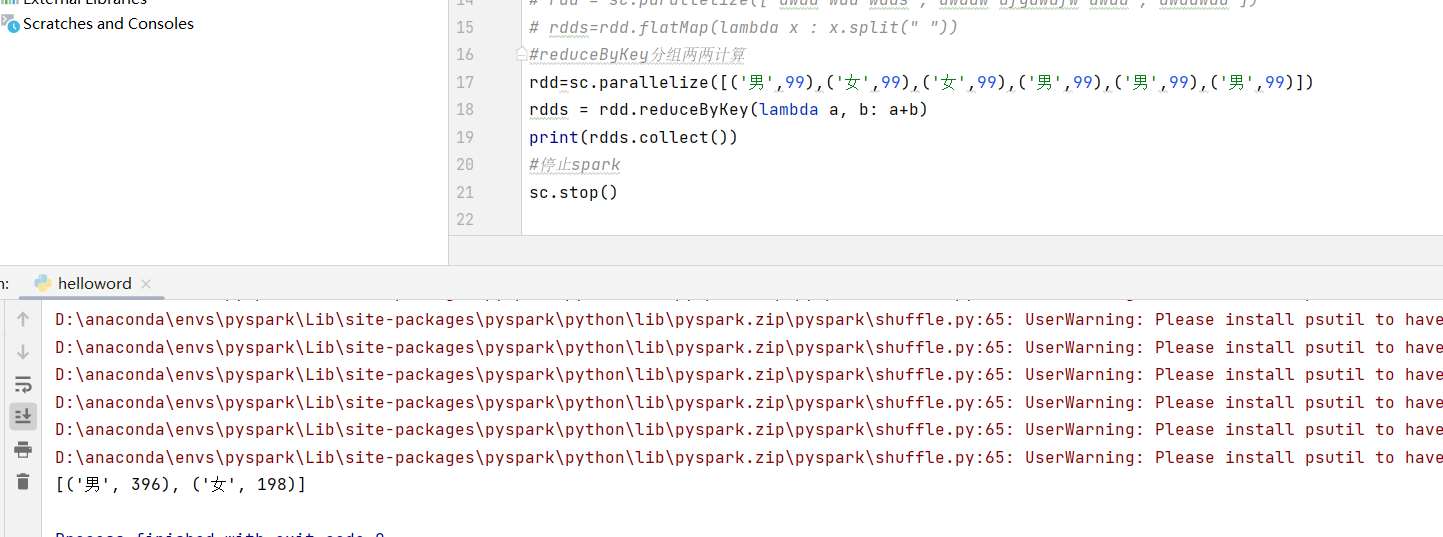

map计算 rdd = sc.parallelize([1,2,3,4,5]) def func(date): return date*10 rdds=rdd.map(func) #flatMap解除嵌套 rdd = sc.parallelize(["dwad wad wdas","dwadw dfgawdfw dwad","dwadwad"]) rdds=rdd.flatMap(lambda x : x.split(" ")) #reduceByKey分组两两计算 rdd=sc.parallelize([('男',99),('女',99),('女',99),('男',99),('男',99),('男',99)]) rdds = rdd.reduceByKey(lambda a, b: a+b) print(rdds.collect())

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通