先定义什么是优化,优化是求损失最小值情况下的参数。这里的调参不包括超参数,超参数怎么调可以参考。

1.梯度下降算法

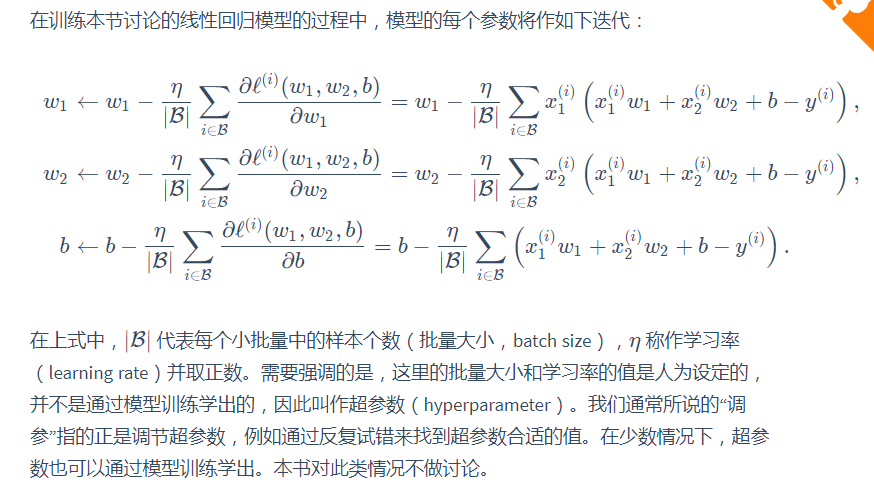

小批量随机梯度下降(mini-batch stochastic gradient descent)在深度学习中被广泛使用。

它的算法很简单:

先选取一组模型参数的初始值,如随机选取;

接下来对参数进行多次迭代,使每次迭代都可能降低损失函数的值。

在每次迭代中,先随机均匀采样一个由固定数目训练数据样本所组成的小批量(mini-batch)B,

然后求小批量中数据样本的平均损失模型,参数的导数(梯度),

最后用此结果与预设的一个正数的乘积,作为模型参数在本次迭代的减小量。

2.

3.牛顿法

参考:

作者:西伯尔

出处:http://www.cnblogs.com/sybil-hxl/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。