1.softmax函数

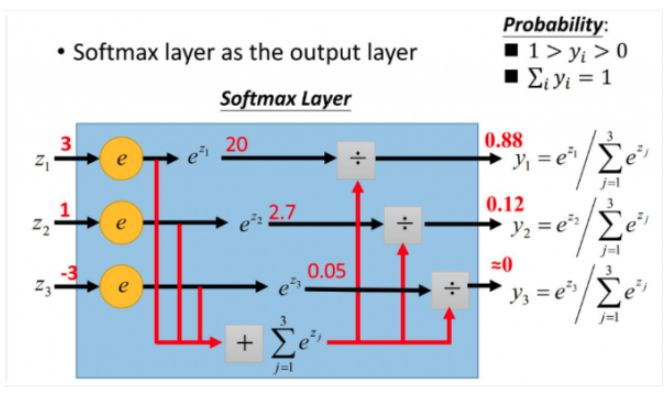

softmax用于多分类过程中,它将多个神经元的输出,映射到(0,1)区间内,进行归一化,转化成概率的形式。

假设我们有一个数组 V,Vi表示V中的第i个元素,那么这个元素的softmax值就是:

例如:下图中,yi = y(zi) = e^zi / ∑ e^zj

2.softmax loss

softmax loss是由softmax和交叉熵(cross-entropy loss)组合而成,全称是softmax with cross-entropy loss。

(1)交叉熵

参考:https://www.cnblogs.com/sybil-hxl/p/12662015.html

(2)交叉熵loss

①![]()

②n对应于样本数量,m是类别数量,yij 表示第i个样本属于分类j的标签,它是0或者1。对于单分类任务,只有一个分类的标签非零。f(xij) 表示的是样本i预测为j分类的概率。loss的大小,完全取决于分类为正确标签那一类的概率,当所有的样本都分类正确时,loss=0,否则大于0。

③当log loss中的f(xij)的表现形式是softmax概率形式时,那么交叉熵loss就是我们熟知的softmax with cross-entropy loss,简称softmax loss,所以说softmax loss只是交叉熵的一个特例。

④softmax loss被广泛用于分类分割等任务,而且发展出了很多的变种。

3.

参考:

https://blog.csdn.net/softdiamonds/article/details/80101440

https://www.jianshu.com/p/bf2c8fe7e507

https://blog.csdn.net/hacker_long/article/details/88674523

作者:西伯尔

出处:http://www.cnblogs.com/sybil-hxl/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。